Libra AI 是一个开源的 AI 原生开发平台,旨在通过自然语言交互实现 Web 应用的快速构建、迭代和部署。它基于 Cloudflare Workers 架构,集成了多种 AI 模型(如 Claude、OpenAI、Gemini 和 DeepSeek),支持从原型设计到生产环境部署的全生命周期管理。作为 V0 和 Lovable 的开源替代品,Libra AI 提供生产环境开箱即用的功能,强调技术自主性和社区协作。用户可以通过简单的句子描述需求,生成高质量代码,并结合 Cloudflare 的边缘计算实现高效部署。平台支持灵活定制,适合个人开发者、企业团队以及需要私有化部署的用户。

功能列表

- AI 驱动的代码生成:支持多模型集成(如 Claude、OpenAI),通过自然语言生成生产级代码,自动遵循最佳实践。

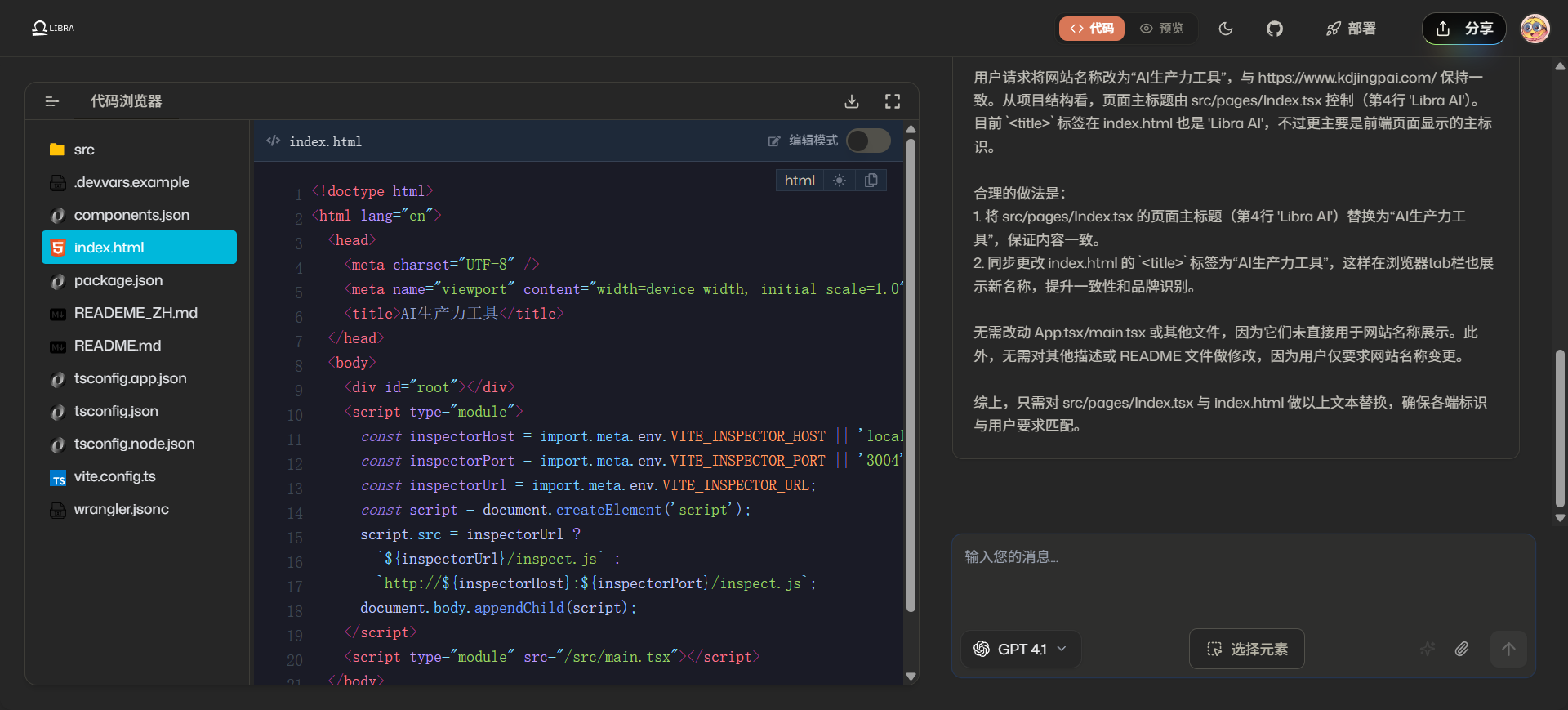

- 云端开发环境:提供代码高亮、智能缩进和实时预览(HMR),支持自定义插件。

- 全栈集成:无缝连接 GitHub、支持 Cloudflare 边缘计算部署、OAuth 2.0 认证和 Stripe 支付管理。

- 生产环境部署:基于 Cloudflare Workers 的无服务器架构,支持弹性扩展、自动化 TLS/SSL 证书和一键回滚。

- 多沙盒支持:集成 E2B 和 Daytona,提供安全的代码运行环境。

- 文档与社区支持:提供详细技术文档和社区论坛,支持多语言国际化。

使用帮助

安装与部署流程

Libra AI 提供两种使用方式:云托管服务和本地自部署。以下是详细的使用指南。

1. 云托管服务(推荐)

云托管服务适合希望快速上手的用户,无需复杂配置即可开始开发。

- 步骤:

- 访问 libra.dev,通过 GitHub OAuth 或邮箱注册。

- 登录后,进入主界面,使用自然语言描述应用需求(如“创建一个带有用户登录的博客网站”)。

- Libra AI 自动生成代码,提供实时预览。

- 配置自定义域名(通过 Cloudflare for SaaS),一键部署到 Cloudflare Workers。

- 注意事项:

- 确保网络连接稳定以访问 Cloudflare 边缘网络。

- Stripe 支付配置需要额外设置,用于商业订阅管理,参考 Stripe 文档。

2. 本地开发部署(适合开发者)

本地部署适合需要深度定制或私有化部署的用户。以下是详细步骤:

环境要求

确保本地环境满足以下要求:

git --version # >= 2.30.0

node --version # >= 20.0.0(推荐 24)

bun --version # >= 1.0.0

步骤 1:获取源代码

git clone https://github.com/nextify-limited/libra.git

cd libra

bun install

# 可选:为 web 应用生成国际化文件

cd apps/web && bun run prebuild && cd ../..

步骤 2:配置环境变量

- 复制示例环境文件并编辑:

cp .env.example .env

- 在

.env文件中配置必要的环境变量,例如 Cloudflare API 密钥、数据库连接信息和 AI 模型 API 密钥(如 Claude 或 OpenAI)。具体变量参考项目文档。

步骤 3:初始化数据库

- 主数据库(PostgreSQL):

cd packages/db

bun db:generate # 生成迁移文件

bun db:migrate # 执行迁移

- 认证数据库(D1/SQLite):

cd apps/web

bun wrangler d1 execute libra --local --command='SELECT 1' # 测试连接

cd packages/auth

bun db:generate

bun db:migrate

步骤 4:启动开发服务

- 启动所有服务:

bun dev

- 或单独启动主应用:

cd apps/web && bun dev

步骤 5:配置 Stripe 支付(商业功能必选)

- 运行 Stripe 本地 webhook 测试:

stripe listen --forward-to localhost:3000/api/auth/stripe/webhook

- 在 Stripe 仪表板中配置产品和订阅,参考 Stripe 文档。

步骤 6:访问本地服务

本地服务启动后,可通过以下地址访问:

- 主应用:

http://localhost:3000 - 文档站点:

http://localhost:3000/docs - CDN 服务:

http://localhost:3000/cdn

3. 生产环境部署

- 云托管部署:

- 在 libra.dev 平台完成应用开发。

- 配置自定义域名和 SSL 证书(通过 Cloudflare for SaaS)。

- 点击“部署”按钮,平台自动将应用发布到 Cloudflare Workers。

- 自托管部署:

- 使用 GitHub Actions 工作流部署各服务,参考以下文件:

.github/workflows/web.yml:主应用部署.github/workflows/cdn.yml:CDN 服务部署.github/workflows/deploy.yml:部署服务.github/workflows/dispatcher.yml:路由服务.github/workflows/screenshot.yml:截图服务.github/workflows/docs.yml:文档站点

- 确保配置了 Cloudflare Workers 和 Wrangler CLI。

- 运行部署命令:

- 使用 GitHub Actions 工作流部署各服务,参考以下文件:

bun wrangler deploy

- 配置用户项目路由(通过

apps/dispatcher服务)。

主要功能操作流程

- AI 代码生成:

- 在主界面输入自然语言描述(如“构建一个电商网站,支持商品展示和支付”)。

- Libra AI 调用集成模型(默认 Claude 或 OpenAI)生成代码。

- 预览生成代码,检查 TypeScript 类型安全性和代码结构。

- 可手动编辑代码,或通过界面调整 UI 组件(基于 shadcn/ui)。

- 实时预览与编辑:

- 使用内置云 IDE,享受代码高亮和智能补全。

- 实时预览通过 HMR(热模块替换)实现,修改代码后页面即时更新。

- 依赖分析自动完成,运行

bun install安装必要包。

- 项目部署:

- 选择部署目标(自定义域名或默认 Worker 地址)。

- 系统通过 Cloudflare Queues(V2 架构)异步处理部署任务。

- 部署完成后,检查日志和状态,必要时使用一键回滚。

- 认证与支付:

- 通过

apps/auth-studio配置用户认证(支持 OAuth 2.0)。 - 集成 Stripe 实现订阅管理,设置 webhook 接收支付事件。

- 通过

注意事项

- AI 模型配置:本地部署需手动配置 AI 模型 API 密钥(参考

packages/sandbox文档)。 - 权限管理:确保正确配置用户权限,防止未经授权的访问。

- 错误处理:部署失败时,检查 Cloudflare Queues 的死信队列,参考日志重试。

应用场景

- 快速原型开发

- 场景描述:初创公司需要快速验证产品创意。开发者使用 Libra AI 输入需求描述,生成包含前端界面和后端逻辑的原型,数分钟内完成部署,展示给客户或投资者。

- 企业级 Web 应用开发

- 场景描述:企业团队需要构建内部工具(如员工管理系统)。Libra AI 提供安全的 OAuth 认证、PostgreSQL 数据库支持和 Cloudflare 边缘部署,确保高可用性和数据安全。

- 教育与学习

- 场景描述:编程初学者通过 Libra AI 的云托管服务学习 Web 开发。输入简单描述即可生成代码,结合文档和社区支持快速上手。

- 开源项目开发

- 场景描述:开发者基于 Libra 的开源版本,定制专属功能,部署到私有云,满足特定区域或合规性需求。

QA

- Libra AI 支持哪些 AI 模型?

- 支持 Claude、OpenAI、Gemini 和 DeepSeek,开发者可通过 API 配置其他模型。

- 云托管和开源版本的区别是什么?

- 云托管提供开箱即用的体验,包含完整 AI 功能和支持;开源版本需自行配置 AI 和环境,但支持深度定制和数据私有化。

- 如何确保生成代码的质量?

- Libra AI 遵循 TypeScript 类型安全、现代 React 模式和 Tailwind CSS 响应式设计,生成代码经过优化,适合生产环境。

- 是否支持商业用途?

- 是的,云托管提供按需付费模式,开源版本遵循 AGPL-3.0 许可,需开源衍生项目,也可购买商业许可用于闭源开发。

- 如何参与社区贡献?

- 可通过 GitHub 提交代码、改进文档、报告问题或翻译多语言,具体参考 社区贡献指南。