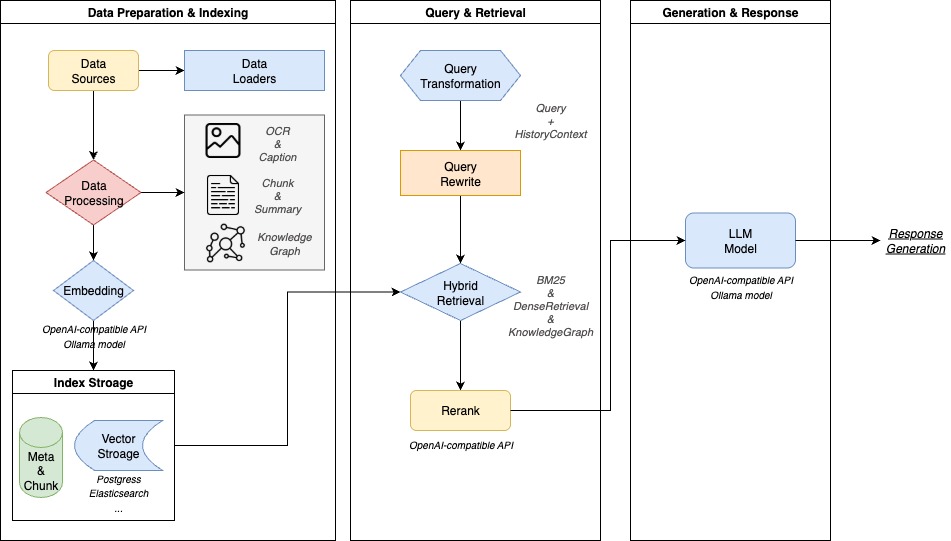

WeKnora(维娜拉)是腾讯开源的一款企业级文档理解与检索问答框架。 它主要用于处理结构复杂、内容多样的文档场景。WeKnora的核心是检索增强生成(RAG)技术,该技术将从文档中检索到的上下文片段与大语言模型结合,从而生成更精准、更贴近事实的回答。整个框架采用了模块化设计,将文档解析、内容召回、模型推理等环节解耦,形成了一套完整且高效的文档问答流程。 用户不仅可以通过一个直观的网页界面进行文档管理和智能问答,还能通过API接口进行二次开发和集成。此框架支持私有化部署,可以保障企业数据的安全可控。

功能列表

- 多模态文档解析:能够精准解析PDF、Word、图片等文件中图文混排的内容,提取文本、表格及图像语义。

- 模块化RAG流水线:支持自由组装检索策略、大语言模型与向量数据库,可以无缝集成Ollama等平台,灵活切换Qwen、DeepSeek等主流模型。

- 智能推理问答:利用大语言模型理解用户意图和文档上下文,支持精准问答和多轮对话。

- 灵活的检索策略:混合使用了关键词检索、向量检索和知识图谱检索等多种策略,并支持自由组合,以提升召回结果的准确性。

- 开箱即用的体验:提供一键启动脚本和直观的Web UI界面,让非技术用户也能快速完成部署与应用。

- 安全可控的部署:支持本地化和私有云部署,并内置监控日志体系,实现全链路可观测性,让用户的数据完全由自己掌控。

- 知识图谱构建:能够将文档内容转化为知识图谱,直观展示信息之间的关联,辅助用户理解和深度检索。

- 丰富的模型支持:兼容多种嵌入模型(如BGE/GTE)、向量数据库(如PostgreSQL、Elasticsearch)以及主流大语言模型。

使用帮助

WeKnora提供了一套完整的工具链,通过Docker实现一键部署和启动,用户无需复杂的配置即可在本地环境中运行整个系统,实现了生产环境的开箱即用。

环境要求

在开始安装前,请确保你的电脑上已经安装了以下三个基本工具:

Docker: 用于管理和运行应用容器。Docker Compose: 用于定义和运行多容器的Docker应用。Git: 用于从GitHub克隆代码仓库。

安装与启动流程

- 克隆代码仓库

首先,打开终端(命令行工具),使用git命令将WeKnora的官方代码库克隆到你的本地电脑。git clone https://github.com/Tencent/WeKnora.git - 进入项目目录

克隆完成后,进入项目所在的文件夹。cd WeKnora - 配置环境变量

WeKnora通过一个.env文件来管理项目的所有环境变量。你可以复制项目提供的示例文件来创建自己的配置文件。cp .env.example .env ``` 复制后,你可以用文本编辑器打开`.env`文件,根据文件内的注释说明,填入你自己的配置信息。对于初次使用者,可以暂时跳过此步骤,直接启动服务,后续通过Web界面进行配置。 - 一键启动服务

项目提供了一个便捷的启动脚本,可以一次性启动所有需要的服务,包括Ollama(用于管理本地大模型)和WeKnora的后端服务。./scripts/start_all.sh你也可以使用

make命令达到同样的效果:make start-all当终端显示服务启动成功后,即可开始使用。

- 访问Web界面

启动成功后,在你的浏览器中访问以下地址:- Web主界面:

http://localhost - 后端API文档:

http://localhost:8080 - 链路追踪系统 (Jaeger):

http://localhost:16686(用于开发者观察系统内部调用情况)

- Web主界面:

初始化模型配置

如果是第一次使用,访问http://localhost时,系统会自动跳转到初始化配置页面。这个页面可以帮助你通过图形化界面完成大语言模型、嵌入模型等关键组件的配置,降低了手动修改配置文件的复杂性。请按照页面的提示信息,填写正确的模型API地址、密钥等信息,完成后系统会自动保存并跳转到知识库主页。

功能操作流程

- 上传知识文档

在Web界面的知识库管理页面,你可以通过直接拖拽文件或点击上传按钮的方式,将你的文档(如产品手册、公司规章、研究报告等)上传到系统中。 系统会自动开始解析文档,提取内容并为其创建向量索引,处理进度和状态会清晰地显示在界面上。 - 进行智能问答

文档处理完成后,你可以进入问答界面。在输入框中提出你的问题,例如“公司的报销流程是怎样的?”或“这个产品如何处理故障?”。系统会根据你的问题,在已上传的知识库中进行语义检索,找到最相关的文档片段,然后利用大语言模型生成通顺、准确的回答。回答结果会附带引用来源,方便你追溯信息出处。 - 使用知识图谱

对于结构复杂的文档,你可以开启知识图谱功能。系统会将文档内的不同段落和实体之间的关系进行分析,并以图谱的形式可视化展示出来。这不仅能帮助你更深入地理解文档的内在逻辑,也能为系统提供更结构化的检索依据,提升问答的相关性。 - 停止服务

当你使用完毕后,可以运行以下脚本来停止所有服务:./scripts/start_all.sh --stop或者使用

make命令:make stop-all

应用场景

- 企业知识管理

将企业内部分散的知识文档,如内部文档、规章制度、操作手册等整合起来,搭建一个智能问答入口。这可以提升员工查找信息的效率,降低内部培训成本。 - 科研文献分析

研究人员可以利用它快速筛选和理解大量的学术文献、研究报告和学术资料。这能加速前期的文献调研工作,辅助研究决策。 - 产品技术支持

将产品的技术手册和常见问题录入系统,可以搭建一个24小时在线的智能客服。它能快速响应用户关于产品功能、故障排查等方面的问题,提升客户服务质量。 - 法律合规审查

在法律领域,它可以辅助律师或法务人员快速在大量的合同条款、法规政策和案例中定位关键信息,提高合规审查的效率。 - 金融投研分析

金融分析师可以利用它处理大量的公司财报、行业研报和市场公告,快速提取关键数据和观点,辅助投资决策。

QA

- WeKnora支持哪些类型的大语言模型?

WeKnora支持多种主流的大语言模型,如Qwen(通义千问)、DeepSeek等。它通过Ollama等平台进行模型管理,用户也可以接入外部的API服务,具有很强的灵活性,可以在配置文件或初始化Web界面中进行切换。 - 部署WeKnora是否需要付费?

WeKnora项目本身基于MIT许可证开源,你可以免费使用、修改和分发,甚至用于商业用途。但如果你在配置中使用了需要付费的第三方大语言模型API服务,那么对应的模型供应商会收取费用。 - 非技术人员可以使用这个框架吗?

可以。WeKnora提供了“开箱即用”的Web界面和一键启动脚本,用户只需按照安装步骤成功部署后,就可以通过拖拽文件、点击按钮等方式来上传知识和进行问答,无需编写代码,使用门槛较低。 - 上传的文档数据安全吗?

非常安全。WeKnora支持本地化和私有云部署,这意味着整个问答系统可以完全运行在你自己的服务器或本地电脑上。所有上传的文档和数据都在你的控制范围内,不会上传到任何外部服务器,保障了高敏感场景下的数据安全。