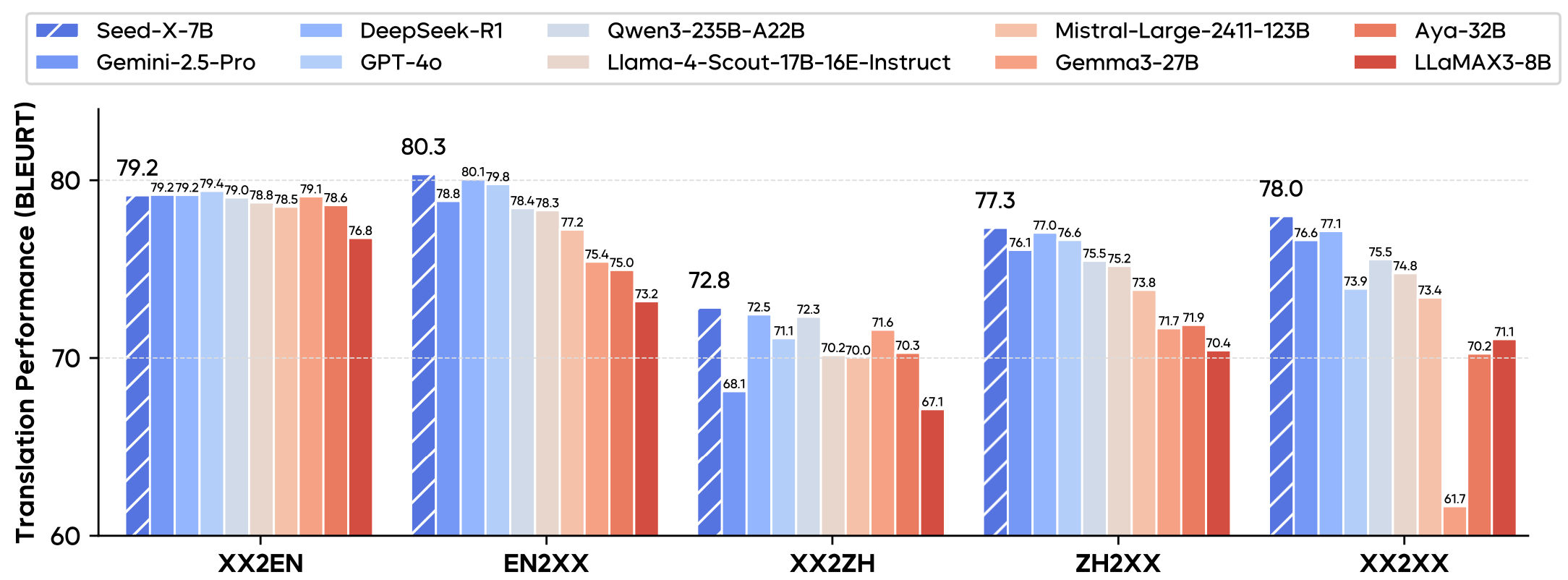

Seed-X-7B 是由字节跳动 Seed 团队开发的一款开源多语言翻译大语言模型,专注于提供高效、准确的翻译功能。它基于 7B 参数的 Mistral 架构,支持 28 种语言的翻译,覆盖互联网、科技、电商、生物医学等多个领域。模型通过预训练、指令微调和强化学习优化,翻译质量可媲美 Gemini-2.5 和 GPT-4o 等大型模型。Seed-X-7B 部署简单,适合研究和实际应用场景。用户可通过 Hugging Face 或 GitHub 获取模型权重和代码,免费用于翻译任务。

功能列表

- 支持 28 种语言的文本翻译,覆盖高资源和低资源语言。

- 提供指令模型(Seed-X-Instruct)和强化学习优化模型(Seed-X-PPO),后者翻译性能更优。

- 支持链式推理(Chain-of-Thought),提升复杂翻译任务的准确性。

- 采用 Mistral 架构,参数规模为 7B,推理效率高,适合多设备部署。

- 开源模型权重和代码,支持社区二次开发和研究。

- 支持多样化翻译场景,包括互联网、科技、法律、文学等领域。

- 提供 Beam Search 和 Sampling 解码方式,优化翻译输出质量。

使用帮助

安装流程

要使用 Seed-X-7B 模型,用户需要先安装必要的环境和依赖。以下是详细的安装和使用步骤,基于官方 GitHub 仓库的说明:

- 克隆仓库

使用 Git 克隆 Seed-X-7B 项目代码:git clone https://github.com/ByteDance-Seed/Seed-X-7B.git cd Seed-X-7B - 创建虚拟环境

使用 Conda 创建 Python 3.10 环境,并激活:conda create -n seedx python=3.10 -y conda activate seedx - 安装依赖

安装项目所需的 Python 库:pip install -r requirements.txt如果需要加速推理,安装 Flash Attention:

pip install flash_attn==2.5.9.post1 --no-build-isolation - 下载模型权重

从 Hugging Face 下载 Seed-X-7B 模型权重。推荐使用 Seed-X-PPO-7B 模型,因其翻译性能更优:from huggingface_hub import snapshot_download save_dir = "ckpts/" repo_id = "ByteDance-Seed/Seed-X-PPO-7B" cache_dir = save_dir + "/cache" snapshot_download( cache_dir=cache_dir, local_dir=save_dir, repo_id=repo_id, local_dir_use_symlinks=False, resume_download=True, allow_patterns=["*.json", "*.safetensors", "*.pth", "*.bin", "*.py", "*.md", "*.txt"] ) - 硬件要求

- 单 GPU 推理:1 张 H100-80G 可处理 720×1280 视频或文本翻译任务。

- 多 GPU 推理:4 张 H100-80G 支持 1080p 或 2K 分辨率任务,需设置

sp_size=4。 - 建议使用高性能 GPU 以提升推理速度。

使用方法

Seed-X-7B 提供两种主要模型:Seed-X-Instruct-7B 和 Seed-X-PPO-7B。以下以 Seed-X-PPO-7B 为例,展示如何进行翻译任务。

单句翻译(无链式推理)

使用 vLLM 库进行快速推理,翻译英语句子到中文:

from vllm import LLM, SamplingParams

model_path = "./ByteDance-Seed/Seed-X-PPO-7B"

model = LLM(model=model_path, max_num_seqs=512, tensor_parallel_size=8, enable_prefix_caching=True, gpu_memory_utilization=0.95)

messages = ["Translate the following English sentence into Chinese:\nMay the force be with you <zh>"]

decoding_params = SamplingParams(temperature=0, max_tokens=512, skip_special_tokens=True)

results = model.generate(messages, decoding_params)

responses = [res.outputs[0].text.strip() for res in results]

print(responses) # 输出:['愿原力与你同在']

带链式推理的翻译

对于复杂句子,可启用链式推理(Chain-of-Thought)以提高翻译准确性:

messages = ["Translate the following English sentence into Chinese and explain it in detail:\nMay the force be with you <zh>"]

decoding_params = BeamSearchParams(beam_width=4, max_tokens=512)

results = model.generate(messages, decoding_params)

responses = [res.outputs[0].text.strip() for res in results]

print(responses) # 输出翻译结果及推理过程

批量推理

若需翻译多个句子,可通过 vLLM 的批量推理功能处理:

messages = [

"Translate the following English sentence into Chinese:\nThe sun sets slowly behind the mountain <zh>",

"Translate the following English sentence into Chinese:\nKnowledge is power <zh>"

]

results = model.generate(messages, decoding_params)

responses = [res.outputs[0].text.strip() for res in results]

print(responses) # 输出:['太阳慢慢地落在山后', '知识就是力量']

特色功能操作

- 多语言支持

Seed-X-7B 支持 28 种语言,包括英语、中文、西班牙语、法语等高资源语言,以及部分低资源语言。用户只需在输入中指定目标语言(例如<zh>表示中文),模型即可生成对应翻译。 - 链式推理(CoT)

对于复杂句子,启用链式推理可让模型逐步分析句子的语义和上下文。例如,翻译文学或法律文本时,模型会先分解句子结构,再生成准确的翻译结果。 - Beam Search 解码

使用 Beam Search(beam_width=4)可生成更高质量的翻译结果,适合需要精确输出的场景。相比 Sampling 解码,Beam Search 更稳定但计算成本稍高。 - 跨领域翻译

Seed-X-7B 在互联网、科技、电商、生物医学、法律等领域的翻译表现出色。用户可直接输入专业术语或长段文本,模型能保持术语准确性和上下文连贯性。

注意事项

- GPU 性能:单 GPU 推理可能较慢,建议使用多 GPU 并行处理以提升效率。

- 模型选择:优先使用 Seed-X-PPO-7B,因其经过强化学习优化,翻译效果优于 Seed-X-Instruct-7B。

- 错误反馈:如遇到翻译错误,可在 GitHub 仓库提交 issue 或联系官方邮箱,提供输入和输出样本以帮助模型改进。

应用场景

- 跨国电商

Seed-X-7B 可用于翻译产品描述、用户评论和客服对话,支持多语言市场扩展。例如,将英文产品描述翻译为中文、西班牙语等,保持术语准确性。 - 学术研究

研究人员可使用模型翻译学术论文、会议材料或技术文档。例如,将英文科技论文翻译为中文,保留专业术语的准确性。 - 内容创作

内容创作者可翻译文章、博客或社交媒体内容,支持多语言发布。例如,将中文博客翻译为英文,吸引国际读者。 - 法律和金融

模型能处理法律合同或金融报告的翻译,确保术语规范。例如,翻译英文合同为中文,保持法律语言的严谨性。

QA

- Seed-X-7B 支持哪些语言?

支持 28 种语言,包括英语、中文、西班牙语、法语等高资源语言,以及部分低资源语言。具体语言列表可参考官方文档。 - 如何选择 Seed-X-Instruct 和 Seed-X-PPO 模型?

Seed-X-PPO 经过强化学习优化,翻译性能更优,推荐用于生产环境。Seed-X-Instruct 适合快速测试或轻量级任务。 - 模型是否支持实时翻译?

目前模型更适合离线批量翻译,实时翻译需优化推理速度,建议使用高性能 GPU。 - 如何处理翻译错误?

可在 GitHub 提交 issue,提供原始文本和翻译结果,或联系官方邮箱反馈。