Vamos começar com uma tarefa simples: agendar uma reunião.

Quando um usuário diz: "Ei, vamos ver se conseguimos fazer uma sincronização rápida amanhã?"

Uma IA que depende apenas do Prompt Engineering pode responder: "Sim, amanhã está bom. A que horas você gostaria de agendar, por favor?" Essa resposta, embora correta, é mecânica e inútil porque não tem compreensão do mundo real.

Agora, imagine outra IA. Ela não apenas vê a frase quando recebe a mesma solicitação, mas também tem acesso imediato a um ambiente rico em informações: seu calendário mostra que a agenda de amanhã está cheia; o histórico de e-mails com a outra pessoa sugere que seu estilo de comunicação é informal; a lista de contatos marca a outra pessoa como um parceiro importante; e a IA tem acesso instrumental para enviar convites para reuniões e e-mails diretamente.

Nesse momento, ele responderia com algo como: "Ei, Jim! Dei uma olhada e minha agenda está completamente cheia amanhã. Parece que há uma vaga na quinta-feira de manhã, isso seria conveniente para você? Se estiver tudo bem, enviarei um convite".

A diferença não se deve ao fato de o segundo modelo de IA ser "mais inteligente" em si, mas ao fato de estar em um "contexto" mais completo. Essa mudança de paradigma, da otimização de uma única instrução para a criação de ambientes de informações dinâmicas, é a evolução mais importante no desenvolvimento de aplicativos de IA atualmente: da engenharia de dicas para a engenharia de contexto.

O que é engenharia contextual?

Andrej Karpathy oferece uma excelente analogia: o Modelo de Linguagem Ampla (LLM) é como um novo tipo de sistema operacional, e sua Janela de Contexto é a RAM. A principal tarefa da engenharia contextual é gerenciar essa RAM de forma eficiente, inserindo as informações mais importantes antes de cada operação.

Uma definição mais engenhosa é:A engenharia contextual é a disciplina de projetar e criar sistemas dinâmicos que fornecem as informações e as ferramentas certas para a solução de problemas no formato certo, no momento certo, para um grande modelo de linguagem.

O "contexto" que ele gerencia é um sistema tridimensional de sete dimensões:

- Instruções. Defina dicas em nível de sistema para o código de conduta e a identidade da IA.

- Prompt do usuário. Questões ou tarefas específicas levantadas pelos usuários.

- Memória de curto prazo (estado/histórico). O histórico de interação do diálogo atual garante a continuidade do diálogo.

- Memória de longo prazo. Conhecimento persistente em várias conversas, como as preferências do usuário.

- Informações recuperadas. Conhecimento adquirido externamente em tempo real por meio de técnicas como o RAG.

- Ferramentas disponíveis. Uma lista de funções ou APIs que a IA pode chamar.

- Saída estruturada. Definição do formato de saída do IA, como uma solicitação para retornar JSON.

Por que o contexto é tão importante? Os quatro modos de falha

Quando o desempenho de um sistema do Agent é ruim, a causa principal geralmente é um problema com o gerenciamento de contexto. Um contexto excessivamente longo ou de baixa qualidade geralmente leva aos quatro modos de falha a seguir:

- Envenenamento por contexto. As informações incorretas ou geradas por ilusões de modelo entram no contexto e contaminam as decisões subsequentes.

- Distração de contexto. O excesso de informações externas sobrecarrega as instruções principais, fazendo com que o modelo se desvie dos objetivos da missão.

- Confusão de contexto. Alguns detalhes ambíguos ou desnecessários no contexto afetam a precisão do resultado final.

- Confronto de contextos. Há contradições factuais ou lógicas em diferentes partes do contexto.

Para enfrentar esses desafios de forma sistemática, os desenvolvedores criaram quatro estratégias principais para gerenciar o contexto.

Estratégia básica para engenharia contextual

1. gravação: salva informações no armazenamento externo.

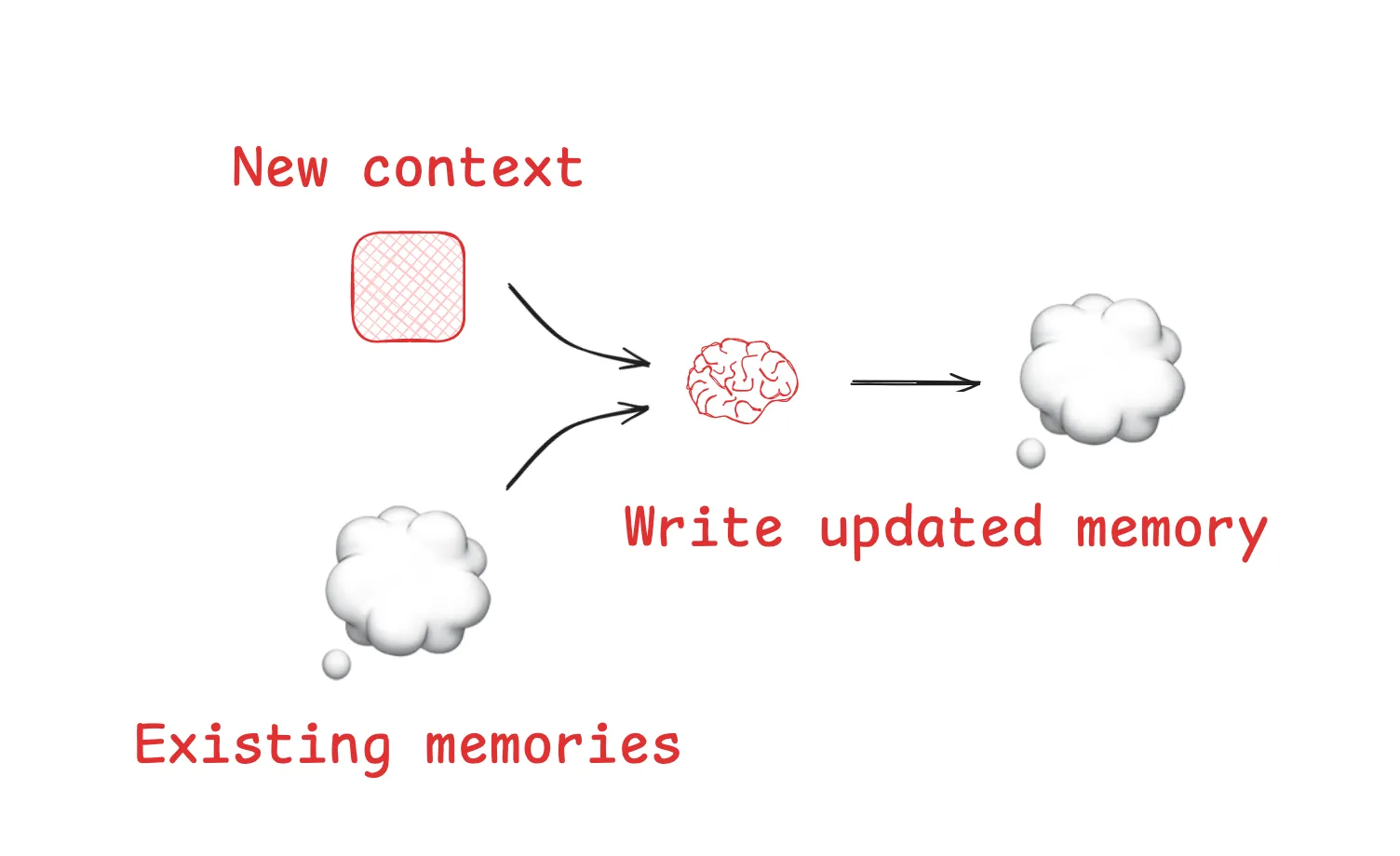

"Escrever" é fornecer ao agente a capacidade de fazer anotações e armazenar informações importantes fora de uma janela de contexto limitada.

- Raspadinhas. Um tipo de memória de curto prazo em uma tarefa. Por exemplo.

AnthropicO estudo mostrou que seusLeadResearcherO agente "grava" o plano pensado na memória externa antes de executar tarefas complexas, evitando que o plano principal seja perdido devido à sobrecarga de contexto. - Memórias. Permite que o agente se lembre das informações em todas as sessões. Como o

ChatGPTfunção de memória, bem como ferramentas de desenvolvimentoCursor和Windsurfem todos eles contêm mecanismos para gerar e preservar automaticamente memórias de longo prazo com base nas interações do usuário.

2. selecionar: puxa o contexto relevante para a janela sob demanda

A "Seleção" é responsável por selecionar as partes mais importantes da tarefa atual a partir da enorme quantidade de informações externas e colocá-las na janela de contexto no momento certo.

- Selecione a partir de um arquivo específico:. Alguns agentes maduros obtêm contexto lendo arquivos específicos. Por exemplo.

Claude CodeleráCLAUDE.mde o arquivoCursorEm vez disso, os arquivos de regras são usados para carregar especificações de codificação, o que é uma maneira eficiente de selecionar a "memória processual". - Selecione no conjunto de ferramentas. Quando o número de ferramentas disponíveis é muito alto, o uso de RAG A tecnologia recupera e "seleciona" dinamicamente as ferramentas mais relevantes com base na tarefa em questão, aumentando em várias vezes a precisão da seleção de ferramentas.

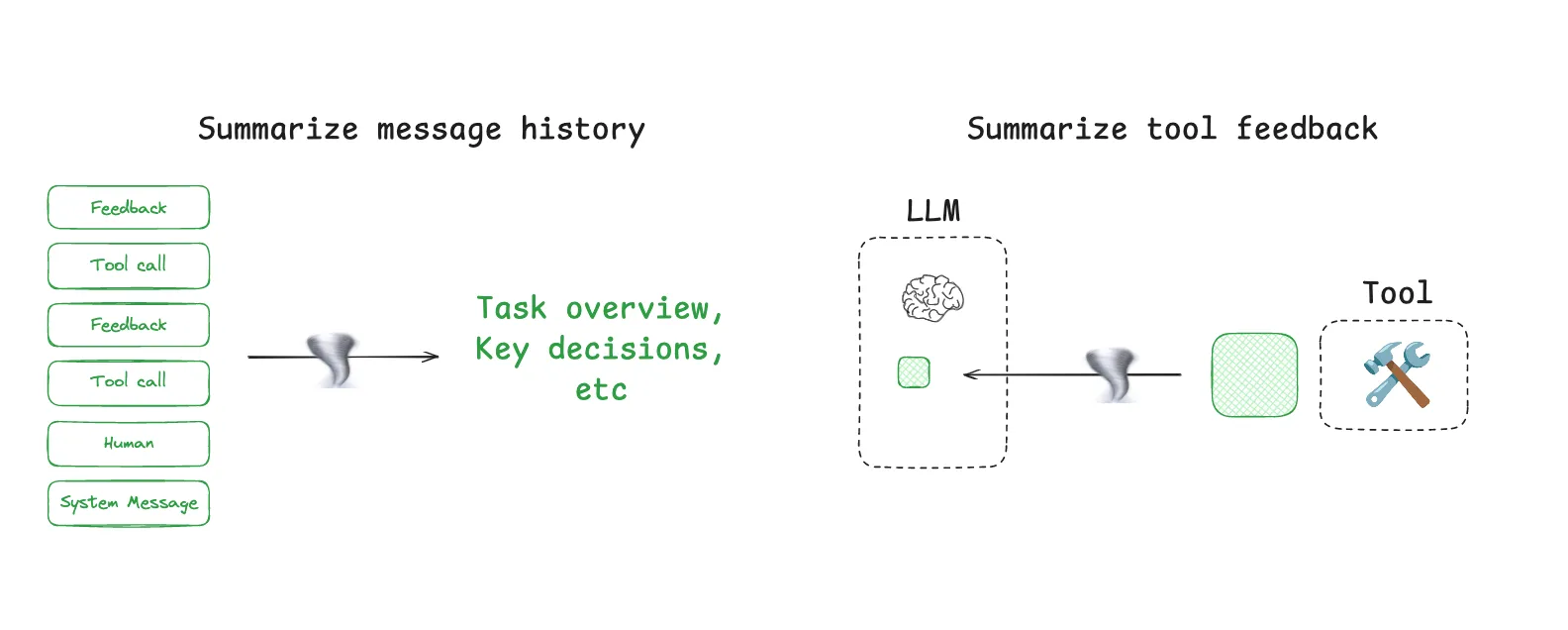

3. comprimir: manter o essencial, reduzir a redundância

A "compressão" visa reduzir o número de tokens ocupados pelo contexto sem perder informações essenciais.

- Sumarização de contexto. Quando o histórico do diálogo se torna muito longo, o LLM pode ser chamado para resumi-lo.

Claude CodeUm exemplo típico disso é o recurso "auto-compact", que resume automaticamente o histórico completo da conversa quando o uso do contexto excede 95%. - Corte de contexto. Um filtro baseado em regras. A abordagem mais simples é simplesmente remover as primeiras rodadas de diálogo, enquanto as abordagens mais avançadas usam modelos de "podador de contexto" especialmente treinados para identificar e remover informações sem importância.

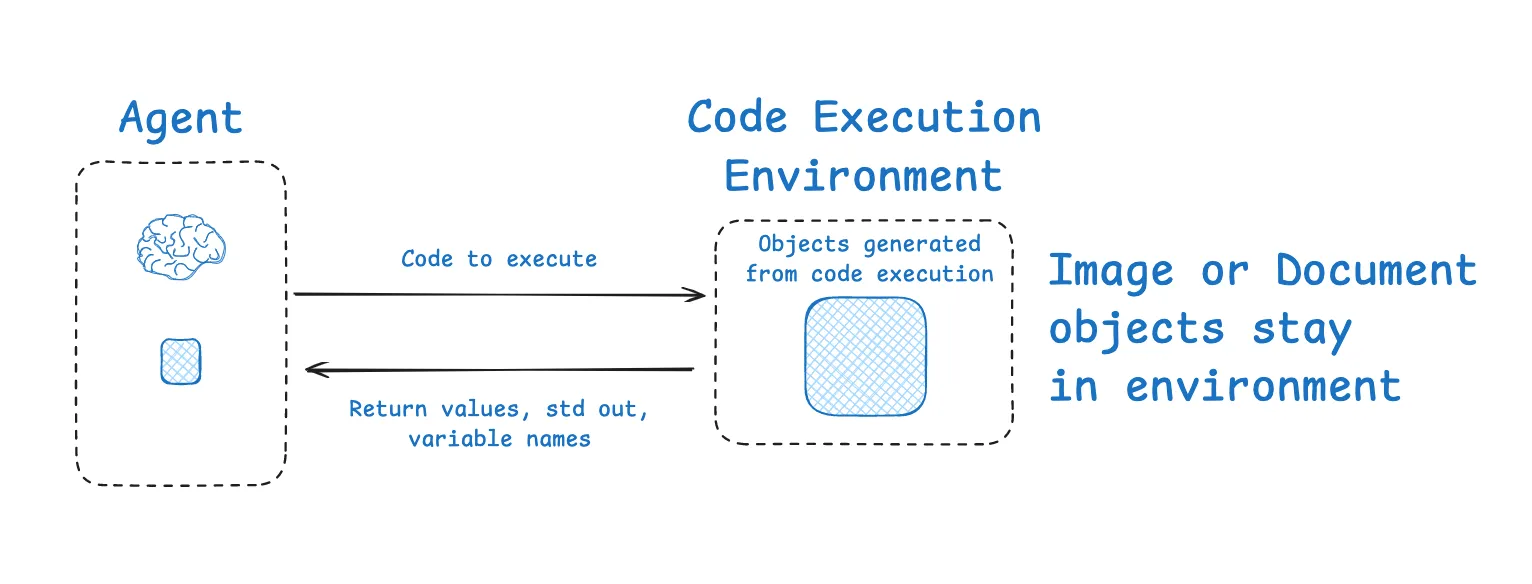

4. isolar: divisão de contextos para lidar com tarefas complexas

A ideia central do "isolamento" é "dividir e conquistar", dividindo uma tarefa grande de modo que contextos diferentes sejam processados em ambientes isolados.

- Multi-agente. Decompor tarefas complexas em vários agentes especializados com janelas de contexto independentes.

Anthropicdescobriram que equipes de vários subagentes trabalhando em paralelo superam em muito o desempenho de um único agente com um contexto enorme em uma tarefa de pesquisa. - Ambientes de sandbox. Para tarefas do tipo execução de código, o processo de execução pode ser isolado em uma área restrita.

HuggingFace的CodeAgenté um exemplo em que o LLM é responsável pela geração do código e, depois que o código é executado na área restrita, somente os resultados mais críticos da execução são retornados ao contexto do LLM, e não o registro completo da execução.

Ferramentas para engenharia contextual: LangGraph e LangSmith

É necessária uma estrutura suficientemente flexível e controlável para realizar as estratégias complexas descritas acima.LangChain no ecossistema LangGraph 和 LangSmith Um forte suporte é fornecido para essa finalidade.

LangGraph é uma estrutura de baixo nível para a criação de agentes controlados. Ele cria o fluxo de trabalho de um agente como um gráfico de estados e foi projetado para atender perfeitamente às necessidades da engenharia contextual:

- Objeto de estado. Atua como uma "área de preparação" perfeita (para gravações) e uma área de "isolamento" contextual. Você pode definir diferentes campos no estado, alguns dos quais são expostos ao LLM e outros são internos e usados "seletivamente" conforme necessário.

- Persistência e memória. Seus módulos integrados de checkpointing e memória facilitam a "gravação" e a "seleção" de memórias de curto e longo prazo.

- Nós personalizáveis. Cada nó do diagrama é uma etapa programável. Você pode implementar facilmente a lógica de "compressão" nos nós, como resumir os resultados imediatamente após chamar uma ferramenta.

- Arquitetura corporal multiinteligente.

LangGraphfornecer informações comosupervisor和swarmAs bibliotecas, como o CMS, suportam nativamente a construção de sistemas complexos de inteligência múltipla, permitindo o "isolamento" contextual.

LangSmith É uma plataforma de observabilidade. Ela permite que você rastreie claramente cada etapa do processo de tomada de decisão de um agente como se estivesse depurando um aplicativo normal, vendo exatamente quais informações estão contidas na janela de contexto para cada chamada LLM. Isso proporciona uma visão indispensável para diagnosticar e otimizar a engenharia contextual e a capacidade de validar a eficácia das estratégias de otimização por meio da função Eval.

Da "alquimia" da engenharia de pistas à "ciência de sistemas" da engenharia contextual, essa não é apenas a evolução da tecnologia, mas também o caminho inevitável para a criação de aplicativos de IA confiáveis e avançados. Dominar essa arte, bem como LangGraph 和 LangSmith Ferramentas como essas estão se tornando uma competência essencial para os engenheiros de IA.