2025年8月5日, OpenAI 投下了一颗重磅炸弹,正式发布了两款名为 gpt-oss-120b 和 gpt-oss-20b 的开源语言模型。这一举动标志着自 GPT-2 以来,OpenAI 首次重返大型语言模型的开源领域,此举被普遍认为是其应对日益激烈的市场竞争,尤其是在 Meta 的 Llama 系列和 Mistral AI 等开源力量崛起背景下的直接回应。

这两款模型在 Apache 2.0 许可下发布,允许开发者和企业自由进行实验、定制乃至商业部署,而无需担忧版权或专利风险。

模型特性与深度定制

OpenAI 强调,gpt-oss 模型专为智能体(Agent)工作流设计,具备强大的指令遵循、工具使用和推理能力。其核心特性包括:

- 专为智能体任务设计: 模型内置了强大的工具使用能力,例如网页搜索和

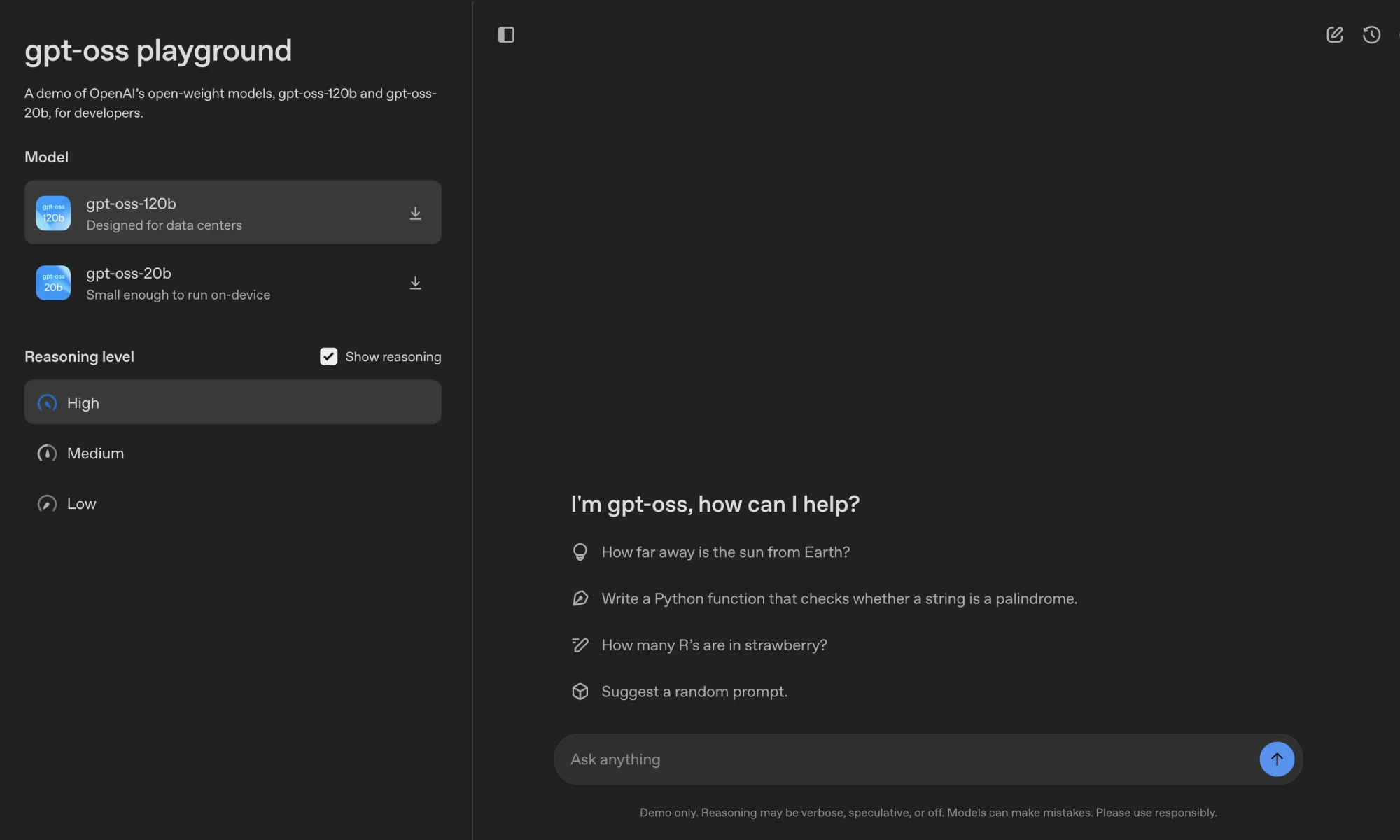

Python代码执行,这使其在构建复杂自动化任务流程时极具潜力。 - 可深度定制: 用户可以根据具体应用场景,对模型的推理强度在低、中、高三个档位间进行调整。同时,模型支持全参数微调,为个性化定制提供了最大空间。

- 完整的思想链 (Chain of Thought):

OpenAI选择不对此模型的思想链(CoT)进行直接监督,开发者可以访问其完整的推理过程。这不仅便于调试和提升对模型输出结果的信任,也为研究社区提供了监测和研究模型行为的宝贵机会。

OpenAI 提供了一个简单的在线 Playground,让开发者可以直接在浏览器中体验这两款模型的交互能力。

技术架构与性能表现

gpt-oss 系列采用了与 GPT-3 类似的 Transformer 架构,并引入了专家混合(Mixture-of-Experts, MoE)技术以提升效率。MoE 架构通过仅激活处理当前任务所需的部分参数,显著降低了计算成本。

gpt-oss-120b模型拥有1170亿总参数,但在处理每个 token 时仅激活51亿参数。gpt-oss-20b模型拥有210亿总参数,激活参数为36亿。

两个模型均支持高达 128k 的上下文长度,并使用分组多查询注意力和旋转位置嵌入(RoPE)来优化推理和内存效率。

模型架构详情

| 模型 | 层数 | 总参数 | 每个令牌的活跃参数 | 总专家数 | 每个令牌的活跃专家数 | 上下文长度 |

|---|---|---|---|---|---|---|

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

在性能方面,OpenAI 公布的基准测试数据显示 gpt-oss 的表现极具竞争力。

模型性能对比

| gpt-oss-120b | gpt-oss-20b | OpenAI o3 | OpenAI o4-mini | |

|---|---|---|---|---|

| 推理与知识 | ||||

| MMLU | 90.0 | 85.3 | 93.4 | 93.0 |

| GPQA 钻石级 | 80.9 | 74.2 | 77.0 | 81.4 |

| 人类终极测试 | 19.0 | 17.3 | 24.9 | 17.7 |

| 竞赛数学 | ||||

| AIME 2024 | 96.6 | 96.0 | 91.6 | 93.4 |

| AIME 2025 | 97.9 | 98.7 | 88.9 | 92.7 |

数据显示,旗舰级的 gpt-oss-120b 在多项核心推理基准测试中,其性能与 OpenAI 自己的闭源模型 o4-mini 不相上下,甚至在竞赛数学等特定领域实现了超越。而轻量级的 gpt-oss-20b 其性能也与 o3-mini 相当或更优。这种表现使其不仅是理论上的强者,更具备了在实际应用中挑战顶级闭源模型的潜力。

安全标准与生态系统

面对开源模型可能被恶意利用的风险,OpenAI 强调已将安全置于核心位置。

OpenAI 采用了其内部的《防范准备框架》,对经过对抗性微调的 gpt-oss-120b 版本进行了严格测试,结论是该模型并未达到“高能力”风险水平。此外,OpenAI 还发起了奖金池高达50万美元的红队测试挑战赛,鼓励社区共同挖掘潜在安全问题。

在可用性方面,OpenAI 已经与 Hugging Face、Azure、AWS 等部署平台,以及 NVIDIA、AMD 等硬件厂商展开合作,确保模型可以被广泛、高效地使用。gpt-oss-120b 已被量化为可在单张 80GB 内存的 GPU 上运行,而 gpt-oss-20b 更是仅需 16GB 内存,这极大地降低了开发者在消费级硬件上进行本地部署和实验的门槛。

战略意义:开放是新的护城河?

OpenAI 此番高调拥抱开源,无疑是对当前 AI 格局的深刻洞察和战略调整。过去,OpenAI 凭借 GPT 系列闭源模型的性能优势,在商业化上取得了巨大成功。但 Meta 的 Llama 系列证明了,一个强大的开源模型能够催生出一个庞大且富有活力的开发者生态,这种生态本身就是一种强大的护城河。

通过发布具有竞争力的 gpt-oss 模型,OpenAI 不仅可以减缓开发者向竞争对手开源生态的流动,还能将自己的技术栈(如 Harmony 提示格式)推广为行业标准。这是一种防御,更是一种进攻。它让 OpenAI 得以在闭源和开源两个战场同时作战,既能通过 API 提供最顶尖的闭源模型获取收入,又能通过开源模型构建社区、吸引人才,并探索新的商业可能性。

对于整个行业而言,OpenAI 的入局将彻底点燃开源大模型领域的战火。开发者将拥有更多高质量、可定制的选择,而模型性能和安全性的标准也将被推向新的高度。这究竟是 OpenAI 的一次性战术防御,还是其长期战略的根本性转变,将取决于其后续的投入和社区的反馈。无论如何,AI 的开放时代已经真正来临。