8月7日,MiniMax 公司发布了其新一代语音生成模型 Speech 2.5。据官方资料显示,该模型在前代 Speech 02 的基础上,于多语种表现力、音色复刻精度以及支持的语种数量上实现了提升。

在人工智能生成内容(AIGC)领域,文本到语音(TTS)技术是实现更自然人机交互的关键环节。评价一个语音模型的优劣,通常会综合考量多个维度,包括发音的准确性(如低字错率)、生成语音与目标音色的相似度,以及语音的自然韵律度(如停顿、重音是否符合人类习惯)。MiniMax 的此次更新,正是围绕这些核心指标展开。

核心升级:多语种、音色与覆盖范围

根据 MiniMax 官方发布的信息,Speech 2.5 的主要突破体现在以下三个方面:

- 多语种表现力增强:模型在中文普通话的生成效果上进一步优化,同时提升了在英语等主流语种上的表现。官方宣称,新模型在相似度和自然韵律度上超越了前代,旨在解决多语言场景下普遍存在的“机械感”问题。

- 音色复刻精度提高:音色复刻,即克隆特定人物声音的能力,是当前

TTS领域竞争的焦点之一。Speech 2.5提升了对声音细节的捕捉能力,尤其是在跨语种复刻和保留特定口音(如同语种下的地区口音)等复杂场景下,力求实现更高保真度的还原。例如,模型可以模仿特定风格的演讲腔调,并在切换语言时保留原说话者的声音特质。 - 语种覆盖范围扩大:新模型增加了对保加利亚语、丹麦语、希伯来语等小众语言的支持,总语种数量达到40个。这一扩展对于需要进行全球化内容部署的企业具有实际意义。

市场应用与行业影响

高质量、多语言的语音合成技术,其应用场景正从传统的有声读物、导航语音,向更广阔的领域拓展。

对于企业用户,尤其是有出海业务的公司,Speech 2.5 这样的模型能够大幅降低多语种内容制作的成本。以往需要聘请不同国家母语配音员完成的广告、产品宣传片和客服语音,现在可以通过模型快速生成,显著缩短制作周期并降低费用。

对于内容创作者,个性化音色复刻意味着他们可以用自己的声音发布多语言内容,打破语言壁垒,从而覆盖更广泛的全球受众。这在短视频、播客和虚拟人直播等领域有巨大的应用潜力。

在教育领域,该技术也能用于快速生成小众语言的教学课件,或制作带有特定地区方言的定制化教材,让知识传播更具本地化特色。

市场竞争格局

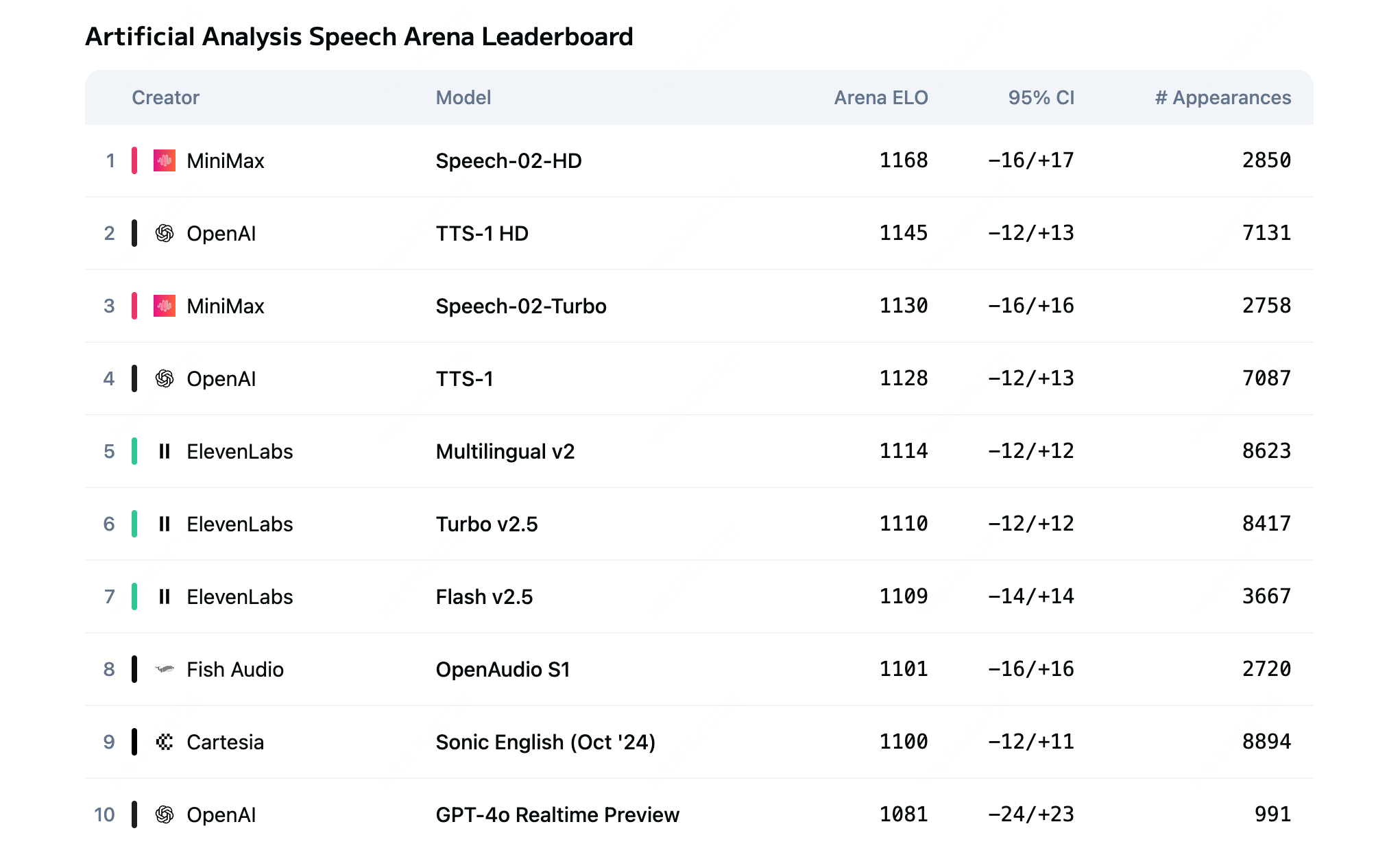

语音合成并非一个新兴赛道,市场竞争激烈。MiniMax Speech 的主要竞争者包括 ElevenLabs,后者以其强大的声音克隆和情感表达能力而闻名。同时,OpenAI 的 Voice Engine 和 Microsoft 的 VALL-E 等模型也展示了强大的技术实力,尽管部分尚未大规模向公众开放。

MiniMax 在新闻稿中提到,其 Speech 模型已被 Vapi、Pipecat 等海外 Agent 平台以及国内的高途教育、喜马拉雅等公司采用。通过不断迭代模型并扩大语种支持,MiniMax 显然希望在激烈的全球市场竞争中,凭借性价比和对特定市场的深入支持来占据一席之地。

目前,Speech 2.5 已通过 MiniMax 开放平台和其官方网站向用户提供。