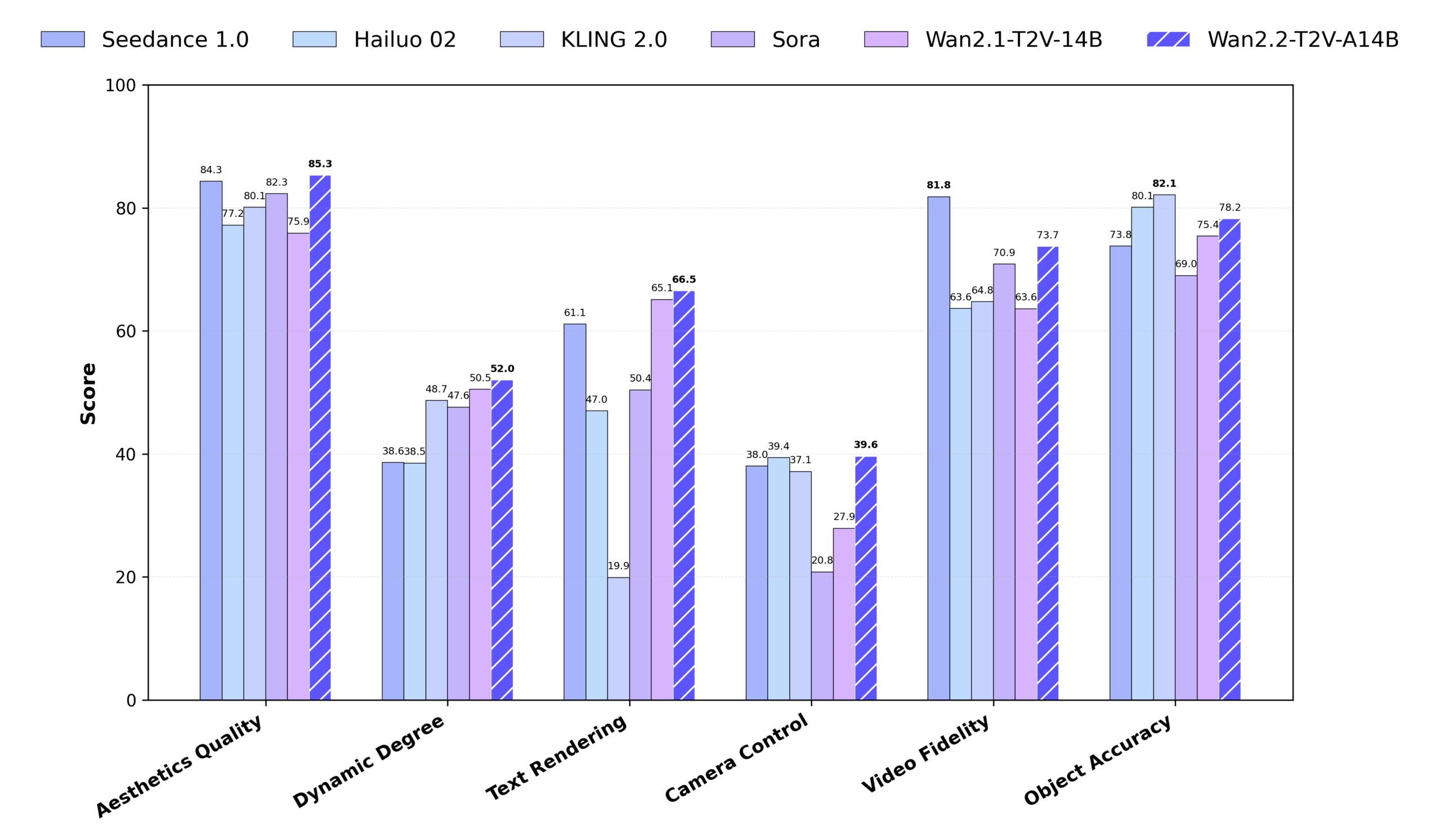

Wan2.2 是由阿里巴巴通义实验室开发的开源视频生成模型,专注于通过文本或图像生成高质量视频。它采用混合专家(MoE)架构,通过分离高噪声和低噪声阶段的去噪过程,显著提升生成质量,同时保持计算效率。Wan2.2 支持 720P@24fps 高清视频生成,可运行在消费级 GPU(如 RTX 4090)上,适合个人创作者和开发者。相比 Wan2.1,Wan2.2 训练数据增加 65.6% 的图像和 83.2% 的视频,显著提升了运动生成、语义理解和美学效果。它支持文本转视频(T2V)、图像转视频(I2V)以及文本-图像联合生成(TI2V),并集成到 Diffusers 和 ComfyUI,提供灵活的使用方式。Wan2.2 在 Wan-Bench 2.0 基准测试中超越部分商业模型,展现出强大的性能和广泛的应用潜力。

功能列表

- 文本转视频(T2V) :根据文本描述生成 5 秒 480P 或 720P 视频,支持复杂场景和动作。

- 图像转视频(I2V) :从静态图像生成动态视频,保持画面一致性和风格。

- 文本-图像联合生成(TI2V) :结合文本和图像生成 720P@24fps 视频,适合低显存设备。

- 高效视频变分自编码器(Wan-VAE) :实现 16×16×4 压缩比,支持高质量视频重建。

- 混合专家架构(MoE) :使用高噪声和低噪声专家模型,提升生成质量,保持计算效率。

- 电影级美学效果 :支持精细控制光线、构图和色调,生成专业电影风格视频。

- 复杂运动生成 :支持动态动作如跳舞、格斗、跑酷等,动作流畅自然。

- 提示扩展 :通过 Dashscope API 或本地 Qwen 模型丰富文本提示,提升视频细节。

- 低显存优化 :支持 FP8 量化和模型卸载,降低 GPU 显存需求。

- 多平台集成 :支持 Diffusers 和 ComfyUI,提供命令行和图形界面操作。

使用帮助

安装流程

要使用 Wan2.2,需要在本地或服务器上配置环境。以下是详细的安装和使用步骤,适合初学者和有经验的开发者。

1. 环境准备

确保你的系统满足以下要求:

- 硬件 :T2V-A14B 和 I2V-A14B 模型需要至少 80GB 显存的 GPU(如 A100);TI2V-5B 模型支持 24GB 显存的消费级 GPU(如 RTX 4090)。

- 操作系统 :支持 Windows、Linux 或 macOS。

- Python 版本 :Python 3.10 或更高版本。

- 依赖工具 :Git、PyTorch(建议 2.4.0 或更高版本)、Hugging Face CLI、ModelScope CLI。

2. 克隆代码库

在终端或命令提示符中运行以下命令,克隆 Wan2.2 代码库:

git clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

3. 安装依赖

安装必要的 Python 库。运行以下命令:

pip install -r requirements.txt

pip install "huggingface_hub[cli]" modelscope

如果使用多 GPU 加速,需安装 xfuser>=0.4.1:

pip install "xfuser>=0.4.1"

注意 :如果 flash_attn 安装失败,建议先安装其他依赖,最后单独安装 flash_attn。

4. 下载模型权重

Wan2.2 提供三种模型:T2V-A14B、I2V-A14B 和 TI2V-5B。以下是下载命令:

Hugging Face 下载 :

huggingface-cli download Wan-AI/Wan2.2-T2V-A14B --local-dir ./Wan2.2-T2V-A14B

huggingface-cli download Wan-AI/Wan2.2-I2V-A14B --local-dir ./Wan2.2-I2V-A14B

huggingface-cli download Wan-AI/Wan2.2-TI2V-5B --local-dir ./Wan2.2-TI2V-5B

ModelScope 下载 :

modelscope download Wan-AI/Wan2.2-T2V-A14B --local_dir ./Wan2.2-T2V-A14B

modelscope download Wan-AI/Wan2.2-I2V-A14B --local_dir ./Wan2.2-I2V-A14B

modelscope download Wan-AI/Wan2.2-TI2V-5B --local_dir ./Wan2.2-TI2V-5B

5. 配置环境变量(可选)

如果使用提示扩展功能,需配置 Dashscope API 密钥:

export DASH_API_KEY=your_dashscope_api_key

对于国际用户,需额外设置:

export DASH_API_URL=https://dashscope-intl.aliyuncs.com/api/v1

你需要提前在 Alibaba Cloud 申请 API 密钥。

6. 运行生成脚本

Wan2.2 提供 generate.py 脚本用于生成视频。以下是各任务的运行示例:

文本转视频(T2V-A14B) :

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --offload_model True --convert_model_dtype --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- 单 GPU :需要 80GB 显存,启用

--offload_model True和--convert_model_dtype降低显存需求。 - 多 GPU :

torchrun --nproc_per_node=8 generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --dit_fsdp --t5_fsdp --ulysses_size 8 --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

图像转视频(I2V-A14B) :

python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --offload_model True --convert_model_dtype --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上,背景是模糊的海景和绿色山丘"

- 图像分辨率需与目标视频分辨率一致。

- 支持无提示词生成,仅依赖输入图像:

DASH_API_KEY=your_key python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --prompt '' --image examples/i2v_input.JPG --use_prompt_extend --prompt_extend_method 'dashscope'

文本-图像联合生成(TI2V-5B) :

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- 图像输入 (I2V 模式):

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上"

- TI2V-5B 支持 24GB 显存的 GPU,生成 720P@24fps 视频约需 9 分钟。

提示扩展 :

使用 Dashscope API:

DASH_API_KEY=your_key python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'dashscope' --prompt_extend_target_lang 'zh' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

使用本地 Qwen 模型(如 Qwen/Qwen2.5-7B-Instruct):

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'local_qwen' --prompt_extend_model 'Qwen/Qwen2.5-7B-Instruct' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

7. 使用 ComfyUI

Wan2.2 已集成到 ComfyUI,适合图形界面用户。安装步骤:

- 克隆 ComfyUI-WanVideoWrapper:

git clone https://github.com/kijai/ComfyUI-WanVideoWrapper.git

cd ComfyUI-WanVideoWrapper

pip install -r requirements.txt

- 将模型文件放入 ComfyUI 目录:

- T2V/I2V 模型:

ComfyUI/models/diffusion_models/ - VAE 模型:

ComfyUI/models/vae/ - CLIP 模型:

ComfyUI/models/clip_vision/

- T2V/I2V 模型:

- 在 ComfyUI 中加载工作流,导入 Wan2.2 模型,设置提示词并运行。

8. 使用 Diffusers

Wan2.2 已集成到 Diffusers,简化模型调用:

from diffusers import DiffusionPipeline

pipeline = DiffusionPipeline.from_pretrained("Wan-AI/Wan2.2-TI2V-5B-Diffusers")

pipeline.to("cuda")

video = pipeline(prompt="两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战").videos

支持 T2V-A14B、I2V-A14B 和 TI2V-5B 模型。

操作主要功能

文本转视频

输入详细的文本描述,如“夜晚的城市天际线,霓虹灯闪烁”,生成 5 秒视频。建议使用具体提示词,如“一个穿红色外套的女孩在雪地中漫步,背景是白雪覆盖的森林”。启用提示扩展(--use_prompt_extend)可自动丰富描述,生成更细致的画面。

图像转视频

上传一张图片,配合文本描述,生成动态视频。例如,上传猫的照片,输入“猫在草地上追逐蝴蝶”,生成相应动画。确保图像分辨率与目标视频一致。

文本-图像联合生成

TI2V-5B 模型支持文本或图像输入,生成 720P@24fps 视频。适合低显存设备,生成速度快,效果稳定。

电影级美学效果

Wan2.2 支持精细控制光线、构图和色调。例如,输入“侧光照明,高对比度,温暖色调,一个年轻男子站在森林中”,生成电影风格视频。

复杂运动生成

支持生成动态动作,如“街头跑酷运动员翻越障碍”或“嘻哈舞者在霓虹灯舞台上表演”,动作流畅自然。

应用场景

- 内容创作

- 创作者可将文本或图片转为短视频,制作广告、短片或社交媒体内容。例如,生成“科幻飞船穿越星际”的动画视频。

- 教育与演示

- 教师可将静态课件转为动态视频,增强教学效果。例如,将历史事件描述转为视频,展示历史场景。

- 游戏与动画开发

- 开发者可生成游戏背景视频或动画原型。例如,生成“中世纪村庄的日常”作为游戏场景参考。

- 商业宣传

- 企业可生成产品宣传视频。例如,输入“智能手表在户外运动场景中的使用”,生成展示功能的短视频。

- 艺术创作

- 艺术家可将静态画作转为动态视频。例如,将抽象画转为流动的动画效果。

QA

- Wan2.2 支持哪些分辨率?

- T2V-A14B 和 I2V-A14B 支持 480P 和 720P;TI2V-5B 支持 720P(1280704 或 7041280)。

- 低显存设备如何运行?

- 使用 TI2V-5B 模型(24GB 显存),启用

--offload_model True、--convert_model_dtype和--t5_cpu降低显存需求。

- 使用 TI2V-5B 模型(24GB 显存),启用

- 如何提升视频质量?

- 使用详细提示词,启用提示扩展,选择 FP16 模型(比 FP8 质量更高)。

- 是否支持商业用途?

- 是的,Wan2.2 采用 Apache 2.0 许可,可用于商业项目,但需遵守相关法律。

- 与 Wan2.1 相比,Wan2.2 有何改进?

- 引入 MoE 架构,训练数据增加 65.6% 的图像和 83.2% 的视频,支持更复杂的运动和电影级美学效果。