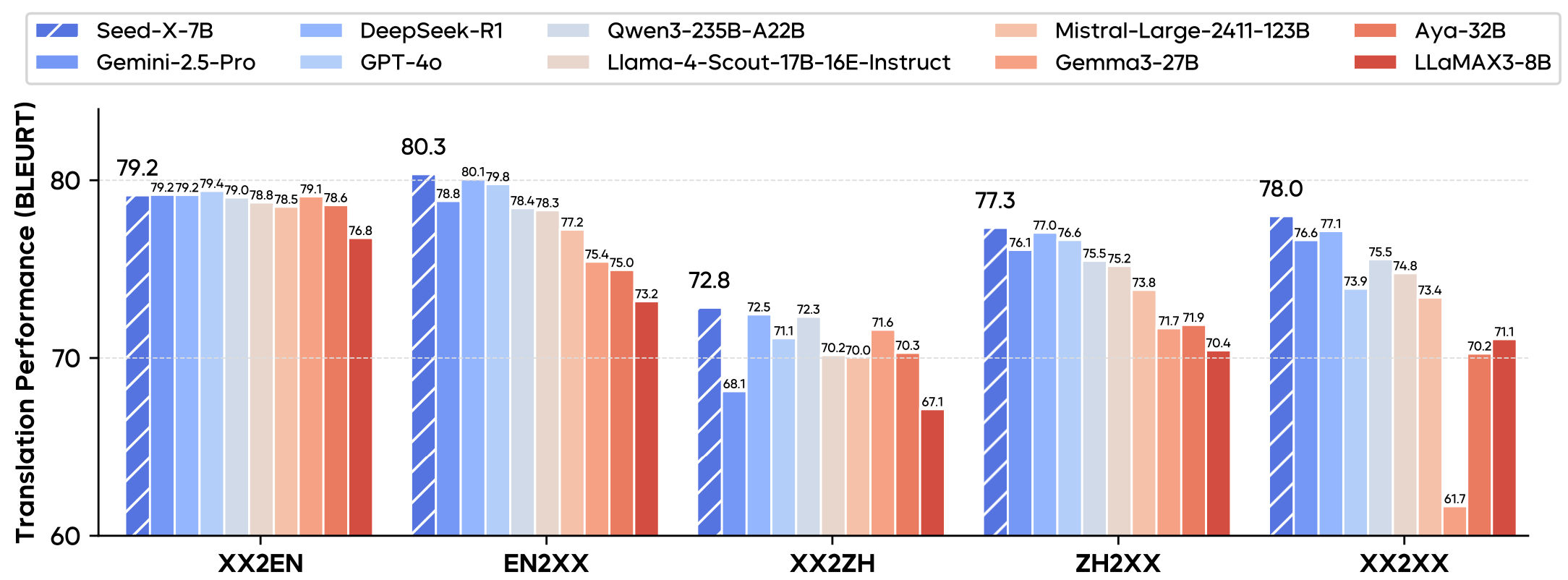

O Seed-X-7B é um modelo de idioma grande de tradução multilíngue de código aberto desenvolvido pela equipe do Seed na ByteDance, com foco no fornecimento de funções de tradução eficientes e precisas. Ele se baseia no parâmetro 7B do Mistral O Seed-X-7B foi projetado para oferecer suporte à tradução em 28 idiomas, abrangendo uma ampla gama de campos, como Internet, tecnologia, comércio eletrônico e biomedicina. O modelo é otimizado por pré-treinamento, ajuste fino de comando e aprendizagem por reforço, e a qualidade da tradução é comparável a modelos de grande escala, como Gemini-2.5 e GPT-4o. O Seed-X-7B é fácil de implantar e adequado tanto para cenários de pesquisa quanto para aplicações do mundo real. Os usuários podem obter os pesos e o código do modelo por meio do Hugging Face ou do GitHub e usá-los gratuitamente em tarefas de tradução.

Lista de funções

- Oferece suporte à tradução de textos em 28 idiomas, abrangendo idiomas de recursos altos e baixos.

- Fornece um modelo de instrução (Seed-X-Instruct) e um modelo de otimização de aprendizado por reforço (Seed-X-PPO), sendo que o último apresenta melhor desempenho de tradução.

- Oferece suporte ao Chain-of-Thought (raciocínio em cadeia) para melhorar a precisão de tarefas de tradução complexas.

- Usando a arquitetura Mistral com escala de parâmetros 7B, a inferência é eficiente e adequada para a implantação de vários dispositivos.

- Pesos e códigos de modelos de código aberto para apoiar o desenvolvimento e a pesquisa secundários da comunidade.

- Oferece suporte a diversos cenários de tradução, incluindo Internet, tecnologia, direito, literatura e outros campos.

- Fornece métodos de decodificação Beam Search e Sampling para otimizar a qualidade de saída da tradução.

Usando a Ajuda

Processo de instalação

Para usar o modelo Seed-X-7B, os usuários precisam primeiro instalar o ambiente e as dependências necessárias. Abaixo estão as etapas detalhadas de instalação e uso, com base nas instruções do repositório oficial do GitHub:

- armazém de clones

Clone o código do projeto Seed-X-7B usando o Git:git clone https://github.com/ByteDance-Seed/Seed-X-7B.git cd Seed-X-7B - Criação de um ambiente virtual

Crie um ambiente Python 3.10 com o Conda e ative-o:conda create -n seedx python=3.10 -y conda activate seedx - Instalação de dependências

Instale as bibliotecas Python necessárias para seu projeto:pip install -r requirements.txtSe você precisar acelerar o raciocínio, instale o Flash Attention:

pip install flash_attn==2.5.9.post1 --no-build-isolation - Download dos pesos do modelo

Faça o download dos pesos do modelo Seed-X-7B da Hugging Face. O modelo Seed-X-PPO-7B é recomendado para um melhor desempenho de tradução:from huggingface_hub import snapshot_download save_dir = "ckpts/" repo_id = "ByteDance-Seed/Seed-X-PPO-7B" cache_dir = save_dir + "/cache" snapshot_download( cache_dir=cache_dir, local_dir=save_dir, repo_id=repo_id, local_dir_use_symlinks=False, resume_download=True, allow_patterns=["*.json", "*.safetensors", "*.pth", "*.bin", "*.py", "*.md", "*.txt"] ) - Requisitos de hardware

- Inferência de GPU única: 1 H100-80G pode lidar com tarefas de tradução de texto ou vídeo de 720×1280.

- Raciocínio multi-GPU: 4 H100-80Gs suportam tarefas com resolução de 1080p ou 2K, requer configurações

sp_size=4。 - As GPUs de alto desempenho são recomendadas para uma inferência mais rápida.

Uso

O Seed-X-7B oferece dois modelos principais: Seed-X-Instruct-7B e Seed-X-PPO-7B. Veja a seguir um exemplo de como executar uma tarefa de tradução usando o Seed-X-PPO-7B.

Tradução de uma única frase (sem raciocínio encadeado)

fazer uso de vLLM A biblioteca realiza um raciocínio rápido para traduzir frases do inglês para o chinês:

from vllm import LLM, SamplingParams

model_path = "./ByteDance-Seed/Seed-X-PPO-7B"

model = LLM(model=model_path, max_num_seqs=512, tensor_parallel_size=8, enable_prefix_caching=True, gpu_memory_utilization=0.95)

messages = ["Translate the following English sentence into Chinese:\nMay the force be with you <zh>"]

decoding_params = SamplingParams(temperature=0, max_tokens=512, skip_special_tokens=True)

results = model.generate(messages, decoding_params)

responses = [res.outputs[0].text.strip() for res in results]

print(responses) # 输出:['愿原力与你同在']

Tradução com raciocínio encadeado

Para frases complexas, o Chain-of-Thought pode ser ativado para melhorar a precisão da tradução:

messages = ["Translate the following English sentence into Chinese and explain it in detail:\nMay the force be with you <zh>"]

decoding_params = BeamSearchParams(beam_width=4, max_tokens=512)

results = model.generate(messages, decoding_params)

responses = [res.outputs[0].text.strip() for res in results]

print(responses) # 输出翻译结果及推理过程

inferência crítica

Se várias frases precisarem ser traduzidas, isso pode ser feito pelo recurso de raciocínio em lote do vLLM:

messages = [

"Translate the following English sentence into Chinese:\nThe sun sets slowly behind the mountain <zh>",

"Translate the following English sentence into Chinese:\nKnowledge is power <zh>"

]

results = model.generate(messages, decoding_params)

responses = [res.outputs[0].text.strip() for res in results]

print(responses) # 输出:['太阳慢慢地落在山后', '知识就是力量']

Operação da função em destaque

- Suporte a vários idiomas

O Seed-X-7B é compatível com 28 idiomas, incluindo idiomas de alto recurso, como inglês, chinês, espanhol e francês, e alguns idiomas de baixo recurso. Os usuários só precisam especificar o idioma de destino na entrada (por exemplo<zh>(denotando chinês), o modelo pode gerar a tradução correspondente. - Raciocínio encadeado (CoT)

Para frases complexas, a habilitação do raciocínio encadeado permite que o modelo analise a semântica e o contexto da frase passo a passo. Por exemplo, ao traduzir textos literários ou jurídicos, o modelo decompõe a estrutura da frase antes de gerar uma tradução precisa. - Decodificação de busca de feixe

Use o Beam Search (beam_width=4O Beam Search produz traduções de maior qualidade e é adequado para cenários em que é necessária uma saída precisa. Em comparação com a decodificação por amostragem, o Beam Search é mais estável, mas um pouco mais caro do ponto de vista computacional. - Tradução interdisciplinar

O Seed-X-7B é excelente em traduções nas áreas de Internet, tecnologia, comércio eletrônico, biomedicina e direito. Os usuários podem inserir diretamente a terminologia especializada ou longas passagens de texto, e o modelo mantém a precisão terminológica e a coerência contextual.

advertência

- Desempenho da GPUInferência de GPU única pode ser lenta, e é recomendável usar o processamento paralelo de várias GPUs para aumentar a eficiência.

- Seleção de modelos: A prioridade é dada ao uso do Seed-X-PPO-7B, pois ele é otimizado para o aprendizado por reforço e se traduz melhor do que o Seed-X-Instruct-7B.

- Feedback de errosSe encontrar erros de tradução, você pode enviar um problema no repositório do GitHub ou entrar em contato com o endereço de e-mail oficial para fornecer amostras de entradas e saídas para ajudar a melhorar o modelo.

cenário do aplicativo

- empresa multinacional de comércio eletrônico

O Seed-X-7B pode ser usado para traduzir descrições de produtos, avaliações de usuários e diálogos de atendimento ao cliente com suporte para a expansão do mercado multilíngue. Por exemplo, traduza descrições de produtos em inglês para chinês, espanhol, etc., mantendo a precisão terminológica. - pesquisa acadêmica

Os pesquisadores podem usar o modelo para traduzir artigos acadêmicos, materiais de conferências ou documentos técnicos. Por exemplo, a tradução de artigos científicos do inglês para o chinês mantém a precisão da terminologia. - criação de conteúdo

Os criadores de conteúdo podem traduzir artigos, blogs ou conteúdo de mídia social para dar suporte à publicação multilíngue. Por exemplo, traduzir um blog chinês para o inglês para atrair leitores internacionais. - Jurídico e financeiro

Os modelos podem lidar com a tradução de contratos legais ou relatórios financeiros, garantindo que a terminologia seja padronizada. Por exemplo, a tradução de contratos em inglês para o chinês mantém o rigor do idioma jurídico.

QA

- Quais são os idiomas suportados pelo Seed-X-7B?

Suporte a 28 idiomas, incluindo inglês, chinês, espanhol, francês e outros idiomas de alto recurso, bem como alguns idiomas de baixo recurso. Para obter uma lista de idiomas, consulte a documentação oficial. - Como escolher entre os modelos Seed-X-Instruct e Seed-X-PPO?

O Seed-X-PPO é otimizado para a aprendizagem por reforço para melhorar o desempenho da tradução e é recomendado para ambientes de produção. O Seed-X-Instruct é adequado para testes rápidos ou tarefas leves. - O modelo oferece suporte à tradução em tempo real?

O modelo atual é mais adequado para a tradução em lote off-line; a tradução em tempo real precisa otimizar a velocidade de inferência, e é recomendável usar GPUs de alto desempenho. - Como faço para lidar com erros de tradução?

Você pode enviar um problema no GitHub com o texto original e as traduções, ou entrar em contato com o endereço de e-mail oficial para obter feedback.