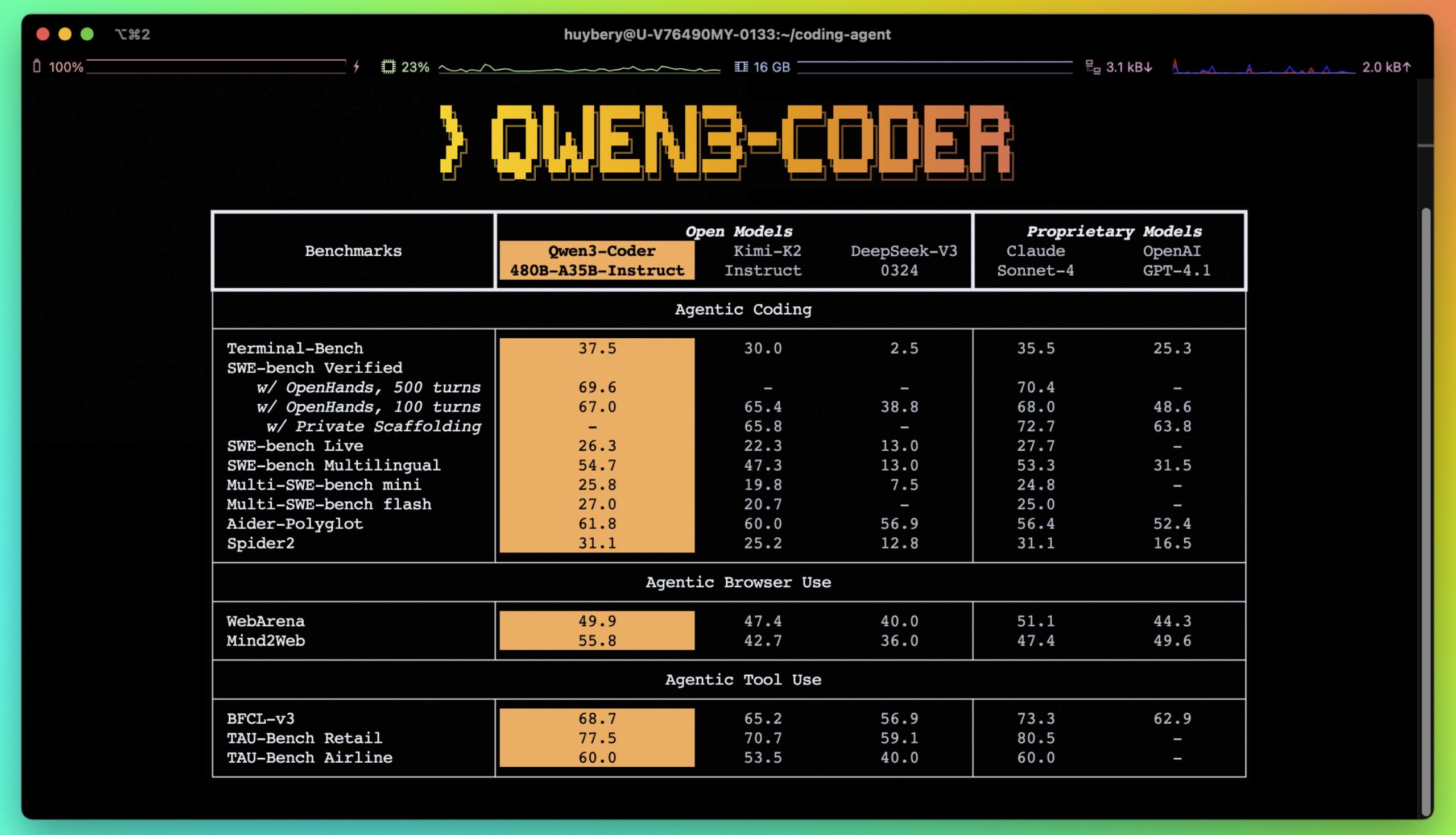

O Qwen3-Coder é uma família de modelagem de linguagem em larga escala de código aberto desenvolvida pela equipe do Alibaba Cloud Qwen, com foco na geração de código e programação inteligente. Seus principais produtos são Qwen3-Coder-480B-A35B-InstructO Qwen3-Coder é um modelo híbrido de especialista (MoE) com 48 bilhões de parâmetros e 3,5 bilhões de parâmetros ativados. Ele suporta um comprimento de contexto nativo de 256 mil tokens e pode ser dimensionado para até 1 milhão de tokens com um método de extensão. O Qwen3-Coder se destaca na geração de código, no reparo de código e em tarefas de agente (por exemplo, manipulação de navegador e uso de ferramentas) com desempenho comparável ao do Claude Sonnet 4. Está disponível por meio da ferramenta de linha de comando de código aberto Qwen Code Oferece suporte aprimorado à codificação para desenvolvedores que trabalham com tarefas de código complexas. Os modelos suportam mais de 100 idiomas e se destacam especialmente na geração de códigos multilíngues e na programação de sistemas. Todos os modelos são de código aberto sob a licença Apache 2.0 e podem ser baixados e personalizados livremente pelos desenvolvedores.

Guia do usuário gratuito do Qwen3-Code: Configurando a API ModelScope e o Qwen CLI

Lista de funções

- geração de códigoGeração de código de alta qualidade com suporte para 92 linguagens de programação, incluindo Python, C++, Java e outras.

- Correções de códigoDetecta e corrige automaticamente erros no código para aumentar a eficiência da programação.

- conclusão do códigoSuporte a patches de preenchimento de trechos de código para otimizar o processo de desenvolvimento.

- Suporte à missão do agenteIntegração de ferramentas externas para executar operações de navegador e lidar com tarefas complexas.

- processamento de contexto longoSuporte nativo para contextos de 256 mil tokens, dimensionável para 1 milhão de tokens, adequado para lidar com grandes bases de código.

- Suporte a vários idiomasCobertura de mais de 100 idiomas e dialetos, adequada para desenvolvimento e tradução multilíngues.

- ferramenta de linha de comando: Fornecido

Qwen CodeOtimizando o suporte a analisadores e ferramentas para simplificar o gerenciamento de código e as tarefas de automação. - modelo de código abertoFornece vários tamanhos de modelo (0,6B a 480B) e oferece suporte à personalização e ao ajuste fino do desenvolvedor.

Usando a Ajuda

Instalação e implementação

O modelo Qwen3-Coder está hospedado no GitHub e pode ser instalado e usado pelos desenvolvedores seguindo estas etapas:

- armazém de clones

Execute o seguinte comando em um terminal para clonar o repositório Qwen3-Coder:git clone https://github.com/QwenLM/Qwen3-Coder.gitIsso fará o download do arquivo de projeto localmente.

- Instalação de dependências

Vá para o diretório do projeto e instale as dependências necessárias do Python:cd Qwen3-Coder pip install -e ./"[gui,rag,code_interpreter,mcp]"Se forem necessárias apenas dependências mínimas, você poderá executar

pip install -e ./。 - Configuração de variáveis de ambiente

O Qwen3-Coder suporta o uso por meio da API DashScope da Alibaba Cloud ou de modelos de implantação nativos.- Usando a API do DashScopeConfiguração de variáveis de ambiente para usar serviços de nuvem:

export OPENAI_API_KEY="your_api_key_here" export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1" export OPENAI_MODEL="qwen3-coder-plus"As chaves de API estão disponíveis na plataforma DashScope da Alibaba Cloud.

- implantação local: Uso

llama.cpp或OllamaModelos de implantação.- Usando OllamaInstale o Ollama (versão 0.6.6 ou superior) e execute-o:

ollama serve ollama run qwen3:8bDefina o comprimento do contexto e os parâmetros de geração:

/set parameter num_ctx 40960 /set parameter num_predict 32768O endereço da API é

http://localhost:11434/v1/。 - Usando llama.cppExecute o seguinte comando para iniciar o serviço:

./llama-server -hf Qwen/Qwen3-8B-GGUF:Q8_0 --jinja --reasoning-format deepseek -ngl 99 -fa -sm row --temp 0.6 --top-k 20 --top-p 0.95 --min-p 0 -c 40960 -n 32768 --no-context-shift --port 8080Isso iniciará um serviço local com um endereço de API de

http://localhost:8080/v1。

- Usando OllamaInstale o Ollama (versão 0.6.6 ou superior) e execute-o:

- Usando a API do DashScopeConfiguração de variáveis de ambiente para usar serviços de nuvem:

- Modelos para download

Os pesos dos modelos podem ser baixados do Hugging Face ou do ModelScope. Exemplo:- Hugging Face:

https://huggingface.co/Qwen/Qwen3-Coder-480B-A35B-Instruct - ModelScope:

https://modelscope.cn/organization/qwen

fazer uso detransformersModelos de carregamento da biblioteca:

from transformers import AutoTokenizer, AutoModelForCausalLM device = "cuda" # 使用 GPU tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct", device_map="auto").eval() - Hugging Face:

Usando o Qwen3-Coder

O Qwen3-Coder oferece uma variedade de funções, e o procedimento de operação detalhado das funções principais é o seguinte:

- geração de código

O Qwen3-Coder gera código de alta qualidade. Por exemplo, gerando algoritmos de classificação rápidos:input_text = "#write a quick sort algorithm" model_inputs = tokenizer([input_text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output)O modelo retorna o código completo de classificação rápida. As linguagens de programação suportadas incluem C, C++, Python, Java, etc., adequadas para uma variedade de cenários de desenvolvimento.

- conclusão do código

O Qwen3-Coder suporta Fill-in-the-Middle. Por exemplo, preencha a função de classificação rápida:input_text = """<|fim_prefix|>def quicksort(arr): if len(arr) <= 1: return arr pivot = arr[len(arr) // 2] <|fim_suffix|> middle = [x for x in arr if x == pivot] right = [x for x in arr if x > pivot] return quicksort(left) + middle + quicksort(right)<|fim_middle|>""" messages = [{"role": "system", "content": "You are a code completion assistant."}, {"role": "user", "content": input_text}] text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True) model_inputs = tokenizer([text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output)O modelo preencherá automaticamente as seções de código ausentes.

- Correções de código

O Qwen3-Coder detecta e corrige erros de código. O usuário pode inserir o código que contém erros e o modelo retornará uma versão corrigida. Por exemplo, no benchmark Aider, o Qwen3-Coder-480B-A35B-Instruct pontua tão bem quanto o GPT-4o para correções de erros complexos. - Usando a ferramenta de código Qwen

Qwen Codeé uma ferramenta de linha de comando otimizada para análise e suporte de ferramentas para o Qwen3-Coder. Execute o seguinte comando:cd your-project/ qwenExemplo de comando:

- Veja a arquitetura do projeto:

qwen > Describe the main pieces of this system's architecture - Função de aprimoramento:

qwen > Refactor this function to improve readability and performance - Gerar documentos:

qwen > Generate comprehensive JSDoc comments for this function

A ferramenta oferece suporte a tarefas automatizadas, como manipulação de commits do git e refatoração de código.

- Veja a arquitetura do projeto:

- Atribuições da agência

O Qwen3-Coder oferece suporte a tarefas de proxy, como ações do navegador ou chamadas de ferramentas. Métodos de configuração:- Defina o provedor de API como

OpenAI Compatible。 - Digite a chave de API do DashScope.

- Defina um URL personalizado:

https://dashscope-intl.aliyuncs.com/compatible-mode/v1。 - Selecione o modelo:

qwen3-coder-plus。

Os modelos podem lidar com tarefas complexas do agente, como a execução automatizada de scripts ou a interação com o navegador.

- Defina o provedor de API como

advertência

- Comprimento do contextoSuporte a 256 mil tokens por padrão, adequado para análise de grandes bases de código. Ele pode ser ampliado para 1 milhão de tokens com o YaRN.

- Requisitos de hardwareModelos menores (por exemplo, Qwen3-8B) são adequados para ambientes com poucos recursos. Modelos menores (por exemplo, Qwen3-8B) são adequados para ambientes com poucos recursos.

- licençaO modelo é de código aberto sob a licença Apache 2.0, que permite o uso e a modificação gratuitos, mas o uso comercial está sujeito a um contrato de licença.

cenário do aplicativo

- desenvolvimento de software

Os desenvolvedores podem usar o Qwen3-Coder para gerar código rapidamente, corrigir bugs ou corrigir funções para projetos que variam de iniciantes a desenvolvedores profissionais. Por exemplo, gerar código de back-end para aplicativos da Web ou otimizar código para sistemas incorporados. - Fluxos de trabalho automatizados

aprovar (um projeto de lei ou inspeção etc.)Qwen CodeUma ferramenta que permite que os desenvolvedores automatizem commits do git, refatoração de código ou geração de documentação para colaboração em equipe e cenários de DevOps. - Projetos multilíngues

O Qwen3-Coder suporta mais de 100 idiomas, o que o torna ideal para o desenvolvimento de aplicativos multilíngues ou para a tradução de códigos, como a conversão de código Python para C++. - Gerenciamento de grandes bases de código

O suporte contextual a tokens de 256K permite que o modelo manipule grandes bases de código, adequadas para analisar e otimizar projetos complexos, como software corporativo ou repositórios de código aberto.

QA

- Quais linguagens de programação são compatíveis com o Qwen3-Coder?

Ele oferece suporte a 92 linguagens de programação, incluindo Python, C, C++, Java, JavaScript etc., atendendo às principais necessidades de desenvolvimento. - Como você lida com grandes bases de código?

O modelo suporta nativamente 256 mil contextos de tokens e pode ser dimensionado para 1 milhão de tokens com o YaRN. O modelo pode ser estendido para 1 milhão de tokens usando oQwen CodeFerramentas para consultar e editar diretamente grandes bases de código. - O Qwen3-Coder é gratuito?

Os modelos são de código aberto sob a licença Apache 2.0 e são gratuitos para download e uso. O uso comercial está sujeito a um contrato de licença. - Como otimizar o desempenho do modelo?

O uso de um dispositivo de GPU, como o CUDA, aumenta a velocidade de inferência. O ajuste de parâmetros comomax_new_tokens和top_pA qualidade da geração pode ser otimizada.