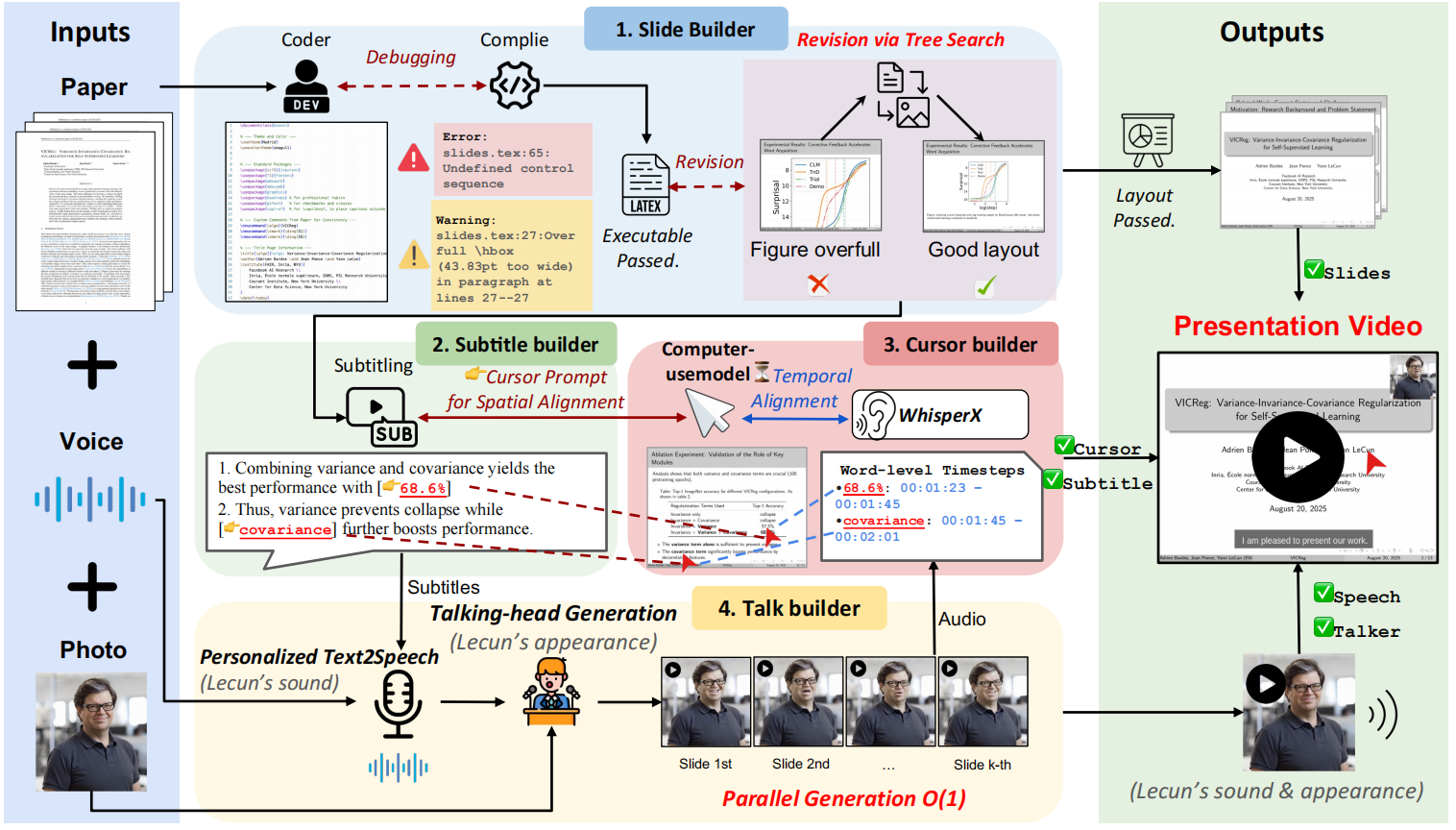

O Paper2Video é um projeto de código-fonte aberto que visa a liberar os pesquisadores do trabalho árduo de preparar vídeos de apresentações acadêmicas. No centro do projeto está uma estrutura de inteligência múltipla chamada PaperTalker, que recebe um documento escrito em LaTeX, uma imagem de referência do orador e um áudio de referência e, em seguida, gera um vídeo completo da apresentação de forma totalmente automática. O PaperTalker automatiza todo o processo, desde a extração do conteúdo, a criação de slides, a geração de legendas, a síntese da fala, o rastreamento do mouse e a renderização do vídeo da palestra humana digital virtual. Para avaliar cientificamente a qualidade do vídeo gerado, o projeto também propõe um benchmark chamado Paper2Video, que contém 101 artigos e vídeos de palestras de autores correspondentes, e projeta várias dimensões de avaliação para medir se o vídeo pode transmitir com precisão as informações do artigo.

Lista de funções

- colaboração de inteligência múltiplaInteligência múltipla: Use várias inteligências, incluindo geradores de slides e geradores de legendas, para dividir o trabalho e concluir tarefas complexas de geração de vídeo.

- Geração automatizada de slidesExtrai o conteúdo principal diretamente do código-fonte do documento LaTeX, gera automaticamente slides para apresentações e otimiza o layout por meio de feedback de compilação.

- síntese de fala e legendasGerar apresentações correspondentes com base no conteúdo dos slides e sintetizar o áudio usando a tecnologia de conversão de texto em fala (TTS), além de gerar legendas com marcas de tempo alinhadas com precisão.

- Simulação da trilha do mouseAnálise do conteúdo da apresentação e dos elementos do slide para gerar automaticamente movimentos do mouse e trajetórias de cliques que imitam os de pessoas reais e são usados para orientar a atenção do público durante a apresentação.

- Geração de pessoas digitais virtuaisCom apenas uma foto frontal do orador, uma pessoa digital virtual (Talking Head) pode ser gerada para falar no vídeo, tornando-o mais expressivo.

- processamento paraleloProcessamento paralelo de tarefas de geração relacionadas a cada página de slide (por exemplo, voz, trilha do mouse etc.) para aumentar consideravelmente a eficiência da geração de vídeo.

- Dois modos de geraçãoModo completo com VMs e modo rápido sem VMs estão disponíveis, e os usuários podem escolher de acordo com suas necessidades.

Usando a Ajuda

O Paper2Video fornece um pipeline automatizado para sintetizar projetos de artigos formatados em LaTeX, imagens de oradores e amostras de áudio em um vídeo de palestra acadêmica completo.

1. preparação ambiental

Antes de começar, você precisa preparar o ambiente para a execução do projeto. Recomenda-se criar um ambiente Python separado usando o Conda para evitar conflitos de versões de pacotes.

Instalação do ambiente primário:

Primeiro, clone o código do projeto e vá para src e, em seguida, crie e ative o ambiente do Conda.

git clone https://github.com/showlab/Paper2Video.git

cd Paper2Video/src

conda create -n p2v python=3.10

conda activate p2v

Em seguida, instale todas as dependências necessárias do Python e o compilador LaTeX tectonic。

pip install -r requirements.txt

conda install -c conda-forge tectonic

Instalação do ambiente virtual Digimon (opcional):

Se não for necessário gerar um vídeo da apresentação do Digitalizador Virtual (ou seja, executar a versão rápida), você pode pular esta etapa. Dependências de funcionalidade do Virtual Digital Man Hallo2 um ambiente separado precisa ser criado para ele.

# 在 Paper2Video 项目根目录下

git clone https://github.com/fudan-generative-vision/hallo2.git

cd hallo2

conda create -n hallo python=3.10

conda activate hallo

pip install -r requirements.txt

Quando a instalação estiver concluída, você precisará anotar o seguinte hallo O caminho para o interpretador Python de seu ambiente, que será usado nas execuções subsequentes. Você pode encontrar o caminho com o seguinte comando:

which python

2. configuração do modelo de linguagem grande (LLM)

A capacidade da Paper2Video de entender e gerar conteúdo se baseia em um modelo de linguagem poderoso e amplo. Você precisa configurar sua chave de API. O projeto recomenda o uso de GPT-4.1 或 Gemini 2.5-Pro para obter melhores resultados.

Exporte sua chave de API como uma variável de ambiente no terminal:

export GEMINI_API_KEY="你的Gemini密钥"

export OPENAI_API_KEY="你的OpenAI密钥"

3. implementação da geração de vídeo

O Paper2Video oferece dois scripts de execução principais:pipeline_light.py para geração rápida (sem homem digital virtual).pipeline.py Usado para gerar uma versão completa de um vídeo que contém uma pessoa digital virtual.

Requisitos mínimos de hardwareGPU NVIDIA A6000 com pelo menos 48 GB de memória de vídeo é recomendada para executar esse processo.

Modo rápido (sem homem digital virtual)

Esse modo pula a etapa demorada de renderização de uma pessoa digital virtual e gera rapidamente um vídeo de apresentação de slides com narração, legendas e trilha do mouse.

Execute o seguinte comando:

python pipeline_light.py \

--model_name_t gpt-4.1 \

--model_name_v gpt-4.1 \

--result_dir /path/to/output \

--paper_latex_root /path/to/latex_proj \

--ref_img /path/to/ref_img.png \

--ref_audio /path/to/ref_audio.wav \

--gpu_list [0,1,2,3,4,5,6,7]

Modo completo (com pessoa digital virtual)

Esse modo executa todas as etapas para gerar um vídeo completo com a tela do alto-falante.

Execute o seguinte comando:

python pipeline.py \

--model_name_t gpt-4.1 \

--model_name_v gpt-4.1 \

--model_name_talking hallo2 \

--result_dir /path/to/output \

--paper_latex_root /path/to/latex_proj \

--ref_img /path/to/ref_img.png \

--ref_audio /path/to/ref_audio.wav \

--talking_head_env /path/to/hallo2_env \

--gpu_list [0,1,2,3,4,5,6,7]

Descrição do parâmetro

model_name_t: o nome do modelo de linguagem grande usado para processar tarefas de texto, por exemplogpt-4.1。result_dirSalvar diretório para resultados de saída, incluindo slides gerados, vídeos, etc.paper_latex_rootO diretório raiz do seu projeto de tese LaTeX.ref_imgFoto de referência do orador, que deve ser uma foto de retrato quadrado.ref_audioÁudio de referência do alto-falante para clonagem de tons, recomenda-se uma amostra de cerca de 10 segundos.talking_head_env(Necessário apenas para o modo completo) Instalado anteriormentehallopara o interpretador Python de seu ambiente.gpu_listGPU: uma lista de dispositivos de GPU usados para computação paralela.

No final da execução, você pode especificar o result_dir para encontrar todos os arquivos intermediários e o vídeo final gerado.

cenário do aplicativo

- Relatórios de conferências acadêmicas

Os pesquisadores podem usar o Paper2Video para transformar rapidamente seus artigos em apresentações de vídeo para compartilhamento em conferências on-line ou para apresentação em conferências. Isso economiza muito tempo na criação manual de slides e na gravação de vídeos. - Divulgação dos resultados da pesquisa

Criar vídeos fáceis de entender sobre o conteúdo complexo de uma dissertação e publicá-los em mídias sociais ou plataformas de vídeo pode ajudar os resultados da pesquisa a atingir um público mais amplo e aumentar o impacto acadêmico. - Materiais educacionais e curriculares

Professores e acadêmicos podem transformar artigos acadêmicos clássicos ou atualizados em vídeos instrucionais que podem ser usados como materiais de curso para ajudar os alunos a entender a ciência de ponta de forma mais intuitiva. - Pré-apresentação e ensaio do trabalho

Antes de defender formalmente ou fazer um relatório off-line, os autores podem usar a ferramenta para gerar um vídeo de visualização para verificar o fluxo lógico, o controle de tempo e os recursos visuais do relatório para otimização e iteração.

QA

- Qual é o principal problema que esse projeto aborda?

Esse projeto se concentra em resolver o problema da produção de vídeos de palestras acadêmicas, que consome muito tempo e exige muita mão de obra. Tradicionalmente, os pesquisadores gastam muito tempo projetando slides, escrevendo palestras, gravando e editando. O paper2Video tem como objetivo liberar os pesquisadores dessa tarefa tediosa, automatizando-a. - Que arquivos de entrada preciso preparar para gerar um vídeo?

Você precisará preparar três coisas: um projeto de papel completo escrito no formato LaTeX, uma fotografia frontal quadrada do palestrante e uma gravação de referência de cerca de 10 segundos do palestrante. - Não sei muito sobre os requisitos de hardware, meu computador normal pode executá-lo?

Os requisitos de hardware para esse projeto são muito altos, especialmente a GPU. A recomendação oficial é usar pelo menos uma GPU NVIDIA A6000 com 48 GB de memória de vídeo. Um PC ou laptop comum provavelmente não conseguirá executar todo o processo de geração, especialmente a parte que contém a renderização da pessoa digital virtual. - Posso usar essa ferramenta se não quiser mostrar meu rosto no vídeo?

Pode. O projeto fornecepipeline_light.pyele executará um modo rápido que gera um vídeo contendo todos os elementos principais (slides, narrações, legendas, trilhas de mouse), mas não conterá a tela da pessoa digital virtual. Esse modo também requer recursos computacionais relativamente baixos.