O DeepInfra é uma plataforma em nuvem que fornece serviços de chamada de modelos de IA para desenvolvedores. Ela permite que os usuários acessem e executem uma variedade de modelos de IA de código aberto convencionais, incluindo Meta Llama 3, Mistral AI e Google Gemma, por meio de uma interface de API simples. O recurso mais importante dessa plataforma é o "Serverless", o que significa que os usuários não precisam implantar e manter um hardware de servidor complexo e podem pagar diretamente pela quantidade de uso, reduzindo bastante o limite de desenvolvimento, operação e manutenção de aplicativos de IA. O DeepInfra Chat é uma página de demonstração intuitiva fornecida pela plataforma, na qual os usuários podem conversar diretamente com os vários modelos de linguagem de grande porte implantados na plataforma e sentir o desempenho e as características de diferentes modelos. Ele também mostra aos desenvolvedores os resultados reais de seus serviços de API, permitindo que eles testem e avaliem rapidamente os modelos para integração em seus próprios aplicativos.

Lista de funções

- Suporte a vários modelos:: A plataforma oferece uma grande variedade de modelos de idiomas grandes e de código aberto para os usuários escolherem, como Llama, Mistral, Gemma e outras famílias de modelos.

- Interface de bate-papo on-lineFornece uma janela limpa de bate-papo na Web que permite aos usuários interagir diretamente com modelos de IA selecionados para teste sem registro ou configuração.

- Serviço de chamada de APIA função principal é fornecer aos desenvolvedores uma interface de API estável e dimensionável para integrar facilmente os recursos dos modelos de IA em seus próprios softwares ou serviços.

- pagar conforme necessárioAdotando um modelo de faturamento por uso (geralmente por contagem de tokens), os usuários pagam apenas pelos recursos de computação realmente consumidos, o que é econômico.

- Pronto para uso em ambientes de produçãoO ML Ops fornece uma infraestrutura dimensionável, de baixa latência e de nível de produção, na qual os desenvolvedores não precisam lidar com as complexidades das operações de aprendizado de máquina (ML Ops).

- Integração de ferramentas de desenvolvedorSuporte à integração com as principais estruturas de desenvolvimento de IA, como LangChain e LlamaIndex, simplificando o processo de criação de aplicativos complexos de IA.

Usando a Ajuda

O DeepInfra Chat é destinado a dois tipos de usuários: usuários em geral que desejam experimentar e analisar rapidamente diferentes modelos de linguagem grandes; e desenvolvedores que precisam integrar recursos de modelos de IA em seus produtos. Como usar cada um deles será descrito a seguir.

1. função de bate-papo baseada na Web (experiência rápida)

Para aqueles que desejam experimentar diretamente os recursos de diálogo do modelo de IA, ele é muito simples de usar:

- Acesso ao siteAbra o site da Web no navegador

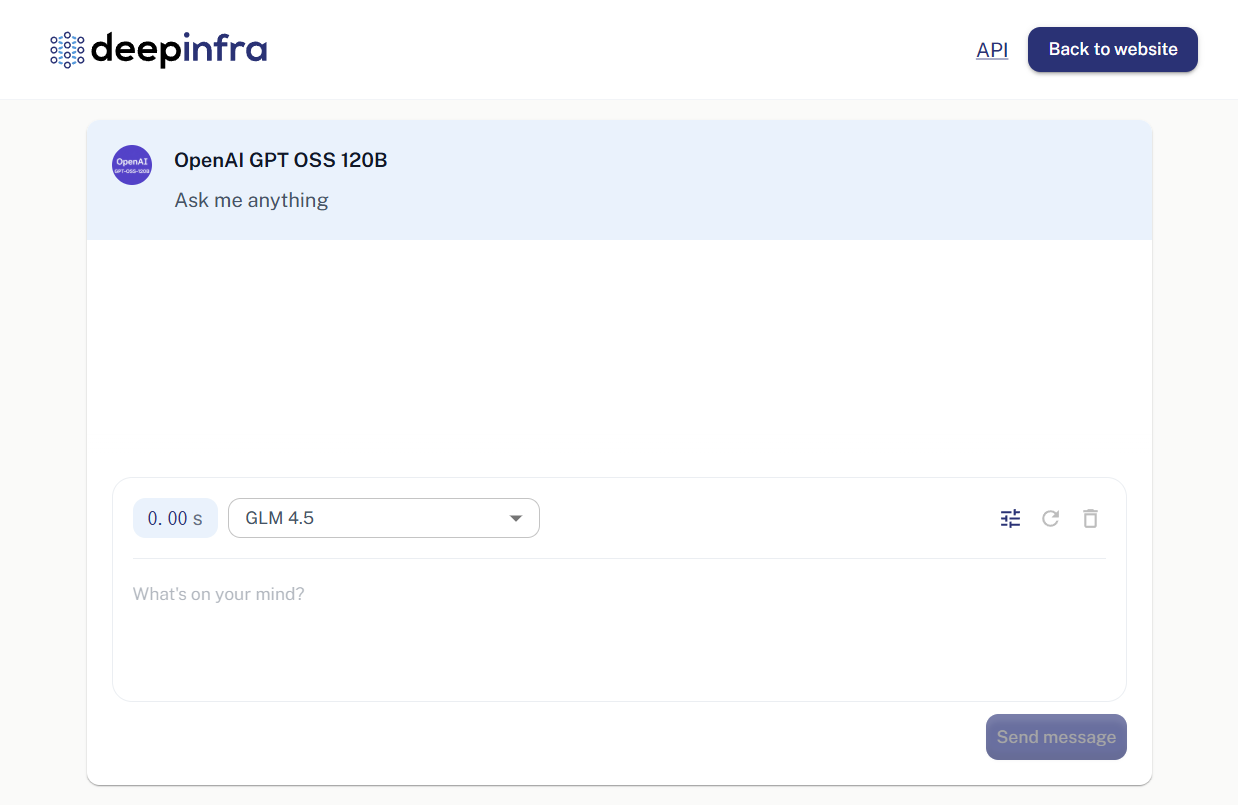

https://deepinfra.com/chat。 - Selecione o modeloInterface de bate-papo: Quando a página for carregada, você verá uma interface de bate-papo. Na parte superior da interface, geralmente é exibido o nome do modelo que está sendo usado no momento (por exemplo, "OpenAI GPT OSS 120B"). Você pode clicar no nome do modelo para alternar entre outros modelos de seu interesse, como o Llama 3 ou a série Mistral, selecionando-os na lista suspensa.

- Iniciando um diálogoNa caixa de entrada na parte inferior da página, digite as perguntas que deseja fazer ou as coisas que deseja dizer e, em seguida, pressione Enter ou clique no botão Enviar.

- Ver respostaRespostas: As respostas do modelo de IA são exibidas diretamente na janela de bate-papo. Você pode continuar a fazer perguntas e participar de várias rodadas de diálogo para testar as habilidades lógicas, linguísticas e intelectuais do modelo.

Esse processo não requer login ou qualquer configuração e é perfeito para revisar modelos rapidamente.

2. serviço de chamada de API (usado por desenvolvedores)

O principal valor do DeepInfra para os desenvolvedores são seus poderosos serviços de API. Você pode integrar os recursos desses modelos de IA em seu site, aplicativo ou serviço de back-end por meio da API.

Etapa 1: Crie uma conta e obtenha uma chave de API

- Registro/Login: Visite o site da DeepInfra

https://deepinfra.com/normalmente você pode fazer login diretamente usando sua conta do GitHub. - Gerar chave de APIApós fazer login, acesse o Dashboard da sua conta e localize a página de gerenciamento de chaves de API (geralmente o caminho para a pasta

https://deepinfra.com/dash/api_keys)。 - Criação de uma nova chaveClique no botão "New API Key" (Nova chave de API), dê um nome à sua chave (por exemplo, "MyTestApp") e clique em Generate (Gerar).

- Salvar a chaveO sistema gera uma string que começa com

di-no início, que é sua chave de API.Por favor, copie-o imediatamente e mantenha-o em segurançaPor questões de segurança, essa chave completa aparecerá apenas uma vez.

Etapa 2: Chamar a API

Os endpoints da API do DeepInfra são compatíveis com o formato da OpenAI, o que facilita a migração e o uso. Seu endpoint principal da API de bate-papo é:

https://api.deepinfra.com/v1/openai/chat/completions

Você pode chamá-lo usando qualquer ferramenta ou linguagem de programação que ofereça suporte a solicitações HTTP.

fazer uso de curl Um exemplo simples do comando:

Abra seu terminal e substitua o {YOUR_API_KEY} substituindo-a pela chave que você acabou de gerar.{MODEL_ID} Substitua-o pela ID do modelo que você deseja chamar (por exemplo meta-llama/Meta-Llama-3-8B-Instruct)。

curl -X POST https://api.deepinfra.com/v1/openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer {YOUR_API_KEY}" \

-d '{

"model": "{MODEL_ID}",

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

]

}'

Exemplo de uso do Python:

Você precisa instalar o requests Biblioteca ( pip install requests )。

import requests

import json

# 替换成你的API密钥

api_key = "{YOUR_API_KEY}"

# 替换成你想使用的模型ID

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

url = "https://api.deepinfra.com/v1/openai/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": model_id,

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

],

"stream": False # 如果需要流式输出,可以设置为True

}

response = requests.post(url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

result = response.json()

# 打印出模型返回的内容

print(result['choices'][0]['message']['content'])

else:

print(f"请求失败,状态码: {response.status_code}")

print(response.text)

Você pode encontrar a documentação oficial do DeepInfra para todos os produtos suportadosLista de identificação do modelo。

cenário do aplicativo

- Desenvolvimento de chatbot de IA

Crie bots de atendimento ao cliente, assistentes inteligentes ou bots de perguntas e respostas de domínio específico para sites, aplicativos ou sistemas internos. Os desenvolvedores têm a flexibilidade de escolher modelos diferentes com base nos requisitos de custo e desempenho. - Assistência na criação de conteúdo

Use os recursos de geração de texto do modelo para ajudar a escrever textos de marketing, postagens de blog, códigos, e-mails ou para retoques de texto. - Educação e pesquisa

Pesquisadores e estudantes podem usar a plataforma para chamar e testar facilmente uma ampla gama de modelos de IA de ponta e de código aberto sem incorrer em altos custos de implementação de hardware. - Verificação rápida do protótipo

Os gerentes e desenvolvedores de produtos podem usar o DeepInfra para criar rapidamente um protótipo com funcionalidade de IA nos estágios iniciais do desenvolvimento do produto para validação funcional e demonstração de resultados.

QA

- O DeepInfra Chat é gratuito?

A versão web da experiência de bate-papo é gratuita, mas tem certas limitações de uso e é usada principalmente para demonstrações de recursos e análises de modelos. Se a chamada for feita por meio da API, você precisará pagar de acordo com o modelo selecionado e o número de tokens solicitados, e a plataforma fornecerá uma determinada quantidade de recursos de computação de avaliação gratuita. - Quais modelos de IA posso usar?

O DeepInfra oferece suporte a uma ampla variedade de modelos de linguagem grande de código aberto, incluindo, entre outros, a série Llama da Meta (por exemplo, Llama 3), os modelos da Mistral AI, o Gemma do Google e o CodeLlama e outros modelos que se concentram na geração de código. A lista específica de modelos compatíveis pode ser visualizada em seu site oficial. - Quem são os principais usuários dessa plataforma?

Destina-se a desenvolvedores de aplicativos de IA, pesquisadores de tecnologia e empresas que buscam integrar recursos de IA em seus negócios atuais. Além disso, seu recurso de bate-papo na Web é adequado para qualquer usuário comum que esteja interessado em tecnologia de IA e queira experimentar diferentes recursos de modelo. - Preciso configurar meu próprio servidor para usar a API?

O DeepInfra é uma plataforma "sem servidor" que hospeda, executa e dimensiona de forma elástica todos os modelos. Os desenvolvedores só precisam iniciar solicitações por meio de chaves de API e não precisam se preocupar com o hardware e as operações subjacentes.