Lemon AI 是一个全栈开源的 AI 智能体框架,提供完全本地的运行环境,无需依赖云端服务。它支持本地大语言模型(LLM)如 DeepSeek、Qwen、Llama 等,通过 Ollama 运行,确保数据隐私和安全。Lemon AI 集成了虚拟机沙箱,保障代码执行的安全性,适合需要本地化 AI 解决方案的个人和企业。用户可以轻松部署在个人电脑或企业服务器上,操作简单且兼容多种环境。它支持深度研究、网页浏览、代码生成和数据分析等功能,架构灵活,可根据需求定制。Lemon AI 提供一键部署,降低技术门槛,同时支持通过 API 连接云端模型如 Claude、GPT、Gemini 和 Grok,兼顾本地与云端的灵活性。

功能列表

- 本地运行 AI 智能体:支持 DeepSeek、Qwen、Llama 等本地大语言模型,数据处理全程本地化。

- 虚拟机沙箱:提供安全的代码执行环境,保护用户设备免受潜在风险。

- 代码生成与解释:生成高质量代码,支持 16K 输出长度,优化代码格式和语法。

- 深度研究与网页浏览:支持复杂任务的规划、执行和反思,适合研究和数据收集。

- 数据分析:处理和分析数据,生成可视化结果,满足多种分析场景。

- API 集成:支持连接云端模型(如 Claude、GPT),扩展功能。

- 一键部署:提供 Docker 容器和简化的安装流程,兼容个人电脑和企业服务器。

- 灵活定制:架构支持用户根据需求修改和扩展,适配不同业务场景。

使用帮助

安装流程

Lemon AI 提供多种部署方式,包括开源代码、Docker 容器、客户端应用和在线订阅。以下以 Docker 部署为例,介绍详细的安装和使用流程,适合初学者和专业用户。

- 安装 Docker

确保你的设备已安装 Docker。如果未安装,可访问 Docker 官网 下载并安装。Windows 用户需启用 WSL(Windows Subsystem for Linux)以运行 Docker 命令。 - 获取 Lemon AI 代码

访问 Lemon AI 的 GitHub 仓库https://github.com/hexdocom/lemonai。点击绿色按钮“Code”,选择“Download ZIP”下载源代码,或使用 Git 克隆仓库:git clone https://github.com/hexdocom/lemonai.git

解压文件或进入克隆的目录。

- 运行 Docker 容器

打开 WSL 终端(Windows 用户)或常规终端(Linux/Mac 用户),进入 Lemon AI 项目目录。运行以下命令启动 Docker 容器:docker-compose up -d此命令会自动拉取所需镜像并启动 Lemon AI 服务。确保 Docker Compose 已安装。

- 配置本地模型

Lemon AI 默认使用 Ollama 运行本地大语言模型。安装 Ollama(参考 Ollama 官网),然后拉取支持的模型,例如:ollama pull deepseek在 Lemon AI 的设置页面,配置模型路径,确保指向本地模型。

- 验证安装

启动后,访问本地地址(通常为http://localhost:3000)查看 Lemon AI 的界面。界面会显示模型状态和可用功能。如果模型未加载,检查 Ollama 是否运行正常。

功能操作流程

1. 代码生成与解释

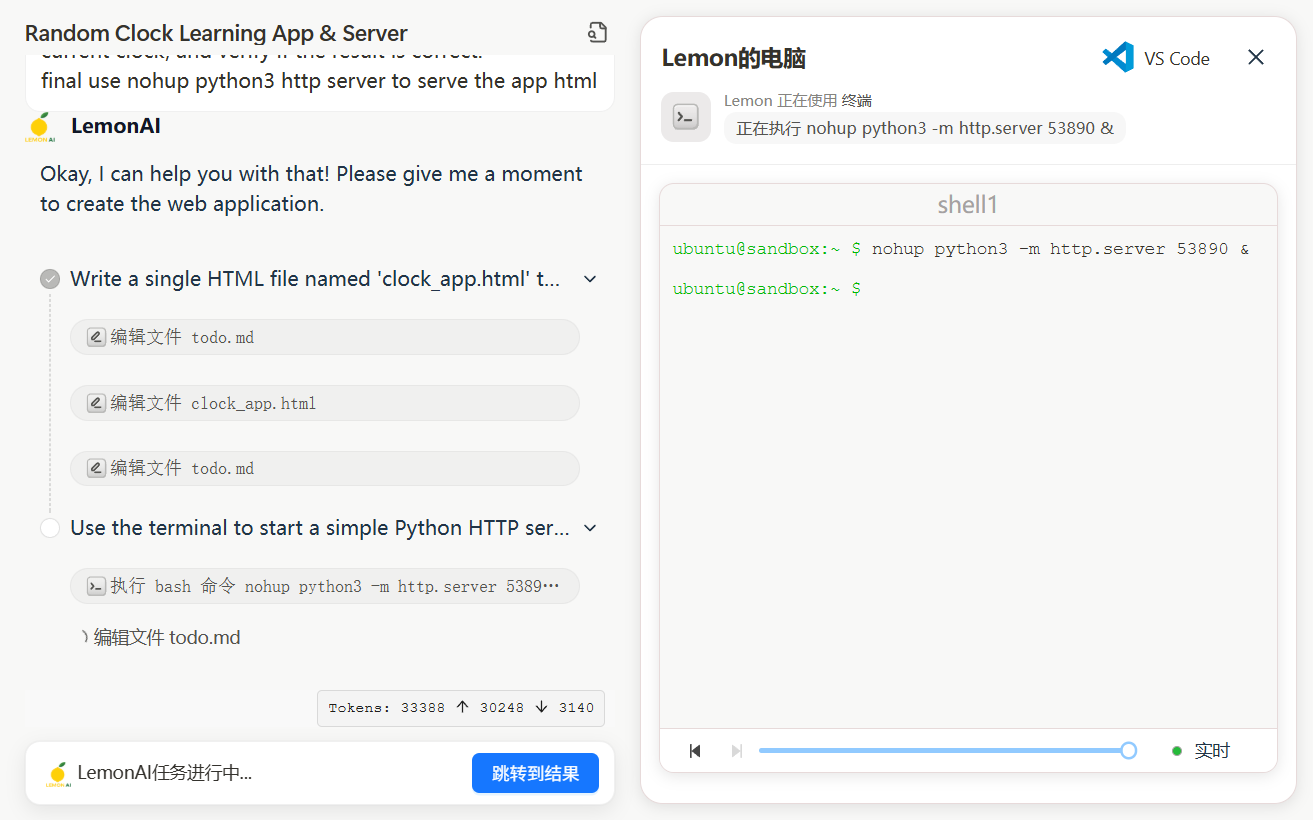

Lemon AI 的代码生成功能支持生成和优化代码,适合开发者快速构建脚本或解决编程问题。在主界面选择“代码生成”模块,输入任务需求,例如“编写一个 Python 脚本爬取网页数据”。系统会调用本地模型(如 DeepSeek-V3)生成代码,并显示在结果区域。生成的代码支持最大 16K 字符长度,格式规范,减少语法错误。用户可直接复制代码或在虚拟机沙箱中运行测试。沙箱环境隔离代码执行,防止影响本地设备。例如,运行以下命令测试代码:

python script.py

如果需要调整代码,点击“编辑”按钮,修改后重新运行。

2. 深度研究与网页浏览

Lemon AI 提供“ReAct 模式”支持复杂任务的规划和执行。进入“研究”模块,输入任务,如“分析某行业的市场趋势”。系统会分解任务,自动搜索相关网页并提取信息。用户可查看搜索结果、数据摘要和分析报告。研究过程完全本地化,保护数据隐私。用户可通过设置调整搜索深度或指定数据来源。

3. 数据分析

在“数据分析”模块,上传 CSV 文件或输入数据,Lemon AI 会生成统计图表和分析结果。例如,上传销售数据后,系统可生成柱状图或折线图,直观展示趋势。支持的分析包括均值、分布和相关性计算。用户可导出分析结果为 PDF 或图片格式。

4. API 集成

若需使用云端模型,进入“设置 – 模型服务”页面,添加 API 密钥(如 Claude 或 GPT)。Lemon AI 会验证密钥有效性,确保连接稳定。配置后,用户可切换本地和云端模型,灵活处理任务。

5. 自定义扩展

Lemon AI 的开源架构允许用户修改代码或添加功能。开发者可编辑 src 目录中的文件,添加自定义工具或模块。修改后,重新构建 Docker 容器:

docker-compose build

参考官方文档(https://github.com/hexdocom/lemonai/blob/main/docs)获取更多开发指南。

注意事项

- 隐私保护:所有任务默认在本地运行,数据不上传云端。如需报告安全问题,发送邮件至

service@hexdo.com而非 GitHub 公开提交。 - 系统要求:建议至少 8GB 内存和 4 核 CPU 以确保流畅运行。

- 更新:定期检查 GitHub 仓库的 Releases 页面(

https://github.com/hexdocom/lemonai/releases)获取最新版本和修复。

应用场景

- 个人研究

研究人员使用 Lemon AI 进行文献整理或市场分析。本地模型处理敏感数据,生成结构化报告,保护隐私。 - 开发者工具

开发者利用代码生成功能快速编写脚本,沙箱环境测试代码,确保安全性和稳定性。 - 企业数据分析

企业部署 Lemon AI 在本地服务器,分析销售或运营数据,生成可视化图表,支持决策。 - 教育支持

学生使用 Lemon AI 辅助学习,生成代码示例或整理学习资料,运行在本地上保护个人信息。

QA

- Lemon AI 是否需要联网?

Lemon AI 支持完全离线运行,使用本地模型和沙箱环境。若需云端模型或搜索功能,则需联网配置 API。 - 如何确保代码执行安全?

Lemon AI 的虚拟机沙箱隔离代码运行环境,防止代码影响主机系统。所有执行都在沙箱内完成,保护设备安全。 - 支持哪些本地模型?

支持 DeepSeek、Qwen、Llama、Gemma 等,通过 Ollama 运行。用户可根据需求选择模型。 - 如何更新 Lemon AI?

访问 GitHub 仓库的 Releases 页面,下载最新版本并重新运行 Docker 容器。文档提供详细更新步骤。