Core 是由 RedPlanetHQ 开发的一个开源工具,旨在为大模型(LLM)提供个性化的记忆存储功能。用户可以通过 Core 构建和管理自己的记忆图谱,将文本、对话或其他数据保存到私有的知识库中。这个工具支持将用户与大模型的交互记录存储下来,形成结构化的记忆节点,方便后续查询或连接到其他工具。Core 的设计理念是简单易用,适合开发者和普通用户。它通过直观的仪表板操作,支持本地部署和云服务,满足不同用户的需求。项目目前处于活跃开发阶段,特别针对大模型的记忆优化持续改进。

功能列表

- 记忆存储:将用户输入的文本或对话保存到私有的知识图谱。

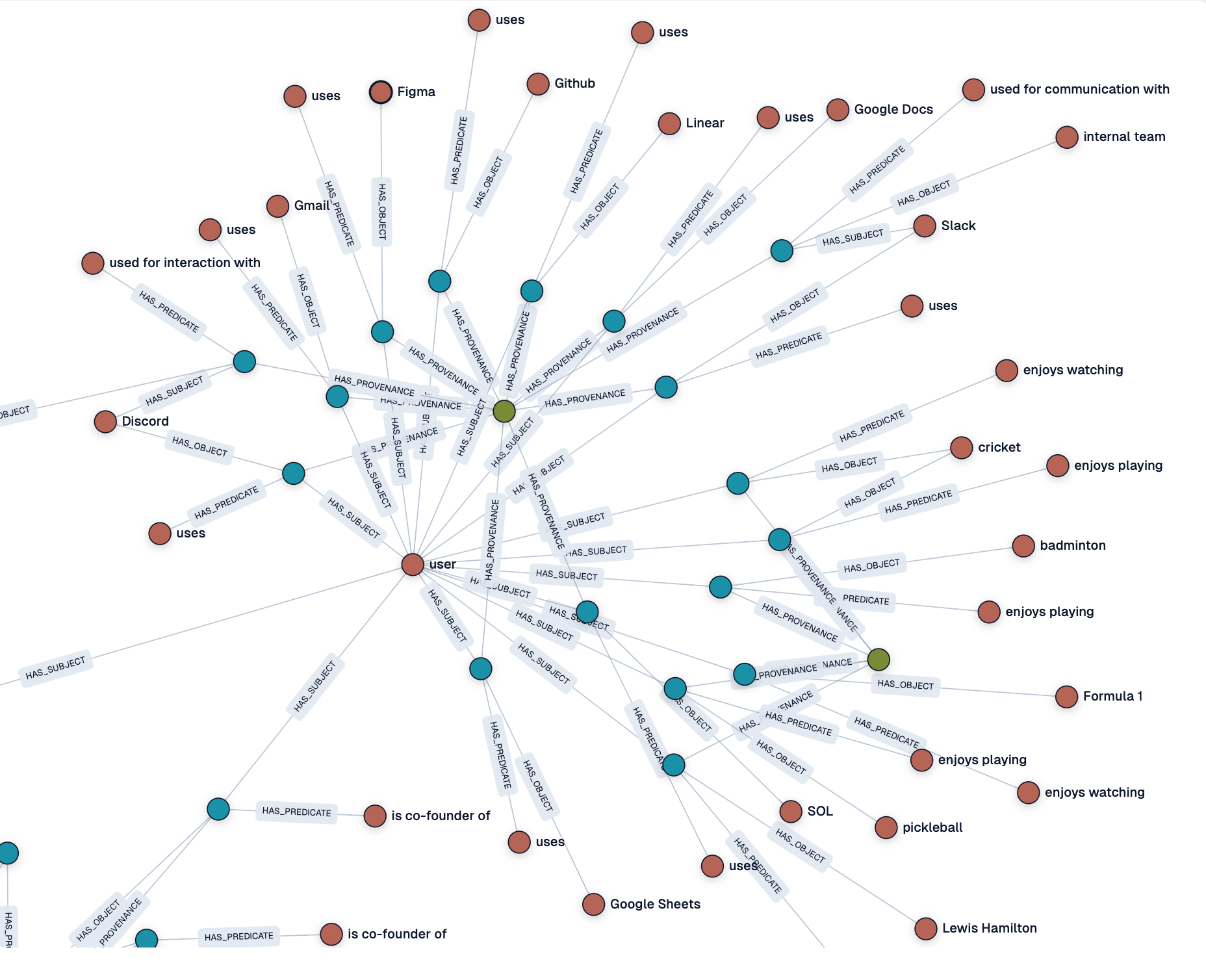

- 知识图谱生成:自动将输入内容转化为结构化的记忆节点,方便检索。

- 仪表板管理:提供可视化界面,查看和管理记忆图谱的节点和状态。

- 支持本地和云端部署:用户可以选择在本地运行或使用 Core Cloud 服务。

- 与大模型集成:支持与多种大模型对接,存储交互记录。

- 日志监控:实时查看记忆处理的日志,了解数据处理状态。

- 开源项目:用户可以自由获取代码,参与开发或定制功能。

使用帮助

安装流程

要使用 Core,首先需要安装并配置环境。以下是详细的安装和使用步骤:

- 克隆仓库:

- 打开终端,运行以下命令克隆 Core 仓库:

git clone https://github.com/RedPlanetHQ/core.git - 进入项目目录:

cd core

- 打开终端,运行以下命令克隆 Core 仓库:

- 安装依赖:

- Core 使用 Node.js 环境,建议安装最新版本的 Node.js(推荐 16.x 或更高)。

- 安装依赖包:

npm install

- 配置环境变量:

- 在项目根目录创建一个

.env文件,添加以下内容:API_TOKEN=YOUR_API_TOKEN_HERE API_BASE_URL=https://core.heysol.ai SOURCE=cursor API_TOKEN需要从 Core Cloud 官网(https://core.heysol.ai)注册账号后获取。

- 在项目根目录创建一个

- 运行本地服务:

- 启动 Core 的内存控制面板(MCP):

npx -y @redplanethq/core-mcp - 服务启动后,打开浏览器,访问

http://localhost:3000。

- 启动 Core 的内存控制面板(MCP):

- 使用 Core Cloud(可选):

- 如果选择云服务,访问 https://core.heysol.ai,注册并登录账号。

- 在云端仪表板中直接管理记忆,无需本地部署。

主要功能操作

1. 添加记忆

- 操作步骤:

- 登录仪表板(本地或云端)。

- 在右上角的输入框中,输入想保存的文本,例如“我喜欢打羽毛球”。

- 点击“+Add”按钮,文本将被发送到处理队列。

- 在“Logs”页面查看处理状态,完成后,记忆节点会显示在仪表板中。

- 功能说明:

- 每次添加的文本会自动生成一个记忆节点,节点包含文本内容和元数据(如时间戳)。

- 这些节点可以连接形成知识图谱,方便后续查询或分析。

2. 查看和管理记忆

- 操作步骤:

- 打开仪表板的“Graph”页面,查看所有记忆节点。

- 点击某个节点,可以查看详细内容或编辑。

- 支持搜索功能,输入关键词快速定位相关记忆。

- 功能说明:

- 仪表板提供可视化的知识图谱,节点之间的关系一目了然。

- 用户可以手动调整节点连接,或删除不需要的记忆。

3. 与大模型集成

- 操作步骤:

- 在设置页面,添加规则以自动保存大模型对话:

- 打开“Settings” -> “User rules” -> “New Rule”。

- 添加规则,确保每次对话后,用户的查询和模型的响应存储到 Core 记忆中。

- 设置

sessionId为对话的唯一标识符(UUID)。

- 示例规则配置:

{ "mcpServers": { "memory": { "command": "npx", "args": ["-y", "@redplanethq/core-mcp"], "env": { "API_TOKEN": "YOUR_API_TOKEN_HERE", "API_BASE_URL": "https://core.heysol.ai", "SOURCE": "cursor" } } } }

- 在设置页面,添加规则以自动保存大模型对话:

- 功能说明:

- Core 自动捕获用户与大模型的交互,存储为结构化数据。

- 支持多种大模型,但目前对 Llama 模型的支持还在优化中,未来会有更好的兼容性。

4. 日志监控

- 操作步骤:

- 打开仪表板的“Logs”页面。

- 查看实时的处理日志,包括记忆添加、处理状态和错误信息。

- 功能说明:

- 日志功能帮助用户监控数据处理流程,确保数据存储的可靠性。

- 如果处理失败,日志会提供错误详情,方便排查问题。

注意事项

- 本地部署:确保网络稳定,端口 3000 未被占用。

- 云服务:需要稳定的 API 密钥,定期检查密钥有效性。

- Llama 模型支持:目前 Core 对 Llama 模型的兼容性有限,建议使用其他主流模型以获得最佳效果。

- 社区支持:Core 是开源项目,遇到问题可以在 GitHub 提交 issue 或加入社区讨论。

应用场景

- 个人知识管理

- 用户可以用 Core 保存日常学习笔记、灵感或重要对话,形成个人知识库。例如,学生可以将课堂笔记保存为记忆节点,方便复习。

- 开发者调试大模型

- 开发者可以记录与大模型的交互,分析模型输出,优化提示词(prompt)设计。例如,调试一个聊天机器人时,Core 可以保存所有测试对话。

- 团队协作

- 团队成员可以通过 Core Cloud 共享记忆图谱,协作构建项目知识库。例如,产品团队可以将用户反馈存入 Core,生成需求分析图谱。

- 研究辅助

- 研究人员可以将文献摘要或实验数据保存到 Core,形成结构化的研究记忆,方便后续分析和引用。

QA

- Core 支持哪些大模型?

- Core 目前支持多种主流大模型,但对 Llama 模型的兼容性还在优化中。建议使用其他模型以获得最佳效果。

- 本地部署和云服务的区别是什么?

- 本地部署需要手动配置环境,适合需要隐私的场景;云服务无需安装,开箱即用,适合快速上手。

- 如何确保记忆数据的安全性?

- 本地部署的记忆数据存储在用户设备上,安全性由用户控制;云服务使用加密传输,API 密钥确保数据访问安全。

- Core 是否完全免费?

- Core 是开源项目,本地部署免费;云服务可能涉及订阅费用,具体需查看官网定价。