以小博大:如何通过模型蒸馏让 0.6B 模型实现 235B 模型的效果

大语言模型(LLM)虽然表现出色,但其高昂的计算成本和较慢的推理速度是实际应用中的主要障碍。一个有效的解决方案是模型蒸馏(Model Distillation):首先利用一个强大的“教师模型”(大参数模型)生成高质量的标注数据,然后用这些数据来“教导”一个更小、更经济的“学生模型”(小参数模型)。通过这种方式,小模型能在特定任务上达到接近大模型的性能。

本文将以从文本中提取物流信息(收件人、地址、电话)为例,详细演示如何通过模型蒸馏技术,让一个 0.6B 参数的 Qwen3-0.6B 模型,在信息提取任务上的准确率从 14% 提升到 98%,媲美大模型的效果。

优化前后的效果对比非常直观:

方案核心流程

整个过程分为三个关键步骤:

- 数据准备:使用一个 235B 的大模型作为教师模型,处理一批虚拟地址描述,生成结构化的 JSON 数据作为高质量的训练集。在实际业务中,应使用真实场景数据以达到最佳效果。

- 模型微调:利用上一步生成的数据,对

Qwen3-0.6B模型进行微调。此过程将使用ms-swift框架,它能将复杂的微调操作简化为单行命令。 - 效果验证:在独立的测试集上评估微调前后的模型表现,以量化性能提升,确保模型在生产环境中的稳定性和准确性。

一、准备计算环境

大模型微调需要配备 GPU 的计算环境,并正确安装 GPU 驱动、CUDA 和 cuDNN。手动配置这些依赖不仅繁琐且易出错。为了简化部署,推荐在创建 GPU 云服务器实例时,选择预装了 GPU 驱动的镜像,从而快速启动微调任务。

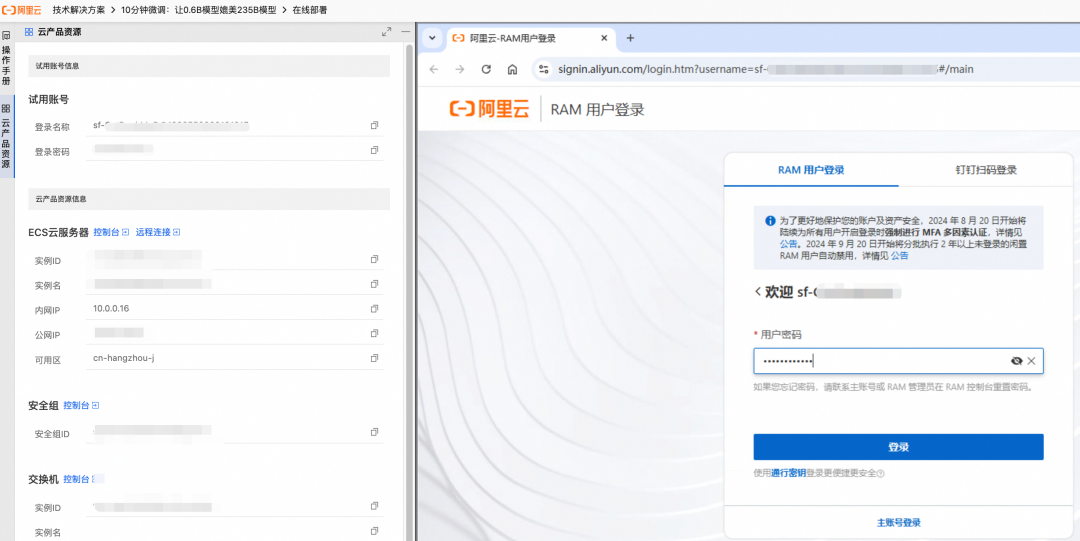

本方案可以通过免费试用资源来体验。试用期创建的资源和数据在结束后会被清除。如果需要长期使用,可以参考官方文档中的手动创建指引。

- 根据页面引导创建资源,右侧会实时展示创建进度。

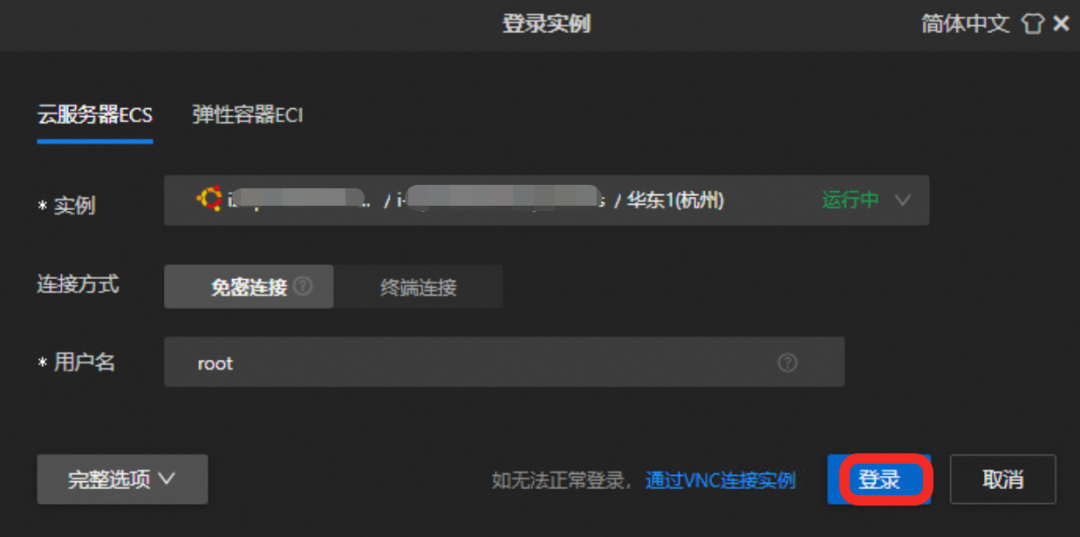

- 创建完成后,通过远程连接功能登录到

GPU云服务器。

点击“远程连接”按钮并使用提供的凭据登录。

二、下载并微调模型

通过魔搭社区(ModelScope)提供的 ms-swift 框架,可以将复杂的模型微调流程大幅简化。

1. 安装依赖

本方案依赖两个核心组件:

ms-swift: 一个由魔搭社区提供的高性能训练框架,集成了模型下载、微调和权重合并等功能。vllm: 一个用于部署和推理服务的框架,支持高性能推理,方便验证模型效果并生成API供业务调用。

在终端运行以下命令来安装依赖(约需5分钟):

pip3 install vllm==0.9.0.1 ms-swift==3.5.0

2. 执行模型微调

运行以下脚本,即可自动完成模型下载、数据准备、模型微调和权重合并的全过程。

# 进入 /root 目录

cd /root && \

# 下载微调脚本 sft.sh

curl -f -o sft.sh "https://help-static-aliyun-doc.aliyuncs.com/file-manage-files/zh-CN/20250623/cggwpz/sft.sh" && \

# 执行微调脚本

bash sft.sh

微调过程大约需要10分钟。sft.sh 脚本中的核心命令如下:

swift sft \

--model Qwen/Qwen3-0.6B \

--train_type lora \

--dataset 'train.jsonl' \

--torch_dtype bfloat16 \

--num_train_epochs 10 \

--per_device_train_batch_size 20 \

--per_device_eval_batch_size 20 \

--learning_rate 1e-4 \

--lora_rank 8 \

--lora_alpha 32 \

--target_modules all-linear \

--gradient_accumulation_steps 16 \

--save_steps 1 \

--save_total_limit 2 \

--logging_steps 2 \

--max_length 2048 \

--output_dir output \

--warmup_ratio 0.05 \

--dataloader_num_workers 4

这里对部分关键参数进行说明:

--train_type lora: 指定使用 LoRA(Low-Rank Adaptation)方式进行微调。这是一种参数高效的微调方法,相比全量微调,它仅训练少量新增的权重,极大地降低了计算资源需求。--lora_rank: LoRA 矩阵的秩。秩越大,模型拟合复杂任务的能力越强,但过大可能导致过拟合。--lora_alpha: LoRA 的缩放因子,与learning_rate类似,用于调整权重更新的幅度。--num_train_epochs: 训练轮次。决定了模型学习数据的深度。

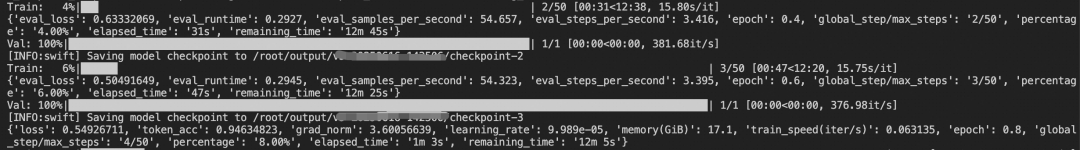

训练过程中,终端会实时打印模型在训练集和验证集上的损失(loss)变化。

当看到以下输出时,表明模型微调和权重合并已成功完成:

✓ swift export 命令执行成功

检查合并结果...

✓ 合并目录创建成功: output/v0-xxx-xxx/checkpoint-50-merged

✓ LoRA权重合并完成!

合并后的模型路径: output/v0-xxx-xxx/checkpoint-50-merged

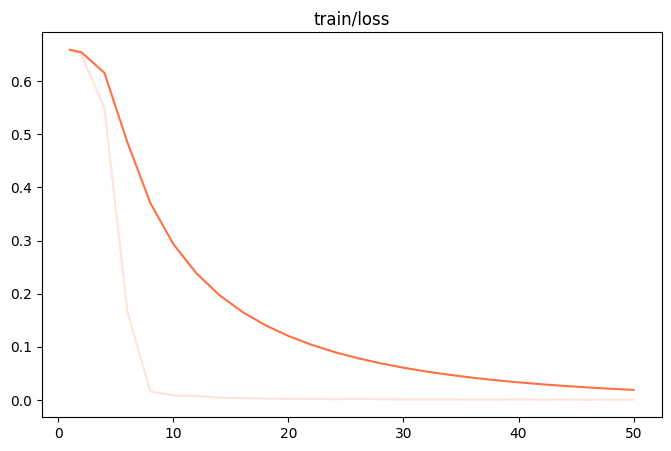

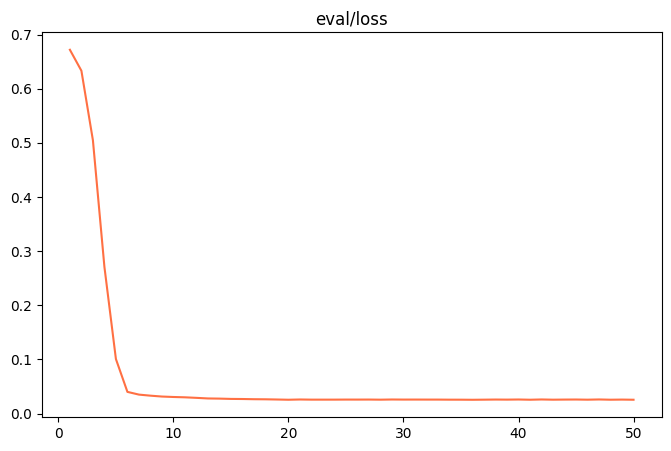

微调完成后,可以在 output/v0-xxx-xxx/images 目录下找到 train_loss.png 和 eval_loss.png 两个图表,它们直观地反映了模型的训练状态。

| train_loss (训练集损失) | eval_loss (验证集损失) |

|---|---|

|

|

- 欠拟合:若

train_loss和eval_loss在训练结束时仍有明显下降趋势,可以尝试增加num_train_epochs或lora_rank。 - 过拟合:若

train_loss持续下降,但eval_loss反而开始上升,说明模型过度学习了训练数据,应减少num_train_epochs或lora_rank。 - 良好拟合:当两条曲线都趋于平稳,说明模型训练达到了一个理想状态。

三、验证模型效果

在部署到生产环境前,系统性地评测是必不可少的环节。

1. 准备测试数据

测试数据应与训练数据格式一致,且必须是全新的、模型未见过的数据,以评估其泛化能力。

cd /root && \

# 下载测试数据 test.jsonl

curl -o test.jsonl "https://help-static-aliyun-doc.aliyuncs.com/file-manage-files/zh-CN/20250610/mhxmdw/test_with_system.jsonl"

测试数据样本示例如下:

{"messages": [{"role": "system", "content": "..."}, {"role": "user", "content": "电话:23204753945:大理市大理市人民路25号 大理古城国际酒店 3号楼:收件者:段丽娟"}, {"role": "assistant", "content": "{\"province\": \"云南省\", \"city\": \"大理市\", ...}"}]}

{"messages": [{"role": "system", "content": "..."}, {"role": "user", "content": "天津市河西区珠江道21号金泰大厦3层 , 接收人慕容修远 , MOBILE:22323185576"}, {"role": "assistant", "content": "{\"province\": \"天津市\", \"city\": \"天津市\", ...}"}]}

2. 设计评测指标

评测标准需紧贴业务目标。在本例中,不仅要判断输出是否为合法的 JSON,还要逐一比对 JSON 中每个键值对(Key-Value)是否完全正确。

3. 评测初始模型效果

首先,在未经微调的 Qwen3-0.6B 模型上进行测试。即使经过精心设计的详细提示词(Prompt),其在 400 个测试样本上的准确率也仅有 14%。

所有预测完成! 结果已保存到 predicted_labels_without_sft.jsonl

样本数: 400 条

响应正确: 56 条

响应错误: 344 条

评估脚本运行完成

4. 验证微调后模型效果

接下来,使用相同的测试集评测微调后的模型。一个显著的变化是,现在可以用一个非常简洁的提示词来获得优异的性能,因为任务的特定知识已经被“烘焙”到模型参数中,不再需要复杂的指令。

简洁版提示词:

你是一个专业的信息抽取助手,专门负责从中文文本中提取收件人的JSON信息,包含的Key有province(省份)、city(城市名称)、district(区县名称)、specific_location(街道、门牌号、小区、楼栋等详细信息)、name(收件人姓名)、phone(联系电话)

执行评测脚本后,结果显示微调后的模型准确率达到了 98%,实现了质的飞跃。

所有预测完成! 结果已保存到 predicted_labels.jsonl

样本数: 400 条

响应正确: 392 条

响应错误: 8 条

评估脚本运行完成

这个结果证明,模型蒸馏和 LoRA 微调是一种极具性价比的方案,它让小型模型在特定领域的应用成为可能,为AI技术的规模化落地扫清了成本和效率障碍。