TaskingAI是一个开源平台,专注于帮助开发者构建AI原生应用。它通过提供直观的界面、强大的API和灵活的模块化设计,简化了大语言模型(LLM)的开发流程。平台支持多种主流模型,如OpenAI、Anthropic等,并允许集成本地模型。TaskingAI强调异步高性能、插件扩展和多租户支持,适合从初学者到专业开发者使用。用户可以通过Docker快速部署社区版,或使用云服务进行开发。平台还提供Python客户端SDK,方便开发者管理和调用AI功能。TaskingAI致力于让AI应用开发更简单高效,社区活跃,鼓励用户参与贡献。

功能列表

- 支持多种大语言模型(LLM),包括OpenAI、Claude、Mistral等,并可集成本地模型如Ollama。

- 提供丰富的插件,如Google搜索、网站内容读取、股票数据获取等,支持用户自定义工具。

- 内置RAG(检索增强生成)系统,方便处理和管理外部数据。

- 支持异步处理,基于FastAPI实现高性能并发计算。

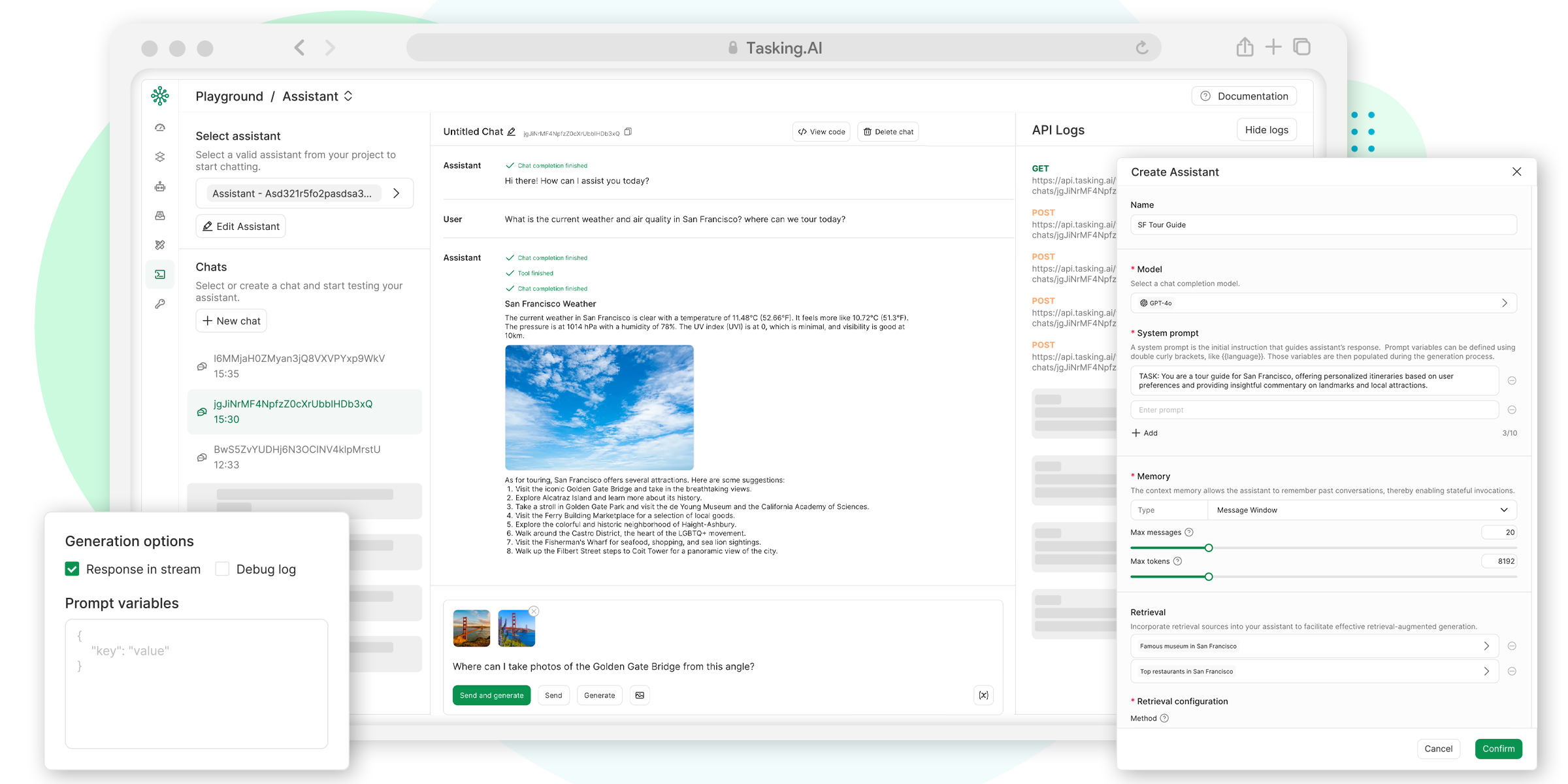

- 提供直观的UI控制台,简化项目管理和测试工作流。

- 支持多租户应用开发,适合快速部署和扩展。

- 提供统一的API接口,方便管理模型、工具和数据。

- 支持OpenAI兼容的聊天完成API,简化任务创建和调用。

使用帮助

TaskingAI是一个功能强大的平台,适合开发者快速构建AI原生应用。以下是详细的安装和使用指南,帮助用户快速上手。

安装流程

TaskingAI社区版可以通过Docker快速部署,适合本地开发或测试。以下是具体步骤:

- 确保环境准备

- 安装Docker和Docker Compose。

- 确保系统支持Python 3.8或以上版本。

- 可选:创建Python虚拟环境以隔离依赖。

- 下载TaskingAI社区版

- 访问GitHub仓库:https://github.com/TaskingAI/TaskingAI。

- 克隆仓库到本地:

git clone https://github.com/TaskingAI/TaskingAI.git - 进入项目目录:

cd TaskingAI

- 配置环境变量

- 在项目根目录下创建

.env文件,设置API密钥和其他配置。例如:TASKINGAI_API_KEY=your_api_key TASKINGAI_HOST=http://localhost:8080 - API密钥可从TaskingAI控制台获取(云版本需注册账号)。

- 在项目根目录下创建

- 启动服务

- 使用Docker Compose启动TaskingAI服务:

cd docker docker-compose -p taskingai pull docker-compose -p taskingai --env-file .env up -d - 服务启动后,访问

http://localhost:8080查看控制台。

- 使用Docker Compose启动TaskingAI服务:

- 安装Python客户端SDK

- 使用pip安装TaskingAI Python客户端:

pip install taskingai - 初始化SDK:

import taskingai taskingai.init(api_key="YOUR_API_KEY", host="http://localhost:8080")

- 使用pip安装TaskingAI Python客户端:

主要功能操作

TaskingAI的核心功能包括模型集成、插件使用、RAG系统和API调用。以下是具体操作指南:

- 模型集成

TaskingAI支持多种大语言模型。用户可以在控制台选择模型(如Claude、Mistral)或通过API指定模型ID。例如:from openai import OpenAI client = OpenAI( api_key="YOUR_TASKINGAI_API_KEY", base_url="https://oapi.tasking.ai/v1", ) response = client.chat.completions.create( model="YOUR_MODEL_ID", messages=[{"role": "user", "content": "你好,今天天气如何?"}] ) print(response)

- 在控制台中,用户可以直接测试模型的对话效果,调整参数如温度或最大输出长度。

- 插件使用

TaskingAI提供多种内置插件,如Google搜索、网站内容读取等。用户也可以开发自定义插件。操作步骤:- 在控制台的“插件”页面选择或添加插件。

- 通过API调用插件功能。例如,调用Google搜索插件:

import taskingai result = taskingai.plugin.google_search(query="最新AI技术") print(result) - 自定义插件需遵循TaskingAI的工具开发文档,上传代码并绑定到AI代理。

- RAG系统操作

RAG(检索增强生成)系统用于处理外部数据。用户可以创建数据集合并检索内容:- 创建集合:

coll = taskingai.retrieval.create_collection( embedding_model_id="YOUR_EMBEDDING_MODEL_ID", capacity=1000 ) print(f"集合ID: {coll.collection_id}") - 添加记录:

record = taskingai.retrieval.create_record( collection_id=coll.collection_id, type="text", content="人工智能正在改变世界。", text_splitter={"type": "token", "chunk_size": 200, "chunk_overlap": 20} ) print(f"记录ID: {record.record_id}") - 检索记录:

retrieved_record = taskingai.retrieval.get_record( collection_id=coll.collection_id, record_id=record.record_id ) print(f"检索内容: {retrieved_record.content}")

- 创建集合:

- UI控制台使用

- 登录控制台后,进入“项目”页面,创建新项目。

- 在“模型”页面选择或配置大语言模型。

- 在“测试”页面运行工作流,实时查看AI输出。

- 使用“日志”功能监控API调用和性能。

特色功能操作

TaskingAI的特色功能包括异步处理和多租户支持:

- 异步处理:基于FastAPI的异步架构,适合高并发场景。用户无需额外配置,API调用自动支持异步。例如,创建多个AI代理任务时,系统会并行处理请求。

- 多租户支持:适合开发面向多用户的应用。用户可以在控制台为不同租户分配模型和插件,确保数据隔离。配置方法:

- 在控制台的“租户管理”页面添加新租户。

- 为每个租户分配独立的API密钥和模型配置。

注意事项

- 确保API密钥安全,不要泄露。

- Docker部署时,检查端口8080是否被占用。

- 云版本用户需注册账号,访问https://www.tasking.ai获取API密钥。

应用场景

- 开发AI聊天机器人

开发者可以使用TaskingAI快速构建基于大语言模型的聊天机器人,支持多轮对话和外部数据检索,适合客户服务或教育场景。 - 自动化数据分析

通过插件和RAG系统,TaskingAI可从网页或文档中提取数据,结合AI分析,生成报告或洞察,适合市场研究人员。 - 快速原型开发

初创公司或个人开发者可利用TaskingAI的UI控制台和API,快速搭建AI应用原型,验证商业想法。 - 教育和培训

教育机构可以使用TaskingAI创建交互式学习助手,支持学生查询知识点或生成练习题。

QA

- TaskingAI支持哪些模型?

TaskingAI支持OpenAI、Claude、Mistral等多种模型,并可通过Ollama等集成本地模型。 - 如何开始使用TaskingAI?

下载社区版通过Docker部署,或注册云版本获取API密钥。安装Python SDK后即可调用API。 - 是否需要编程经验?

初学者可使用UI控制台操作,开发者可通过API和SDK实现复杂功能。 - TaskingAI社区版和云版本有何不同?

社区版免费,需本地部署;云版本提供托管服务,适合快速开发。