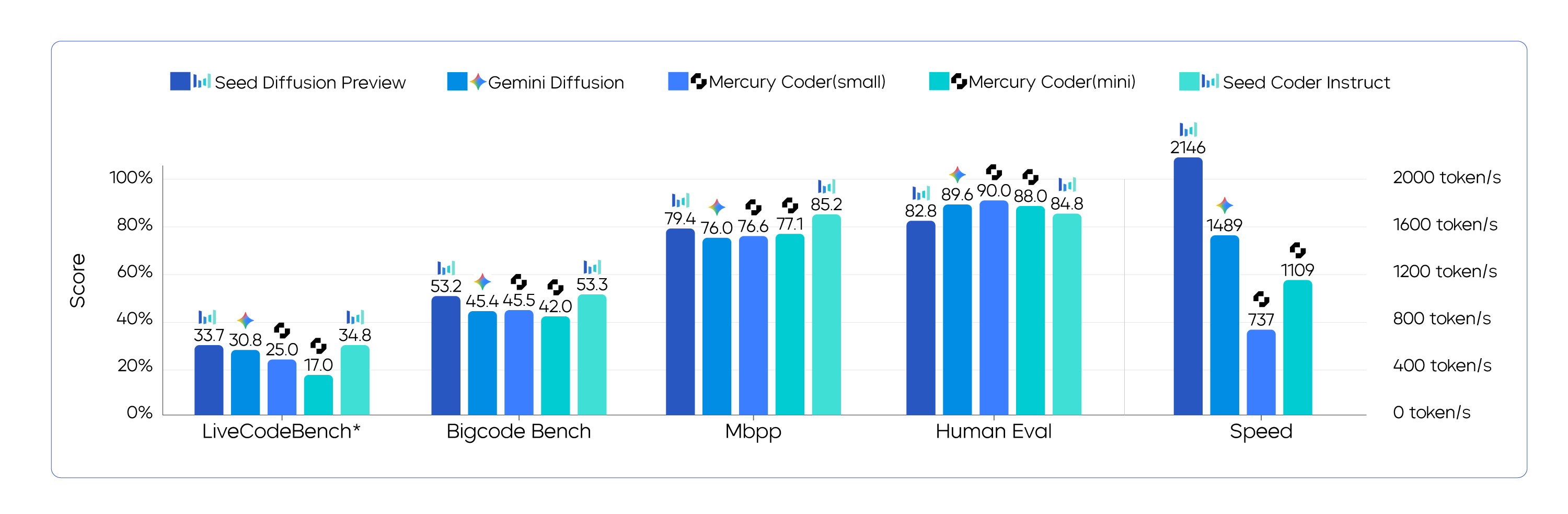

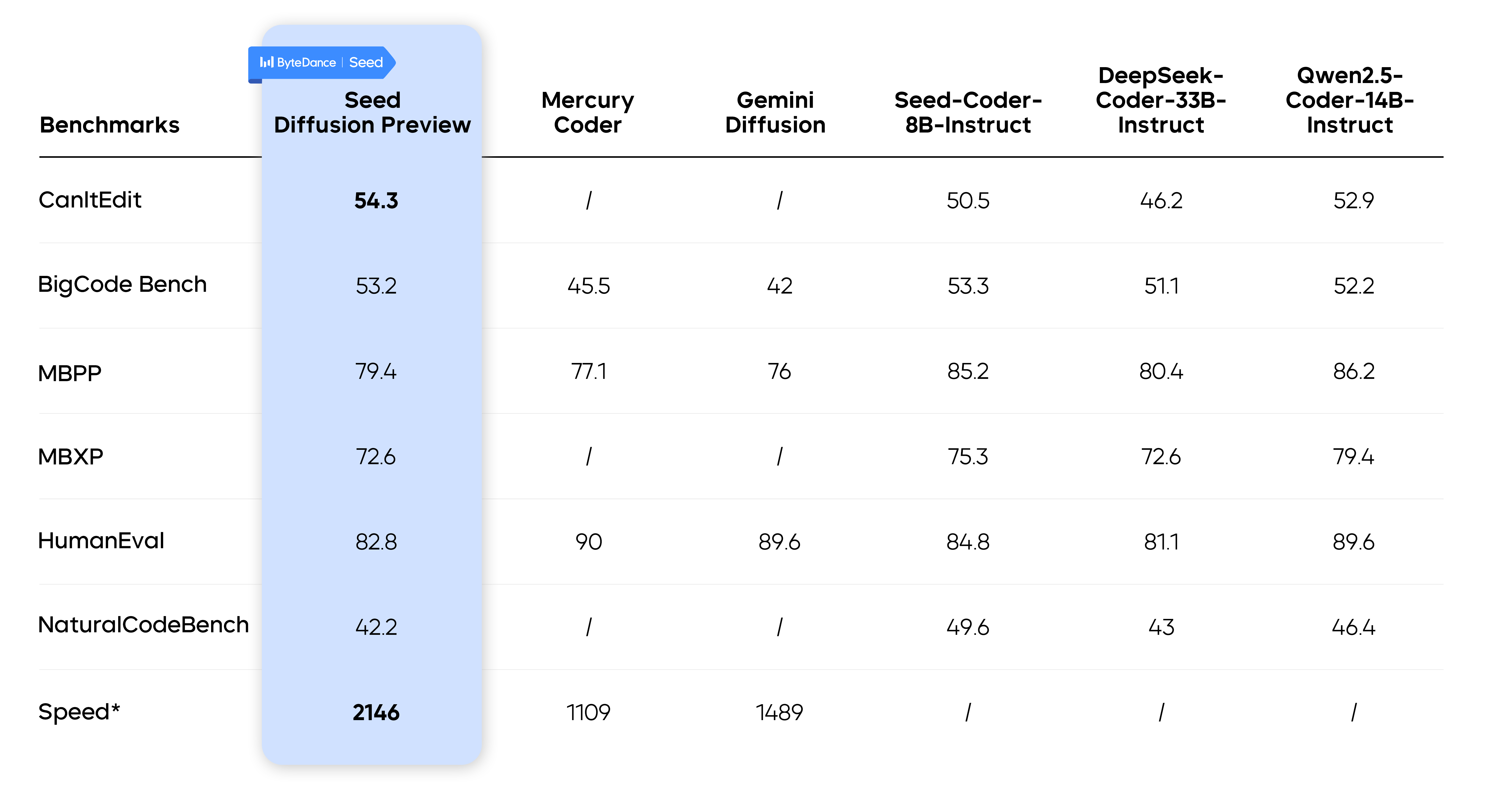

salto de bytes Seed A equipe lançou um novo produto chamado Seed Diffusion Preview O modelo é um modelo de linguagem experimental dedicado à geração de código. O modelo é baseado em técnicas de difusão de estado discreto e atinge uma velocidade de inferência de 2.146 tokens/s, o que é 5,4 vezes mais rápido do que um modelo autorregressivo do mesmo tamanho, mantendo um desempenho comparável em vários benchmarks de código de núcleo.

Esse resultado estabelece uma nova referência para a fronteira de Pareto de qualidade de velocidade para modelagem de código e demonstra o grande potencial dos métodos de difusão discreta no campo da geração de código.

A "manilha de velocidade" da modelagem autorregressiva

A maioria dos principais modelos atuais de geração de código usa arquitetura autorregressiva, prevendo o próximo código um a um token Isso é semelhante à "saída literal" da escrita humana. Esse mecanismo garante a coerência do código, mas também cria um gargalo de velocidade intransponível. Como a geração de cada token depende do token anterior, o processo inteiro não pode ser paralelizado de forma eficiente, resultando em um processamento mais lento de sequências de código longas.

Seed Diffusion A adoção do Modelo de Difusão foi um divisor de águas fundamental. Inicialmente, o modelo de difusão deixou sua marca no campo da geração de imagens, funcionando mais como um processo de pintura de "borrar para clarear". Para a geração de código, é possível começar com uma imagem com ruído (ou "borrada"). [MASK] A primeira etapa é recuperar o código completo e estruturalmente correto em paralelo por meio da "redução de ruído" em várias etapas, começando pelo modelo (tags). Teoricamente, esse recurso de decodificação paralela pode aumentar muito a velocidade de geração.

Seed Diffusion a velocidade da inferência. O benchmarking direto com outros modelos é desafiador devido às diferentes condições de teste. Por exemplo.Mercury Coder foi avaliado em um conjunto de dados proprietário e no hardware H100, e o Gemini Diffusion Os dados de velocidade são obtidos de um benchmark de tarefa mista em um hardware desconhecido.

A metodologia principal por trás do aumento de velocidade

Seed A equipe introduziu várias tecnologias importantes para traduzir as vantagens teóricas da modelagem de difusão em aplicações práticas.

Aprendizagem em dois estágios, do preenchimento de padrões à edição lógica

Há uma desvantagem na maneira tradicional de treinar modelos de difusão: os modelos se concentrarão apenas na faixa [MASK] Posicionar tags e depositar confiança indevida em outro código descoberto para que esteja perfeitamente correto é tecnicamente conhecido como "correlação falsa".

Para superar essa limitação, a equipe projetou uma estratégia de aprendizado em duas etapas:

- Fase 1: Treinamento de difusão baseado em máscara. Nessa fase, o modelo aprende o contexto local e os padrões fixos do código por meio de tarefas padrão de "preenchimento de lacunas".

- Fase 2: Treinamento de difusão baseado em editoriais. Essa fase introduz perturbações baseadas na distância de edição (operações de inserção e exclusão) que forçam o modelo a revisitar e corrigir todos os tokens, inclusive os que foram inicialmente descobertos. Isso melhora significativamente a capacidade do modelo de entender e corrigir a lógica global do código.

Os dados experimentais mostram que, após a introdução do segundo estágio de treinamento, o modelo está na faixa de CanItEdit Benchmarking na pass@1 foram 4,81 TP3T mais altos do que os do modelo autorregressivo (54,3 vs. 50,5).

Difusão sequencial restrita da estrutura do código de fusão a priori

O código, embora seja um dado sequencial, não é gerado estritamente da esquerda para a direita. Ele contém fortes dependências causais, por exemplo, as variáveis devem ser declaradas antes de serem usadas. A geração totalmente desordenada ignora essa estrutura a priori, o que leva a limitações de desempenho.

Para isso, a equipe propõe o "treinamento de ordem restrita". Na fase pós-treinamento, o modelo aprende e segue as dependências corretas do código por meio da autodestilação, respeitando assim a lógica intrínseca do código durante o processo de geração.

Em Aprendizagem Estratégica e Decodificação Paralela Eficiente

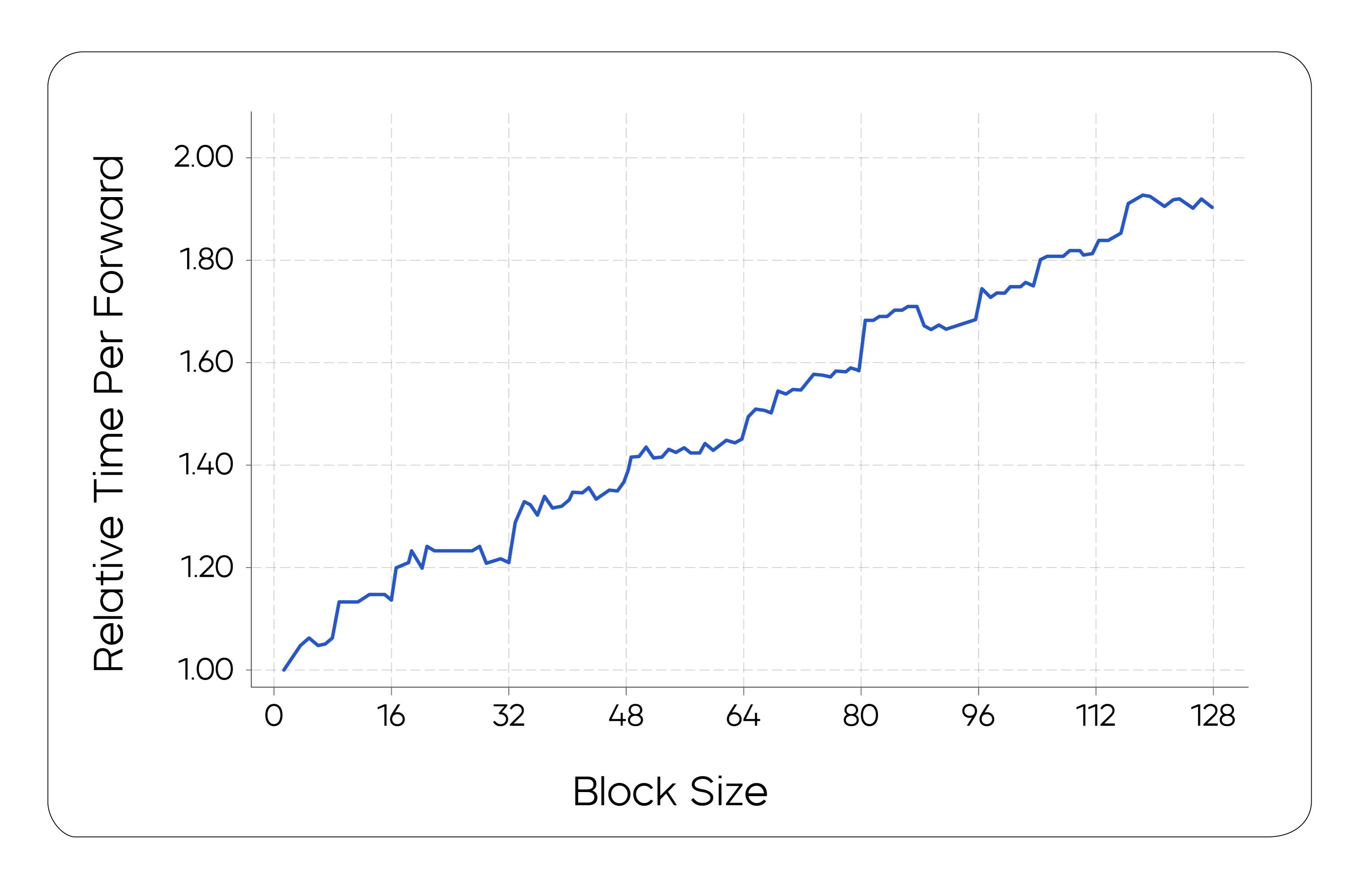

As vantagens teóricas da decodificação paralela são difíceis de realizar na prática. A sobrecarga computacional de uma única inferência paralela é alta e, se o número total de etapas for reduzido para compensar a sobrecarga, a qualidade da geração será novamente sacrificada.

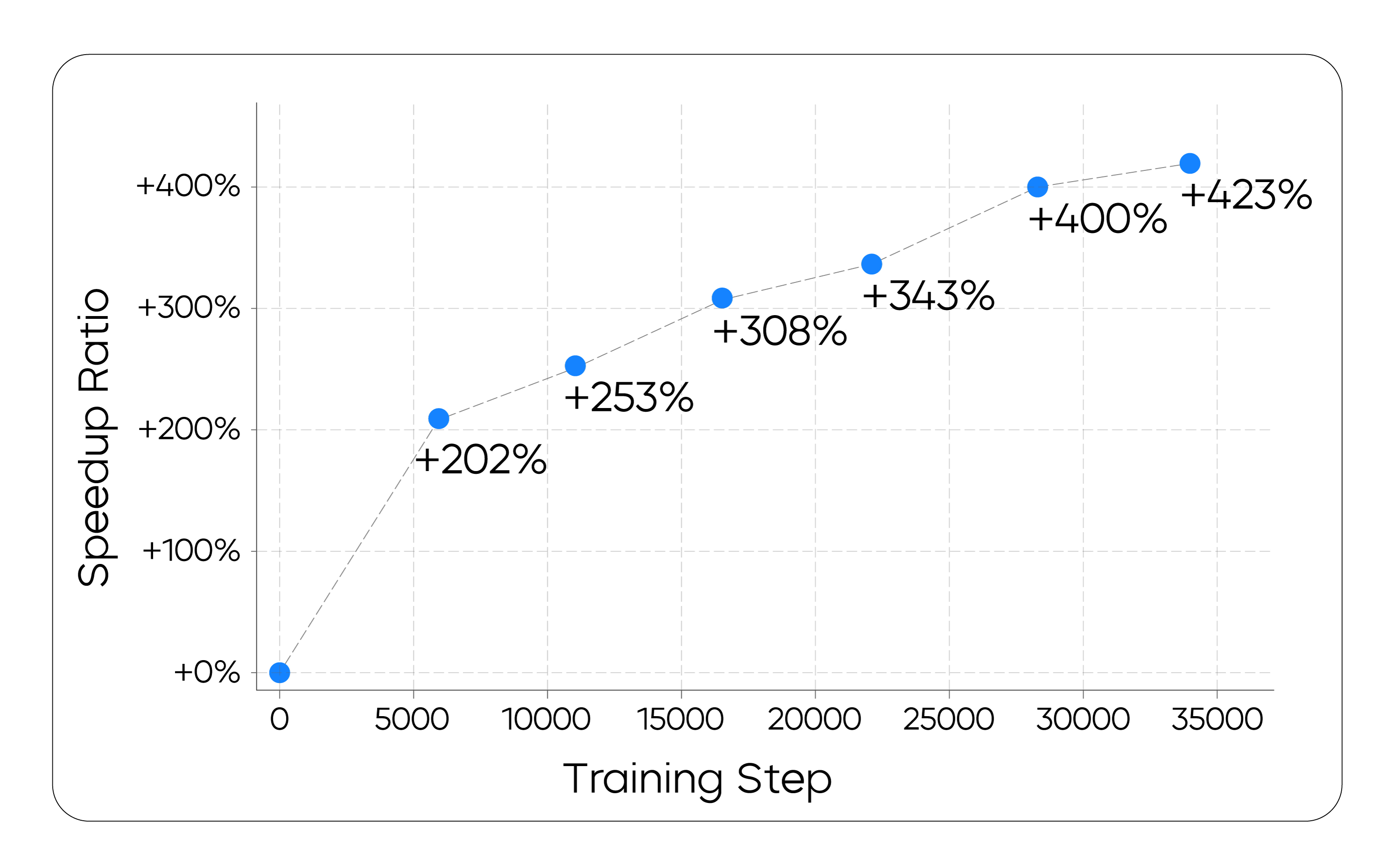

Para isso, a equipe propôs o paradigma de aprendizagem na política. O objetivo é treinar o modelo para otimizar diretamente seu próprio processo de geração, minimizando o número de etapas de geração e mantendo a qualidade do resultado final. |τ|. Sua função objetiva é a seguinte:

Lτ = E(x0,τ)∼D[log V(xτ) - λ * |τ|]

Na prática, minimizar diretamente o número de etapas leva a um treinamento instável. Em vez disso, a equipe adotou uma função de perda de proxy mais estável para incentivar o modelo a convergir de forma mais eficiente. Esse processo é semelhante às técnicas de "filtragem de padrões" usadas na literatura de geração não autorregressiva, em que caminhos de geração ineficientes ou de baixa qualidade são implicitamente "podados" por meio do treinamento.

Da teoria à realização da engenharia

Para equilibrar a computação e a latência, oSeed A equipe usou um esquema de amostragem de difusão paralela em partes. Esse esquema mantém a ordem causal entre os blocos enquanto usa o KV-caching técnicas de reutilização de informações dos blocos gerados. A equipe também otimizou especificamente a estrutura de infraestrutura subjacente para dar suporte eficiente ao raciocínio paralelo em blocos.

Resultados experimentais e perspectivas de mercado

No teste da tarefa de geração, oSeed Diffusion Preview Todo o potencial paralelo do modelo de difusão é liberado, alcançando um aumento de velocidade de 5,4 vezes em relação a um modelo autorregressivo do mesmo tamanho.

Além disso, essa alta velocidade não foi obtida à custa da qualidade. Em vários testes de referência do setor, oSeed Diffusion Preview O desempenho é comparável ao dos principais modelos autorregressivos e até os supera em tarefas como edição de código.

Esse resultado sugere que, para Seed Diffusion A abordagem de difusão discreta, representada pelo método de difusão discreta, não só tem o potencial de se tornar a estrutura básica para a próxima geração de modelos generativos, mas também prevê suas amplas perspectivas de aplicação. Para os desenvolvedores, a aceleração de 5,4 vezes significa um preenchimento de código em tempo real mais suave, geração de teste de unidade mais rápida e mais eficiente bug que melhorarão radicalmente a experiência de programação colaborativa entre humanos e computadores.

no rastro de Seed Diffusion A exploração contínua do projeto, seu potencial de aplicação em tarefas de raciocínio complexas e as leis de escalonamento serão revelados com mais detalhes.