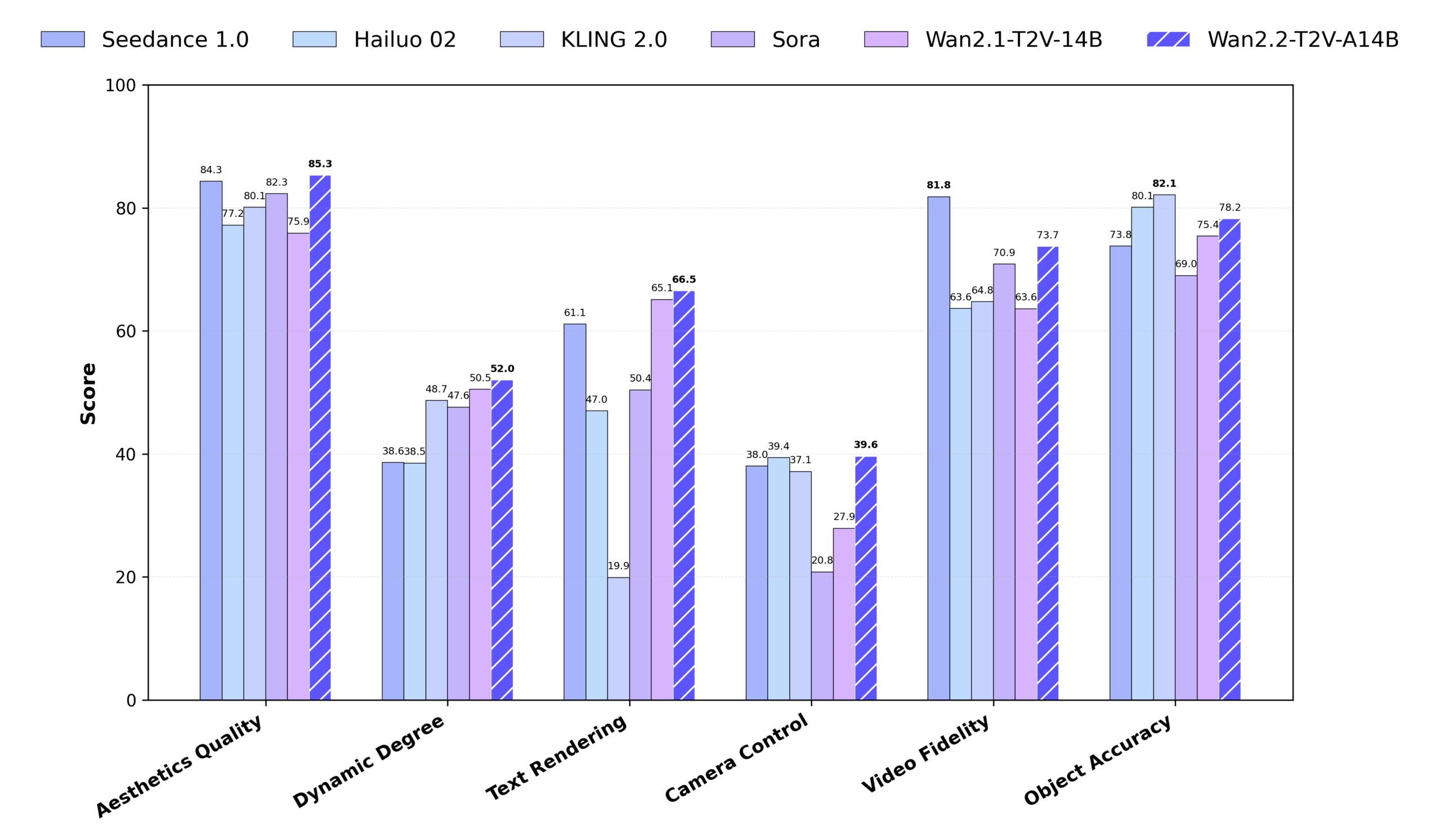

O Wan2.2 é um modelo de geração de vídeo de código aberto desenvolvido pela Alibaba Tongyi Labs, com foco na geração de vídeos de alta qualidade a partir de texto ou imagens. Ele adota a arquitetura Mixed Expert (MoE), que melhora significativamente a qualidade da geração e, ao mesmo tempo, mantém a eficiência computacional ao separar o processo de redução de ruído das fases de alto e baixo ruído. O Wan2.2 é compatível com a geração de vídeo HD 720P@24fps e é executado em GPUs de consumo (por exemplo, RTX 4090), o que o torna adequado para criadores e desenvolvedores individuais. Em comparação com o Wan2.1, o Wan2.2 adiciona 65,6% de imagens e 83,2% de vídeos aos dados de treinamento, melhorando significativamente a geração de movimento, a compreensão semântica e a estética. Ele é compatível com texto para vídeo (T2V), imagem para vídeo (I2V) e co-geração de texto-imagem (TI2V), e se integra com Diffusers e ComfyUI para proporcionar um uso flexível. O Wan2.2 supera alguns dos modelos comerciais nos benchmarks do Wan-Bench 2.0, demonstrando um desempenho sólido e um amplo potencial de aplicação.

Lista de funções

- Texto para vídeo (T2V) Gera 5 segundos de vídeo em 480P ou 720P a partir de descrições de texto, oferecendo suporte a cenas e ações complexas.

- Imagem para vídeo (I2V) Geração de vídeo em movimento a partir de imagens estáticas, mantendo a consistência e o estilo da imagem.

- Geração conjunta de texto e imagem (TI2V) Combina texto e imagens para gerar vídeo de 720P@24fps para dispositivos com pouca RAM.

- Auto-Encodificador variável de vídeo de alta eficiência (Wan-VAE) Taxa de compactação de 16×16×4: alcança a taxa de compactação de 16×16×4 e oferece suporte à reconstrução de vídeo de alta qualidade.

- Arquitetura especializada híbrida (MoE) Melhorar a qualidade da geração e manter a eficiência computacional usando modelos especializados de alto e baixo ruído.

- Estética cinematográfica Suporte ao controle preciso de iluminação, composição e tom para produzir vídeos profissionais no estilo de cinema.

- Geração de movimentos complexos Suporte a ações dinâmicas, como dança, luta, parkour etc., com movimentos suaves e naturais.

- Extensão da ponta Enriqueça as dicas de texto e aprimore os detalhes do vídeo com a API do Dashscope ou com os modelos nativos do Qwen.

- Otimização de pouca memória Suporte à quantificação do FP8 e ao descarregamento de modelos para reduzir os requisitos de memória da GPU.

- Integração multiplataforma Suporte a Diffusers e ComfyUI, fornecendo operação de linha de comando e interface gráfica.

Usando a Ajuda

Processo de instalação

Para usar o Wan2.2, é necessário configurar o ambiente localmente ou em um servidor. As etapas detalhadas de instalação e uso a seguir são adequadas para desenvolvedores iniciantes e experientes.

1. preparação ambiental

Certifique-se de que seu sistema atenda aos seguintes requisitos:

- software Os modelos T2V-A14B e I2V-A14B exigem uma GPU com pelo menos 80 GB de memória de vídeo (por exemplo, A100); o modelo TI2V-5B é compatível com GPUs de consumo com 24 GB de memória de vídeo (por exemplo, RTX 4090).

- sistema operacional Windows, Linux ou macOS são compatíveis.

- Versão Python Python 3.10 ou posterior.

- Ferramentas dependentes Git, PyTorch (recomendado 2.4.0 ou posterior), Hugging Face CLI, ModelScope CLI.

2. clonagem da base de código

Execute o seguinte comando em um terminal ou prompt de comando para clonar a base de código do Wan2.2:

git clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

3. instalação de dependências

Instale as bibliotecas Python necessárias. Execute o seguinte comando:

pip install -r requirements.txt

pip install "huggingface_hub[cli]" modelscope

Se estiver usando a aceleração de várias GPUs, será necessário instalar o xfuser>=0.4.1:

pip install "xfuser>=0.4.1"

tomar nota de : Se flash_attn Se a instalação falhar, é recomendável instalar outras dependências primeiro e, por fim, instalá-las individualmente flash_attn。

4. download dos pesos do modelo

O Wan2.2 oferece três modelos: T2V-A14B, I2V-A14B e TI2V-5B. Veja a seguir os comandos de download:

Downloads do Hugging Face :

huggingface-cli download Wan-AI/Wan2.2-T2V-A14B --local-dir ./Wan2.2-T2V-A14B

huggingface-cli download Wan-AI/Wan2.2-I2V-A14B --local-dir ./Wan2.2-I2V-A14B

huggingface-cli download Wan-AI/Wan2.2-TI2V-5B --local-dir ./Wan2.2-TI2V-5B

Download do ModelScope :

modelscope download Wan-AI/Wan2.2-T2V-A14B --local_dir ./Wan2.2-T2V-A14B

modelscope download Wan-AI/Wan2.2-I2V-A14B --local_dir ./Wan2.2-I2V-A14B

modelscope download Wan-AI/Wan2.2-TI2V-5B --local_dir ./Wan2.2-TI2V-5B

5) Configuração de variáveis de ambiente (opcional)

Se estiver usando a Hint Extension, você precisará configurar a chave da API do Dashscope:

export DASH_API_KEY=your_dashscope_api_key

Para usuários internacionais, são necessárias configurações adicionais:

export DASH_API_URL=https://dashscope-intl.aliyuncs.com/api/v1

Você precisa solicitar uma chave de API no Alibaba Cloud com antecedência.

6. execute o script de geração

Provisão Wan2.2 generate.py Os scripts são usados para gerar vídeos. Veja abaixo um exemplo de como cada tarefa é executada:

Texto para vídeo (T2V-A14B) :

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --offload_model True --convert_model_dtype --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- GPU única : 80 GB de memória de vídeo necessários, habilite

--offload_model True和--convert_model_dtypeRedução dos requisitos de memória gráfica. - Multi-GPU :

torchrun --nproc_per_node=8 generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --dit_fsdp --t5_fsdp --ulysses_size 8 --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

Imagem para vídeo (I2V-A14B) :

python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --offload_model True --convert_model_dtype --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上,背景是模糊的海景和绿色山丘"

- A resolução da imagem precisa corresponder à resolução do vídeo de destino.

- Oferece suporte à geração de palavras não solicitadas, contando apenas com a imagem de entrada:

DASH_API_KEY=your_key python generate.py --task i2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-I2V-A14B --prompt '' --image examples/i2v_input.JPG --use_prompt_extend --prompt_extend_method 'dashscope'

Geração conjunta de texto e imagem (TI2V-5B) :

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

- entrada de imagem (modo I2V):

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --image examples/i2v_input.JPG --prompt "夏日海滩度假风格,一只戴墨镜的白猫坐在冲浪板上"

- O TI2V-5B é compatível com GPUs com 24 GB de memória de vídeo e leva cerca de 9 minutos para gerar vídeo 720P@24fps.

Extensão da ponta :

Use a API do Dashscope:

DASH_API_KEY=your_key python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'dashscope' --prompt_extend_target_lang 'zh' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

Usando um modelo Qwen nativo (por exemplo Qwen/Qwen2.5-7B-Instruct):

python generate.py --task t2v-A14B --size 1280*720 --ckpt_dir ./Wan2.2-T2V-A14B --use_prompt_extend --prompt_extend_method 'local_qwen' --prompt_extend_model 'Qwen/Qwen2.5-7B-Instruct' --prompt "两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战"

7. usando o ComfyUI

O Wan2.2 está integrado ao ComfyUI para usuários de GUI. Etapas de instalação:

- Clone ComfyUI-WanVideoWrapper:

git clone https://github.com/kijai/ComfyUI-WanVideoWrapper.git

cd ComfyUI-WanVideoWrapper

pip install -r requirements.txt

- Coloque o arquivo de modelo na pasta ComfyUI Catálogo:

- Modelo T2V/I2V:

ComfyUI/models/diffusion_models/ - Modelo VAE:

ComfyUI/models/vae/ - Modelo CLIP:

ComfyUI/models/clip_vision/

- Modelo T2V/I2V:

- Carregue o fluxo de trabalho no ComfyUI, importe o modelo Wan2.2, defina os prompts e execute-o.

8. uso de difusores

O Wan2.2 foi integrado ao Diffusers para simplificar a chamada de modelos:

from diffusers import DiffusionPipeline

pipeline = DiffusionPipeline.from_pretrained("Wan-AI/Wan2.2-TI2V-5B-Diffusers")

pipeline.to("cuda")

video = pipeline(prompt="两只拟人猫穿着舒适的拳击装备,在聚光灯舞台上激烈对战").videos

Os modelos T2V-A14B, I2V-A14B e TI2V-5B são compatíveis.

Operação das principais funções

Texto para vídeo

Gere um vídeo de 5 segundos inserindo uma descrição de texto detalhada, como "A city skyline at night with neon lights flashing" (O horizonte de uma cidade à noite com luzes de neon piscando). Recomenda-se o uso de dicas específicas, como "Uma garota com um casaco vermelho caminhando na neve com uma floresta coberta de neve ao fundo". Ative as extensões de dicas (--use_prompt_extend) As descrições podem ser enriquecidas automaticamente para gerar uma imagem mais detalhada.

Imagem para vídeo

Carregue uma imagem com uma descrição de texto para gerar um vídeo animado. Por exemplo, carregue uma foto de um gato e digite "Cat chasing butterfly on grass" (Gato perseguindo borboleta na grama) para gerar a animação correspondente. Certifique-se de que a resolução da imagem seja a mesma do vídeo de destino.

Geração conjunta de texto e imagem

O modelo TI2V-5B suporta entrada de texto ou imagem para gerar vídeo 720P@24fps. Adequado para dispositivos com pouca memória de vídeo, velocidade de geração rápida e resultados estáveis.

Estética cinematográfica

O Wan2.2 oferece suporte ao controle preciso da iluminação, da composição e dos tons de cores. Por exemplo, digite "Iluminação lateral, alto contraste, tons quentes, um jovem em pé em uma floresta" para gerar um vídeo de estilo cinematográfico.

Geração de movimentos complexos

Suporte para gerar ações dinâmicas, como "atletas de parkour de rua saltando sobre obstáculos" ou "dançarinos de hip-hop se apresentando em um palco de neon", com movimentos suaves e naturais.

cenário do aplicativo

- criação de conteúdo

- Os criadores podem transformar textos ou imagens em vídeos curtos para anúncios, curtas-metragens ou conteúdo de mídia social. Por exemplo, gerar um vídeo animado de uma "nave espacial de ficção científica viajando pelas estrelas".

- Educação e apresentação

- Os professores podem transformar material didático estático em vídeos dinâmicos para aprimorar o ensino e a aprendizagem. Por exemplo, as descrições de eventos históricos são convertidas em vídeos para mostrar cenas históricas.

- Desenvolvimento de jogos e animações

- Os desenvolvedores podem gerar vídeos de fundo de jogos ou protótipos animados. Por exemplo, gerar uma "vida cotidiana em uma vila medieval" como referência para uma cena de jogo.

- Publicidade comercial

- As empresas podem gerar vídeos promocionais de produtos. Por exemplo, digite "o uso de relógios inteligentes em cenas de esportes ao ar livre" para gerar um vídeo curto demonstrando a função.

- arte

- Os artistas podem transformar pinturas estáticas em vídeos dinâmicos. Por exemplo, transforme uma pintura abstrata em um efeito de animação fluida.

QA

- Quais resoluções são compatíveis com o Wan2.2?

- O T2V-A14B e o I2V-A14B suportam 480P e 720P; o TI2V-5B suporta 720P (1280).704 ou 7041280)。

- Como funcionam os dispositivos de memória de vídeo de baixo custo?

- Usando o modelo TI2V-5B (24 GB de memória de vídeo), ative a função

--offload_model True、--convert_model_dtype和--t5_cpuRedução dos requisitos de memória gráfica.

- Usando o modelo TI2V-5B (24 GB de memória de vídeo), ative a função

- Como posso melhorar a qualidade do meu vídeo?

- Use palavras de dicas detalhadas, ative a expansão de dicas e selecione modelos FP16 (qualidade superior a FP8).

- Ele é compatível com o uso comercial?

- Sim, o Wan2.2 está licenciado sob a licença Apache 2.0 e pode ser usado em projetos comerciais, sujeito às leis pertinentes.

- Quais são os aprimoramentos do Wan2.2 em relação ao Wan2.1?

- A introdução da arquitetura MoE adiciona 65,6% de imagens e 83,2% de vídeo aos dados de treinamento, oferecendo suporte a efeitos estéticos mais complexos de movimento e qualidade cinematográfica.