A Together AI é uma plataforma focada em modelos de IA generativos, fornecendo uma gama completa de serviços, desde o treinamento do modelo, o ajuste fino até a inferência. Os usuários podem aproveitar o mecanismo de inferência altamente eficiente do Together AI e os clusters de GPU para implementar e executar rapidamente uma variedade de modelos de código aberto. A plataforma oferece suporte a várias arquiteturas de modelos para atender a diferentes requisitos de aplicativos de IA.

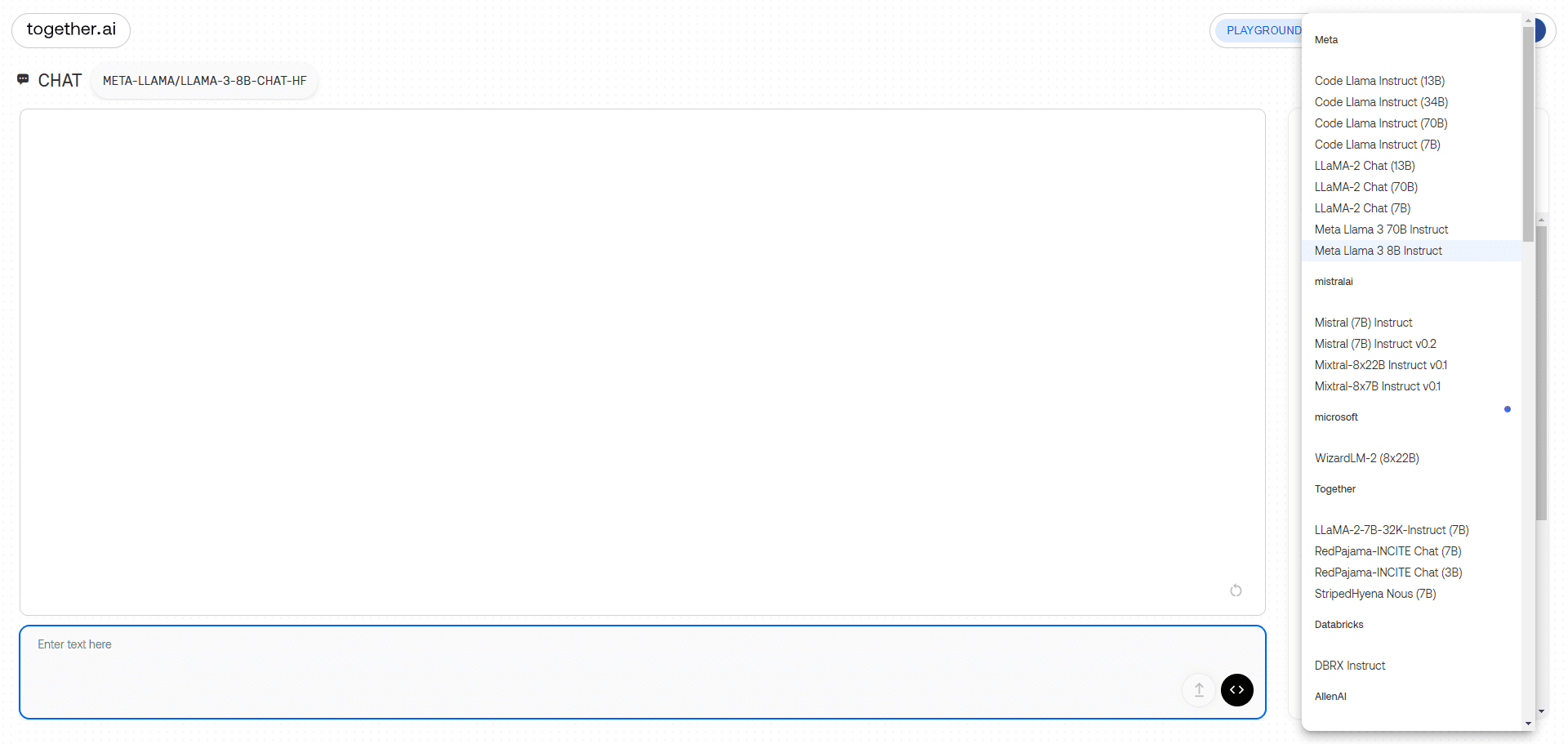

Interface de demonstração de bate-papo de modelo grande

Lista de funções

- API de inferênciaSuporte ao raciocínio em mais de 100 modelos de código aberto e fornece modelos de instância dedicados e sem servidor.

- função de ajuste finoPermitir que os usuários façam o ajuste fino dos modelos de IA generativa usando seus próprios dados, mantendo a propriedade dos dados.

- Cluster de GPUFornece clusters de ponta de 16 a mais de 1.000 GPUs para dar suporte ao treinamento de modelos em grande escala.

- Treinamento de modelos personalizadosTreinamento de modelos de ponta a partir do zero e suporte a várias arquiteturas de modelos.

- modelo multimodalSuporte a reconhecimento de imagens, inferência de imagens, geração de imagens e muito mais.

- Mecanismo de inferência eficienteIntegração das mais recentes tecnologias de inferência, como FlashAttention-3 e Flash-Decoding, para fornecer serviços de inferência rápidos e precisos.

Usando a Ajuda

Instalação e uso

- Registro e login:

- Visite o site da Together AI (https://www.together.ai/) e clique no botão "Start Building" para se registrar.

- Após a conclusão do registro, faça login na sua conta e acesse o Painel de controle do usuário.

- Selecionar serviço:

- No painel de controle, selecione o módulo de serviço que precisa usar, como a API de inferência, a função de ajuste fino ou o cluster de GPU.

- Selecione o modo de instância dedicada ou sem servidor, conforme necessário.

- Uso da API de inferência:

- Selecione o modelo de código aberto que você precisa executar, como Llama-3, RedPajama, etc.

- Integre o modelo em seu aplicativo por meio da interface API fornecida pela Together AI.

- Crie seu próprio aplicativo RAG usando os pontos de extremidade incorporados do Together AI.

- função de ajuste fino:

- Carregue seu conjunto de dados e selecione os modelos que precisam ser ajustados.

- Configure os parâmetros de ajuste fino para iniciar o processo de ajuste fino.

- Quando o ajuste fino estiver concluído, faça o download do modelo ajustado e implemente-o.

- Uso do cluster de GPU:

- Selecione o tamanho do cluster de GPU desejado e configure os parâmetros de hardware.

- Carregue os dados de treinamento e o código do modelo para iniciar o treinamento.

- Após a conclusão do treinamento, o modelo treinado é baixado para inferência ou ajuste fino adicional.

- Treinamento de modelos personalizados:

- Selecione o módulo Custom Model Training para configurar a arquitetura do modelo e os parâmetros de treinamento.

- Carregue o conjunto de dados e inicie o processo de treinamento.

- Após a conclusão do treinamento, o modelo é baixado para implantação e inferência.

fluxo de trabalho

- Acesso ao painel de controleApós fazer o login, acesse o painel de controle e selecione o módulo de serviço desejado.

- Parâmetros de configuraçãoConfiguração de parâmetros de inferência, ajuste fino ou treinamento, conforme necessário.

- Carregar dadosCarregar o conjunto de dados ou o código do modelo necessário.

- Início da missãoIniciar tarefas de raciocínio, ajuste fino ou treinamento e monitorar o progresso da tarefa em tempo real.

- Resultados do downloadApós a conclusão da tarefa, os resultados do modelo ou da inferência são baixados para integração com o aplicativo.

problemas comuns

- Como escolher o modelo certo?

- Selecione o modelo de código aberto apropriado com base no cenário do aplicativo, como geração de texto, reconhecimento de imagem etc.

- E se eu encontrar um erro durante o ajuste fino?

- Verifique o formato do conjunto de dados e as configurações dos parâmetros e consulte a documentação oficial para fazer ajustes.

- Desempenho insatisfatório durante o uso do cluster de GPU?

- Confirme se a configuração do hardware atende aos requisitos e ajuste os parâmetros de treinamento para aumentar a eficiência.

modelo utilizável

| Serverless Endpoints | Author | Type | Pricing (per 1M tokens) | |

|---|---|---|---|---|

| Meta Llama 3.2 11B Vision Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3.2 90B Vision Instruct Turbo | ||||

| Meta | chat | $1.20 | ||

| Qwen2.5 7B Instruct Turbo | ||||

| Qwen | chat | $0.30 | ||

| Qwen2.5 72B Instruct Turbo | ||||

| Qwen | chat | $1.20 | ||

| FLUX.1 [schnell] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX1.1 [pro] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX.1 [pro] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX.1 [schnell] Free | ||||

| Black Forest Labs | image | See pricing | ||

| Meta Llama 3.2 3B Instruct Turbo | ||||

| Meta | chat | $0.06 | ||

| Meta Llama Vision Free | ||||

| Meta | chat | Free | ||

| Meta Llama Guard 3 11B Vision Turbo | ||||

| Meta | moderation | $0.18 | ||

| Meta Llama 3.1 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Mixtral-8x22B Instruct v0.1 | ||||

| mistralai | chat | $1.20 | ||

| Stable Diffusion XL 1.0 | ||||

| Stability AI | image | See pricing | ||

| Meta Llama 3.1 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3.1 405B Instruct Turbo | ||||

| Meta | chat | $3.50 | ||

| Gryphe MythoMax L2 Lite (13B) | ||||

| Gryphe | chat | $0.10 | ||

| Salesforce Llama Rank V1 (8B) | ||||

| salesforce | rerank | $0.10 | ||

| Meta Llama Guard 3 8B | ||||

| Meta | moderation | $0.20 | ||

| Meta Llama 3 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3 70B Instruct Lite | ||||

| Meta | chat | $0.54 | ||

| Meta Llama 3 8B Instruct Lite | ||||

| Meta | chat | $0.10 | ||

| Meta Llama 3 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3 70B Instruct Reference | ||||

| Meta | chat | $0.90 | ||

| Meta Llama 3 8B Instruct Reference | ||||

| Meta | chat | $0.20 | ||

| Qwen 2 Instruct (72B) | ||||

| Qwen | chat | $0.90 | ||

| Gemma-2 Instruct (27B) | ||||

| chat | $0.80 | |||

| Gemma-2 Instruct (9B) | ||||

| chat | $0.30 | |||

| Mistral (7B) Instruct v0.3 | ||||

| mistralai | chat | $0.20 | ||

| Qwen 1.5 Chat (110B) | ||||

| Qwen | chat | $1.80 | ||

| Meta Llama Guard 2 8B | ||||

| Meta | moderation | $0.20 | ||

| WizardLM-2 (8x22B) | ||||

| microsoft | chat | $1.20 | ||

| DBRX Instruct | ||||

| Databricks | chat | $1.20 | ||

| DeepSeek LLM Chat (67B) | ||||

| DeepSeek | chat | $0.90 | ||

| Gemma Instruct (2B) | ||||

| chat | $0.10 | |||

| Mistral (7B) Instruct v0.2 | ||||

| mistralai | chat | $0.20 | ||

| Mixtral-8x7B Instruct v0.1 | ||||

| mistralai | chat | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| mistralai | language | $0.60 | ||

| Qwen 1.5 Chat (72B) | ||||

| Qwen | chat | $0.90 | ||

| Llama Guard (7B) | ||||

| Meta | moderation | $0.20 | ||

| Nous Hermes 2 – Mixtral 8x7B-DPO | ||||

| NousResearch | chat | $0.60 | ||

| Mistral (7B) Instruct | ||||

| mistralai | chat | $0.20 | ||

| Mistral (7B) | ||||

| mistralai | language | $0.20 | ||

| LLaMA-2 Chat (13B) | ||||

| Meta | chat | $0.22 | ||

| LLaMA-2 Chat (7B) | ||||

| Meta | chat | $0.20 | ||

| LLaMA-2 (70B) | ||||

| Meta | language | $0.90 | ||

| Code Llama Instruct (34B) | ||||

| Meta | chat | $0.78 | ||

| Upstage SOLAR Instruct v1 (11B) | ||||

| upstage | chat | $0.30 | ||

| M2-BERT-Retrieval-32k | ||||

| Together | embedding | $0.01 | ||

| M2-BERT-Retrieval-8k | ||||

| Together | embedding | $0.01 | ||

| M2-BERT-Retrieval-2K | ||||

| Together | embedding | $0.01 | ||

| UAE-Large-V1 | ||||

| WhereIsAI | embedding | $0.02 | ||

| BAAI-Bge-Large-1p5 | ||||

| BAAI | embedding | $0.02 | ||

| BAAI-Bge-Base-1p5 | ||||

| BAAI | embedding | $0.01 | ||

| MythoMax-L2 (13B) | ||||

| Gryphe | chat | $0.30 |

exemplo de uso

Exemplos de raciocínio de modelo

import os

import requests

url = "https://api.together.xyz/v1/chat/completions"

payload = {

"model": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"temperature": 0.7,

"top_p": 0.7,

"top_k": 50,

"repetition_penalty": 1

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)

Exemplo de ajuste fino do modelo

import os

import requests

url = "https://api.together.xyz/v1/fine-tune"

payload = {

"model": "togethercomputer/llama-2-70b-chat",

"data": "path/to/your/data",

"epochs": 3,

"batch_size": 8

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)