TaskingAI é uma plataforma de código aberto focada em ajudar os desenvolvedores a criar aplicativos nativos de IA. Ela simplifica o processo de desenvolvimento de modelos de linguagem grande (LLMs) fornecendo uma interface intuitiva, APIs avançadas e um design modular flexível. A plataforma é compatível com uma ampla variedade de modelos convencionais, como OpenAI, Anthropic etc., e permite a integração de modelos nativos. Com ênfase no alto desempenho assíncrono, nas extensões de plug-in e no suporte multilocatário, o TaskingAI é adequado para desenvolvedores iniciantes e profissionais. Os usuários podem implementar rapidamente a edição da comunidade via Docker ou usar serviços de nuvem para desenvolvimento. A plataforma também oferece um SDK de cliente Python para facilitar aos desenvolvedores o gerenciamento e a invocação de funções de IA. O TaskingAI tem o compromisso de tornar o desenvolvimento de aplicativos de IA mais fácil e eficiente, com uma comunidade ativa que incentiva os usuários a participarem da contribuição.

Lista de funções

- Oferece suporte a uma ampla variedade de modelos de idiomas grandes (LLMs), incluindo OpenAI, Claude, Mistral, etc., e pode ser integrado a modelos locais, como Ollama.

- Fornece plug-ins avançados, como pesquisa no Google, leitura de conteúdo de sites, aquisição de dados de ações etc. Oferece suporte a ferramentas definidas pelo usuário.

- Sistema RAG (Retrieval Augmentation Generation) integrado para facilitar o manuseio e o gerenciamento de dados externos.

- Oferece suporte ao processamento assíncrono e à computação simultânea de alto desempenho com base na FastAPI.

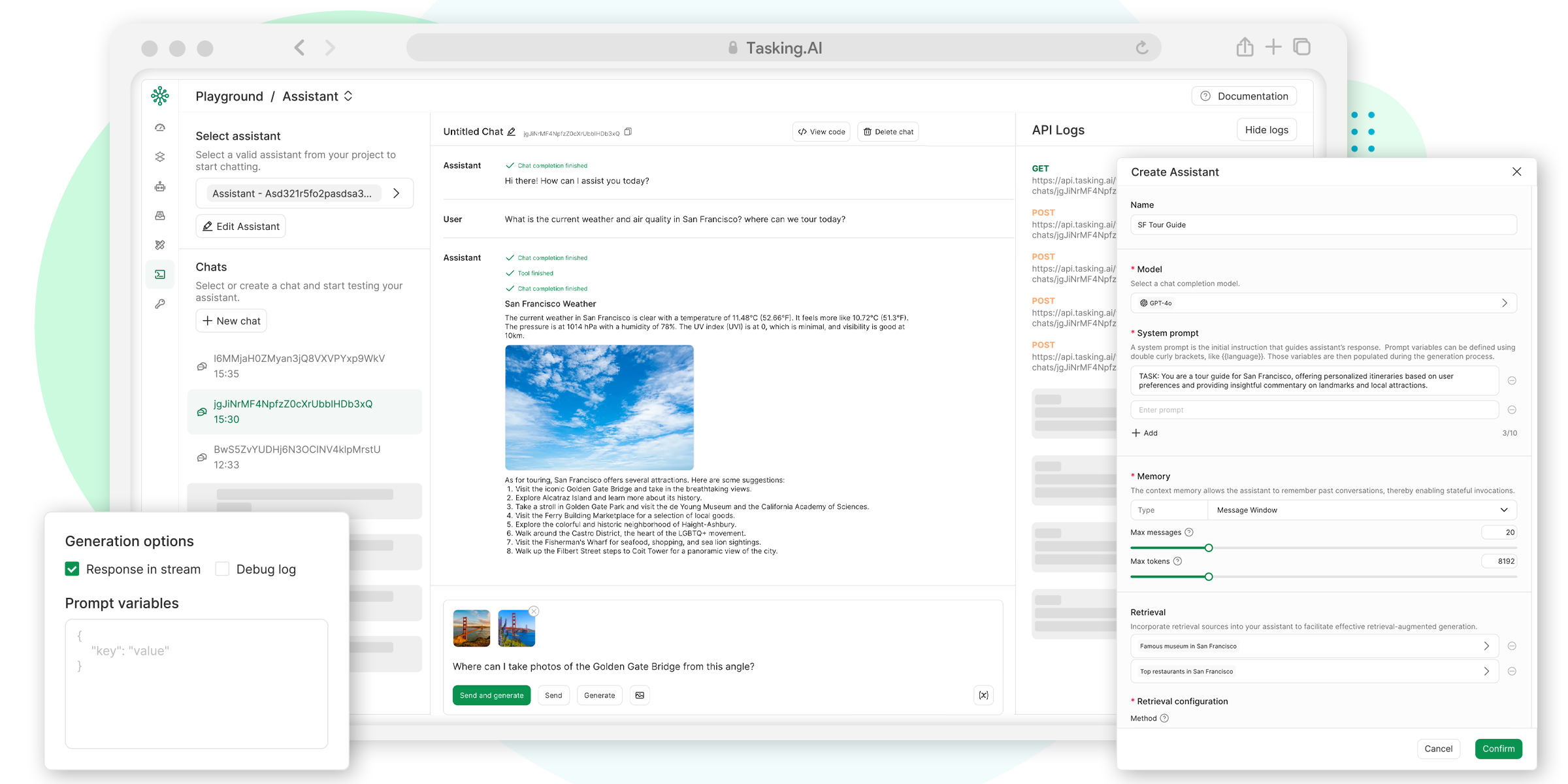

- Fornece um console de interface do usuário intuitivo para simplificar o gerenciamento de projetos e os fluxos de trabalho de teste.

- Oferece suporte ao desenvolvimento de aplicativos multilocatário para rápida implementação e dimensionamento.

- Fornecer uma interface API unificada para facilitar o gerenciamento de modelos, ferramentas e dados.

- Suporte a APIs de conclusão de bate-papo compatíveis com OpenAI para simplificar a criação e a invocação de tarefas.

Usando a Ajuda

O TaskingAI é uma plataforma avançada para que os desenvolvedores criem rapidamente aplicativos nativos de IA. Abaixo está um guia detalhado de instalação e uso para ajudar os usuários a começar rapidamente.

Processo de instalação

O TaskingAI Community Edition pode ser implantado rapidamente via Docker e é adequado para desenvolvimento ou teste local. Aqui estão as etapas específicas:

- Garantir a prontidão ambiental

- Instale o Docker e o Docker Compose.

- Certifique-se de que seu sistema seja compatível com Python 3.8 ou superior.

- Opcional: crie um ambiente virtual Python para isolar as dependências.

- Download do TaskingAI Community Edition

- Visite o repositório do GitHub em https://github.com/TaskingAI/TaskingAI.

- Clonar o repositório para o local:

git clone https://github.com/TaskingAI/TaskingAI.git - Vá para o catálogo de projetos:

cd TaskingAI

- Configuração de variáveis de ambiente

- No diretório raiz do projeto, crie o arquivo

.envpara definir a chave de API e outras configurações. Exemplo:TASKINGAI_API_KEY=your_api_key TASKINGAI_HOST=http://localhost:8080 - As chaves de API estão disponíveis no console do TaskingAI (a versão em nuvem requer registro de conta).

- No diretório raiz do projeto, crie o arquivo

- Início dos serviços

- Inicie o serviço TaskingAI usando o Docker Compose:

cd docker docker-compose -p taskingai pull docker-compose -p taskingai --env-file .env up -d - Depois que o serviço for iniciado, acesse o

http://localhost:8080Exibir console.

- Inicie o serviço TaskingAI usando o Docker Compose:

- Instalando o SDK do cliente Python

- Instale o cliente Python do TaskingAI usando o pip:

pip install taskingai - Inicialize o SDK:

import taskingai taskingai.init(api_key="YOUR_API_KEY", host="http://localhost:8080")

- Instale o cliente Python do TaskingAI usando o pip:

Funções principais

Os principais recursos do TaskingAI incluem integração de modelos, uso de plugins, sistema RAG e chamadas de API. Abaixo estão as diretrizes específicas de operação:

- integração de modelos

O TaskingAI oferece suporte a uma ampla variedade de modelos de idiomas grandes. Os usuários podem selecionar modelos (por exemplo, Claude, Mistral) no console ou especificar IDs de modelos por meio da API:from openai import OpenAI client = OpenAI( api_key="YOUR_TASKINGAI_API_KEY", base_url="https://oapi.tasking.ai/v1", ) response = client.chat.completions.create( model="YOUR_MODEL_ID", messages=[{"role": "user", "content": "你好,今天天气如何?"}] ) print(response)

- No console, o usuário pode testar diretamente os efeitos de diálogo do modelo, ajustando parâmetros como temperatura ou comprimento máximo de saída.

- Uso do plug-in

O TaskingAI oferece uma variedade de plug-ins embutidos, como pesquisa no Google, leitura de conteúdo de sites etc. Os usuários também podem desenvolver plug-ins personalizados. Etapas da operação:- Selecione ou adicione um plug-in na página Plug-ins do console.

- Chamar a funcionalidade do plug-in por meio da API. Por exemplo, chamar o plug-in de pesquisa do Google:

import taskingai result = taskingai.plugin.google_search(query="最新AI技术") print(result) - Os plug-ins personalizados precisam seguir a documentação de desenvolvimento de ferramentas do TaskingAI, carregar o código e vincular-se ao agente de IA.

- Operação do sistema RAG

O sistema RAG (Retrieval Augmentation Generation) é usado para processar dados externos. Os usuários podem criar coleções de dados e recuperar conteúdo:- Criação de coleções:

coll = taskingai.retrieval.create_collection( embedding_model_id="YOUR_EMBEDDING_MODEL_ID", capacity=1000 ) print(f"集合ID: {coll.collection_id}") - Adicione um registro:

record = taskingai.retrieval.create_record( collection_id=coll.collection_id, type="text", content="人工智能正在改变世界。", text_splitter={"type": "token", "chunk_size": 200, "chunk_overlap": 20} ) print(f"记录ID: {record.record_id}") - Recuperar registros:

retrieved_record = taskingai.retrieval.get_record( collection_id=coll.collection_id, record_id=record.record_id ) print(f"检索内容: {retrieved_record.content}")

- Criação de coleções:

- Uso do console da interface do usuário

- Depois de fazer login no console, vá para a página "Projects" (Projetos) e crie um novo projeto.

- Selecione ou configure um modelo de idioma grande na página Modelo.

- Execute o fluxo de trabalho na página Teste para ver o resultado da IA em tempo real.

- Use o recurso "Logging" para monitorar as chamadas e o desempenho da API.

Operação da função em destaque

Os recursos do TaskingAI incluem processamento assíncrono e suporte a vários locatários:

- processamento assíncronoArquitetura assíncrona baseada na FastAPI, adequada para cenários de alta simultaneidade. Os usuários não precisam de configuração adicional, e as chamadas de API suportam automaticamente a assincronia. Por exemplo, ao criar várias tarefas de agente de IA, o sistema processará as solicitações em paralelo.

- Suporte a vários locatáriosAdequado para o desenvolvimento de aplicativos orientados a vários usuários. Os usuários podem atribuir modelos e plug-ins a diferentes locatários no console para garantir o isolamento dos dados. Métodos de configuração:

- Adicione um novo locatário na tela Tenant Management (Gerenciamento de locatários) do console.

- Atribua chaves de API e configurações de modelo independentes a cada locatário.

advertência

- Certifique-se de que a chave de API seja segura e não esteja comprometida.

- Quando o Docker for implantado, verifique se a porta 8080 está ocupada.

- Os usuários da versão em nuvem devem se registrar para obter uma conta e acessar https://www.tasking.ai获取API密钥.

cenário do aplicativo

- Desenvolvimento de chatbots com IA

Os desenvolvedores podem usar o TaskingAI para criar rapidamente chatbots baseados em grandes modelos de linguagem, com suporte a conversas em várias rodadas e recuperação de dados externos, adequados para cenários de atendimento ao cliente ou educação. - Análise automatizada de dados

Com plug-ins e um sistema RAG, o TaskingAI pode extrair dados de páginas da Web ou documentos e combiná-los com a análise de IA para gerar relatórios ou percepções, adequados para pesquisadores de mercado. - Prototipagem rápida

As startups ou os desenvolvedores individuais podem aproveitar o console de interface do usuário e as APIs do TaskingAI para criar rapidamente protótipos de aplicativos de IA e validar ideias de negócios. - Educação e treinamento

As organizações educacionais podem usar o TaskingAI para criar assistentes de aprendizagem interativos que ajudem os alunos a consultar pontos de conhecimento ou gerar perguntas práticas.

QA

- Quais modelos são compatíveis com o TaskingAI?

O TaskingAI é compatível com uma ampla variedade de modelos, como OpenAI, Claude, Mistral, etc., e pode integrar modelos locais por meio do Ollama, etc. - Como faço para começar a usar o TaskingAI?

Faça download da versão comunitária para implantar via Docker ou registre-se na versão em nuvem para obter a chave da API. Instale o Python SDK para chamar a API. - É necessário ter experiência em programação?

Os iniciantes podem operar com o console da interface do usuário, e os desenvolvedores podem implementar funcionalidades complexas por meio de APIs e SDKs. - Qual é a diferença entre o TaskingAI Community Edition e o Cloud Edition?

A versão comunitária é gratuita e requer implantação local; a versão em nuvem oferece serviços de hospedagem e é adequada para desenvolvimento rápido.