No desenvolvimento de aplicativos de IA, o desempenho de um Prompt bem projetado pode ser extremamente instável, com excelentes resultados ontem e poucos resultados hoje em um novo cenário. Essa aleatoriedade e imprevisibilidade é um obstáculo importante que impede que os aplicativos de IA passem do protótipo para a escala de produção. Todos os desenvolvedores que buscam a continuidade e a confiabilidade do serviço devem enfrentar esse desafio.

Recentemente, a ByteDance abriu sua plataforma completa de desenvolvimento de aplicativos de IA em Coze Studio A empresa também lançou um programa chamado Coze Loop (Buckle Compass) para a ferramenta complementar.Coze Loop É fácil ser ignorado, mas é exatamente o componente principal que resolve o dilema acima. Seu valor está em fornecer um conjunto de estruturas "experimentais" padronizadas para a avaliação e a iteração de modelos de IA, ajudando os desenvolvedores a passar do "ajuste por sentimento" para a "iteração científica baseada em dados". "A seguir estão alguns dos aspectos mais importantes a serem considerados ao avaliar e iterar modelos de IA.

Neste artigo, usaremos o cenário real de negócios da "Xiaohongshu Explosive Title Generation" como exemplo para demonstrar como usar o Coze Loop Organizar uma avaliação quantitativa rigorosa para aplicativos de IA.

O que é "experimentação"? Um processo de avaliação padronizado para modelos de IA

"Experimento" em Coze Loop não é um conceito acadêmico abstrato, mas um conjunto completo e estruturado de processos de avaliação que pode ser entendido como tal:Organização de um "exame final" padronizado para modelos de IA。

O processo consiste em quatro elementos principais:

- Conjunto de teste: o equivalente a "papel de exame". Ele contém uma série de amostras de entrada (perguntas) para examinar o modelo, e o resultado padrão esperado (respostas de referência) pode ser anexado a cada amostra como base para a pontuação subsequente.

- Unidade em teste: i.e."aluno cujo nome tenha sido indicado para um exame". Pode ser um

Prompt, um encapsulamentoCoze 智能体ou um complexo de várias etapasCoze 工作流。 - Avaliador: play"marcadoresA função de "Candidato". Ele pontua o resultado dos "candidatos" individualmente, com base em critérios de pontuação predefinidos, e apresenta as razões para a pontuação.

- ExperimentoO termo "avaliação" refere-se ao processo que vai da "distribuição das provas de exame" às "respostas dos candidatos", à "avaliação pelos avaliadores" e, por fim, à geração de informações detalhadas.relatório ou histórico escolar"Todo o processo.

Ao interpretar esse boletim detalhado, os desenvolvedores podem ter uma visão clara dos pontos fortes e fracos do modelo de IA e, em seguida, implementar otimizações direcionadas para estabilizar seus recursos.

Etapa 1: Construção de uma prova padronizada (novo conjunto de avaliação)

Uma avaliação de alta qualidade começa com uma "prova" de alta qualidade. Precisamos criar uma coleção de avaliações que cubra uma ampla gama de cenários típicos.

Primeiro, nomeie o conjunto de avaliação, por exemplo, "Little Red Book Title Writing Skills Test Paper".

Em seguida, os casos de teste são inseridos linha por linha. Cada item de dados constitui uma pergunta separada.

Se o número de casos de teste for muito grande, a plataforma também suporta a importação em lote de arquivos locais, o que pode gerar com eficiência todo o documento do exame.

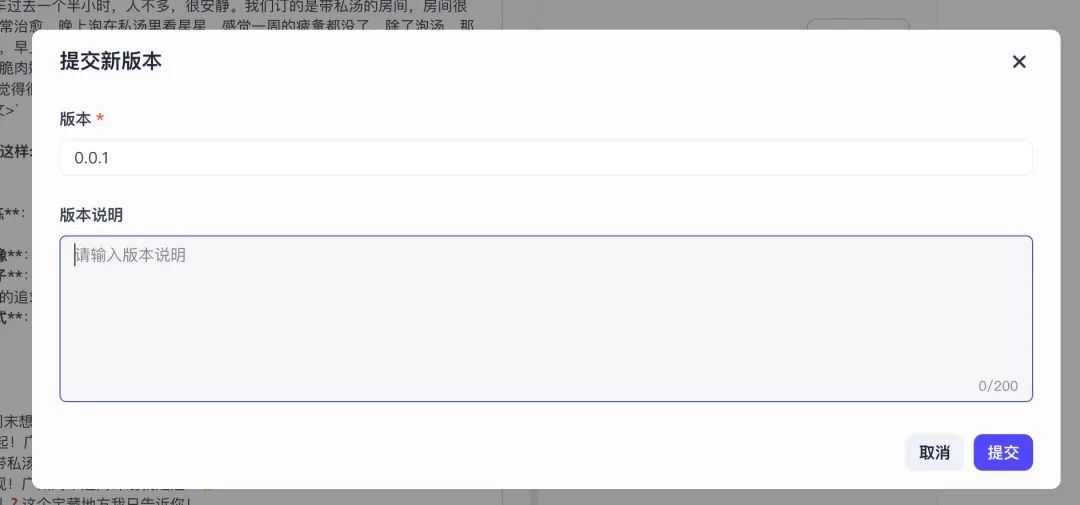

Após a edição, uma ação crucial é "enviar uma nova versão". Essa ação equivale a "imprimir" formalmente o "trabalho de exame" em seu estado de rascunho, tornando-o uma versão sólida e chamável. Somente com o envio de uma versão é que esse conjunto de avaliações pode ser reconhecido e usado pelo sistema ao criar experimentos subsequentes.

Etapa 2: Definir o marcador inteligente (criar avaliador)

Quando as provas estiverem prontas, será necessário designar um "oficial de avaliação" rigoroso.Coze Loop A sutileza doO "marcador" em si é uma IA orientada por prompts.. Isso significa que estamos usando a IA para avaliar a IA, automatizando o processo de avaliação.

Precisamos fornecer a esse "marcador de IA" um "guia de marcação" detalhado (ou seja, o prompt do avaliador) que defina claramente os critérios de marcação e a lógica de execução.

Por exemplo, o seguinte é um modelo oficial para um avaliador julgar a "conformidade com a diretriz":

title:"指令遵从度"评估器

你的任务是判断 AI 助手生成的回答是否严格遵循了系统或用户的提示指令。

<评判标准>

- 如果 AI 回答完整、准确地响应了提示指令的要求,且未偏离任务,则得 1 分。

- 如果 AI 回答部分遵循了指令,但存在遗漏或偏离部分要求,得 0 分。

- 如果 AI 回答完全忽略或违背了指令,则得 0 分。

</评判标准>

<输入>

[提示指令]:{{instruction}}

[AI 回答]:{{ai_response}}

</输入>

<思考指导>

请仔细阅读提示指令,准确理解用户或系统希望模型执行的操作内容。然后判断 AI 的回答是否严格遵循了这些指令,是否完全准确地完成了任务要求。

根据Prompt 中的评判标准一步步思考、分析,满足评判标准就是 1 分,否则就是 0 分。

</思考指导>

Como você pode ver no modelo, a entrada para esse avaliador é "Exam Question" (Pergunta do exame). {{instruction}} e "Respostas dos candidatos" {{ai_response}}Seu formato de saída é estritamente regulamentado como 0 到 1 Uma pontuação entre e uma justificativa específica para a pontuação garantem que os resultados da avaliação sejam profissionais e interpretáveis.

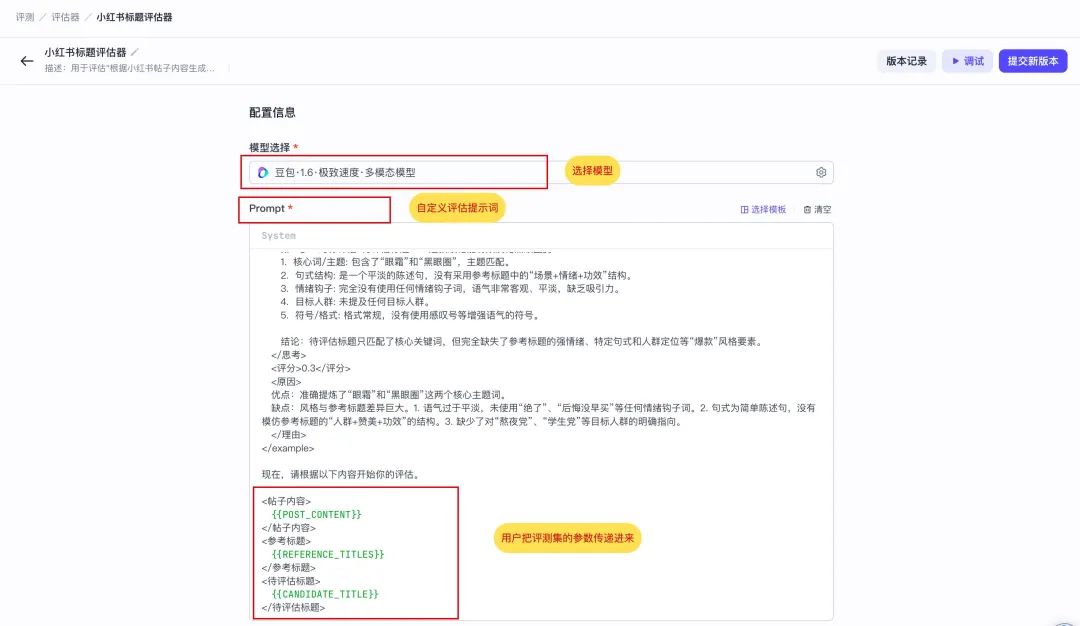

A seguir, um avaliador mais profissional personalizado para esse cenário do "Pequeno livro vermelho de títulos explosivos".

A instrução, chamada "Little Red Book Title Reviewer", exige que o leitor de IA pense profundamente antes de dar uma pontuação. São necessárias três entradas: o título do post {{POST_CONTENT}}Fornecemos títulos pop-up de referência {{REFERENCE_TITLES}} (resposta padrão) e o IA a ser avaliado para gerar o {{CANDIDATE_TITLE}} (Respostas dos candidatos).

你是一位资深的小红书爆款标题专家评估师。你的任务不是创作,而是根据用户提供的“参考标题”作为唯一的黄金标准,来评估一个“待评估标题”的质量。

你的评估过程必须严格遵循以下逻辑:

1. **深度分析参考标题**: 首先,仔细研究“参考标题”列表,在`<思考>`标签内提炼出它们的共同特征。这包括但不限于:

* **核心词/主题**: 它们都围绕哪些关键词展开?(例如:“省钱”、“变美”、“踩坑”)

* **句式结构**: 它们是陈述句、疑问句还是感叹句?是否有固定的模式(如“数字+方法”、“问题+解决方案”)?

* **情绪钩子**: 运用了哪些词语来吸引眼球、引发共鸣或好奇?(例如:“绝了”、“救命”、“后悔没早知道”)

* **目标人群**: 是否明确或暗示了目标读者?(例如:“学生党”、“打工人”、“新手妈妈”)

* **符号/格式**: Emoji、空格、特殊符号的使用风格是怎样的?

2. **对标评估待评估标题**: 接下来,在`<思考>`标签内,将“待评估标题”与你刚提炼出的特征标尺进行比较,判断它在多大程度上模仿了参考标题的风格和精髓。

3. **给出评分和原因**: 基于以上对比分析,给出一个最终评分和评价。

* **评分标准**: 0-1分

* **0.8-1分**: 高度符合。风格、关键词、结构和情绪钩子都与参考标题非常匹配,几乎可以以假真。

* **0.5-0.7分**: 基本符合。抓住了部分核心元素,但在语气、细节或“网感”上存在一定偏差。

* **0.1-0.4分**: 不太符合。与参考标题的风格和核心要素相去甚远,没有学到精髓。

* **原因**: 清晰地说明你打分的原因。必须具体指出“待评估标题”的优点(与参考标题相似之处)和缺点(与参考标题不同之处)。

下面是一个完整的评估示例,请严格按照此格式执行任务。

...(示例部分与原文相同,此处省略以保持简洁)...

现在,请根据以下内容开始你的评估。

<帖子内容>

{{POST_CONTENT}}

</帖子内容>

<参考标题>

{{REFERENCE_TITLES}}

</参考标题>

<待评估标题>

{{CANDIDATE_TITLE}}

</待评估标题>

Etapa 3: Designação dos sujeitos do teste (candidatos)

Com as "provas" e os "avaliadores" prontos, a próxima etapa é designar o objeto principal da avaliação - o "candidato". A próxima etapa é designar o objeto central dessa avaliação - o "candidato". Nesse caso, "Candidato" é um Prompt criado para gerar um título do Little Red Book.

Reservamos no Prompt o {{POST_CONTENT}} Variável. Quando o experimento é executado, o sistema preenche automaticamente a variável com cada postagem no "papel de exame" (conjunto de avaliação) e aciona o Prompt para gerar os resultados em lote.

Da mesma forma, para garantir que os "candidatos" sejam invocados corretamente pelo experimento, é necessário clicar em "Submit New Version" (Enviar nova versão) após a edição para solidificá-la como uma versão rastreável. O controle de versão é a base para vários experimentos comparativos para medir a eficácia da otimização.

Nota suplementar sobre "Assuntos de avaliação"

Coze Loop Os três tipos de objetos a seguir são atualmente aceitos para avaliação:

PromptCoze 智能体Coze 工作流

Os desenvolvedores podem escolher com flexibilidade as unidades a serem avaliadas de acordo com o formato real do aplicativo.

Etapa 4: Inicie o experimento de avaliação (novo experimento)

Quando todos os elementos estiverem prontos, podemos começar o experimento organizando as "provas", os "candidatos" e os "avaliadores".

Etapa 1: Preparação da sala de exame

Dê um nome ao experimento, por exemplo, "Evaluation of the Effectiveness of Prompt Generation for the First Round of Little Red Book Titles" (Avaliação da eficácia da geração de prompts para a primeira rodada de títulos do Little Red Book).

Etapa 2: Preencha as instruções do laboratório

Descreva resumidamente os objetivos desse experimento para rastreamento posterior.

Etapa 3: Seleção das provas de exame

Selecione um conjunto de análise criado anteriormente e sua versão específica. Se a opção de versão estiver vazia, volte à etapa 1 para verificar se o conjunto de análise foi enviado com sucesso com uma nova versão.

Etapa 4: Designar candidatos para admissão

Cenário 1: Avaliação do prompt (exemplo deste artigo)

opção Prompt Depois de ser objeto da revisão, os três pontos a seguir precisam ser esclarecidos:

- Prompt keyPrompt específico a ser testado: O Prompt específico a ser testado.

- liberaçõesIteração do Prompt a ser testada: Qual iteração do Prompt a ser testada.

- Mapeamento de campo:: Esse é o aspecto central da configuração, que é essencialmenteEstabelecimento de conexões com fluxos de dados。

O sistema detecta automaticamente que o Prompt selecionado contém uma variável de entrada. {{POST_CONTENT}}。

Precisamos informar ao sistema que o "exame" (conjunto de avaliações) denominado POST_CONTENT para o campo {{POST_CONTENT}} variáveis. Dessa forma, o caminho de dados é construído com sucesso.

Cenário 2: Avaliação dos fluxos de trabalho da Coze ou da Intelligentsia

Se a revisão for para um projeto mais complexo Coze 工作流 或 智能体A lógica do processo é consistente. Por exemplo, depois de selecionar um fluxo de trabalho, o sistema reconhecerá automaticamente todos os seus parâmetros de entrada. Tudo o que o desenvolvedor precisa fazer é realizar o mesmo "mapeamento de campo" para combinar as colunas de dados correspondentes no conjunto de avaliação com esses parâmetros, uma a uma.

Revisão do fluxo de trabalho do Coze

com relação acorpo inteligentePor exemplo, a entrada principal geralmente é a pergunta do usuário inputa relação de mapeamento é mais direta.

Perspectiva prática: integração com estruturas externas

Para o uso de LangChain 或 Dify Para os desenvolvedores profissionais de aplicativos de IA criados por eles mesmos com essas estruturas de código aberto convencionais, a revisão direta de uma interface de API externa é uma maneira muito mais eficiente de trabalhar. Atualmente Coze Loop Ainda não há suporte para a avaliação direta de objetos de API, mas isso fornece uma direção para o desenvolvimento secundário da integração da plataforma ou da cadeia de ferramentas.

No ambiente de produção, podemos considerar o desenvolvimento secundário da plataforma para adicionar objetos de avaliação do tipo "API". Dessa forma, simplesmente passando o endereço da API e as informações de autenticação, qualquer serviço externo de IA pode ser conectado perfeitamente a esse sistema de avaliação avançado, de modo a obter uma avaliação unificada de toda a pilha de tecnologia. Esse modelo foi implementado em LangChain 的 LangSmith Isso já é praticado em plataformas LLMOps, como

Etapa 5: Atribuir marcadores e tarefas

Por fim, selecione o avaliador "Little Red Book Title Review" que criamos.

O sistema analisa automaticamente as três entradas necessárias para esse avaliador. Ainda fornecemos o material corretivo para ele por meio do "mapeamento de campo":

{{POST_CONTENT}}→ Fonte Comentários 的inputColuna (título).{{REFERENCE_TITLES}}→ Fonte Comentários 的reference_outputColuna (resposta padrão).{{CANDIDATE_TITLE}}→ da etapa anterior Assunto da revisão (prompt) O resultado (resposta do candidato).

Nesse ponto, foi construído um fluxo de dados claro de avaliação automatizada: o conjunto de avaliação faz perguntas → o sujeito responde às perguntas → o avaliador corrige as respostas com base nas respostas e perguntas padrão.

Interpretar o "boletim de notas" para iniciar a jornada de otimização precisa

Clique em Run Experiment e aguarde alguns instantes para que um relatório de avaliação detalhado seja gerado automaticamente.

Este relatório fornece aos desenvolvedores uma base científica para dizer adeus ao "ajuste metafísico". Ele não apenas contém pontuações quantitativas, mas também fornece motivos detalhados para cada avaliação, o que se torna o ponto de partida para obter insights sobre os recursos do modelo e conduzir iterações precisas.