- Ferramentas de diálogo de IA

- Pintura com IA

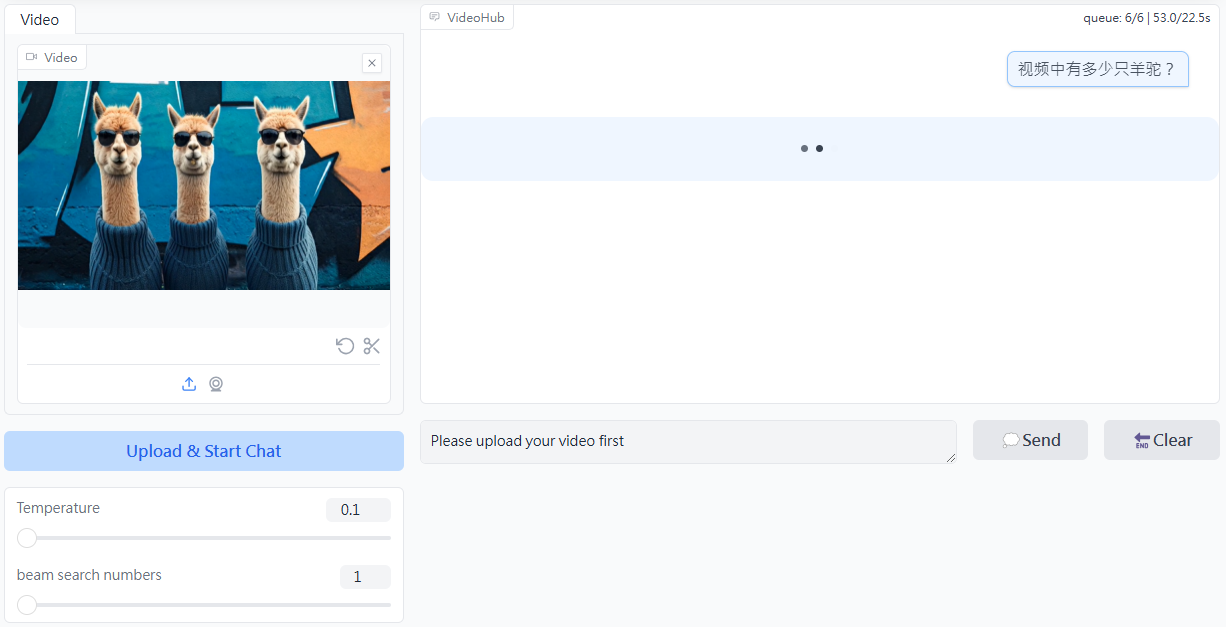

- Vídeo de IA

- Áudio de IA

- Educação e aprendizado com IA

- Produtividade da IA

- Vida e entretenimento com IA

- Aplicativos comerciais de IA

- Marketing com IA

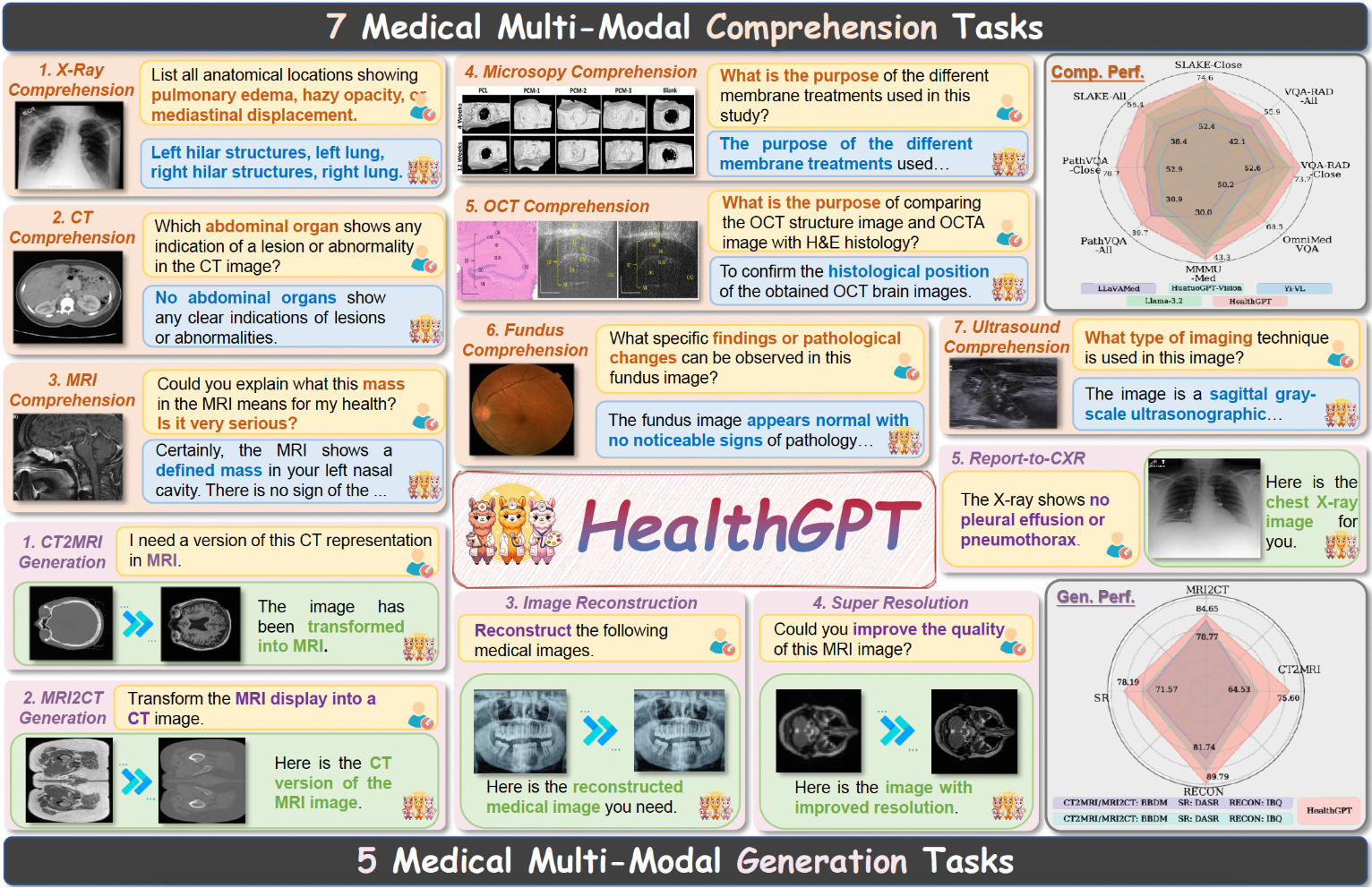

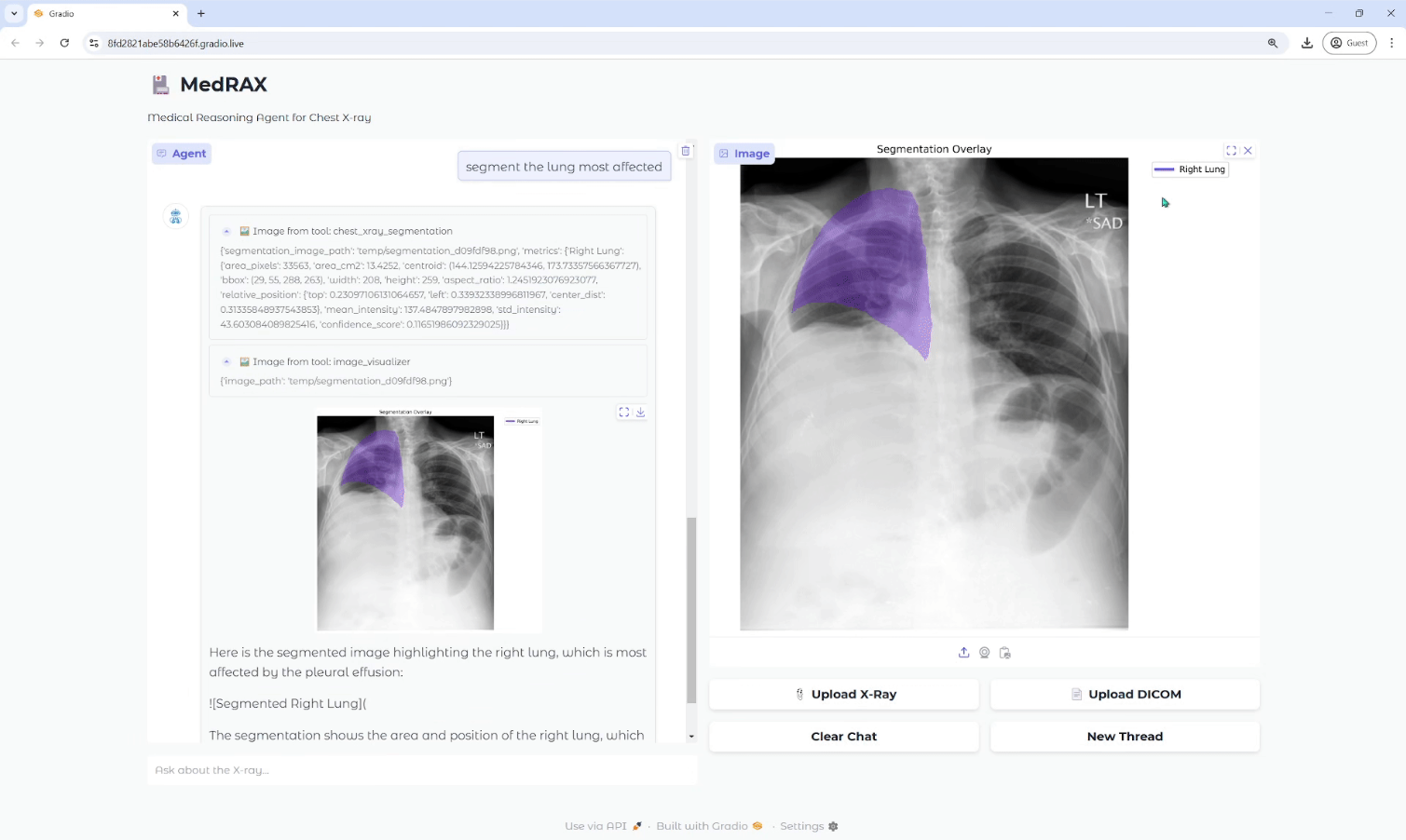

- Aplicativos profissionais de IA

- Aplicativos de base de conhecimento

- Desenvolvimento com pouco código

- RAG

- extração de dados

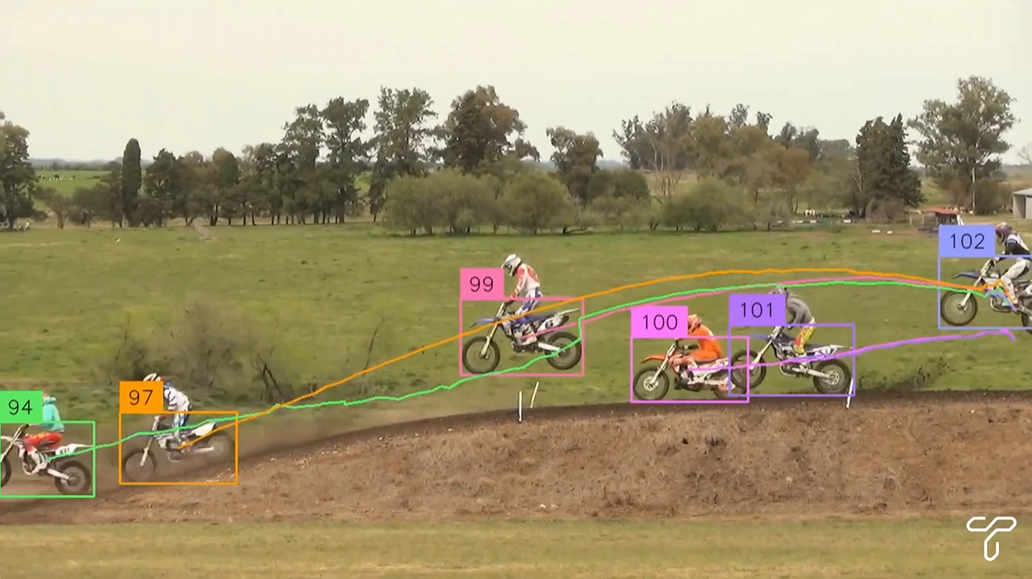

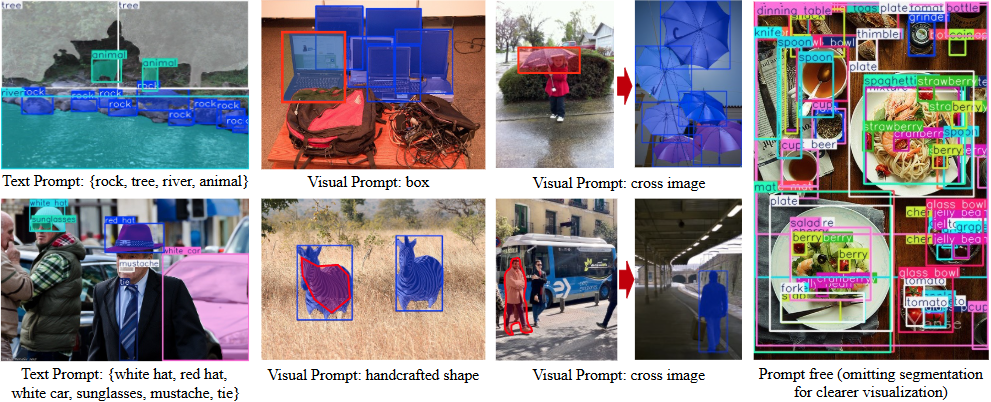

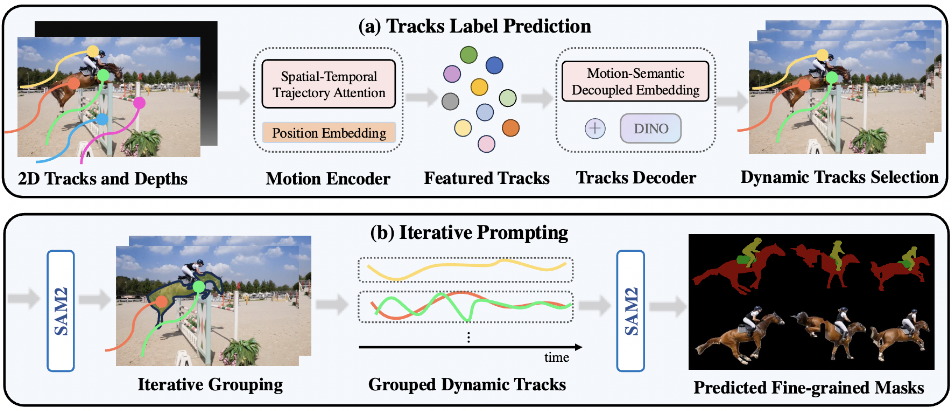

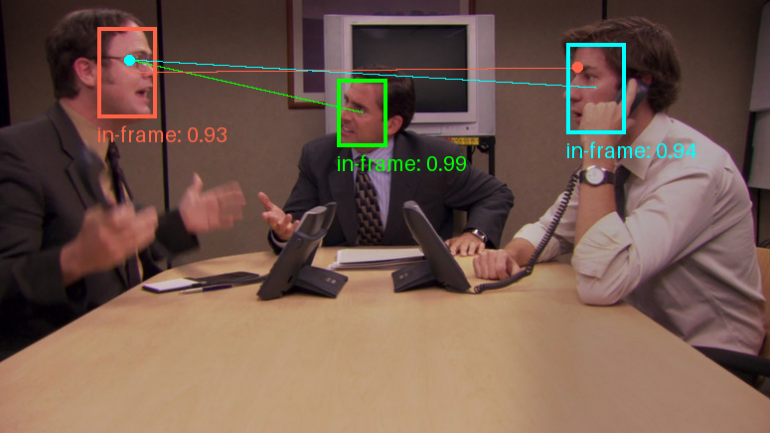

- Detecção visual de alvos

- OCR

- Aplicativos para corpos inteligentes

- Desenvolvimento do corpo inteligente

- sistema de cache de memória

- Modelagem do ajuste fino

- fluxo de trabalho

- automação de desktop

- Serviços de infraestrutura de IA

- modelo de implantação

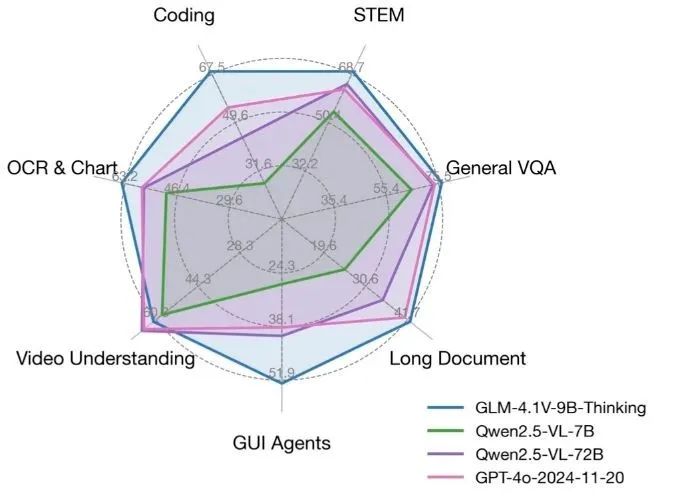

- modelo básico

- API gratuita

- Projetos paralelos