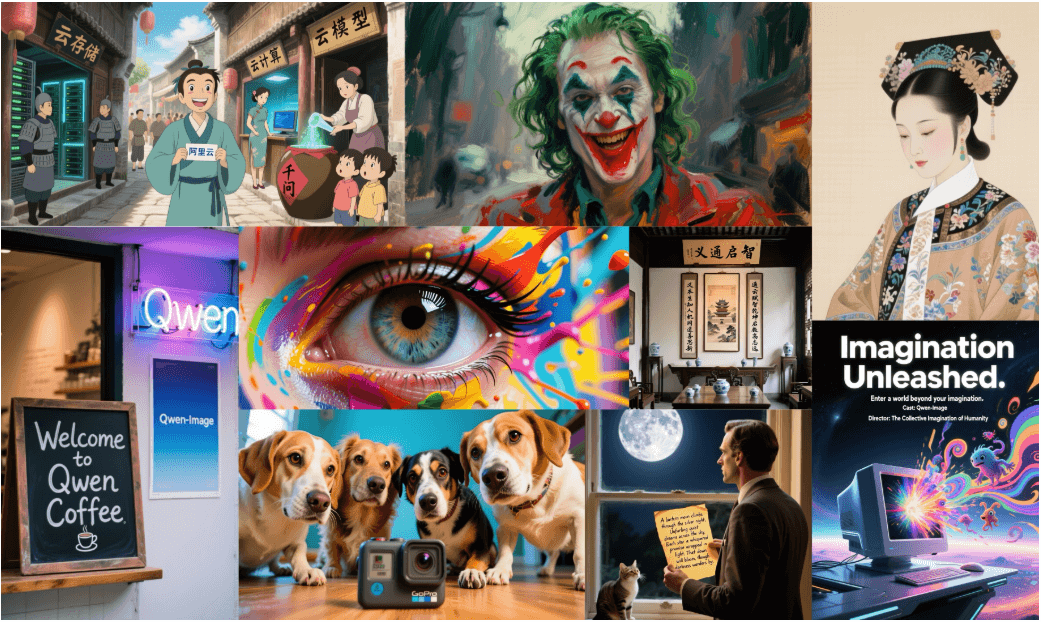

O Qwen-Image é um modelo de difusão multimodal paramétrico 20B (MMDiT) desenvolvido pela equipe do Qwen, com foco na geração de imagens de alta fidelidade e na renderização precisa de textos. Ele se destaca no processamento de textos complexos (especialmente chinês e inglês) e na edição de imagens. O modelo suporta uma ampla variedade de estilos de arte, como pôsteres realistas, de anime e HD, e pode lidar com tipografia multilíngue e cenários sensíveis ao layout. O modelo pode ser personalizado, combinando-o com ComfyUI Com a integração nativa do Qwen-Image, os usuários podem usar facilmente o Qwen-Image em seu fluxo de trabalho local para gerar conteúdo, como pôsteres de publicidade, capas de revistas ou pixel art. O modelo está disponível sob a licença Apache 2.0 e é aberto a artistas, designers e desenvolvedores.

Lista de funções

- Geração de imagens de alta fidelidade: suporte a estilos realistas, anime, pixel art e outros para gerar imagens de alta resolução.

- Renderização de textos complexos: renderize com precisão textos em vários idiomas, em inglês e chinês, mantendo a consistência tipográfica e a harmonia visual.

- Recursos de edição de imagens: suporte para conversão de estilo, adição e exclusão de objetos, modificação de texto e aprimoramento de detalhes.

- Funções de compreensão de imagens: incluindo detecção de alvos, segmentação semântica, estimativa de profundidade e super-resolução.

- Suporte a várias resoluções: 1:1, 16:9, 9:16, 4:3, 3:4 e outras proporções.

- Integração ComfyUI: é executado em fluxos de trabalho nativos e suporta operações modulares e fluxos de trabalho personalizados.

- Otimização de prompts: aprimoramento de prompts multilíngues com o Qwen-Plus para melhorar a qualidade da geração.

- Suporte multiplataforma: compatível com Hugging Face, ModelScope, WaveSpeedAI e LiblibAI.

Usando a Ajuda

Processo de instalação

Para usar o Qwen-Image no ComfyUI, conclua as seguintes etapas de instalação:

- Faça o download ou atualize o ComfyUI:

Visite o site da ComfyUI (https://www.comfy.org/download) para fazer o download da versão mais recente ou atualizar uma instalação existente. Certifique-se de que o Python 3.8 ou posterior esteja instalado em seu sistema. - Instalação de dependências:

Instale as bibliotecas Python necessárias, incluindodiffuserse PyTorch:pip install git+https://github.com/huggingface/diffusers pip install torch torchvision

Se estiver usando uma GPU, é recomendável instalar o PyTorch com suporte a CUDA para melhorar o desempenho.

- Obtendo o modelo Qwen-Image:

Depois de selecionar o fluxo de trabalho Qwen-Image no ComfyUI, você será automaticamente solicitado a baixar os pesos do modelo (Qwen/Qwen-Image). Ele também pode ser baixado manualmente do Hugging Face ou do ModelScope. - Ambiente de configuração:

Para garantir o suporte de hardware, recomendamos o uso de uma GPU de alto desempenho, como a RTX 4090D (24 GB de RAM). É possível executar a CPU, mas mais lentamente.

Usando o Qwen-Image no ComfyUI

A ComfyUI fornece um fluxo de trabalho modular que é adequado para executar o Qwen-Image localmente:

- Iniciar o ComfyUI:

Execute o aplicativo ComfyUI para entrar na tela principal. - Carregando o fluxo de trabalho do Qwen-Image:

- Navegue até

Workflow→Browse Templates→Image。 - Selecione o fluxo de trabalho "Qwen-Image" ou faça o download do arquivo de fluxo de trabalho em https://blog.comfy.org/p/qwen-image-in-comfyui-new-era-of.

- Depois de carregar o fluxo de trabalho, o ComfyUI configura automaticamente o modelo e os parâmetros.

- Navegue até

- Definição de pistas:

Digite uma palavra de prompt de texto detalhada, por exemplo:A realistic vintage TV news broadcast scene from the 1980s, displayed on an old CRT television with rounded screen edges, static noise, and scanlines. The screen shows a breaking news segment with a lower-third banner that reads: "Breaking: ComfyUI just supported Qwen-Image".Recomenda-se adicionar dicas positivas para otimizar os resultados:

Ultra HD, 4K, cinematic composition - Ajuste dos parâmetros de geração:

- resolução (de uma foto)Selecione 16:9 (1664 x 928) ou outra proporção suportada.

- etapa de inferência: 50 etapas são recomendadas para equilibrar qualidade e velocidade.

- Escala CFGAjuste para 4,0 para garantir que a imagem seja altamente relevante para a palavra-chave.

- semente aleatóriaSemente de fixação: Defina a semente de fixação (por exemplo, 42) para garantir resultados reproduzíveis.

- Geração de imagens:

strike (no teclado)Runo ComfyUI chamará o Qwen-Image para gerar uma imagem. O resultado pode ser salvo como um arquivo PNG.

Otimização de palavras-chave

Para melhorar a qualidade da geração, pode ser usada a ferramenta de aprimoramento de palavras prontas do Qwen-Plus:

- integração de código:

from tools.prompt_utils import rewrite prompt = rewrite(prompt) # 优化提示词 - operação de linha de comando:

configurarDASHSCOPE_API_KEYApós a corrida:cd src DASHSCOPE_API_KEY=sk-xxxxxxxxxxxxxxxxxxxx python examples/generate_w_prompt_enhance.py

Operação de funções avançadas

- renderização de texto:

A Qwen-Image se destaca na renderização de texto em vários idiomas e é adequada para gerar pôsteres, capas de revistas e muito mais. Por exemplo, gerar uma capa de revista de moda:A high-fashion magazine cover inspired by Vogue. Stylish model in avant-garde outfit, dramatic pose, soft studio lighting. Elegant layout with English headlines: "THE BOLD ISSUE — Confidence is the New Couture", "100 LOOKS THAT DEFINE TOMORROW".O modelo garantirá que as fontes e a tipografia do texto se misturem naturalmente com o plano de fundo.

- edição de imagens:

Os próximos recursos de edição suportam conversão de estilo, adição e exclusão de objetos e modificação de texto. Por exemplo, um fundo de foto pode ser substituído por um estilo de pixel art ou novos objetos podem ser adicionados a uma imagem. - compreensão gráfica:

O Qwen-Image oferece suporte a tarefas como detecção de alvos e segmentação semântica. Por exemplo, ele pode ser usado para analisar a posição de um objeto em uma imagem ou para segmentar uma região, cuja operação específica terá que aguardar a atualização da documentação oficial.

Implementação e otimização

Se você precisar implementar serviços com várias GPUs para dar suporte à alta simultaneidade:

- Configurar variáveis de ambiente:

export NUM_GPUS_TO_USE=4 export TASK_QUEUE_SIZE=100 export TASK_TIMEOUT=300 - Inicie o servidor Gradio:

cd src DASHSCOPE_API_KEY=sk-xxxxxxxxxxxxxxxxx python examples/demo.pyO acesso à interface da Web do Gradio está disponível por meio de seu navegador.

Suporte à comunidade

- Hugging Face: Suporte

diffusersOs recursos de fluxo de trabalho, LoRA e ajuste fino serão lançados em breve. - ModelScopeSuporte a inferência com pouca memória (4 GB de VRAM), quantificação FP8 e treinamento LoRA.

- WaveSpeedAI e LiblibAIOferece experiência on-line, visite o site para obter detalhes.

- Documentação da ComfyUI: Visite o site https://docs.comfy.org/tutorials/image/qwen/qwen-image para obter mais tutoriais.

cenário do aplicativo

- design de publicidade

Gere pôsteres ou outdoors contendo texto de marca, com texto e imagens perfeitamente combinados.

Por exemplo, gere um outdoor em um telhado da cidade que diga "ComfyUI is built with love". - arte

Os artistas podem gerar imagens em diversos estilos, como pixel art ou capas de alta costura para ilustração ou arte digital.

Por exemplo, crie uma interface de jogo no estilo pixel de 16 bits. - Educação e pesquisa

Detecção de alvos ou segmentação semântica usando funções de compreensão de imagens para ajudar na pesquisa acadêmica.

Por exemplo, analisar o layout da mercadoria em um cenário de varejo. - Conteúdo de marketing

Crie apresentações de slides profissionais de marketing ou material de publicidade em vídeo com suporte para texto multilíngue e tipografia elegante.

Por exemplo, crie uma apresentação de slides sobre a marca do leite com títulos e elementos visuais.

QA

- Como o Qwen-Image funciona na ComfyUI?

O modelo Qwen-Image é carregado por meio do fluxo de trabalho modular da ComfyUI, os prompts e parâmetros são definidos e a imagem é gerada. - Quais idiomas de texto são suportados?

Suporte para chinês, inglês e outros idiomas, a renderização em chinês é particularmente precisa, adequada para tipografias complexas. - Quais são os requisitos de hardware?

Recomenda-se a RTX 4090D (24 GB de RAM); as CPUs podem executá-la, mas é mais lenta; o ModelScope oferece suporte à otimização de baixa RAM. - Como posso participar da revisão do modelo?

Visite o site oficial do AI Arena para participar da comparação de geração de imagens ou entre em contato com weiyue.wy@alibaba-inc.com para implantar o modelo.