O surgimento da estrutura Ollama certamente atraiu muita atenção no campo da inteligência artificial e dos modelos de linguagem ampla (LLMs). Essa estrutura de código aberto se concentra em simplificar a implementação e a operação de LLMs localmente, facilitando a experiência de mais desenvolvedores com o apelo dos LLMs. No entanto, ao analisar o mercado, o Ollama não está sozinho, e há muitas outras ferramentas do mesmo tipo que surgiram e que, juntas, oferecem aos desenvolvedores opções mais diversificadas. Neste artigo, daremos uma olhada detalhada em algumas das ferramentas que funcionam com Ollama Espera-se que várias ferramentas de estrutura de modelos grandes como essas ajudem os leitores a obter uma compreensão mais abrangente do ecossistema tecnológico nessa área e a encontrar a ferramenta mais adequada para eles.

Introdução à estrutura de Ollama

O Ollama foi projetado para simplificar a implantação e a operação de modelos de linguagem grandes (LLMs) em ambientes locais. Ele oferece suporte a uma ampla variedade de LLMs convencionais, como Llama 2, Code Llama, Mistral, Gemma etc., e permite que os usuários personalizem e criem seus próprios modelos de acordo com suas necessidades. ChatGPT A interface de bate-papo permite que os usuários interajam diretamente com o modelo sem desenvolvimento adicional. Além disso, o código limpo do Ollama e o baixo uso de recursos de tempo de execução o tornam ideal para ser executado em um computador local.

Ferramentas semelhantes ao Ollama

Introdução ao vLLM

vLLM O VLLM (Vectorised Large Language Model Serving System) é um mecanismo eficiente de serviço e inferência de modelos grandes, adaptado para LLM. O vLLM melhora significativamente o desempenho da inferência LLM por meio da inovadora tecnologia PagedAttention, do processamento contínuo em lote, da otimização do núcleo CUDA e do suporte à inferência distribuída. O vLLM melhora significativamente o desempenho da inferência LLM por meio da inovadora tecnologia PagedAttention, do processamento contínuo de lotes, da otimização do núcleo CUDA e do suporte ao raciocínio distribuído.

especificidades

vLLM O vLLM é compatível com uma variedade de formatos de modelos, incluindo PyTorch, TensorFlow etc., facilitando a escolha flexível dos usuários de acordo com suas necessidades. Ao mesmo tempo, o vLLM também tem um mecanismo de inferência de alto desempenho que suporta inferência on-line e inferência em lote, e é capaz de responder rapidamente a um grande número de solicitações simultâneas, além de ter um bom desempenho em cenários de alta carga.

Introdução ao LightLLM

LightLLM é uma estrutura de serviço e raciocínio LLM leve e de alto desempenho baseada em Python. Ele se baseia nos pontos fortes de várias implementações de código aberto, como FasterTransformer, TGI, vLLM e FlashAttention, e oferece aos usuários um novo modelo de serviço LLM.

especificidades

LightLLM A arquitetura exclusiva de três processos desacopla as três principais etapas de tokenização, inferência de modelo e destokenização, e as executa em paralelo por meio de um mecanismo de colaboração assíncrona. Esse design melhora significativamente a utilização da GPU e reduz a latência causada pela transmissão de dados, melhorando efetivamente a eficiência da inferência. Além disso, o LightLLM é compatível com a operação Nopad no-fill, que pode lidar com solicitações com grandes diferenças de comprimento de forma mais eficiente e evitar o preenchimento inválido, melhorando assim a utilização de recursos.

Introdução ao llama.cpp

llama.cpp é um mecanismo de inferência LLM desenvolvido em C e C++. Ele foi profundamente otimizado em termos de desempenho para o chip de silício da Apple e é capaz de executar com eficiência o modelo Llama 2 do Meta em dispositivos Apple.

especificidades

O principal objetivo do llama.cpp é implementar a inferência LLM em uma ampla variedade de plataformas de hardware, proporcionando desempenho superior com configuração mínima. Para melhorar ainda mais o desempenho, o llama.cpp oferece uma variedade de opções de quantização, como quantização de inteiros de 1,5 bits, 2 bits, 3 bits, 4 bits, 5 bits, 6 bits e 8 bits, projetadas para acelerar a inferência e reduzir o espaço ocupado na memória. Além disso, o llama.cpp oferece suporte à inferência mista de CPU/GPU, aumentando ainda mais a flexibilidade e a eficiência da inferência.

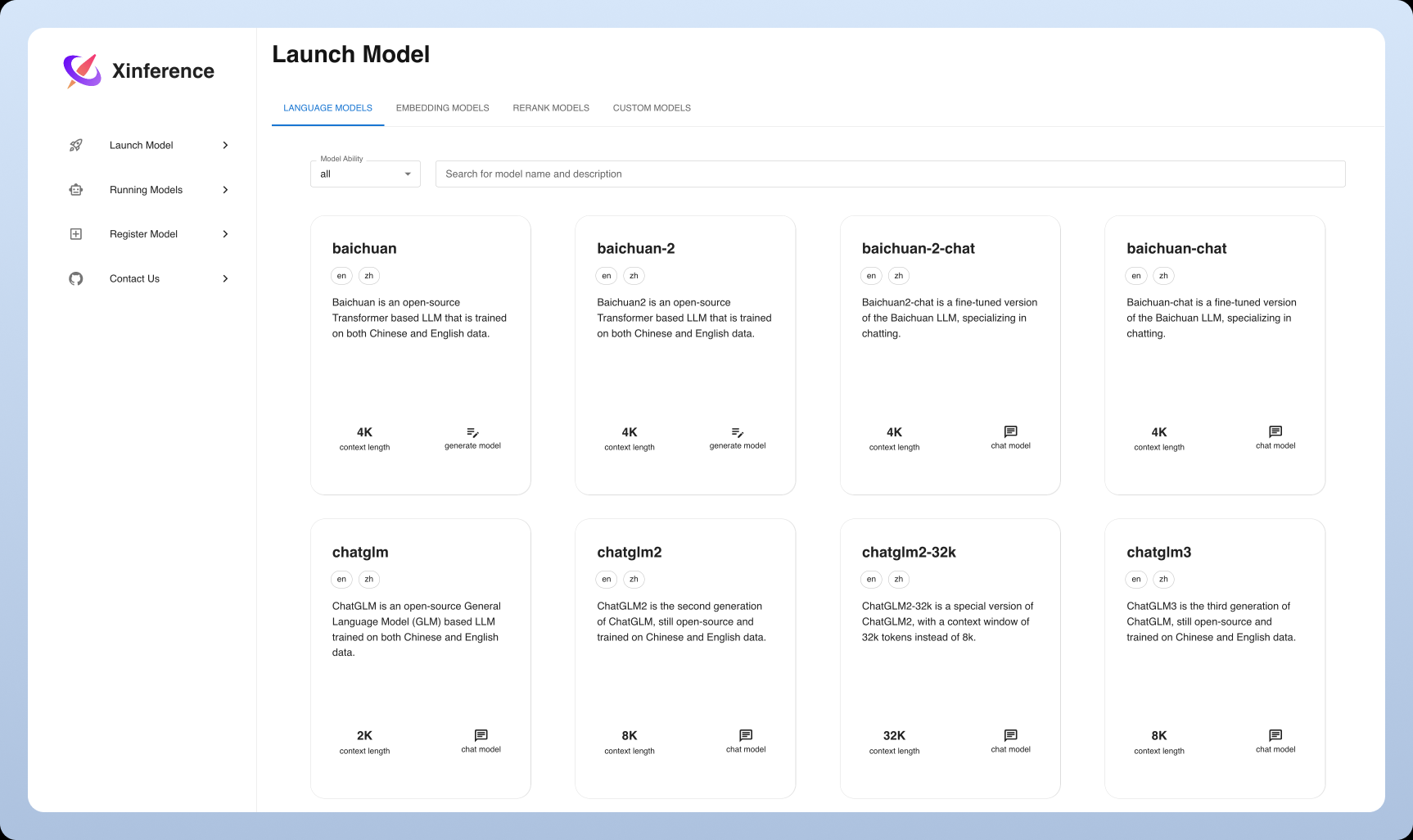

Introdução à Xinference

Xinference é uma estrutura emergente de inferência de uso geral que suporta não apenas LLM, mas também modelos em uma variedade de modalidades, incluindo imagem e fala. Seu objetivo é reduzir o limite de implantação e uso do modelo, fornecer uma interface unificada e uma experiência de usuário amigável.

especificidades

Xinference O destaque do Xinference é seu amplo suporte a modelos multimodais, que permite aos usuários implementar e experimentar facilmente diferentes tipos de modelos na mesma plataforma. Ao mesmo tempo, o Xinference se concentra na facilidade de uso, oferecendo uma variedade de métodos de interação, como UI da Web, cliente Python, etc., e oferecendo suporte ao gerenciamento unificado e à expansão flexível de modelos.

Comparação e análise de ferramentas

Instalação e implementação

Ollama: O processo de instalação é extremamente fácil. O Ollama fornece um guia de instalação claro e conciso e é compatível com muitos dos principais sistemas operacionais. Os usuários podem facilmente colocar um grande modelo de linguagem em funcionamento com apenas algumas ações simples de linha de comando.

vLLM: Em contrapartida, a instalação do vLLM é um pouco mais complicada, exigindo que o usuárioantecipadamenteConfigurar o ambiente Python e instalar um conjunto de bibliotecas de dependência. No entanto, uma vez implantado, o desempenho eficiente da inferência do vLLM dará aos usuários um impulso significativo, especialmente em cenários de desempenho crítico.

LightLLM: O processo de instalação do LightLLM é relativamente fácil de usar, e guias detalhados de instalação e configuração são fornecidos para orientar os usuários a começar rapidamente. Os usuários podem escolher com flexibilidade o formato de modelo apropriado para a implementação de acordo com suas necessidades.

llama.cpp: A implementação do llama.cpp requer um certo nível de conhecimento técnico, e o usuário precisa ter oinoportunoConfigurar o ambiente de desenvolvimento C++. No entanto, para os entusiastas e desenvolvedores de tecnologia, uma vez configurado, o mecanismo de inferência de alto desempenho do llama.cpp oferece a melhor experiência de usuário, com controle profundo sobre todos os aspectos da inferência do modelo.

Xinference: O Xinference também é relativamente fácil de instalar e implantar, fornecendo imagens do Docker, pacotes Python e outros métodos de instalação, facilitando aos usuários a configuração rápida de seus ambientes. Ao mesmo tempo, o Xinference também oferece uma interface de IU da Web abrangente, que reduz o limite de uso.

Suporte e compatibilidade de modelos

Ollama: Em termos de suporte a modelos, o Ollama demonstra boa abertura, oferecendo suporte a muitos modelos de código aberto, incluindo Llama 2, Code Llama, etc., e permitindo que os usuários façam upload de modelos personalizados. Além disso, o Ollama oferece uma biblioteca de modelos pré-construídos para que os usuários comecem a usar rapidamente vários modelos.

vLLM: O vLLM é excelente em termos de compatibilidade de formato de modelo, suportando PyTorch, TensorFlow e muitos outros formatos de modelo importantes.viável O usuário pode escolher uma seleção flexível de modelos. Vale a pena mencionar que o vLLM também oferece suporte à inferência distribuída, que pode fazer uso total do poder aritmético de várias GPUs e executar modelos em paralelo para melhorar ainda mais a eficiência da inferência.

LightLLM: O LightLLM também tem excelente compatibilidade de formato de modelo, suportando uma variedade de formatos de modelo comumente usados. Ao mesmo tempo, o LightLLM oferece APIs e ferramentas avançadas para facilitar a personalização detalhada e atender às necessidades de uma ampla gama de usuários.especialA necessidade de cenários de aplicativos.

llama.cpp: O llama.cpp se concentra na otimização do modelo Llama para inferência extrema, mas também oferece suporte a outros modelos. Seu eficiente mecanismo de inferência permite que o llama.cpp mantenha um excelente desempenho ao lidar com grandes conjuntos de dados.

Xinference: Um dos destaques do Xinference é seu suporte a modelos, que não apenas suporta vários LLMs, mas também modelos de geração de imagens, como Stable Diffusion e Whisper e outros modelos de fala, demonstrando uma forte compatibilidade de modelos multimodais e oferecendo aos usuários um espaço de aplicação mais amplo.

Desempenho e otimização

Ollama: O Ollama é conhecido por sua API limpa e desempenho de inferência eficiente, mas pode haver gargalos de desempenho em cenários com grande número de solicitações simultâneas. O Ollama ainda é uma boa opção para usuários que buscam facilidade de uso e implantação rápida.

vLLM: O vLLM foi desenvolvido para desempenho extremo. Ele melhora significativamente o desempenho do raciocínio do LLM por meio de técnicas como o PagedAttention, especialmente ao lidar com um grande número de solicitações simultâneas, e é capaz de satisfazer cenários de aplicativos com requisitos rigorosos de desempenho de serviço.

LightLLM: O LightLLM também se esforça muito para otimizar o desempenho. Graças à sua arquitetura exclusiva de três processos e ao mecanismo de colaboração assíncrona, o LightLLM melhora efetivamente a utilização da GPU e a velocidade de inferência. Além disso, o LightLLM é compatível com a operação Nopad no-fill, o que melhora ainda mais a utilização dos recursos. Contribui para o desempenho geral。

llama.cpp: O llama.cpp também se destaca em termos de desempenho. Além de ter um mecanismo de inferência eficiente, ele também oferece uma variedade de opções de quantização que permitem flexibilidade entre a velocidade de inferência e o uso da memóriaequilíbrioO raciocínio do llama.cpp é baseado no raciocínio híbrido CPU/GPU. Além disso, o llama.cpp também oferece suporte à inferência mista CPU/GPU, o que aumenta ainda mais a flexibilidade e a eficiência da inferência, permitindo que os usuários executem omelhor (atleta, filme etc.)Configuração.

Xinference: O Xinference também é otimizado quanto ao desempenho, oferecendo suporte a técnicas como quantificação e poda de modelos para melhorar a eficiência da inferência e reduzir o consumo de recursos. Além disso, o Xinference também é otimizado iterativamente para melhorar o desempenho da inferência de modelos multimodais.

Resumo e perspectivas

Ferramentas semelhantes ao Ollama têm seus próprios recursos e vantagens, e os usuários podem escolher a estrutura certa de acordo com os cenários de aplicação e as necessidades reais. Com o desenvolvimento contínuo da inteligência artificial e da tecnologia de modelagem de linguagem em larga escala, essas ferramentas continuarão a ser aprimoradas e atualizadas, oferecendo aos usuários soluções mais eficientes e convenientes. Olhando para o futuro, essas ferramentas desempenharão um papel mais importante no processamento de linguagem natural, no atendimento inteligente ao cliente, na geração de texto e em outros campos, promovendo ainda mais o desenvolvimento e a aplicação da tecnologia de inteligência artificial e, em última análiseperceber Uma bela visão da Inteligência Artificial para todos.

Recomendações e sugestões

O Ollama pode ser uma boa opção para usuários iniciantes e individuais. O Ollama oferece uma API simples e uma interface de usuário amigável, o que permite que os usuários interajam diretamente com os modelos sem desenvolvimento adicional. Além disso, o Ollama oferece suporte a uma ampla gama de modelos de código aberto, o que facilita aos usuários começar a usar e experimentar rapidamente vários cenários de aplicativos, além de experimentar rapidamente a diversão de implantar o LLM localmente.

Para usuários corporativos que precisam lidar com solicitações altamente simultâneas, o vLLM pode ser a melhor opção. O desempenho eficiente do raciocínio e o suporte ao raciocínio distribuído do vLLM podem atender às demandas de cenários altamente simultâneos e oferecer aos usuários uma solução mais estável e confiável para garantir a continuidade dos negócios.Estabilidade e continuidade。

O LightLLM e o llama.cpp são mais adequados para usuários com uma certa base técnica para desenvolvimento personalizado e otimização profunda. Essas duas ferramentas oferecem aos desenvolvedores maior flexibilidade e mais controle sobre o permissível O usuário é responsável pelaespecificação Crie aplicativos LLM mais personalizados e de alto desempenho.

O Xinference também é uma opção para aqueles que desejam fazer experiências com modelos multimodais e estão procurando uma experiência pronta para uso. O Xinference reduz as barreiras ao uso de modelos multimodais, permitindo que os usuários experimentem o poder de uma ampla variedade de modelos de IA em uma única plataforma.