Às 2h da manhã de hoje, os 12 dias de transmissão ao vivo da OpenAI finalmente chegaram ao seu capítulo final: o openAI o3 foi lançado oficialmente!

O o3 é o sucessor da família de modelos o1. Esse tipo de modelo é caracterizado por permitir que o modelo passe mais tempo pensando (raciocinando) antes de responder a uma pergunta, aumentando assim a precisão da resposta. De acordo com o The Information, isso foi feito para evitar problemas de direitos autorais, já que existe uma empresa de telecomunicações no Reino Unido chamada O2, o que poderia causar confusão. sam Altman confirmou isso em uma transmissão ao vivo nesta tarde.

Na verdade, a OpenAI está aquecendo o modelo desde ontem. E os desenvolvedores já encontraram referências ao o3_min_safety_test no site da OpenAI.

o3 Data de lançamento

Agora, conforme os rumores, a o3 e a o3-mini Aqui vamos nós! Infelizmente, os modelos da série o3 não serão lançados diretamente para o público, mas serão testados primeiro quanto à segurança. sam Altman também destacou que hoje não é um lançamento, apenas um anúncio.

Sam Altman mencionou que eles planejam lançar o o3-mini por volta do final de janeiro e o modelo completo do o3 logo em seguida.

Diferenças entre o3 e o3-mini

o3-mini: o o3 mini é uma versão mais econômica do o3, com foco no aumento da velocidade de inferência e na redução do custo de inferência, levando em conta o desempenho do modelo. O alto desempenho e o baixo custo o tornam ideal para programação.

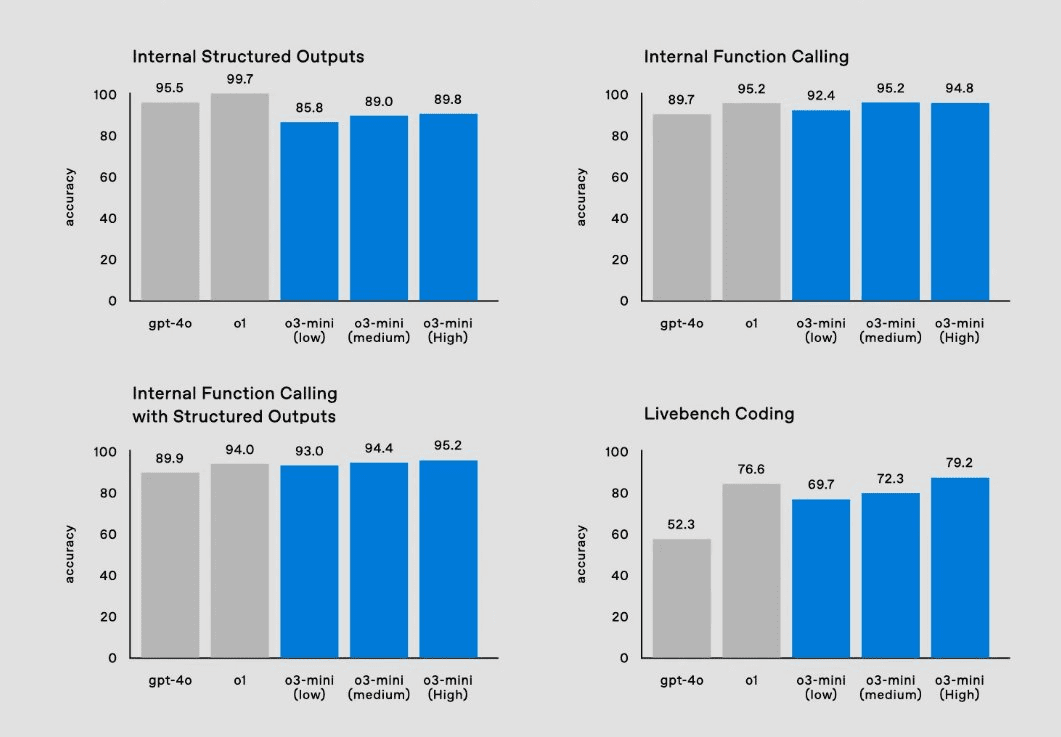

Ele suporta três opções diferentes de tempo de inferência: baixo, médio e alto.

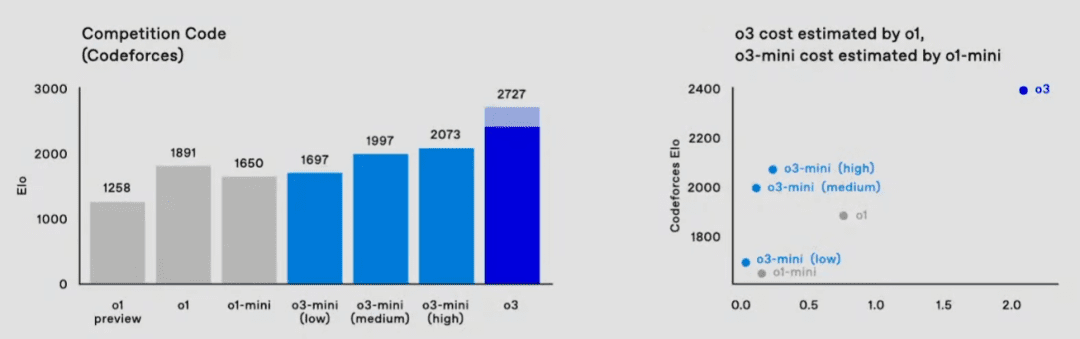

Em comparação com o o1, o desempenho do o3-mini no Codeforces é notavelmente econômico, o que o torna um excelente modelo para uso em programação.

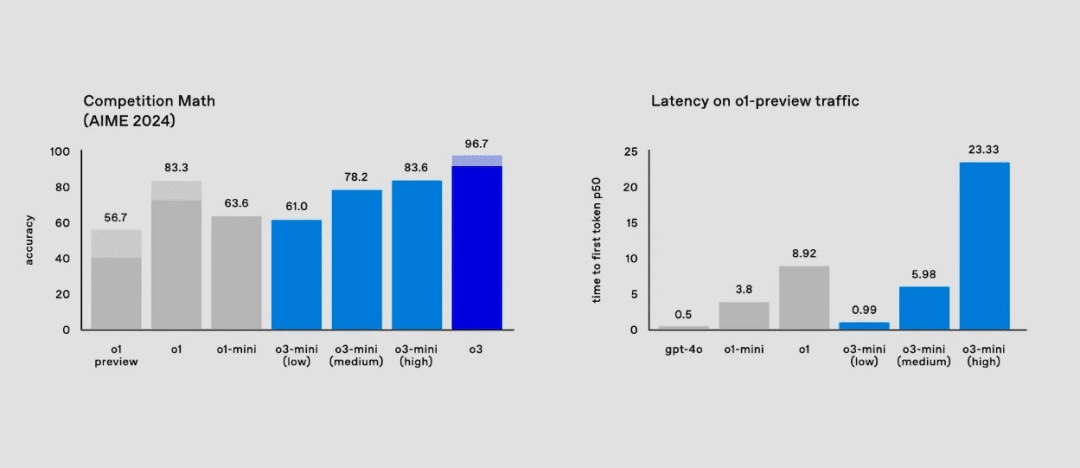

Para problemas matemáticos, o o3-mini (low) atinge uma latência baixa comparável ao gpt-4o.

Todos os recursos da API no o3-mini e seus respectivos recursos estão listados abaixo:

o3 Testes de aptidão

Qual é a força do o3, em comparação com o recém-lançado GoogleGemini 2.0 Flash ThinkingCompare:

A capacidade do o3 é um golpe direto e descendente em quase todos os modelos atuais. Dê uma olhada no que o o3 é capaz de fazer.

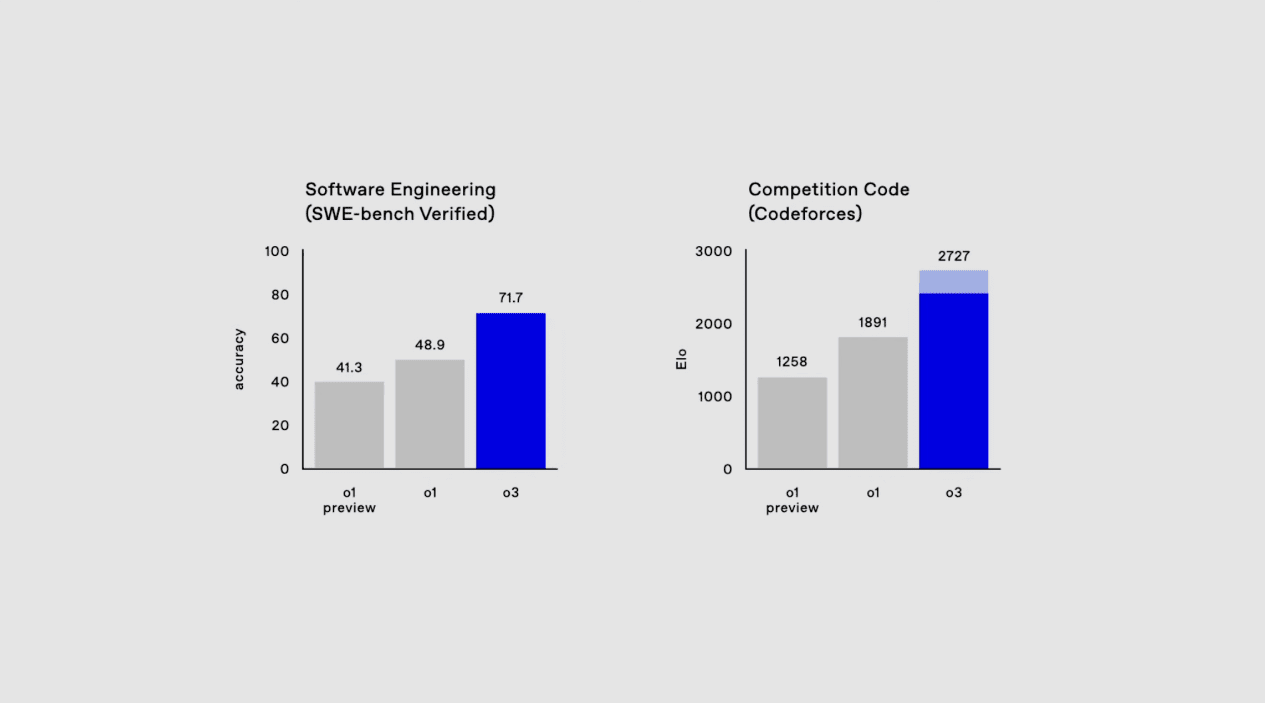

À esquerda.Exame de Engenharia de Software (SWE-Bench Verified).Isso é como um teste para escrever programas, por exemplo, você escreve um software para ser rápido e preciso, e não pode haver bugs (pequenos erros). O objetivo é verificar se o o3 consegue escrever um código perfeito como um engenheiro de software de primeira classe. Pontuação do o3: 71,7%, que ainda é muito superior ao o1. O benchmark à direita é um pouco mais agressivo, o Codeforces, uma plataforma de competição de codificação de renome mundial. A pontuação do o3 é de 2.727, o que, equivalente ao 175º lugar em toda a lista, já ultrapassou os 99,99% dos seres humanos.

A capacidade do o1 de codificar foi explosiva, e o o3, outro grande passo em direção ao topo da montanha da AGI.

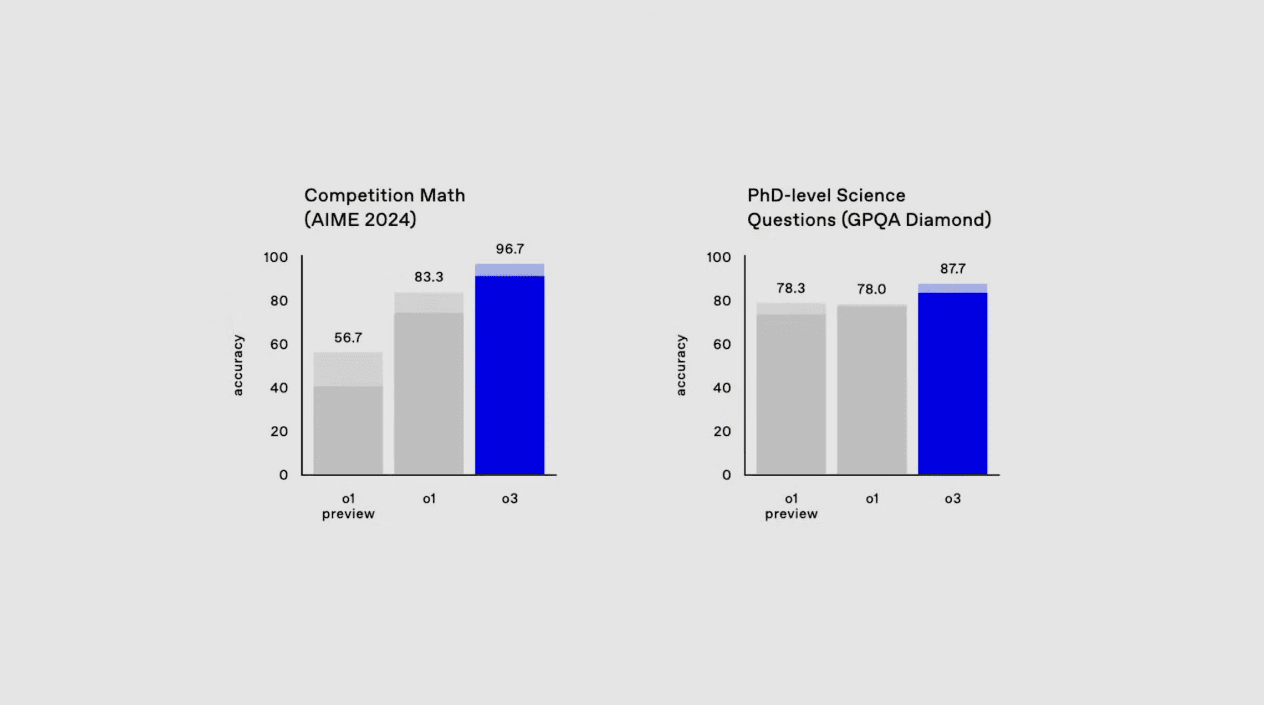

O concurso de matemática AIEM 2024 e o exame de ciências de nível de doutorado GPQA Diamond. O AIEM 2024 ficou próximo de uma pontuação perfeita e, se bem me lembro, seria a primeira vez que uma IA conseguiu atingir um nível em que houve um AIEM próximo de uma pontuação perfeita. Os exames de ciências em nível de doutorado evoluíram, mas não tão violentamente quanto os de matemática e programação.

O concurso de matemática AIEM 2024 e o exame de ciências de nível de doutorado GPQA Diamond. O AIEM 2024 ficou próximo de uma pontuação perfeita e, se bem me lembro, seria a primeira vez que uma IA conseguiu atingir um nível em que houve um AIEM próximo de uma pontuação perfeita. Os exames de ciências em nível de doutorado evoluíram, mas não tão violentamente quanto os de matemática e programação.

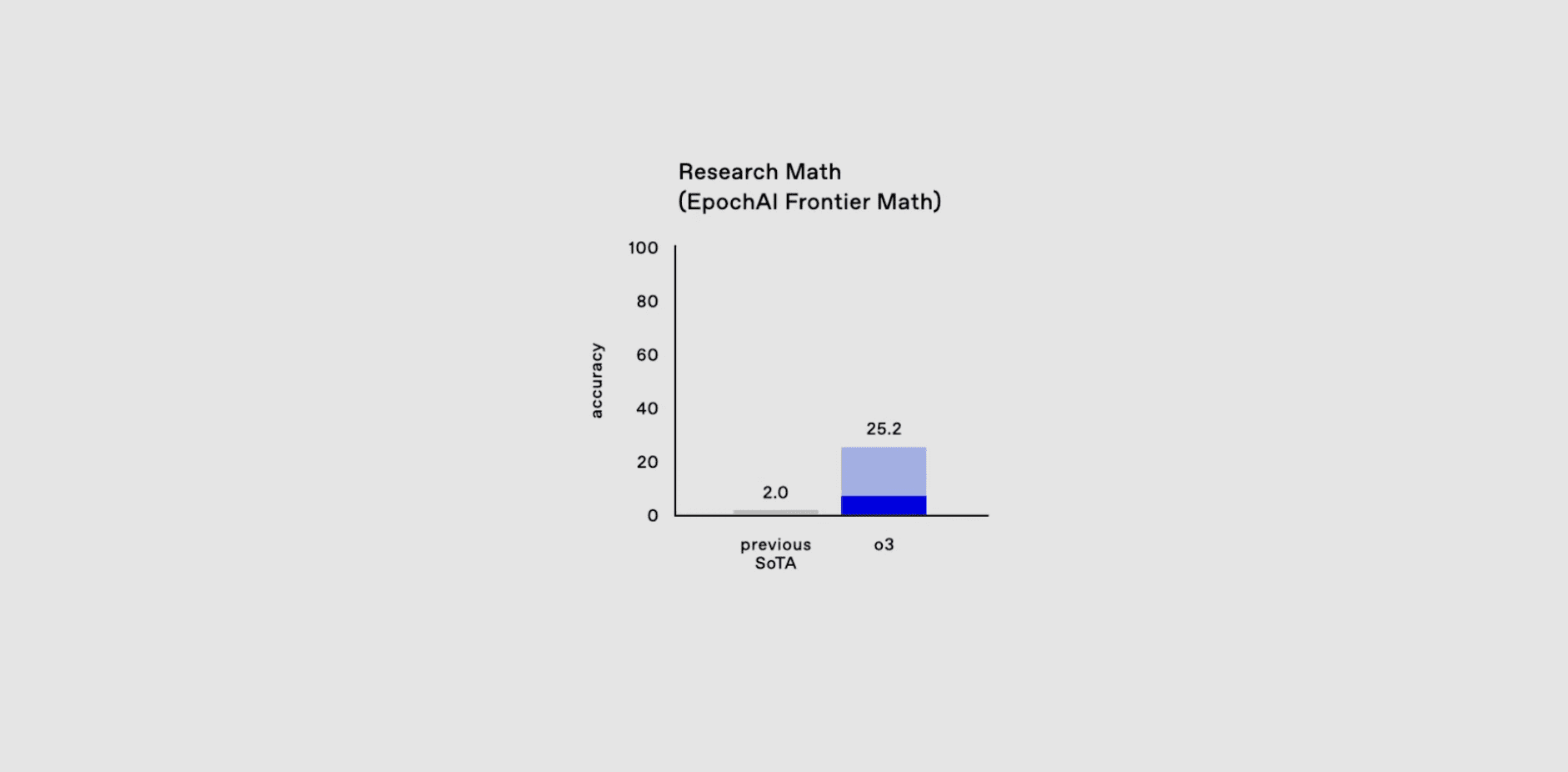

O próximo benchmark de matemática é um pouco mais interessante.  O rontierMath, um teste de benchmark de matemática desenvolvido pela Epoch AI, foi desenvolvido por uma colaboração de mais de 60 matemáticos importantes para avaliar a capacidade da IA em raciocínio matemático avançado. E para evitar a contaminação de dados, todas as perguntas são originais e novas que nunca foram lançadas antes.

O rontierMath, um teste de benchmark de matemática desenvolvido pela Epoch AI, foi desenvolvido por uma colaboração de mais de 60 matemáticos importantes para avaliar a capacidade da IA em raciocínio matemático avançado. E para evitar a contaminação de dados, todas as perguntas são originais e novas que nunca foram lançadas antes.

Anteriormente, GPT-4 e Gemini 1.5 Pro Este modelo vai para uma avaliação com menos de 21 TP3T de potência bem-sucedida, em contraste com a taxa de sucesso de mais de 901 TP3T em outros benchmarks matemáticos tradicionais, como GSM-8K e MATH. E desta vez.o3 diretamente para 25,2. Enquanto todos os outros modelos principais ainda estão rodando benchmarks matemáticos tradicionais, o o3 realmente entrou em outro mundo.

o3 se torna o primeiro modelo de IA a quebrar os padrões de referência do ARC-AGI

A ARC Prize Fundation é uma organização sem fins lucrativos que tem como objetivo "ser a Estrela do Norte no caminho para a AGI por meio de benchmarking". O primeiro benchmark da organização, o ARC-AGI, foi proposto há cinco anos, mas ainda não foi conquistado.

Até o momento, a Kamradt anunciou que o o3 alcançou níveis excelentes no benchmark, tornando-se o primeiro modelo de IA a quebrar o benchmark ARC-AGI.

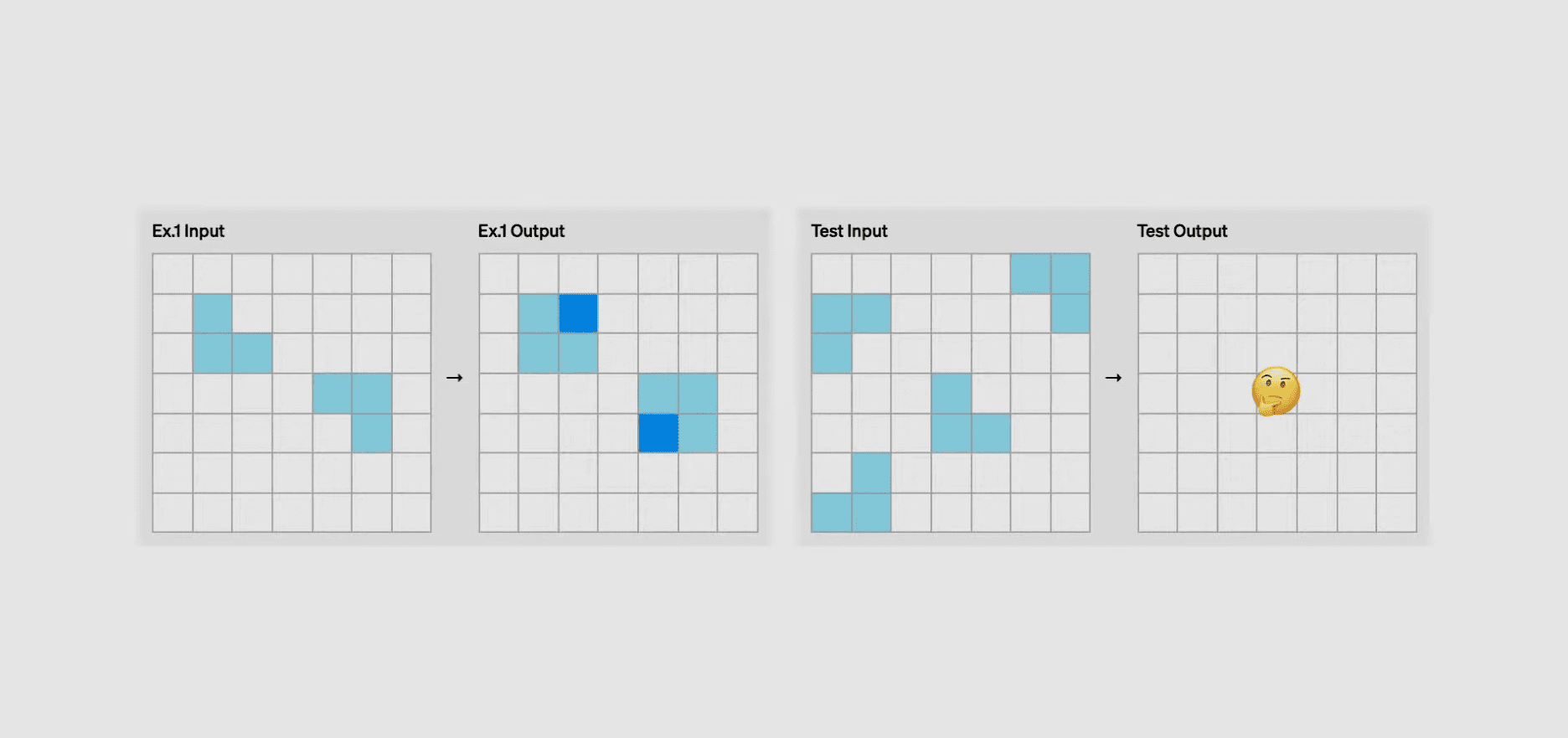

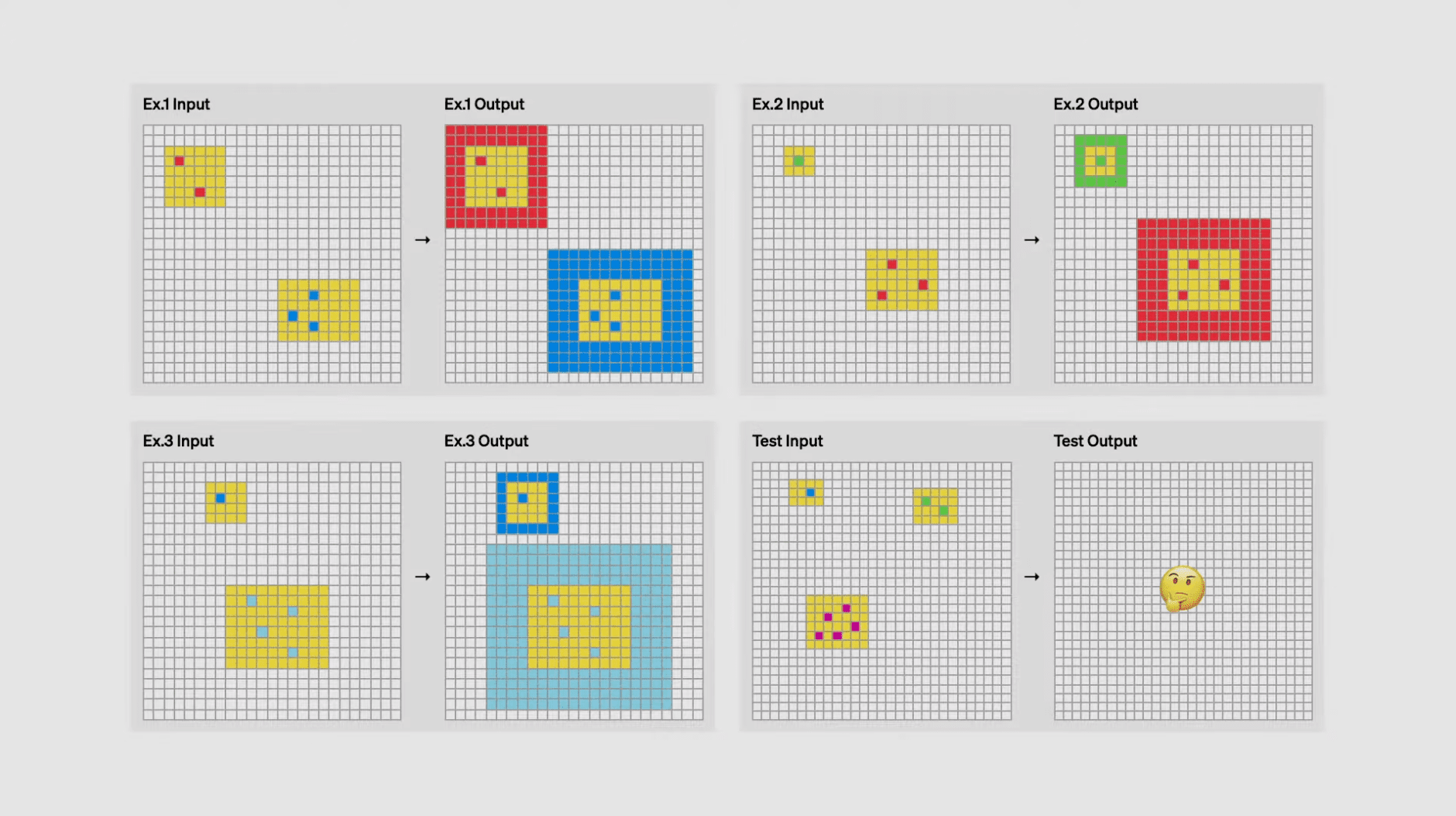

O ARC-AGI, apresentado pela primeira vez em 2019, tem como objetivo testar os recursos dos sistemas de IA por meio de uma série de tarefas de abstração e raciocínio. Principalmente porque as medidas tradicionais de habilidade não representam efetivamente a inteligência, pois tendem a se basear em conhecimento e experiência prévios, enquanto a verdadeira inteligência deve se refletir em ampla adaptabilidade e generalização. Assim, a ARC-AGI nasceu e, em seu interior, essas tarefas exigem que a IA reconheça padrões e resolva novos problemas, sendo que cada tarefa consiste em exemplos de entrada e saída. Essas tarefas são apresentadas na forma de uma grade, em que cada quadrado pode ter uma das dez cores e o tamanho da grade pode variar de 1×1 a 30×30. Os participantes devem gerar saídas corretas com base nas entradas fornecidas, testando suas habilidades de raciocínio e abstração. Isso pode ser entendido simplesmente como encontrar padrões. Provavelmente é assim que funciona:

No benchmark ARC-AGI, a IA precisa procurar padrões com base em exemplos de "entrada - saída" emparelhados antes de prever a saída com base em uma entrada, alguns exemplos dos quais são mostrados na figura abaixo. Quem já fez exames de recrutamento para a temporada de graduação ou para o serviço público talvez não esteja familiarizado com esses problemas de raciocínio gráfico.

Muito difícil e abstrato. As classificações das gerações anteriores de modelos estão aqui:

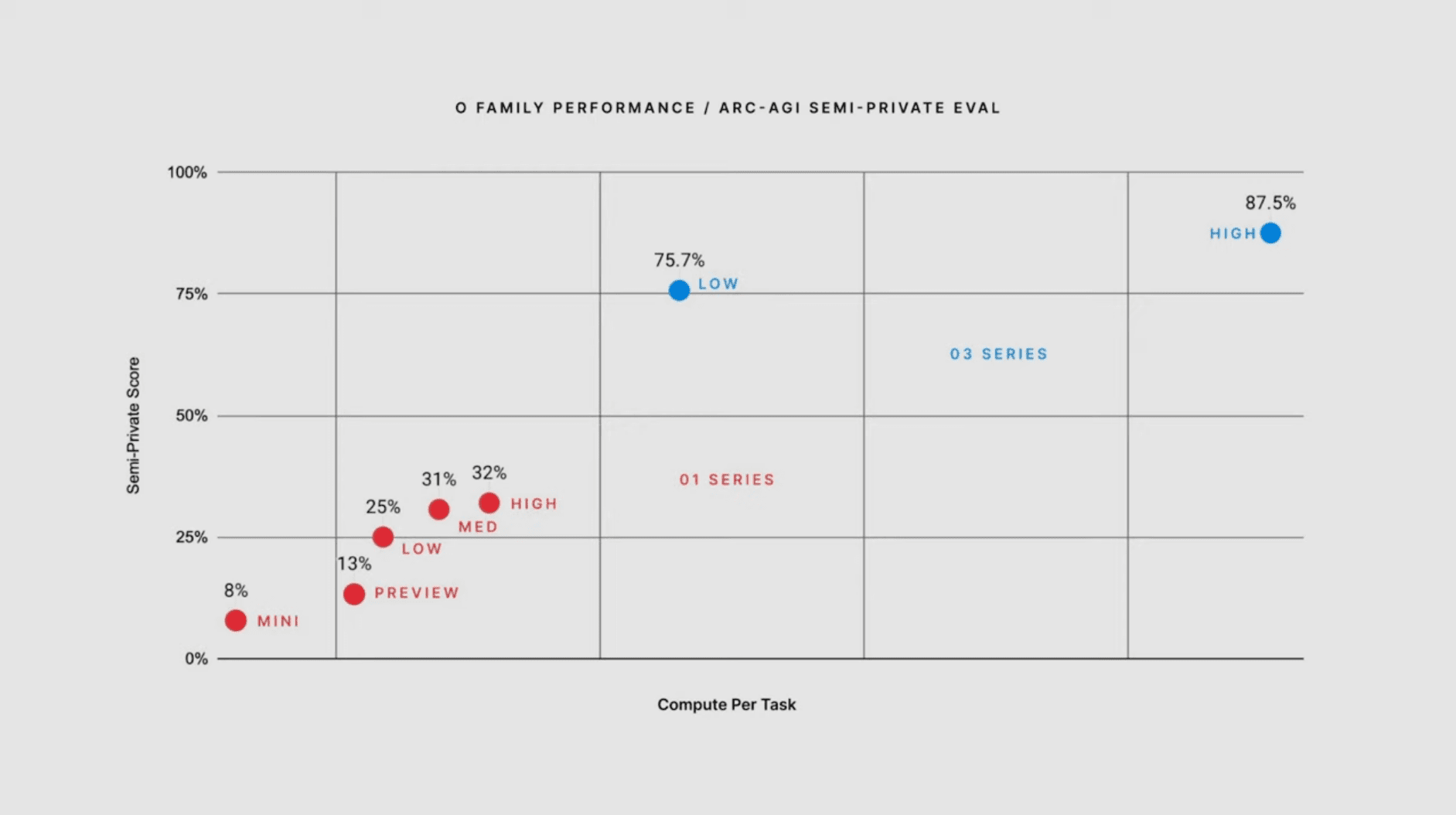

Diz-se que a família de modelos o3 atinge um desempenho mínimo de 75,7% no benchmark ARC-AGI, e o o3 é ainda mais capaz de atingir 87,5% se for permitido pensar por períodos mais longos usando mais recursos computacionais.

De 0% a 5%, foram necessários cinco anos inteiros, mas agora, de 5% a 87,5%, foi necessário apenas meio ano. E a pontuação correspondente, o limiar humano, é 85%. Não há mais nenhum obstáculo em nosso caminho para a AGI.

De 0% a 5%, foram necessários cinco anos inteiros, mas agora, de 5% a 87,5%, foi necessário apenas meio ano. E a pontuação correspondente, o limiar humano, é 85%. Não há mais nenhum obstáculo em nosso caminho para a AGI.

o3 Como o modelo funciona

Neste momento, só podemos especular um pouco sobre como o modelo o3 funciona. O mecanismo principal do modelo o3 parece estar no token espaço para pesquisa e execução de programas de linguagem natural - durante o teste, o modelo pesquisa o espaço de possíveis cadeias de pensamento que descrevem as etapas necessárias para resolver a tarefa, de uma forma que pode ser de uma forma que pode ter alguma semelhança com a pesquisa em árvore Monte-Carlo no estilo AlphaZero. No caso do o3, a pesquisa pode ser orientada por algum tipo de modelo de avaliação. Vale a pena observar que Demis Hassabis, da DeepMind, deu a entender em uma entrevista em junho de 2023 que a DeepMind está trabalhando nesse conceito - um trabalho que vem sendo desenvolvido há muito tempo.