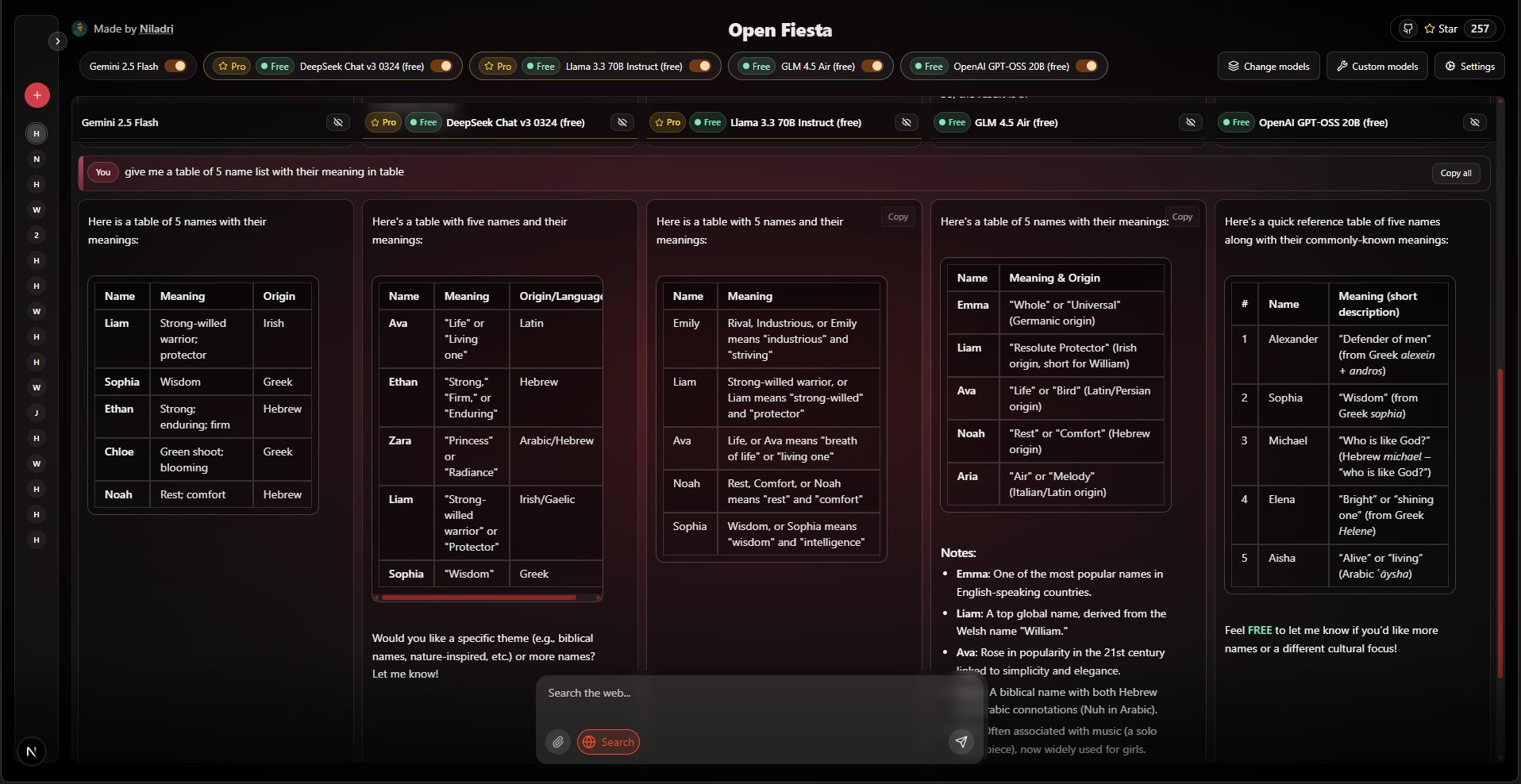

O Open-Fiesta é uma ferramenta de bate-papo de IA de código aberto. Ela permite que os usuários conversem com vários modelos de linguagem grandes e diferentes ao mesmo tempo na mesma interface. Os usuários podem selecionar até cinco modelos, enviar uma pergunta uma vez e ver as diferentes respostas de cada modelo lado a lado para comparação direta. A ferramenta suporta o acesso a uma ampla variedade de modelos nas plataformas Gemini e OpenRouter, como Llama 3.3, Qwen e Mistral. Além do bate-papo por texto, ela oferece recursos adicionais para pesquisa na Web e upload de imagens (somente modelos Gemini) para aprimorar os recursos de resposta do modelo. Todo o projeto foi desenvolvido usando a estrutura Next.js, que permite que os próprios usuários o implementem e o utilizem preenchendo sua chave de API nas configurações.

Lista de funções

- Bate-papo com vários modelosSuporte para seleção de até 5 modelos de IA na mesma interface para diálogo e comparação simultâneos.

- Suporte avançado a modelosSuporte, incluindo DeepSeek R1, Llama 3.3, Qwen, por meio de acesso ao Gemini e ao OpenRouter. MistralMoonshot, Reka, Sarvam e muitos outros modelos convencionais e de código aberto.

- Pesquisa na WebPesquisa na Web: Você pode escolher se deseja ativar a função de pesquisa na Web ao enviar cada mensagem, permitindo que o modelo acesse as informações mais recentes da Internet para responder às perguntas.

- Entrada de imagemQuando se usa o modelo Gemini, o usuário pode carregar uma imagem e fazer com que o modelo entenda o conteúdo da imagem e responda a perguntas e respostas.

- Interface de usuário simplesInterface do usuário: A interface é limpa e organizada, suporta o envio direto de perguntas pelo teclado e exibe as respostas geradas pelo modelo em tempo real.

- Gerenciamento de chaves de APIOs usuários podem fornecer ou modificar suas chaves de API a qualquer momento no painel "Settings" da GUI ou configurá-las por meio do arquivo de variáveis de ambiente.

- Formatação de respostasProcessamento especial para a saída do modelo DeepSeek R1: remove automaticamente as tags de inferência e converte a formatação Markdown em texto simples para melhorar a legibilidade do conteúdo.

- Código aberto e implementação automáticaO projeto é baseado na licença MIT de código aberto, os usuários podem fazer o download do código-fonte para executar localmente ou no servidor.

Usando a Ajuda

O Open-Fiesta é um aplicativo da Web que pode ser usado diretamente por meio da URL fornecida pelo desenvolvedor, ou você pode fazer download do código-fonte e implantá-lo em seu próprio computador ou servidor. Veja abaixo o processo detalhado de uso e implementação.

Processo de implantação local

Se quiser executar o Open-Fiesta em seu próprio computador, será necessário instalar o ambiente Node.js primeiro e depois seguir estas etapas:

- Código de download

Abra um terminal (ferramenta de linha de comando) e usegitpara clonar o código do projeto em seu computador:git clone https://github.com/NiladriHazra/Open-Fiesta.gitEm seguida, vá para o diretório do projeto:

cd Open-Fiesta - Instalação de dependências

No diretório raiz do projeto, execute o seguinte comando para instalar todas as dependências necessárias para a execução do projeto:npm i - Configuração da chave de API

O projeto requer uma chave de API para se conectar ao serviço Big Model. Você precisa criar um arquivo de variável de ambiente local.env.localpara armazenar a chave.- No diretório raiz do projeto, crie manualmente um arquivo chamado

.env.localdo documento. - Abra esse arquivo e adicione o seguinte, dependendo do modelo que você precisa usar:

Se quiser usar modelos da plataforma OpenRouter (recomendado, pois ela oferece suporte a uma ampla variedade de modelos gratuitos e pagos), você precisará obter a chave da API em https://openrouter.ai e adicioná-la ao arquivo:

OPENROUTER_API_KEY=你的OpenRouter密钥Se quiser usar o modelo Gemini do Google (que suporta entrada de imagem), você precisará começar com o Google AI Studio Obtenha a chave da API e adicione-a ao arquivo:

GOOGLE_GENERATIVE_AI_API_KEY=你的Gemini密钥

Você pode configurar ambas as chaves ou apenas uma.

- No diretório raiz do projeto, crie manualmente um arquivo chamado

- Iniciando o servidor de desenvolvimento

Após concluir as etapas acima, execute o seguinte comando para iniciar o projeto:npm run devO terminal mostrará que o aplicativo foi iniciado com êxito e fornecerá um URL local, geralmente o

http://localhost:3000。 - começar a usar

Abrir em seu navegadorhttp://localhost:3000Em seguida, você pode começar a usar o Open-Fiesta com sua própria implementação.

Guia de operação de funções

Ao abrir a interface do Open-Fiesta, você verá uma janela de bate-papo muito limpa.

- Selecione o modelo

Na parte superior da interface de bate-papo, você verá a área de seleção de modelos. Clicar nela expande uma lista de modelos, que relaciona todos os modelos compatíveis com o OpenRouter e o Gemini. Você pode marcar até 5 modelos dessa lista com os quais deseja conversar ao mesmo tempo. - enviar uma mensagem

Digite sua pergunta ou instrução na caixa de entrada na parte inferior. Quando terminar de digitar, basta pressionar a tecla Return (Enter) para enviá-la. - Usando a pesquisa na Web

Ao lado da caixa de entrada, há um botão "Web Search" (Pesquisa na Web). Se quiser que o modelo pesquise informações na Web antes de responder, você pode ativar esse botão antes de enviar a pergunta. Isso é especialmente útil para perguntas que exigem informações atualizadas ou verificação de fatos. - Fazer upload de imagens (somente Gemini)

Se você selecionar um modelo que inclua o Gemini, um botão de upload de imagem também será exibido ao lado da caixa de entrada. Clique nele para selecionar uma imagem de seu computador. Após o upload, você poderá enviar uma pergunta e o modelo Gemini responderá com a imagem. Por exemplo, você pode carregar uma imagem de comida e perguntar "What is this dish?" (O que é este prato?). . - Visualizar e comparar respostas

Depois de enviar uma pergunta, vários modelos de sua escolha começarão a gerar respostas ao mesmo tempo. As respostas são exibidas lado a lado em seus respectivos cartões, facilitando a comparação direta das diferenças e das vantagens e desvantagens entre os diferentes modelos. - Chaves de configuração de tempo de execução

Se você implantar sem configurar o.env.localou se quiser usar outra chave de API temporariamente, você pode clicar no botão "Settings" (Configurações) na interface. No painel pop-up, você pode inserir diretamente sua chave de API do OpenRouter ou do Gemini. A chave inserida aqui é válida somente para a sessão atual do navegador; você precisará inseri-la novamente depois de fechar a página da Web.

cenário do aplicativo

- criador de conteúdo

Os criadores de conteúdo, como blogueiros ou profissionais de marketing, podem inserir o mesmo tópico ou instruções em vários modelos de IA ao mesmo tempo para obter rapidamente um rascunho em vários estilos e ângulos. Isso os ajuda a comparar os recursos de redação de diferentes modelos e a selecionar ou combinar o conteúdo de melhor qualidade entre eles, aumentando consideravelmente a eficiência criativa. - Desenvolvedores e pesquisadores

Os desenvolvedores que estão escrevendo códigos ou resolvendo problemas técnicos podem fazer perguntas a vários modelos e comparar os exemplos de código, as soluções ou as sugestões de depuração que eles fornecem. Os pesquisadores, por outro lado, podem usar essa ferramenta para comparar a profundidade do conhecimento e a capacidade de raciocínio de diferentes modelos em áreas específicas de especialização para informar suas pesquisas. - Estudantes e educadores

Os alunos que estão aprendendo conceitos complexos ou escrevendo artigos podem usar essa ferramenta para aprofundar sua compreensão, obtendo diferentes interpretações e perspectivas de vários "tutores" de IA. Eles podem pedir ao modelo que explique um princípio científico, forneça o contexto de um evento histórico ou conceitue um esboço de um artigo e compare-os para obter uma visão mais completa. - Exploração de curiosidade para o usuário comum

Para qualquer usuário interessado em tecnologia de IA, essa ferramenta é um excelente playground. Os usuários podem fazer quantas perguntas quiserem, desde a vida cotidiana ("Ajude-me a planejar uma viagem de fim de semana") até tópicos imaginativos ("Escreva uma história curta sobre uma aventura espacial"), para visualizar os diferentes modelos de IA. desde a vida cotidiana ("Help me plan a weekend trip") até tópicos imaginativos ("Write a short story about space adventure"), sentir intuitivamente as "personalidades" e as diferenças de capacidade dos diferentes modelos de IA e satisfazer sua curiosidade.

QA

- Esse programa é gratuito?

O projeto em si é de código aberto e gratuito, e você pode fazer o download e implantá-lo livremente. No entanto, para usá-lo, é necessário chamar serviços de modelos de IA de terceiros (como o OpenRouter ou o Google Gemini), que podem cobrar uma taxa. No entanto, a plataforma OpenRouter também oferece vários modelos que podem ser usados gratuitamente, com uma quantidade suficiente para o uso diário. - Minha chave de API é segura?

Se estiver implementando localmente, sua chave de API será armazenada apenas em seu próprio computador (.env.local), é seguro. Se você inserir a chave nas configurações da versão da Web, a chave também será armazenada apenas no navegador e não será carregada no servidor. - Por que algumas das respostas dos modelos são de baixa qualidade?

O Open-Fiesta é apenas uma ferramenta de interface para chamar diferentes modelos, e a qualidade da resposta depende inteiramente dos recursos do modelo de IA que você escolher. Modelos diferentes têm seus próprios pontos fortes, pontos fracos e áreas de especialização, e você pode experimentar mais alguns para encontrar o que melhor atenda às suas necessidades. - É possível adicionar mais modelos?

Pode. Se você for um desenvolvedor, poderá modificar olib/para adicionar quaisquer novos modelos compatíveis com a plataforma OpenRouter no formato existente.