Para qualquer desenvolvedor que deseje executar localmente modelos de linguagem grande de código aberto, oOllama Ele se tornou uma ferramenta indispensável. Simplificou muito o processo de download, implantação e gerenciamento de modelos. No entanto, com o crescimento explosivo dos tamanhos dos parâmetros dos modelos, até mesmo os PCs profissionais estão enfrentando dificuldades com centenas de gigabytes de vídeo e requisitos de memória, tornando muitos modelos de ponta fora do alcance da maioria dos desenvolvedores.

Para resolver esse problema central, aOllama A prévia do Cloud Models foi lançada oficialmente recentemente. O novo serviço tem como objetivo oferecer aos desenvolvedores a capacidade de executar esses modelos gigantes em hardware de nível de datacenter em um esquema inteligente que é tão interativo quanto executá-los localmente.

Principais recursos: supere as limitações de hardware e mantenha a experiência local

Ollama Cloud A filosofia de design não é simplesmente fornecer uma interface de API de nuvem, mas integrar perfeitamente a aritmética de nuvem aos fluxos de trabalho locais com os quais os desenvolvedores estão familiarizados.

- Ultrapassar as limitações de hardwareOs usuários agora podem executar diretamente um arquivo como

deepseek-v3.1:671b(671 bilhões de parâmetros) ouqwen3-coder:480b(480 bilhões de parâmetros) tais modelos gigantescos. O primeiro é um poderoso modelo de pensamento híbrido, enquanto o segundo foi desenvolvido pela Alibaba e é especializado em geração de código e tarefas de agente. Esses modelos exigem recursos de computação que vão muito além do domínio dos dispositivos pessoais, e oOllama CloudEntão, esse obstáculo é completamente removido. - Experiência de localização perfeitaIsso é

Ollama CloudO ponto mais atraente. Os usuários não precisam alterar a cadeia de ferramentas existente, pois todas as operações ainda são feitas por meio doOllamacliente para concluir. Se você usar oollama runpara ter um diálogo interativo, ou por meio deollama lsA visualização de uma lista de modelos é exatamente a mesma experiência que o gerenciamento de modelos locais. O modelo de nuvem é representado localmente como uma referência leve ou "atalho" que não ocupa espaço em disco. - Priorizar a privacidade e a segurançaPrivacidade dos dados: a privacidade dos dados é uma consideração importante nos aplicativos de IA.

OllamaAs autoridades prometem explicitamente que os servidores em nuvem não reterão nenhum dado de consulta dos usuários, garantindo que as conversas e os trechos de código permaneçam privados. - Compatível com a API OpenAI:

Ollamade serviços locais devido ao seu impacto sobreOpenAIA compatibilidade com o formato da API é popular.Ollama CloudA herança desse recurso significa que todo o suporte existente paraOpenAIAplicativos e fluxos de trabalho com APIs podem mudar sem problemas para o uso desses grandes modelos na nuvem.

Modelos de nuvem disponíveis atualmente

Atualmente.Ollama Cloud A versão de visualização oferece os seguintes modelos paramétricos superdimensionados, todos com o nome do modelo -cloud Os sufixos são usados para diferenciar:

- qwen3-coder:480b-cloudModelo principal da Alibaba com foco em geração de código e tarefas de agente.

- deepseek-v3.1:671b-cloudModelo de uso geral em escala ultragrande que suporta modos mistos de pensamento e se destaca em raciocínio e codificação.

- gpt-oss:120b-cloud

- gpt-oss:20b-cloud

Guia de início rápido

experiências Ollama Cloud O processo é muito simples e pode ser feito em apenas algumas etapas.

Etapa 1: Atualizar o Ollama

Certifique-se de que o Ollama Atualização da versão para a v0.12 ou superior. Você pode fazer o download da versão mais recente no site oficial ou usar o System Package Manager para atualizar.

Etapa 2: Faça login em sua conta Ollama

Como o modelo de nuvem precisa chamar ollama.com recursos de computação, os usuários devem fazer login em seus Ollama para concluir a autenticação. Execute o seguinte comando no terminal:

ollama signin

Esse comando direciona o usuário para concluir a autorização de login no navegador.

Etapa 3: Execute o modelo de nuvem

Depois de fazer o login com sucesso, você pode executar o modelo de nuvem diretamente como se fosse um modelo local. Por exemplo, para iniciar o parâmetro de 480 bilhões Qwen3-Coder Modelos, somente execução:

ollama run qwen3-coder:480b-cloud

Ollama O cliente lida automaticamente com todo o roteamento de solicitações para a nuvem e o usuário simplesmente aguarda a resposta do modelo.

Etapa 4: Gerenciar o modelo de nuvem

fazer uso de ollama ls para ver a lista de modelos que foram extraídos localmente. Você notará que o modelo de nuvem SIZE A coluna é mostrada como -o que intuitivamente mostra que se trata apenas de uma referência que não ocupa espaço de armazenamento local.

% ollama ls

NAME ID SIZE MODIFIED

gpt-oss:120b-cloud 569662207105 - 5 seconds ago

qwen3-coder:480b-cloud 11483b8f8765 - 2 days ago

Integração e chamadas de API

Para os desenvolvedores, as chamadas de API estão no centro da integração.Ollama Cloud Oferece suporte a dois tipos principais de chamadas de API: por meio de proxies locais e acesso direto a endpoints de nuvem.

Opção 1: via agente de serviço local da Ollama

Essa é a maneira mais fácil e recomendada de fazer isso, e funciona perfeitamente com os fluxos de trabalho existentes.

Primeiro, use o pull extrai a referência do modelo localmente:

ollama pull gpt-oss:120b-cloud

Em seguida, como em qualquer modelo local, chame o Ollama Serviços (http://localhost:11434) Envie a solicitação.

Exemplo de Python

import ollama

response = ollama.chat(

model='gpt-oss:120b-cloud',

messages=[{

'role': 'user',

'content': 'Why is the sky blue?',

},

])

print(response['message']['content'])

Exemplos de JavaScript (Node.js)

import ollama from "ollama";

const response = await ollama.chat({

model: "gpt-oss:120b-cloud",

messages: [{ role: "user", content: "Why is the sky blue?" }],

});

console.log(response.message.content);

Exemplo de cURL

curl http://localhost:11434/api/chat -d '{

"model": "gpt-oss:120b-cloud",

"messages": [{

"role": "user",

"content": "Why is the sky blue?"

}],

"stream": false

}'

Maneira 2: acesso direto à API da nuvem

Em alguns cenários, como em uma função de servidor ou nuvem, é mais conveniente chamar a API da nuvem diretamente.

- Pontos de extremidade da API:

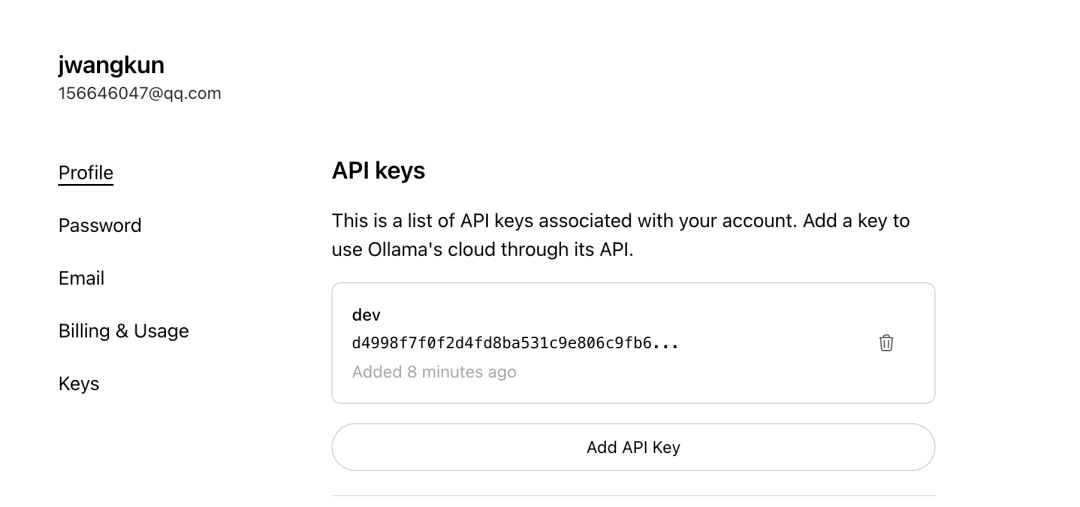

https://ollama.com/v1/chat/completions - Aplicativo de chave de APIÉ necessária uma chave de API dedicada para acessar diretamente esse endpoint. Os usuários podem encontrar a chave de API na seção

OllamaDepois de fazer login no site oficial, acesse a página Keys (Chaves) para gerar sua própria chave.

As chamadas diretas para APIs de nuvem seguem o padrão OpenAI basta carregar o formato Authorization Os comprovantes são suficientes.

Integração com ferramentas de terceiros

Ollama Cloud O ponto forte do design está em sua perfeita compatibilidade ecológica. Todo o suporte está disponível por meio do Ollama Um cliente de terceiros que se conecta a partir de um endpoint de API local, como o Open WebUI、LobeChat 或 Cherry StudioO modelo de nuvem pode ser usado diretamente sem nenhuma modificação.

以 Cherry Studio como exemplo:

- seguro

APIOs pontos de extremidade apontam para o localOllamaExemplo:http://localhost:11434。 - Na lista de nomes de modelos, preencha o nome do modelo de nuvem que você extraiu diretamente, por exemplo

gpt-oss:120b-cloud。 API KeyO campo geralmente é deixado em branco porque a autenticação já foi aprovadaollama signinfeito no cliente local.

Quando a configuração estiver concluída, suas chamadas para o modelo de nuvem nessas ferramentas serão feitas localmente Ollama O cliente é automaticamente transferido para a nuvem para processamento, e todo o processo é completamente transparente para o aplicativo de camada superior.

Importância estratégica e perspectivas

Ollama Cloud O lançamento marca um avanço significativo na usabilidade dos modelos de IA de código aberto. Ele não apenas abre a porta para grandes modelos de alto nível para desenvolvedores individuais e entusiastas, mas, o que é mais importante, reduz o custo de aprendizado e migração para os desenvolvedores, mantendo a experiência de interação localizada.

No momento, o serviço está em fase de pré-visualização, e os funcionários mencionaram que há uma limitação temporária da taxa para garantir a estabilidade do serviço e planos para introduzir um modelo de cobrança baseado no uso no futuro. Essa iniciativa será Ollama Posicionado como uma ponte entre os ambientes de desenvolvimento local e o poderoso poder de computação da nuvem, possibilitando a conexão com Groq、Replicate e outros serviços de raciocínio puramente baseados em nuvem têm uma vantagem exclusiva na experiência do desenvolvedor em relação à concorrência.