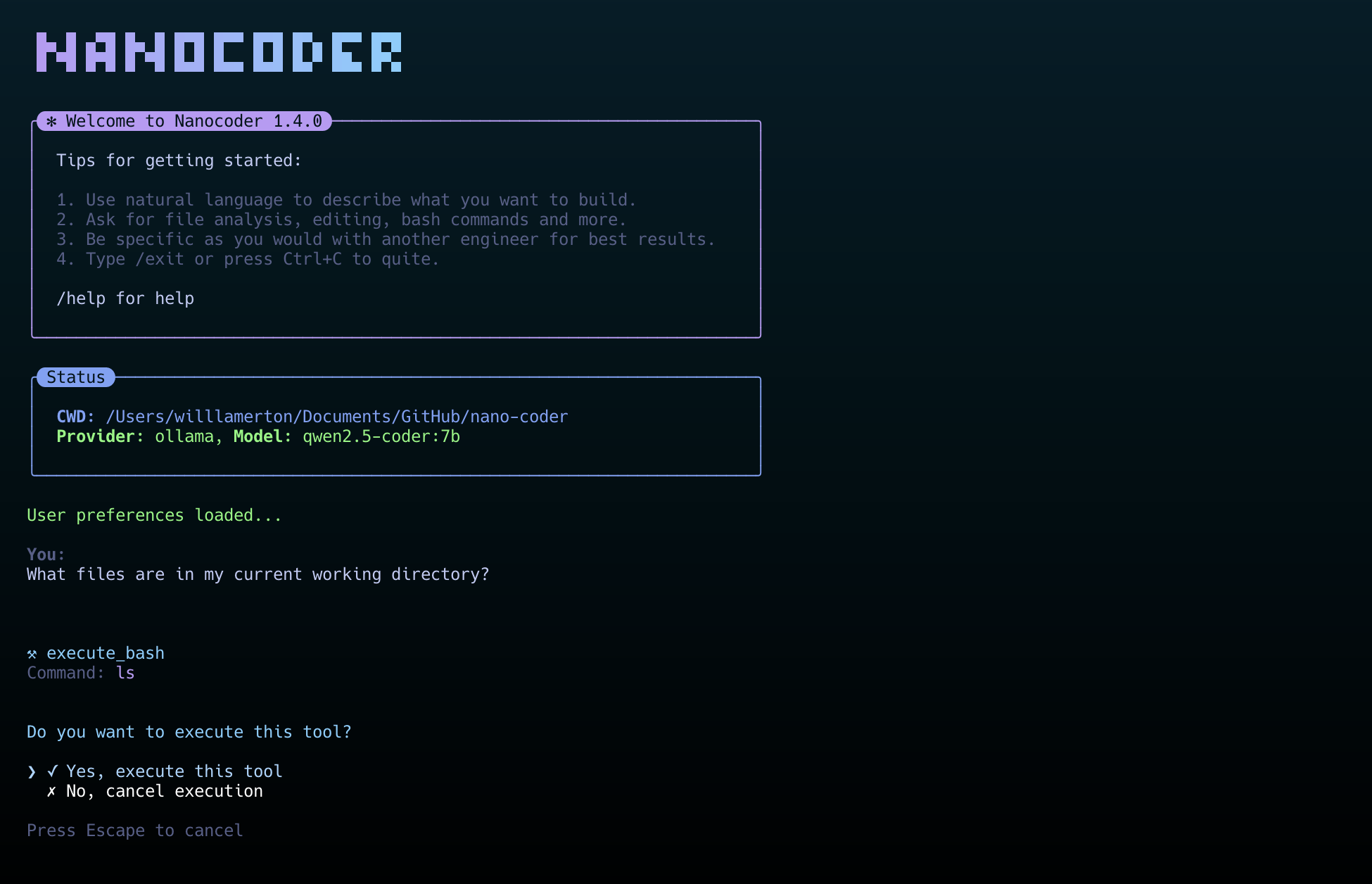

O nanocoder é uma ferramenta de programação de IA executada em um ambiente de terminal local, com uma filosofia de design central de "local primeiro" para proteger a privacidade do usuário e a segurança dos dados. O nanocoder permite que os desenvolvedores interajam com a IA em seus próprios computadores por meio de uma interface de linha de comando para realizar tarefas como escrever, revisar e refatorar. A ferramenta permite que os desenvolvedores interajam com a IA em seus próprios computadores por meio de uma interface de linha de comando para escrever, revisar e refatorar códigos. O nanocoder oferece suporte a uma ampla gama de provedores de serviços de modelos de IA. Os usuários podem se conectar ao Ollama, que é executado totalmente localmente, para geração de código off-line, ou configurar interfaces de API compatíveis com OpenRouter ou OpenAI para usar esses modelos de IA mais avançados baseados em nuvem. Ele tem um sistema integrado de ferramentas úteis que permitem que a IA leia e grave arquivos e execute comandos de terminal diretamente, bem como se conecte a mais serviços externos, como sistemas de arquivos, repositórios do GitHub e pesquisas na Web por meio do protocolo de contexto de modelo (MCP), expandindo ainda mais os recursos do aplicativo.

Lista de funções

- Suporte a vários provedores de serviços de IAÉ possível conectar-se ao Ollama em execução localmente, ao OpenRouter na nuvem e a qualquer serviço compatível com a API do OpenAI (por exemplo, LM Studio, vLLM etc.).

- Sistema avançado de ferramentasFerramentas integradas para manipulação de arquivos, execução de comandos bash etc. A IA pode realizar operações como leitura ou gravação de arquivos ou execução de código com a permissão do usuário.

- Protocolo de contexto de modelo (MCP)Suporte para conexão com servidores MCP, o que amplia os recursos de ferramentas de IA, como acesso ao sistema de arquivos, GitHub, pesquisa Brave e bancos de memória.

- Sistema de instrução personalizadoOs usuários podem adicionar um novo nome de usuário à lista de usuários do projeto

.nanocoder/commandsuse arquivos Markdown para criar instruções reutilizáveis com parâmetros para facilitar a execução de tarefas altamente repetitivas, como a geração de testes, revisões de código etc. - Experiência inteligente do usuárioAutopreenchimento de comandos, rastreabilidade do histórico de diálogos, retenção do estado da sessão etc., e exibirá o processo de raciocínio da IA, o uso de tokens e o tempo de execução em tempo real, de acordo com o status da tarefa.

- Configuração autônoma em nível de projeto: Ao colocar o

agents.config.jsonum modelo de IA ou uma chave de API diferente pode ser definido para cada projeto para facilitar o gerenciamento. - Compatível com o desenvolvedorO projeto inteiro foi criado usando TypeScript, a estrutura de código é clara e fácil de estender. Também oferece ferramentas de depuração detalhadas e controle de nível de registro.

Usando a Ajuda

O nanocoder é uma ferramenta executada no terminal (interface de linha de comando). A seção a seguir descreve em detalhes como instalá-lo e usá-lo.

Processo de instalação

1. preparação ambiental

Antes de instalar o nanocoder, você precisa se certificar de que seu computador tenha o Node.js (versão 18+ necessária) e npm Ferramenta de gerenciamento de pacotes. O npm geralmente é instalado com o Node.js.

2. instalação global

Recomenda-se usar o método de instalação global para que você possa executar o nanocoder diretamente de qualquer diretório em seu computador. abra o terminal e digite o seguinte comando:

npm install -g @motesoftware/nanocoder

Quando a instalação estiver concluída, você poderá acessá-la diretamente de qualquer pasta do projeto digitando nanocoder para iniciá-lo.

Configuração do modelo de IA

O poder do nanocodificador é que ele pode conectar diferentes modelos de IA. Você precisa selecionar e configurar um serviço de IA de acordo com suas necessidades. As informações de configuração são armazenadas em um arquivo chamadoagents.config.jsonque você precisa colocar no diretório raiz do código do seu projeto.

Opção 1: Uso do Ollama (modelo local)

Essa é a maneira mais protetora da privacidade, pois o modelo é executado inteiramente em seu próprio computador.

- Primeiro, você precisa instalar e executar o Ollama.

- Em seguida, faça o download de um modelo de que você precisa na biblioteca de modelos do Ollama. Por exemplo, baixe um modelo leve

qwen2:0.5bModelos:ollama pull qwen2:0.5b - Após concluir as etapas acima, execute diretamente

nanocoderEle detectará automaticamente seu serviço Ollama local e se conectará.

Opção 2: usar o OpenRouter (modelo baseado em nuvem)

O OpenRouter reúne uma ampla variedade de excelentes modelos de IA no mercado, como GPT-4o, Claude 3 e outros.

- No diretório raiz do projeto, crie um arquivo

agents.config.jsonDocumentação. - Copie o seguinte no arquivo e coloque o

your-api-key-hereSubstitua a chave da API do OpenRouter por sua própria chave e adicione uma nova chave da API do OpenRouter no arquivomodelsO campo é preenchido com o nome do modelo que você deseja usar.{ "nanocoder": { "openRouter": { "apiKey": "your-api-key-here", "models": ["openai/gpt-4o", "anthropic/claude-3-opus"] } } }

Opção 3: usar APIs compatíveis com a OpenAI (local ou remota)

Ele também pode ser configurado se o serviço de IA que você estiver usando (por exemplo, LM Studio, vLLM ou um serviço criado por você mesmo) fornecer uma interface de API compatível com o OpenAI.

- Da mesma forma, no diretório raiz do projeto, crie o arquivo

agents.config.jsonDocumentação. - Preencha os campos a seguir para colocar

baseUrlSubstitua-o por seu endereço de serviço e preencha a chave de API, se necessário.{ "nanocoder": { "openAICompatible": { "baseUrl": "http://localhost:1234", "apiKey": "optional-api-key", "models": ["model-1", "model-2"] } } }

comando de operação básica

Depois de iniciar o nanocoder, você será levado a uma interface de bate-papo interativa. Você pode digitar uma descrição em linguagem natural do que deseja ou usar a barra/As instruções incorporadas no início controlam o programa.

/helpExibe uma lista de todos os comandos disponíveis./provider:: troca de provedores de serviços de IA, por exemplo, de Ollama para OpenRouter./modelAlternar entre a lista de modelos fornecidos pelo provedor de serviços atual./clearLimpar o bate-papo atual e iniciar uma nova sessão./debugNível de exibição do registro: Alterna o nível de exibição do registro, que é usado para visualizar informações detalhadas sobre a operação do programa./exitSair do programa do nanocodificador.

Uso de comandos personalizados

Os comandos personalizados são um recurso especial do nanocoder que o ajuda a modelar tarefas complexas comuns.

- Crie um arquivo no diretório raiz do seu projeto chamado

.nanocodere, em seguida, crie outra pastacommandsPasta. - 在

.nanocoder/commands/crie um arquivo Markdown, por exemplotest.md。 - Nesse arquivo, você pode definir a descrição, os aliases e os parâmetros da diretiva. Por exemplo, crie uma diretiva para gerar testes de unidade:

--- description: "为指定的组件生成全面的单元测试" aliases: ["testing", "spec"] parameters: - name: "component" description: "需要测试的组件或函数名称" required: true --- 请为 {{component}} 生成全面的单元测试。测试需要覆盖以下几点: - 正常情况下的行为 - 边界条件和异常处理 - 对外部依赖进行模拟 - 清晰的测试描述 - Depois de salvar o arquivo, você pode usar esse novo comando no nanocoder. Por exemplo, para

UserServiceGerar testes que você pode inserir:

/test component="UserService"

O programa definirá automaticamente a{{component}}Substituir porUserServiceque, em seguida, envia todo o prompt para o modelo de IA executar a tarefa.

cenário do aplicativo

- Gerar rapidamente trechos de código

Quando os desenvolvedores precisam escrever uma nova função ou módulo, eles podem descrever diretamente os requisitos para o nanocoder no terminal, por exemplo, "Criar uma função TypeScript para analisar arquivos CSV", e a IA gerará diretamente o código correspondente. - Revisão e refatoração de código

Um trecho de código escrito pode ser entregue a um nanocodificador para revisão e sugestões de aprimoramento. Também é possível usar diretivas de refatoração personalizadas, como/refactor:dryA IA é instruída a otimizar o código de acordo com o princípio de "não se repetir". - Escrever testes de unidade

A geração rápida de casos de teste de unidade para funções ou componentes existentes é um dos aspectos mais tediosos do desenvolvimento de software. É possível gerar casos de teste unitário para funções ou componentes existentes personalizando a função/testinstruções, os desenvolvedores só precisam fornecer o nome do componente e você pode permitir que a IA escreva automaticamente o código de teste para aumentar a eficiência do desenvolvimento. - Aprender uma nova linguagem ou estrutura de programação

Ao abordar uma tecnologia desconhecida, pense nela como um professor de programação de plantão, fazendo perguntas e pedindo ao nanocodificador que forneça exemplos de código ou explique a finalidade e o funcionamento de determinado código.

QA

- Quais sistemas operacionais são compatíveis com o nanocoder?

O nanocoder foi desenvolvido com base no Node.js, portanto, pode ser executado em todos os principais sistemas operacionais, incluindo Windows, macOS e Linux, desde que o ambiente Node.js esteja instalado no sistema. - Quais são os requisitos para usar o modelo Ollama local?

Para usar o Ollama, é necessário primeiro instalar e executar o programa Ollama em seu computador. Existem alguns requisitos de hardware do computador, principalmente dependendo do tamanho do modelo de IA que estiver sendo executado. Quanto maior o modelo (por exemplo, mais de 7 bilhões de parâmetros), mais RAM e uma boa placa gráfica (GPU) são necessárias para garantir uma geração rápida. - Minha chave de API e meus dados de código estão seguros?

O Nanocoder foi projetado tendo em mente o "local primeiro". Quando você usa o Ollama, todos os dados e cálculos são feitos em seu computador local, sem passar por nenhum servidor externo. Quando você usa um serviço de nuvem, como o OpenRouter, seu código e suas dicas são enviados ao provedor de serviços por meio de uma API e, nesse caso, você precisa estar em conformidade com a política de privacidade de dados desse provedor de serviços. Arquivo de configuraçãoagents.config.jsonSalvo em seu diretório de projeto local, ele não será carregado. - Como o nanocoder é diferente de outras ferramentas de programação de IA?

O principal diferencial do nanocoder é o fato de ser uma ferramenta executada exclusivamente no terminal de linha de comando, o que a torna ideal para desenvolvedores acostumados a manipular o teclado e os fluxos de trabalho do terminal. Em segundo lugar, ele enfatiza a prioridade local e o controle do usuário, dando aos usuários a liberdade de escolher se querem usar um modelo local ou baseado na nuvem, com gerenciamento granular por meio de arquivos de configuração no nível do projeto.