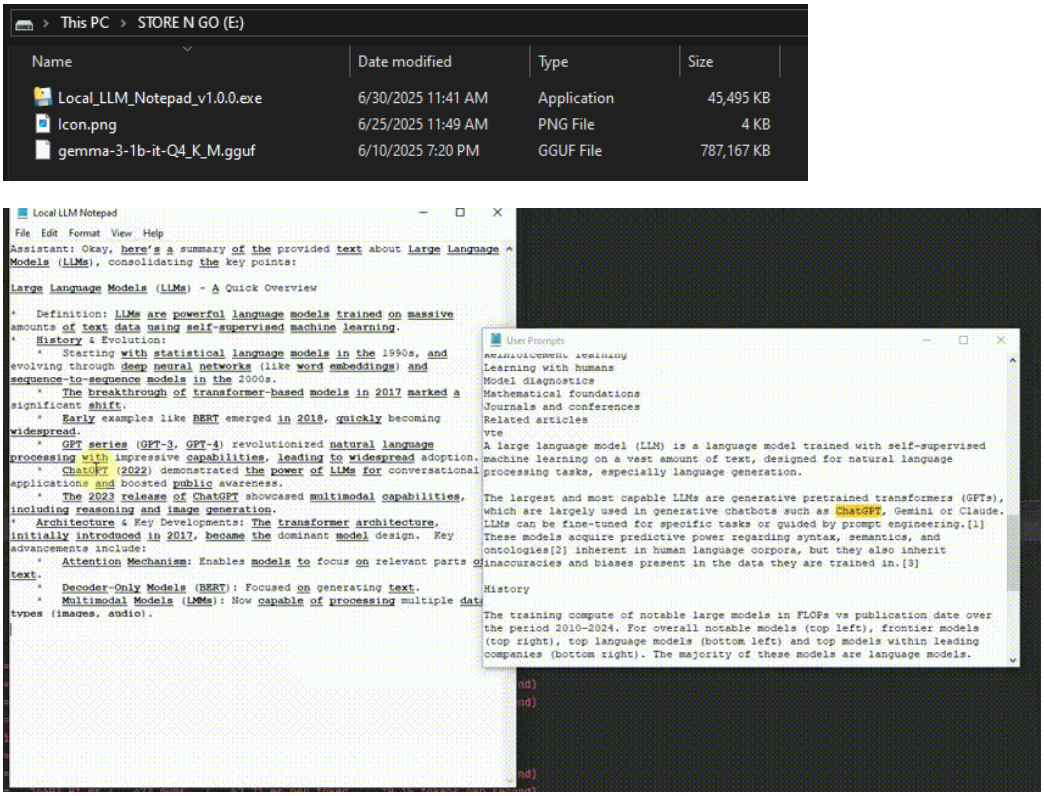

O Local LLM Notepad é um aplicativo off-line de código aberto que permite que os usuários executem Modelos Locais de Idiomas Grandes em qualquer computador Windows por meio de um dispositivo USB, sem conexão com a Internet e sem instalação. Os usuários podem simplesmente copiar um único executável (EXE) e um arquivo de modelo (por exemplo, formato GGUF) em um pen drive e conversar, fazer brainstorming ou rascunhar documentos em qualquer lugar, a qualquer momento. Ele foi projetado com o objetivo de ser simples e fácil de usar, não exigindo privilégios de administrador, e é adequado para usuários de diferentes níveis de habilidade em diversos cenários, como acesso de clientes ou estações de trabalho temporárias. A ferramenta enfatiza a portabilidade e a proteção da privacidade, e todo o processamento de dados é feito localmente, sem depender de serviços de nuvem ou de API. A interface é simples e intuitiva, com um layout de janela dupla, suporte para destaque de palavras-chave e diálogo de exportação no formato JSON, facilitando o gerenciamento e o rastreamento do conteúdo pelos usuários.

Lista de funções

- Execução off-line de modelos de idiomas grandesNão requer conexão com a Internet, carrega modelos no formato GGUF, adequado para cenários sensíveis à privacidade.

- Design portátilArquivo único EXE, sem necessidade de instalação, executado diretamente do pendrive.

- Interface interativa de janela duplaA interface é simples e sem enfeites desnecessários: digite a palavra de alerta abaixo e a resposta do modelo será exibida em tempo real na parte superior.

- Destaque e rastreabilidade de palavras-chavePalavras inseridas pelo usuário são automaticamente negritadas e sublinhadas na resposta do modelo. Ctrl+Clique para ver o histórico da palavra de prompt relevante.

- Exportação de diálogo JSONSuporte à exportação de registros de diálogo com um clique para facilitar a migração entre dispositivos.

- Troca flexível de modelosCarga: Carregue diferentes modelos de GGUF por meio de "File > Select Model" para atender a várias necessidades.

- Alto desempenhoSuporte a modelos de CPU rápidos (por exemplo, modelos de 0,8 GB), atingindo velocidades de geração de aproximadamente 20 tokens/segundo em hardware comum.

Usando a Ajuda

Instalação e preparação

O Local LLM Notepad não requer instalação no sentido tradicional e foi projetado para ser plug and play. Veja abaixo um processo de preparação detalhado:

- programa de download: Visite a página Releases no repositório do GitHub (https://github.com/runzhouye/Local_LLM_Notepad) para fazer o download da versão mais recente do

Local_LLM_Notepad-portable.exe。 - Obtendo o arquivo de modeloDownload de arquivos de modelo compatíveis no formato GGUF, por exemplo, recomendado

gemma-3-1b-it-Q4_K_M.gguf(~0,8 GB). Disponível na Hugging Face ou em outras comunidades de modelos. - Copiar para o pendrive USBCopie os arquivos EXE e os arquivos de modelo GGUF baixados para uma unidade USB ou outro dispositivo de armazenamento removível.

- programa de corridaClique duas vezes em qualquer computador com Windows

Local_LLM_Notepad-portable.exeInicialização. Na primeira vez em que é executado, o programa carrega o modelo na memória (RAM), o que pode levar alguns segundos; as operações subsequentes serão mais suaves.

Funções principais

1. operação e interação

Após iniciar o programa, a interface é dividida em duas partes:

- metade inferiorDigite um prompt (prompt), texto de apoio, perguntas ou instruções.

- parte superiorAs respostas do modelo são exibidas em tempo real e são geradas a uma taxa de cerca de 20 tokens/segundo (dependendo do desempenho do hardware).

Os usuários podem inserir diretamente uma pergunta ou tarefa, como "Escreva-me um e-mail" ou "Explique a mecânica quântica", e o modelo gerará a resposta instantaneamente. A interface é intuitiva, sem menus complexos, e é ideal para iniciar rapidamente.

2. realce e rastreamento de dicas

Um dos recursos do Bloco de Notas do LLM local é o destaque de palavras de alerta. As palavras ou números que o usuário digita na palavra-chave são destacados na resposta do modelo com umnegrito, sublinhadoO formulário é exibido. Por exemplo, se você digitar "Technology trends in 2025" (Tendências tecnológicas em 2025), a parte da resposta do modelo que se refere a "2025" ou "tecnologia" será destacada. O usuário pode destacar a parte da resposta do modelo que se refere a "2025" ou "tecnologia" pressionando e mantendo pressionada a tecla Ctrl e clicar na palavra destacada abre uma janela lateral para visualizar todas as palavras com dicas históricas que contêm essa palavra. Esse recurso é ideal para cenários em que você precisa validar a saída do modelo ou rastrear informações, como extração de dados ou verificação de resumo.

3) Comutação de modelos

Se precisar alterar o modelo, você pode clicar na opção 文件 > 选择模型Se quiser usar um novo modelo, selecione outro arquivo de modelo no formato GGUF em seu cartão de memória USB. O programa carregará automaticamente o novo modelo sem reinicializar. Recomenda-se que os usuários iniciantes usem os modelos leves recomendados (por exemplo, 0,8 GB de gemma-3-1b-it-Q4_K_M.gguf) para garantir uma experiência tranquila em hardware comum.

4. exportar o diálogo

Os usuários podem salvar o diálogo atual no formato JSON em uma unidade USB ou em outro caminho de armazenamento clicando no botão Exportar na interface. O arquivo exportado contém os prompts completos e as respostas do modelo, facilitando a continuação do uso ou o arquivamento em outros dispositivos. Etapas:

- Clique na barra de menu do

导出Botão. - Selecione o caminho para salvar e nomeie o arquivo (a extensão padrão é

.json)。 - Depois de salvo, o arquivo pode ser visualizado em um editor de texto ou importado para outras ferramentas que suportam JSON.

5. otimização do desempenho

O programa é otimizado para hardware comum e não requer suporte de GPU. Ao carregar um modelo pela primeira vez, o programa armazena o modelo em cache na RAM para acelerar as respostas subsequentes. Se o seu computador tiver pouca RAM, é recomendável escolher um arquivo de modelo menor (menos de 1 GB). Nos testes, o programa atinge uma velocidade de geração de cerca de 20 tokens/segundo na CPU i7-10750H, o que é adequado para a maioria das tarefas diárias.

advertência

- Requisitos de hardwareRAM: Mínimo de 4 GB de RAM, recomenda-se 8 GB ou mais para garantir uma operação tranquila.

- Compatibilidade de modelosSomente modelos no formato GGUF são compatíveis, e não outros formatos, como PyTorch ou ONNX.

- sistema operacionalNo momento, apenas o Windows é compatível, não há versão para Mac ou Linux disponível no momento.

- PrivacidadeSegurança das informações: Todo o processamento é feito localmente, sem upload de dados, para garantir a segurança das informações.

cenário do aplicativo

- Uso temporário da estação de trabalho

Execute o Bloco de Notas Local do LLM a partir de um pen drive em um computador sem rede ou com acesso restrito (como um site de cliente ou uma instalação pública) para redigir rapidamente documentos, debater ideias ou responder a perguntas. - Mandatos sensíveis à privacidade

Para cenários que exigem um alto grau de confidencialidade, como a elaboração de documentos jurídicos ou a análise de dados confidenciais, a execução off-line garante que os dados não vazem e é adequada para advogados, jornalistas ou pesquisadores. - Educação e aprendizado

Alunos ou professores podem usar essa ferramenta em sala de aula para acessar modelos e explicar conceitos complexos digitando perguntas ou para gerar notas de estudo, adequadas para ambientes de ensino sem Internet. - Criatividade durante a viagem

Escritores ou criadores em trânsito usam um pen drive USB para executar o programa e registrar a inspiração, redigir artigos ou gerar conteúdo criativo a qualquer momento, sem depender de serviços baseados em nuvem.

QA

- Preciso fazer networking?

Não. O Bloco de Notas do LLM local é executado totalmente off-line, todos os cálculos são feitos localmente, sem necessidade de conexão com a Internet. - Quais são os modelos suportados?

Atualmente, há suporte para modelos de formato GGUF e modelos leves, comogemma-3-1b-it-Q4_K_M.ggufO usuário pode baixar modelos compatíveis de plataformas como Hug16.ging Face. Os usuários podem baixar modelos compatíveis de plataformas como Hug16.ging Face. - Ele funcionará em um Mac?

No momento, apenas o Windows é suportado; os usuários de Mac ou Linux terão que esperar por uma versão posterior ou usar uma máquina virtual para executá-lo. - Como garantir a velocidade de geração?

O programa é otimizado para a CPU e armazenado em cache na RAM quando o modelo é carregado pela primeira vez. Recomenda-se usar um dispositivo com mais de 8 GB de RAM e selecionar um modelo com menos de 1 GB para obter o melhor desempenho. - Como os registros de diálogo são salvos?

Salve o diálogo como um arquivo JSON para armazenamento em um pendrive ou outro dispositivo para facilitar a migração e o arquivamento por meio da função de exportação na barra de menus.