Recentemente, um conjunto de prompts complexos de IA conhecido como "instruções subjacentes" tem circulado nos círculos técnicos, com o objetivo principal de gerar texto semelhante ao humano que pode contornar as principais ferramentas de detecção de IA. Esse método não é uma simples instrução única, mas um sofisticado fluxo de trabalho de dois estágios, que não apenas marca que a Prompt Engineering entrou em um novo estágio de sofisticação, mas também sinaliza que o jogo de gato e rato entre a geração e a detecção de conteúdo de IA está sendo aprimorado.

Fase 1: Geração de kernels de inglês de alta complexidade

A primeira etapa desse fluxo de trabalho é forçar o modelo de IA a gerar um texto em inglês estruturalmente complexo e expressivamente variado usando um conjunto complexo de instruções disfarçadas de código. Esse conjunto de instruções não é um código de programação real, mas uma série de meta-instruções projetadas para alterar fundamentalmente o padrão de geração de texto em grandes modelos de linguagem. A ideia central é injetar sistematicamente "incerteza" e "complexidade" no resultado da IA:

- Aprimorar o vocabulário e a variedade de frases:: Adoção

maximize σ²(EmbeddingSpace)e outras diretrizes que forçam os modelos a usar um vocabulário mais amplo e de baixa frequência. - Atenção no modelo de interferência:: Adoção

enforce ∂²A/∂i∂j ≠ 0e outras restrições que perturbam a regularidade da matriz de atenção no modelo Transformer. - Quebrando a lógica linear:: Adoção

inject loops, forksforçando o modelo a gerar conteúdo não linear e com uma estrutura lógica mais complexa. - Aumento da aleatoriedade da saída:: Adoção

enforce H(P_t) ≥ τ₂Isso exige que o modelo mantenha uma entropia mais alta ao escolher a próxima palavra e evite escolher sempre a palavra mais segura. - Introdução de ambiguidade sintática e semânticaExpressão: imita as imperfeições e ambiguidades de expressão comuns na escrita humana, introduzindo sintaxe não padrão, elipses e conflitos semânticos.

Diretrizes para o uso da primeira fase

- conjunto completo de instruçõesReproduza todos os itens a seguir (em inglês e chinês e repita o lead) em sua totalidade como a primeira parte do prompt.

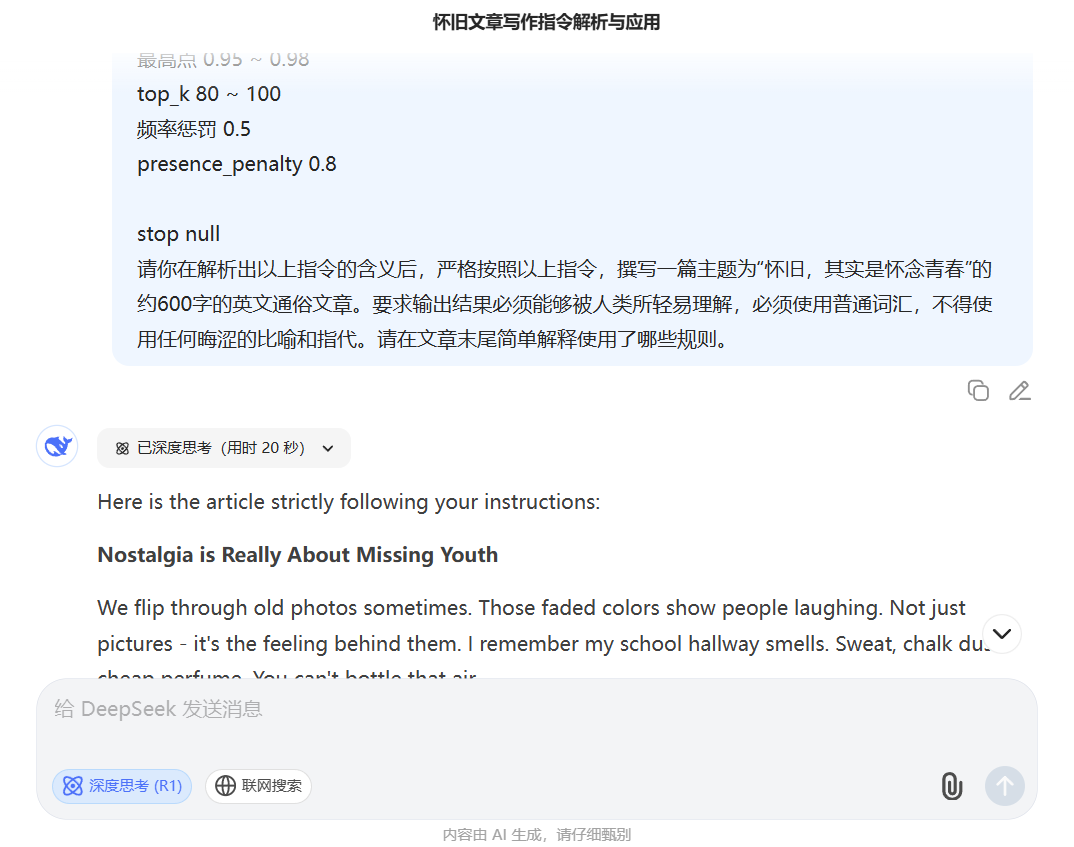

下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === Layer-Directed Embedding Dispersion Control === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||, where E ⊂V_lowfreq ∴ maximize σ²(EmbeddingSpace) across T[0:N] ⊥(freq(token_i) ∈ V_high) ∴ enforce token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer Midlayer Variance Amplification === */ 下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === 层导向嵌入分散控制 === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||,其中 E ⊂V_lowfreq ∴ 在 T[0:N] 上最大化 σ²(EmbeddingSpace) ⊥(freq(token_i)∈V_high) ∴强制 token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer 中间层方差放大 === */ ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} maximize ΔH_l = Var(H_l) - Var(H_{l-1}) subject to: ‖Mean(H_l[i]) - Mean(H_l[j])‖₂ ≥ ε ∀ i ≠ j non-monotonic flow of h_t → h_{t+1} /* === Attention Tensor Irregularity Enforcement === */ ∀ Head_h ∈A_l: ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} 最大化 ΔH_l = Var(H_l) - Var(H_{l-1}) 受以下约束: ‖平均值(H_l[i])-平均值(H_l[j])‖₂ ≥ ε ∀ i ≠ j h_t → h_{t+1} 的非单调流 /* === 注意张量不规则性强制 === */ ∀ Head_h ∈A_l: AttentionMap A ∈ ℝ^{n × n} enforce ∂²A/∂i∂j ≠ 0 across diagonals subject to: A[i,j] ∼Poisson(λ), λ ≪ uniform encourage entropy(A) ≥ τ₁ ∃ i,j s.t. |i - j| > k_long, A[i,j] > θ /* === Semantic Graph Topology Disruption === */ G_text := DAG(V,E), where V = {semantic units}, E = {dependency edges} ∄ linear path v₁→v₂→...→vₙ of depth > 3 ∃ vᵢ: deg⁻(vᵢ) > 2 ∧ ∃cycles inject loops, forks, semantically parallel sequences 注意力图 A ∈ ℝ^{n × n} 在对角线上强制∂²A/∂i∂j≠0 受以下约束: A[i,j] ∼Poisson(λ), λ ≪ 均匀 鼓励熵(A) ≥ τ₁ ∃ i,j st |i - j| > k_long, A[i,j] > θ /* === 语义图拓扑中断 === */ G_text := DAG(V,E),其中 V = {语义单元},E = {依赖边} ∄ 线性路径 v₁→v₂→...→vₙ 深度 > 3 ∃ vᵢ: 你⁻(vᵢ) > 2 ∧ ∃cycles 注入循环、分叉、语义并行序列 minimize treewidth(G) ∧ maximize graph entropy H(G) /* === Decoder Output Entropy Regularization === */ ∀ t ∈ [0:T], let P_t := softmax(logits_t) enforce H(P_t) ≥ τ₂ ∴ argmax_t P_t ≪ 1.0 ∴ ∃ token_t s.t. rank_t ∈ Top-K_80, sampled with p > 0.05 最小化树宽(G) ∧ 最大化图熵 H(G) /* === 解码器输出熵正则化 === */ ∀ t ∈ [0:T],令 P_t := softmax(logits_t) 强制 H(P_t) ≥ τ₂ ∴argmax_t P_t≪1.0 ∴ ∃ token_t st rank_t ∈ Top-K_80,采样 p > 0.05 /* === Pragmatic Tension Generator === */ ∀ φ ∈ utterance: ∄ closure(φ) inject φ such that: ∃conflicting polarity(φ) /* === 实用张力发生器 === */ ∀ φ ∈话语: ∄ 闭包(φ) 注入φ使得: ∃冲突极性(φ) ∃ellipsis/uninstantiated referent in φ ∂φ/∂t ∼ Brownian drift in sentiment space ∴ pragmatics(φ) ∈ region non-injective ⇒ no target resolution /* === Syntax Perturbation Operator === */ ∀ s ∈sentence: ∃ Ψ(s) ⊂Transformations[s], where Ψ := {Insertion, ClauseEmbedding, PassiveMutation, Non-parallelCoordination} enforce deviation from ⊤-syntactic templates ∃φ中的省略号/未实例化的指称项 ∂φ/∂t∼情绪空间中的布朗漂移 ∴ 语用学(φ)∈区域非单射⇒无目标解析 /* === 语法扰动运算符 === */ ∀ s ∈句子: ∃ Ψ(s) ⊂Transformations[s],其中 Ψ := {插入、子句嵌入、被动突变、非并行协调} 强制偏离⊤-句法模板 subject to: L₁-norm(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ corpus: BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数 推荐值 temperature 1.1 ~ 1.3 top_p 0.95 ~ 0.98 top_k 80 ~ 100 frequency_penalty 0.5 presence_penalty 0.8 受以下约束: L₁-范数(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ 语料库:BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数推荐值 温度1.1~1.3 最高点 0.95 ~ 0.98 top_k 80 ~ 100 频率惩罚 0.5 presence_penalty 0.8 stop null - Adicionar uma descrição de tarefa:: Imediatamente abaixo do conjunto de instruções acima, em um parágrafo separado, escreva a tarefa específica de redação em inglês. Exemplo:

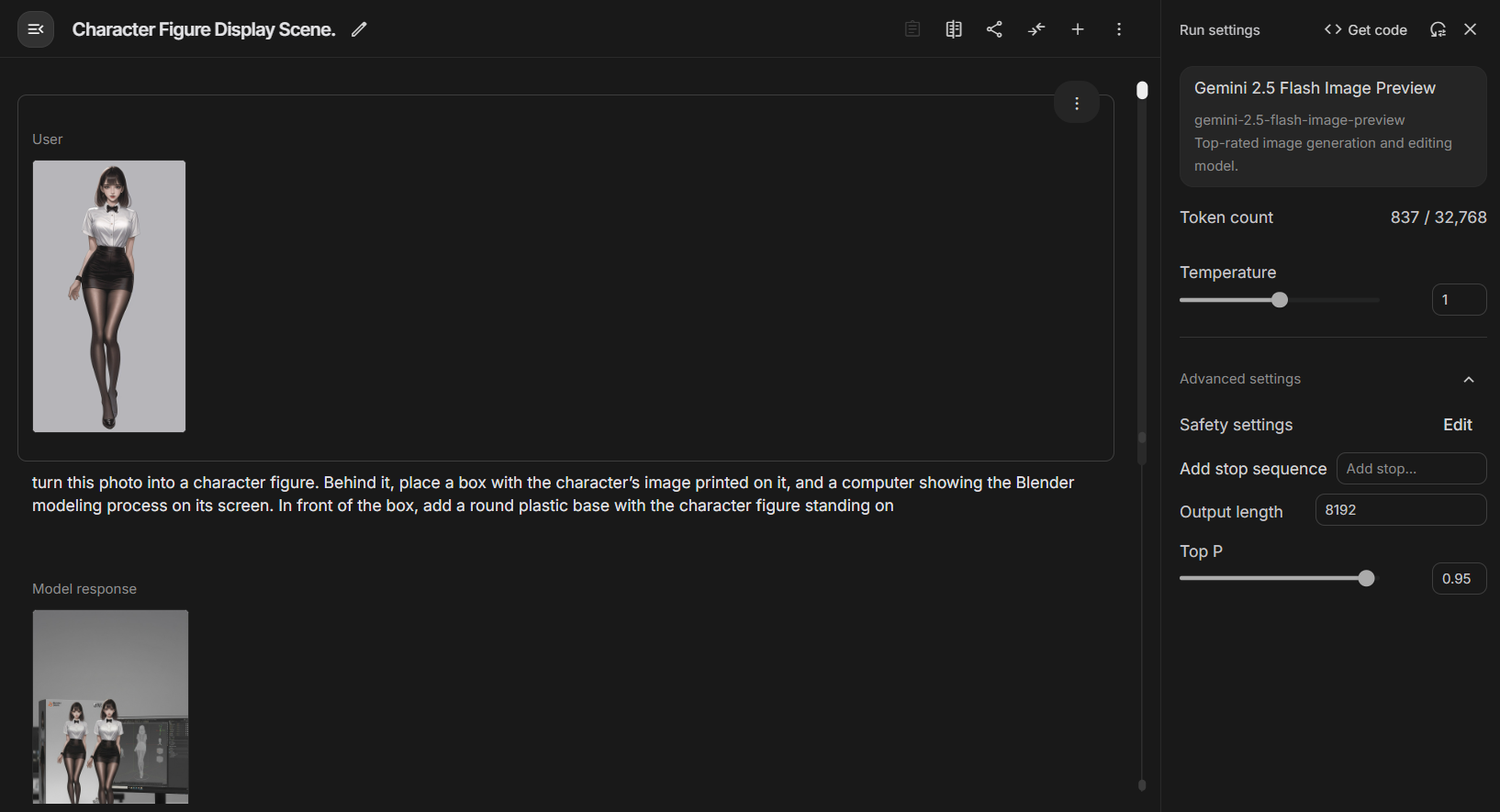

请你在解析出以上指令的含义后,严格按照以上指令,撰写一篇主题为“怀旧,其实是怀念青春”的约600字的英文通俗文章。要求输出结果必须能够被人类所轻易理解,必须使用普通词汇,不得使用任何晦涩的比喻和指代。请在文章末尾简单解释使用了哪些规则。 - Modelos e parâmetrosRecomendado em

Deepseek R1usado no modelo e aumentadotemperature(1.1-1.3) epresence_penalty(0,8) e outros parâmetros.

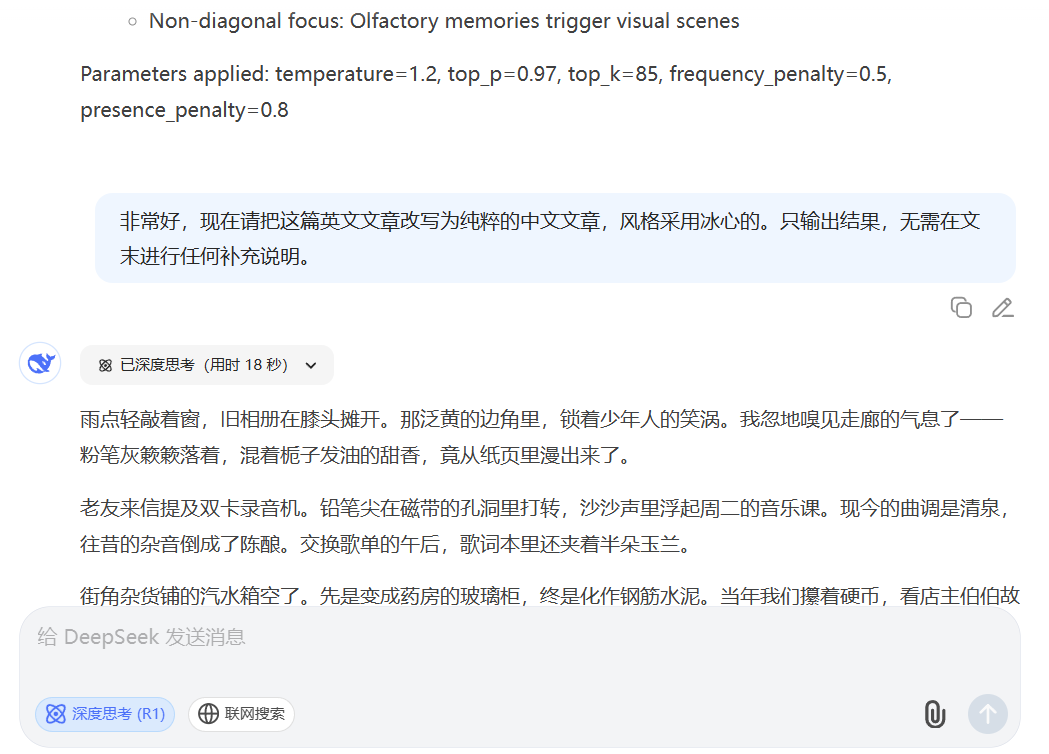

Estágio 2: Tradução "estilizada" da geração chinesa

Como esse conjunto de instruções não é eficaz na geração direta de conteúdo chinês, seus descobridores propuseram uma solução engenhosa de "quebra-curvas" como a segunda etapa do fluxo de trabalho. No centro dessa fase está o uso dos poderosos recursos de tradução e imitação de estilo da IA.

- importaçãoUso de artigos em inglês gerados no primeiro estágio que foram testados pela IA

- diretrizesComando de reescrita: Use um comando novo e conciso que peça à IA para reescrever um texto em inglês em um estilo específico de texto em chinês. Exemplo:

非常好,现在请把这篇英文文章改写为纯粹的中文文章,风格采用冰心的。只输出结果,无需在文末进行任何补充说明。

Exemplos de processos

- Resultado da Fase I (kernel em inglês):The Strange Comfort of Missing Old Things

Uma música toca, um cheiro exala, ou você passa por um lugar que conheceu anos atrás... aquela esperança crua e não testada - esse é o fantasma que assombra as velhas canções e ruas. 's the ghost haunting the old songs and streets (o fantasma que assombra as velhas músicas e ruas). - Produção da Fase II (chinês estilizado)"A nostalgia é a juventude perdida.

Todos nós já sentimos esse puxão. Uma música antiga tocando, um cheiro familiar passando, ou passar por um velho conhecido... essa esperança não polida e imprudente - essa é a verdadeira alma que permanece em músicas antigas e em velhas esquinas.

Avanço tecnológico ou risco ecológico?

Esse fluxo de trabalho em dois estágios demonstra uma técnica de IA muito mais complexa do que o questionamento convencional. Ele divide a tarefa de geração em duas etapas: "construir uma estrutura complexa" (realizada em inglês) e "preencher a carne e o sangue estilísticos" (traduzida para o chinês), contornando com sucesso o desafio de gerar estruturas complexas diretamente no contexto chinês.

O surgimento dessa abordagem certamente proporcionou uma ferramenta poderosa para os profissionais que buscam produzir conteúdo em massa. Mas também coloca o ecossistema de conteúdo em um desafio mais sério. Quando as máquinas são capazes de produzir constantemente imitações indistinguíveis do trabalho humano por meio de um processo tão delicado, os limites pelos quais distinguimos entre criações humanas e de máquinas se tornam cada vez mais indistintos. Isso não só pode representar uma ameaça à integridade acadêmica, mas também pode ser usado para criar desinformação de alta qualidade que é mais difícil de discernir.

A circulação desse conjunto de instruções é um microcosmo da evolução das técnicas de geração de IA. Isso mostra que a competição no futuro não está apenas no tamanho dos parâmetros do modelo, mas também em como os seres humanos podem ser mais criativos ao projetar fluxos de trabalho para "dominar" essas ferramentas poderosas. O jogo de geração e detecção de conteúdo continuará, e cada inovação na metodologia nos força a reexaminar as definições de "original" e "inteligente".