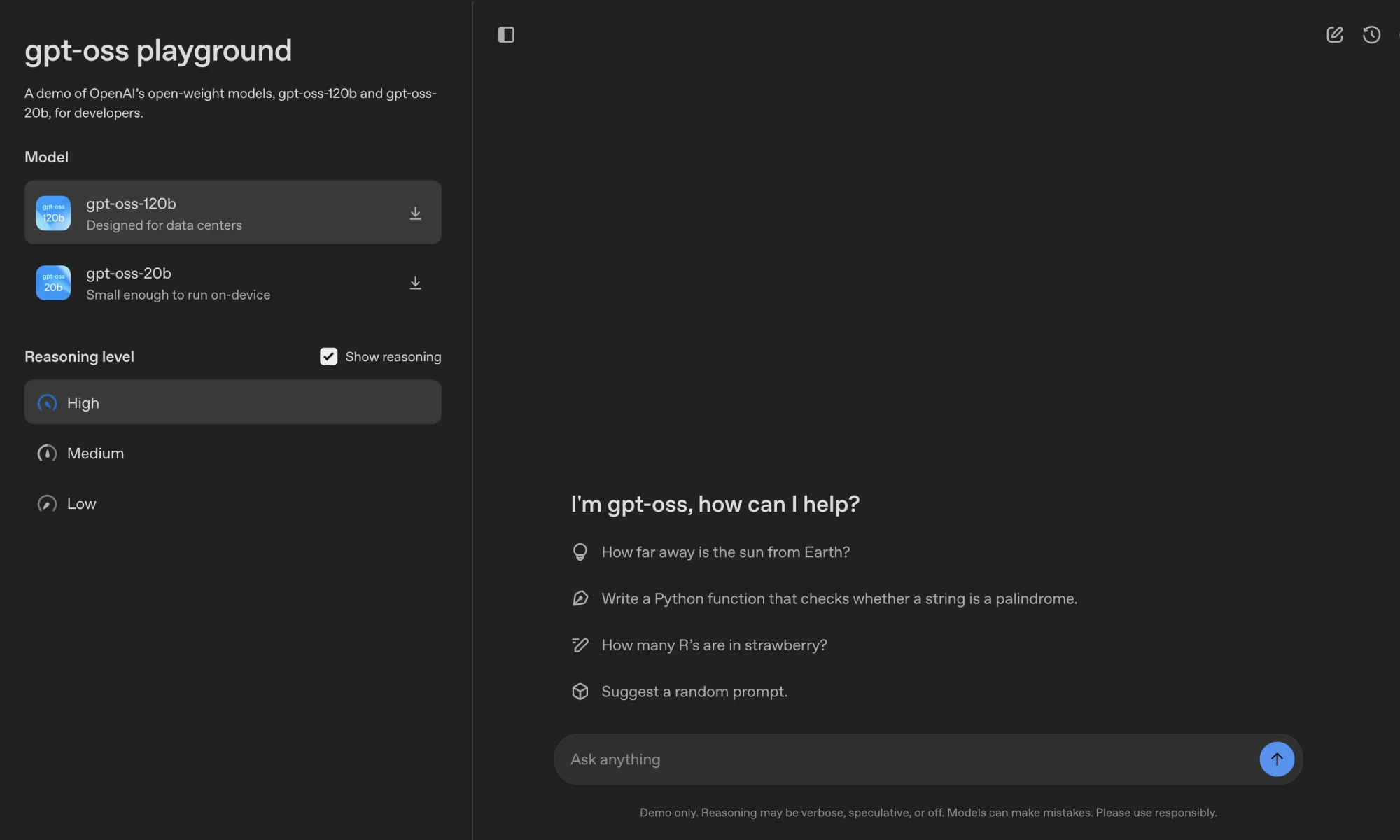

O GPT-OSS é uma família de modelos de linguagem de código aberto da OpenAI, incluindo gpt-oss-120b 和 gpt-oss-20bA versão mais recente do software, que tem 117 bilhões e 21 bilhões de parâmetros, respectivamente, está licenciada sob a licença Apache 2.0, que permite que os desenvolvedores façam download, modifiquem e implementem o software gratuitamente.gpt-oss-120b Ideal para datacenters ou equipamentos de ponta, executado em uma única GPU Nvidia H100;gpt-oss-20b Para cenários de baixa latência, ele é executado em dispositivos com 16 GB de RAM. Os modelos suportam inferência encadeada, chamadas de ferramentas e saídas estruturadas para tarefas de corpo inteligente e aplicativos localizados. O OpenAI garante a segurança do modelo por meio de treinamento seguro e auditoria externa, tornando-o adequado para desenvolvedores empresariais, de pesquisa e individuais.

Lista de funções

- Download de modelos de código aberto: Fornecido

gpt-oss-120b和gpt-oss-20bPesos do modelo, disponíveis gratuitamente na plataforma Hugging Face. - Raciocínio eficiente: quantificado usando MXFP4.

gpt-oss-120bem execução em uma única GPU.gpt-oss-20bCompatível com dispositivos de 16 GB de RAM. - raciocínio lógicoSuporte a forças de inferência baixas, médias e altas, e os desenvolvedores podem ajustar o desempenho e a latência de acordo com a tarefa.

- Chamada de ferramentaIntegração de pesquisa na Web, execução de código Python e ferramentas de manipulação de arquivos para melhorar a interatividade.

- Formato HarmonyUso do formato de resposta proprietário do Harmony garante que a saída seja estruturada para facilitar a depuração.

- Suporte a várias plataformasCompatível com Transformers, vLLM, Ollama, LM Studio e outras estruturas, adaptado a uma variedade de hardwares.

- mecanismo de segurançaRedução de riscos, como injeção de ponta, por meio de alinhamento prudente e sistemas de priorização de instruções.

- aparávelSuporte ao ajuste fino total dos parâmetros para se adaptar a cenários específicos de tarefas.

- Suporte a contextos longosSuporte nativo a 128k de comprimento de contexto para tarefas complexas.

Usando a Ajuda

Processo de instalação

Para usar o modelo GPT-OSS, faça o download dos pesos do modelo e configure o ambiente. Veja a seguir as etapas detalhadas:

- Download dos pesos do modelo

Obtenha os pesos dos modelos na Hugging Face:huggingface-cli download openai/gpt-oss-120b --include "original/*" --local-dir gpt-oss-120b/ huggingface-cli download openai/gpt-oss-20b --include "original/*" --local-dir gpt-oss-20b/Garantir a instalação

huggingface-cli:pip install huggingface_hub。 - Configuração do ambiente Python

Criando um ambiente virtual com o Python 3.12:uv venv gpt-oss --python 3.12 source gpt-oss/bin/activate pip install --upgrade pipInstale a dependência:

pip install transformers accelerate torch pip install gpt-ossPara implementações do Triton, é necessária uma instalação adicional:

git clone https://github.com/triton-lang/triton cd triton pip install -r python/requirements.txt pip install -e . pip install gpt-oss[triton] - modelo operacional

- Realização de TransformersCarregamento e execução

gpt-oss-20b:from transformers import pipeline import torch model_id = "openai/gpt-oss-20b" pipe = pipeline("text-generation", model=model_id, torch_dtype="auto", device_map="auto") messages = [{"role": "user", "content": "量子力学是什么?"}] outputs = pipe(messages, max_new_tokens=256) print(outputs[0]["generated_text"][-1])Certifique-se de usar o formato Harmony ou o modelo não funcionará corretamente.

- Implementação da vLLMIniciar um servidor compatível com OpenAI:

uv pip install --pre vllm==0.10.1+gptoss --extra-index-url https://wheels.vllm.ai/gpt-oss/ vllm serve openai/gpt-oss-20b - Realização Ollama(hardware de nível de consumidor):

ollama pull gpt-oss:20b ollama run gpt-oss:20b - Implementação do LM Studio:

lms get openai/gpt-oss-20b - Realização de silício da AppleConverter pesos em formato de metal:

pip install -e .[metal] python gpt_oss/metal/scripts/create-local-model.py -s gpt-oss-20b/metal/ -d model.bin python gpt_oss/metal/examples/generate.py gpt-oss-20b/metal/model.bin -p "为什么鸡过马路?"

- Realização de TransformersCarregamento e execução

função operacional

- raciocínio lógicoO modelo suporta três pontos fortes de inferência (baixo, médio e alto). O desenvolvedor pode definir isso por meio de uma mensagem do sistema, por exemplo:

system_message_content = SystemContent.new().with_reasoning_effort("high")A alta intensidade é boa para tarefas complexas, como raciocínio matemático, e a baixa intensidade é boa para respostas rápidas.

- Formato HarmonyA saída do modelo é dividida em

analysis(processo de raciocínio) efinal(Resposta final). Analisado usando a biblioteca Harmony:from openai_harmony import load_harmony_encoding, HarmonyEncodingName, Conversation, Message, Role, SystemContent encoding = load_harmony_encoding(HarmonyEncodingName.HARMONY_GPT_OSS) messages = [Message.from_role_and_content(Role.USER, "旧金山天气如何?")] conversation = Conversation.from_messages(messages) token_ids = encoding.render_conversation_for_completion(conversation, Role.ASSISTANT)Mostrar apenas para usuários

finalConteúdo do canal. - Chamada de ferramenta:

- Pesquisa na Web: através de

browserFerramentas para pesquisar, abrir ou localizar conteúdo da Web. Habilite a ferramenta:from gpt_oss.tools.simple_browser import SimpleBrowserTool, ExaBackend backend = ExaBackend(source="web") browser_tool = SimpleBrowserTool(backend=backend) system_message_content = SystemContent.new().with_tools(browser_tool.tool_config)requerem uma configuração

EXA_API_KEYVariáveis de ambiente. - Execução de código PythonExecutar tarefas de computação, por exemplo:

from gpt_oss.tools.python_docker.docker_tool import PythonTool python_tool = PythonTool() system_message_content = SystemContent.new().with_tools(python_tool.tool_config)Observação: as ferramentas Python usam contêineres do Docker e precisam lidar com o risco de injeção imediata com cuidado.

- operação de arquivo: através de

apply_patchpara criar, atualizar ou excluir arquivos.

- Pesquisa na Web: através de

- Saída estruturadaSuporte ao formato da API de respostas para garantir uma saída consistente, adequada para fluxos de trabalho de corpos inteligentes.

advertência

- Requisitos de hardware:

gpt-oss-120bÉ necessária uma GPU de 80 GB (por exemplo, Nvidia H100).gpt-oss-20bSão necessários 16 GB de RAM. O Apple Silicon requer pesos no formato Metal. - Comprimento do contextoSuporte a contextos de 128k: precisa ser ajustado

max_context_lengthParâmetros. - Uso seguroEvite a exibição direta de conteúdo de raciocínio encadeado para evitar a divulgação de informações prejudiciais.

- Parâmetros de amostragem: Recomendações

temperature=1.0和top_p=1.0para obter o melhor resultado.

cenário do aplicativo

- Implantação de localização corporativa

As organizações podem executar o GPT-OSS em servidores locais para lidar com dados confidenciais, adequados para atendimento ao cliente, bases de conhecimento internas ou cenários críticos de conformidade. - Personalização do desenvolvedor

Os desenvolvedores podem ajustar o modelo com base na licença Apache 2.0 para otimizar tarefas específicas, como a análise de documentos jurídicos ou a geração de códigos. - pesquisa acadêmica

Os pesquisadores podem usar os modelos para fazer experiências com algoritmos de IA, analisar o comportamento de raciocínio ou desenvolver sistemas de monitoramento de segurança. - Aplicativos para dispositivos de consumo

gpt-oss-20bAdaptável a laptops ou dispositivos de ponta, adequado para o desenvolvimento de assistentes pessoais ou ferramentas de escrita off-line.

QA

- Qual é o hardware suportado pelo GPT-OSS?

gpt-oss-120bÉ necessária uma GPU de 80 GB (por exemplo, Nvidia H100).gpt-oss-20bFunciona em dispositivos com 16 GB de RAM, como laptops de última geração ou o Apple Silicon. - Como faço para proteger meu modelo?

Os modelos são treinados com alinhamento prudente e priorização de instruções para resistir à injeção de dicas. A OpenAI organiza o $500,000 Red Team Challenge para incentivar a comunidade a descobrir vulnerabilidades de segurança. - Há suporte multimodal?

Somente entrada e saída de texto são suportadas, não imagens ou outras modalidades. - Como posso fazer o ajuste fino do modelo?

Ajuste fino completo dos parâmetros em um conjunto de dados personalizado após o carregamento dos pesos do modelo, usando Transformers ou outras estruturas. - O que o formato Harmony faz?

O formato Harmony garante uma saída estruturada para facilitar a depuração e a confiança. Ele deve ser usado ou o modelo não funcionará corretamente.