Em seguida, o Google introduziu modelos de código aberto para execução em uma única nuvem ou acelerador de desktop Gemma 3 Depois da QAT com o Gemma 3, a empresa está expandindo sua pegada para a IA generalizada. Se o Gemma 3 trouxe recursos avançados de nuvem e desktop para os desenvolvedores, este lançamento prévio do Gemma 3n em 20 de maio de 2025 revela claramente suas ambições para IA em tempo real no lado do dispositivo móvel - com o objetivo de fazer com que os telefones, tablets e laptops que usamos todos os dias sejam executados diretamente com IA de alto desempenho diretamente nos telefones celulares, tablets e laptops que usamos todos os dias.

Para impulsionar a próxima geração de IA no lado final e oferecer suporte a diversos cenários de aplicativos, incluindo aprimoramentos adicionais ao Gêmeos Para otimizar os recursos do Nano, a equipe de engenharia do Google criou uma nova arquitetura de ponta. Alegando ser o resultado de uma estreita colaboração com líderes de hardware móvel, como a Qualcomm, a MediaTek e a empresa System LSI da Samsung, essa nova arquitetura é otimizada para uma resposta extremamente rápida e processamento de IA multimodal, e foi projetada para oferecer uma experiência inteligente verdadeiramente personalizada e privada diretamente no dispositivo.

O Gemma 3n é o primeiro modelo aberto criado com base nessa arquitetura compartilhada inovadora, permitindo que os desenvolvedores experimentem a tecnologia por meio de uma visualização antecipada a partir de hoje. Notavelmente, a mesma arquitetura avançada também capacitará a próxima geração do Gemini Nano, trazendo aprimoramentos para uma ampla gama de recursos do Google Apps e seu ecossistema final, e está programada para entrar em operação ainda este ano. Isso significa que, ao começar a usar o Gemma 3n, os desenvolvedores estão, na verdade, se preparando para uma tecnologia subjacente que em breve chegará às principais plataformas, como o Android (Android) e o Chrome.

Observação: este gráfico classifica os modelos de IA com base na pontuação Elo do Chatbot Arena; pontuações mais altas (números superiores) indicam maior preferência do usuário.

Uma inovação fundamental do Gemma 3n é o uso da tecnologia Per-Layer Embeddings (PLE) do Google DeepMind, que reduz significativamente o uso de memória (RAM) dos modelos. Embora as contagens de parâmetros originais dos modelos sejam de 5 bilhões (5B) e 8 bilhões (8B), a PLE permite que os modelos sejam executados com sobrecargas de memória comparáveis às dos tamanhos de parâmetros de 2 bilhões (2B) e 4 bilhões (4B). Especificamente, eles podem ser executados com pegadas de memória dinâmica de apenas 2 GB e 3 GB. Esse avanço é uma grande vantagem para dispositivos móveis com restrições de memória. Mais detalhes técnicos podem ser encontrados na documentação oficial.

Ao explorar o Gemma 3n, os desenvolvedores podem dar uma olhada nos principais recursos desse modelo de código aberto e nas inovações arquitetônicas que priorizam os dispositivos móveis e que chegarão às plataformas Android e Chrome com o Gemini Nano.

Perfil dos principais recursos do Gemma 3n

O Gemma 3n foi projetado para proporcionar uma experiência de IA rápida e com baixo consumo de recursos, executada localmente com os seguintes recursos principais:

- Desempenho e eficiência otimizados no lado finalEm comparação com o modelo Gemma 3 4B, o Gemma 3n oferece uma inicialização de resposta aproximadamente 1,5 vezes mais rápida em dispositivos móveis, além de uma melhoria significativa na qualidade da saída do modelo. Isso é possível graças a inovações como a incorporação camada por camada (PLE), o compartilhamento de cache de valor-chave (compartilhamento KVC) e a quantificação de ativação avançada, que, juntos, reduzem o espaço de memória.

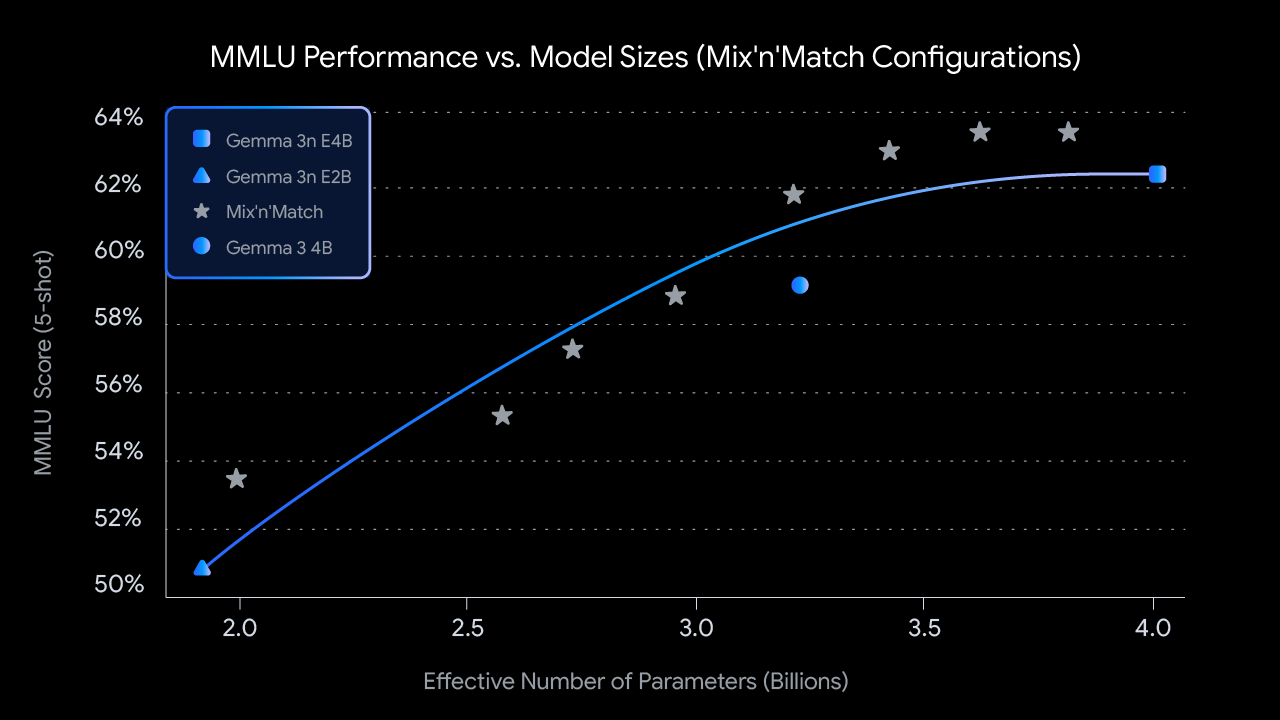

- Flexibilidade "Muitos em 1A versão com pegada de memória ativa de 4B do Gemma 3n inclui naturalmente um submodelo aninhado com pegada de memória ativa de 2B, líder do setor, dentro da tecnologia de treinamento MatFormer. Esse design oferece ao modelo a flexibilidade de fazer uma troca dinâmica entre desempenho e qualidade sem a necessidade de hospedar vários modelos independentes. O mais interessante é que o Gemma 3n apresenta um recurso "mix'n'match" que permite que submodelos sejam criados dinamicamente a partir do modelo 4B para se adequar de forma ideal a um caso de uso específico e aos requisitos de qualidade/latência associados. Mais detalhes sobre essa pesquisa serão divulgados em um relatório técnico a ser publicado em breve.

- Privacidade em primeiro lugar e disponibilidade off-lineO recurso de execução local garante que a função opere com respeito à privacidade do usuário e funcione de forma confiável mesmo quando não houver conexão de rede.

- Compreensão multimodal de áudio estendidaGemma 3n não apenas compreende e processa áudio, texto e imagens, mas também aprimora significativamente a compreensão de vídeo. Seus recursos de áudio permitem que o modelo execute reconhecimento automático de fala (transcrição) e tradução (fala para texto traduzido) de alta qualidade. Além disso, o modelo aceita entradas intercaladas entre modalidades, o que lhe permite compreender interações multimodais complexas. (Implementação pública em breve)

- Recursos multilíngues aprimoradosGemma 3n: o Gemma 3n melhorou o desempenho multilíngue, especialmente em japonês, alemão, coreano, espanhol e francês. Ele alcançou

50.1%O WMT (Workshop on Machine Translation) é uma avaliação importante no campo da tradução automática, e o ChrF é um índice de avaliação comumente usado para tradução automática.

Observação: este gráfico mostra o desempenho do MMLU do recurso "mix-n-match" (pré-treinamento) do Gemma 3n para diferentes tamanhos de modelos. O MMLU (Massive Multitask Language Understanding) é um teste de referência abrangente de compreensão de linguagem.

Desbloqueando o potencial de novas experiências móveis

Espera-se que o Gemma 3n capacite uma nova onda de aplicativos móveis inteligentes até

- Criação de experiências interativas em tempo realCapacidade de entender e responder a sinais visuais e auditivos em tempo real do ambiente do usuário.

- Promover uma compreensão mais profundaUsando uma combinação de entradas de áudio, imagem, vídeo e texto, as informações são processadas de forma privada no dispositivo para permitir a geração de textos mais contextuais.

- Desenvolvimento de aplicativos avançados para centros de áudioInclui transcrição de voz em tempo real, tradução e interação avançada orientada por voz.

O vídeo a seguir descreve os tipos de experiências que você pode criar:

Co-construção responsável

O compromisso com o desenvolvimento responsável da IA é essencial. Assim como todos os modelos da família Gemma, o Gemma 3n foi submetido a rigorosas avaliações de segurança, governança de dados e calibração refinada, de acordo com suas políticas de segurança. Por sua vez, o Google afirma que aborda os modelos abertos com uma avaliação cuidadosa dos riscos e continua a refinar suas práticas à medida que o cenário da IA evolui.

Análise aprofundada dos parâmetros do modelo Gemma 3n

O Gemma 3n é um modelo de IA generativo otimizado para uso em dispositivos de uso diário, como telefones celulares, laptops e tablets. O modelo incorpora inovações no processamento eficiente de parâmetros, como o já mencionado cache de parâmetros de incorporação camada por camada (PLE), bem como a arquitetura do modelo MatFormer, que oferece flexibilidade para reduzir os requisitos de computação e memória. Os modelos são capazes de processar entradas de áudio, bem como dados textuais e visuais.

Fase de visualização e licenciamentoGemma 3n: O Gemma 3n está em fase de pré-visualização. Os usuários podem saber mais sobre o Gemma 3n na página Estúdio de IA do Google e Google AI Edge para experimentá-lo. Como outros modelos Gemma, o Gemma 3n oferece pesos abertos e é licenciado para uso comercial responsável, permitindo que os desenvolvedores o ajustem e implementem em seus próprios projetos e aplicativos.

Os principais recursos do Gemma 3n podem ser refinados em nível técnico como

- entrada de áudioProcessamento de dados sonoros para reconhecimento de fala, tradução e análise de dados de áudio.

- Entrada visual e de textoRecursos multimodais: os recursos multimodais permitem que ele processe informações visuais, de áudio e textuais para ajudar a entender e analisar o mundo ao seu redor.

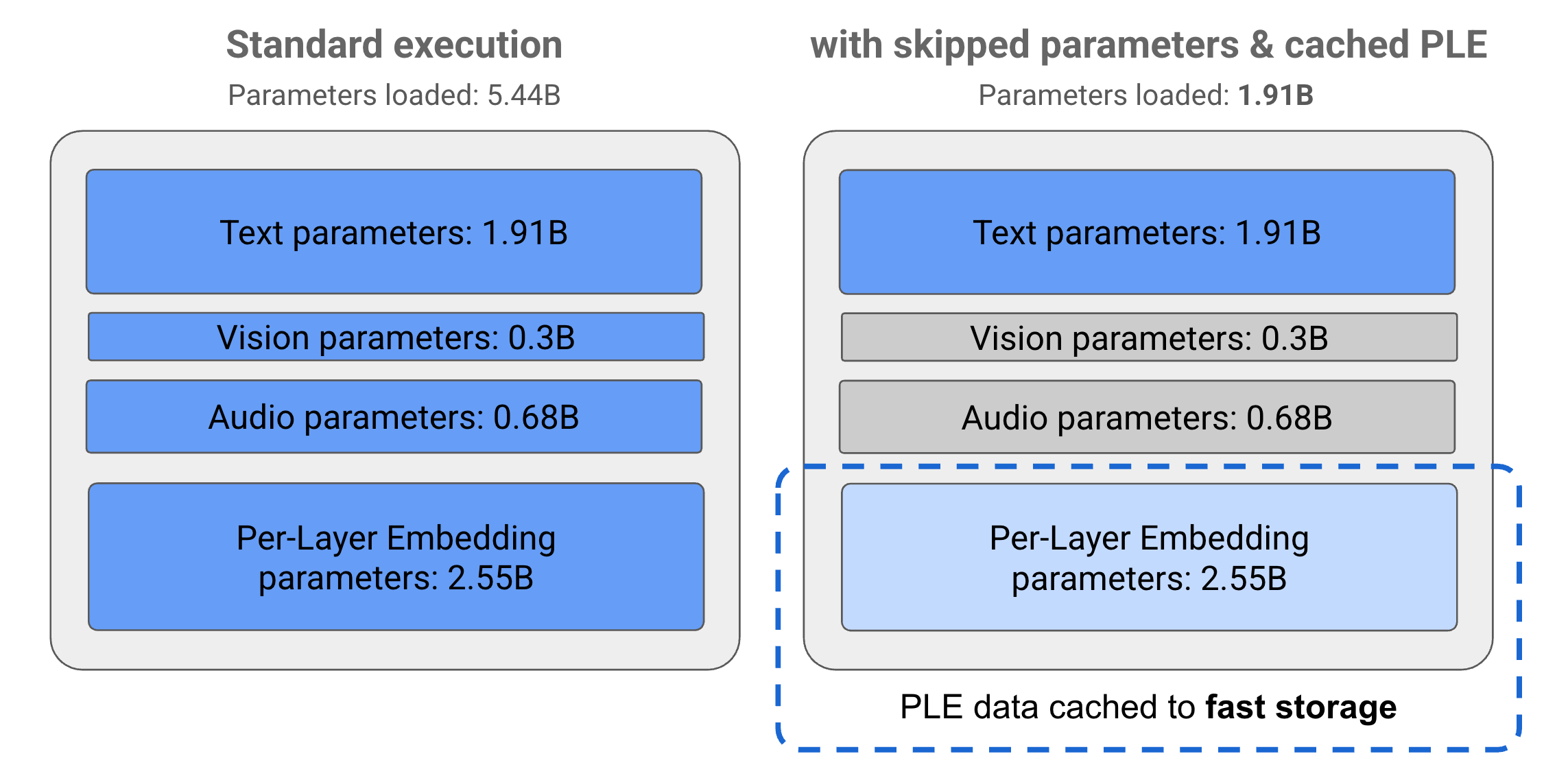

- Cache de PLEOs parâmetros do Layer-by-Layer Embedding (PLE) contidos no modelo podem ser armazenados em cache no armazenamento local rápido para reduzir os custos de memória no tempo de execução do modelo. Esses dados de PLE são usados durante a execução do modelo para criar dados que aprimoram o desempenho de cada camada do modelo, reduzindo o consumo de recursos e melhorando a qualidade da resposta do modelo ao excluir os parâmetros de PLE do espaço da memória principal do modelo.

- Arquitetura do MatFormer:: "estilo camisinha" Transformador (Matryoshka Transformer) com modelos menores aninhados em um modelo maior. Esses submodelos aninhados podem ser invocados em resposta a uma solicitação sem ativar os parâmetros completos do modelo externo. Essa capacidade de executar somente os modelos centrais menores dentro de um modelo MatFormer pode reduzir significativamente o custo computacional, o tempo de resposta e o consumo de energia do modelo. Para o Gemma 3n, somente o modelo E4B contém E2B parâmetros do modelo. A arquitetura também permite que os desenvolvedores selecionem parâmetros e montem modelos de tamanhos intermediários entre 2B e 4B. Mais detalhes podem ser encontrados no artigo de pesquisa do MatFormer.

- Carregamento condicional de parâmetrosParâmetros de PLE: Semelhante aos parâmetros de PLE, determinados parâmetros no modelo (por exemplo, parâmetros de áudio ou visuais) podem ser seletivamente ignorados e não carregados na memória para reduzir a carga de memória. Esses parâmetros podem ser carregados dinamicamente em tempo de execução se o dispositivo tiver os recursos necessários. De modo geral, a omissão de parâmetros pode reduzir ainda mais a quantidade de memória de tempo de execução exigida pelos modelos Gemma 3n, permitindo que eles sejam executados em uma variedade maior de dispositivos e que os desenvolvedores sejam mais eficientes em termos de recursos para tarefas menos exigentes.

- Amplo suporte a idiomasConhecimento extenso de idiomas, com treinamento em mais de 140 idiomas.

- Contexto de token de 32KComprimento do contexto de entrada: fornece comprimento de contexto de entrada suficiente para analisar dados e processar tarefas.

chamar a atenção para algoPara obter mais informações, consulte a documentação do desenvolvedor do Gemini Nano para Android (Android).

O mistério dos parâmetros do modelo e dos "parâmetros efetivos"

O modelo Gemma 3n é nomeado com um nome como E2B responder cantando E4B Contagens de parâmetros que são inferiores ao número total de parâmetros incluídos no modelo. Prefixos E Isso indica que os modelos podem operar com um conjunto simplificado de parâmetros efetivos. Essa manipulação simplificada de parâmetros é possível graças às técnicas flexíveis de parametrização incorporadas aos modelos Gemma 3n, o que os ajuda a funcionar de forma eficiente em equipamentos com poucos recursos.

Os parâmetros do modelo Gemma 3n são divididos em quatro grupos principais: parâmetros textuais, visuais, de áudio e de incorporação camada por camada (PLE). No modo de execução padrão do modelo E2B, mais de 5 bilhões de parâmetros são carregados no tempo de execução. No entanto, com a utilização de técnicas de cache de PLE e de salto de parâmetros, o modelo é capaz de ser executado com uma carga de memória efetiva de cerca de 2 bilhões (1,91B) de parâmetros, conforme mostrado na figura abaixo.

Figura 1. Parâmetros do modelo Gemma 3n E2B no modo de execução padrão em comparação com o uso de técnicas de cache de PLE e de salto de parâmetros para obter cargas de parâmetros efetivamente menores.

Usando essas técnicas de descarregamento de parâmetros e ativação seletiva, é possível executar o modelo com um conjunto muito condensado de parâmetros ou ativar parâmetros adicionais para lidar com outros tipos de dados, como visuais e de áudio. Esses recursos oferecem aos usuários a flexibilidade para adaptar a funcionalidade do modelo aos recursos do dispositivo ou aos requisitos da tarefa.

Primeiros passos: Pré-visualização do Gemma 3n

Um teste antecipado do Gemma 3n já está aberto:

- Exploração da nuvem com o Google AI StudioAcesse o Google diretamente em seu navegador, sem necessidade de configuração! Estúdio de IA Experimente o Gemma 3n agora e explore seus recursos de entrada de texto instantaneamente.

- Desenvolvimento do lado final com o Google AI EdgePara os desenvolvedores que desejam integrar o Gemma 3n localmente, o Google AI Edge fornece as ferramentas e as bibliotecas para isso. Atualmente, é possível começar a usar seus recursos de compreensão/geração de texto e imagem.

O Gemma 3n marca uma nova etapa na popularização da IA eficiente e de ponta. À medida que a tecnologia se abre, é empolgante ver as inovações que ela trará para a comunidade de desenvolvedores, começando com a prévia de hoje.

Você pode explorar esse anúncio e todo o seu conteúdo no io.google a partir de 22 de maio. Google I/O 2025 A atualização.

Interessado em começar a construir? Por que não começar com o Guia de Introdução para Modelos Gemma.