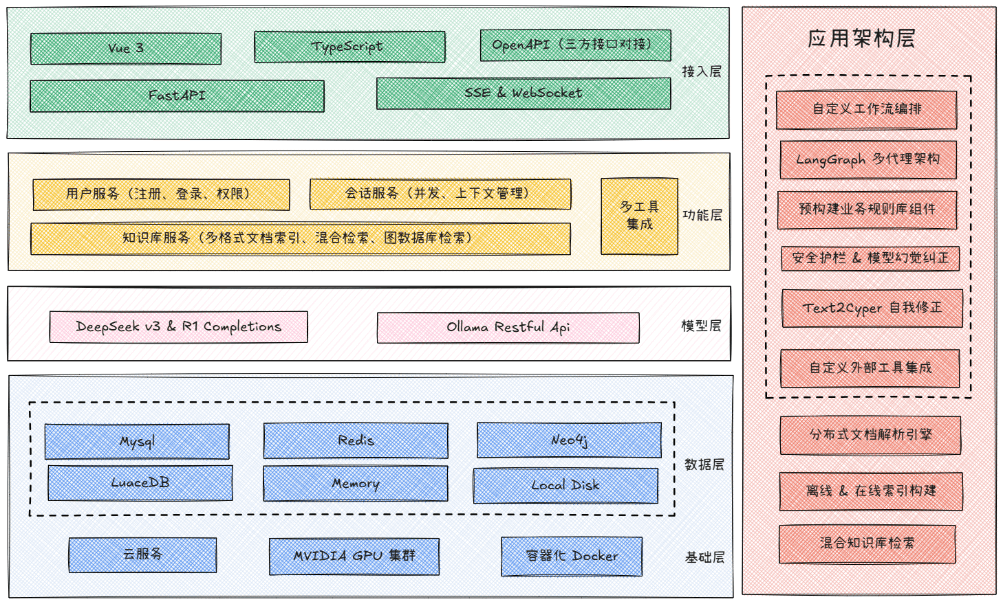

O GBC MedAI é um sistema de assistente médico inteligente de código aberto. Ele usa o FastAPI como estrutura de back-end e o Vue 3 como pilha de tecnologia de front-end. O principal recurso desse sistema está na capacidade de integrar vários modelos de big language de IA ao mesmo tempo, como o DeepSeek, implantado localmente Ollama e outros modelos compatíveis com a interface OpenAI. Ele também integra uma variedade de serviços de mecanismos de pesquisa para oferecer aos usuários funções inteligentes de diálogo e pesquisa que incorporam informações em tempo real. Com uma arquitetura modular e uma pilha de tecnologia avançada e completa, o projeto tem como objetivo fornecer uma solução de assistente de IA que possa ser implantada rapidamente e desenvolvida secundariamente para a área médica ou outros cenários profissionais.

Lista de funções

- Recursos de IASuporte ao acesso ao DeepSeek, aos modelos locais do Ollama e a uma variedade de modelos de IA compatíveis com o OpenAI. O sistema tem a capacidade de lidar com tarefas complexas de raciocínio e compreensão visual, e pode analisar imagens carregadas.

- Pesquisa inteligenteIntegração do Boca AI, Baidu AI Search e SerpAPI: a integração do Boca AI, Baidu AI Search e SerpAPI permite a seleção automática do mecanismo de pesquisa mais adequado com base na pergunta e o acesso às informações médicas mais recentes e ao progresso das pesquisas.

- sistema de diálogoResposta de streaming suave e recursos de memória contextual. O sistema tem um mecanismo completo de autenticação de usuário integrado e de gerenciamento de várias sessões v para salvar o histórico.

- Front-end modernoInterface do usuário: Criado com Vue 3 e TypeScript, ele oferece um layout responsivo e é compatível com dispositivos móveis e de desktop. A interface foi projetada em um belo estilo de anime secundário e inclui ricas animações interativas.

- Back-end de alto desempenhoDesenvolvido com base na estrutura assíncrona FastAPI, ele garante recursos eficientes de processamento de solicitações.

- Dados e cacheUso do Redis como cache semântico: o uso do Redis como cache semântico pode melhorar efetivamente o desempenho da resposta de consultas repetidas e reduzir o custo das chamadas de modelos de IA.

- Estrutura avançada de IA:: Aplicado LangGraph e tecnologias como o GraphRag para criar processos de IA mais complexos e aplicativos de gráficos de conhecimento.

Usando a Ajuda

Esta seção detalha como instalar, configurar e executar com êxito o sistema GBC MedAI. Siga as etapas abaixo para concluir a implantação.

Requisitos ambientais

Antes de começar, verifique se o ambiente do sistema atende às seguintes condições:

- Python3.8 ou superior

- Node.js: 16 ou superior (necessário apenas se for necessário o desenvolvimento de front-end)

- banco de dados abrangenteMySQL 8.0 ou superior, Redis 6.0 ou superior

- Gráfico de conhecimento (opcional)Neo4j 4.0 ou superior

Download do Prefile

O projeto depende de alguns arquivos pré-construídos para ser executado. Faça o download deles no endereço a seguir e descompacte-os primeiro no diretório especificado:

- Documentação de front-endLink do Baidu.com

https://pan.baidu.com/s/1KTROmn78XhhcuYBOfk0iUQ?pwd=wi8k(Código de extração: wi8k) Faça o download do arquivo do pacote front-end e extraia-o para o diretóriollm_backend/static/Catálogo. - Arquivos GraphRagLink do Baidu.com

https://pan.baidu.com/s/1dg6YxN_a4wZCXrmHBPGj_Q?pwd=hppu(Código de extração: hppu) Faça o download dos arquivos relacionados ao GraphRag e coloque-os no diretório raiz do projeto.

Etapas de instalação e configuração

1. clonagem de códigos de projeto

Primeiro, use o git para clonar o código do projeto do GitHub para seu computador local.

git clone https://github.com/zhanlangerba/gbc-madai.git

cd gbc-madai

2. configuração do serviço de back-end

Vá para o diretório de código do backend e use o comando pip Instale todas as dependências do Python.

cd llm_backend

pip install -r requirements.txt

3. configuração de variáveis de ambiente

O arquivo de configuração é fundamental para a operação do sistema. Você precisará copiar o arquivo de modelo e preencher suas informações pessoais de configuração.

# 复制环境变量模板文件

cp .env.example .env

# 使用文本编辑器(如 nano 或 vim)打开并编辑 .env 文件

nano .env

在 .env você precisará preencher as seguintes informações:

DEEPSEEK_API_KEY: Seu DeepSeek Chave de API.BOCHA_AI_API_KEY/BAIDU_AI_SEARCH_API_KEY/SERPAPI_KEYPreencha a chave de API correspondente de acordo com o mecanismo de pesquisa que você escolheu.DB_HOST,DB_USER,DB_PASSWORD,DB_NAMESuas informações de conexão com o banco de dados MySQL.REDIS_HOST,REDIS_PORTSuas informações de conexão do serviço Redis.NEO4J_URL,NEO4J_USERNAME,NEO4J_PASSWORDInformações de conexão do seu banco de dados Neo4j (se usado).

4. inicialização do banco de dados

Antes de iniciar o serviço, você precisa criar o banco de dados necessário para o projeto no MySQL.

# 使用您的 MySQL root 用户登录并执行以下命令

mysql -u root -p -e "CREATE DATABASE assist_gen CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci;"

5. iniciar os serviços do sistema

Após concluir todas as etapas acima, execute run.py para iniciar o sistema inteiro.

# 启动后端服务

python run.py

Depois que o serviço tiver sido iniciado com sucesso, você poderá acessar o seguinte endereço pelo navegador:

- endereço de acesso front-end:

http://localhost:8000/ - Documentação da API (Swagger UI):

http://localhost:8000/docs

Método de implantação

Além de executar o código-fonte diretamente, o projeto oferece suporte ao método de implantação do Docker, mais estável e conveniente.

Implementação com o Docker (recomendado)

Certifique-se de que você instalou o Docker. Execute o seguinte comando no diretório raiz do projeto:

# 1. 构建 Docker 镜像,将其命名为 gbc-madai

docker build -t gbc-madai .

# 2. 以后台模式运行容器,并将本地的 .env 文件作为环境变量传入

docker run -d -p 8000:8000 --env-file .env gbc-madai

Desenvolvimento independente de front-end

Se precisar modificar e desenvolver a interface de front-end, você pode ir para a seção gbc_madai_web para executar o serviço de desenvolvimento de front-end de forma independente. "`shell

Vá para o diretório de código do front-end

cd ../gbc_madai_web

Instalação de dependências de front-end

npm install

Inicie o servidor de desenvolvimento front-end

npm run dev

Os serviços de desenvolvimento front-end estarão disponíveis em http://localhost:3000 é iniciado e fará o proxy automático das solicitações de API para o http://localhost:8000。

cenário do aplicativo

- Consultoria em saúde inteligente

Como um assistente médico virtual, ele pode ser usado on-line 24 horas por dia, 7 dias por semana, para responder às perguntas dos pacientes sobre doenças comuns, conselhos sobre medicamentos e vida saudável, além de fornecer orientação médica inicial. - Suporte a decisões clínicas

Ajudar os médicos a recuperar e analisar rapidamente a literatura médica mais recente, relatórios de estudos clínicos e diretrizes de tratamento, fornecendo suporte de informações para o desenvolvimento de diagnósticos e planos de tratamento mais precisos. - Plataforma de recuperação de informações médicas

Ele pode ser usado como uma base de conhecimento inteligente em um hospital ou organização de pesquisa, ajudando a equipe a encontrar rapidamente regulamentos internos, procedimentos operacionais, arquivos de casos e materiais de pesquisa. - Outras áreas especializadas de aplicação

O design modular do sistema permite que ele seja facilmente estendido a outros campos profissionais, como comércio eletrônico, finanças, direito etc., para ser usado como atendimento inteligente ao cliente ou assistente especializado.

QA

- Esse projeto é gratuito e de código aberto?

Sim, o projeto é totalmente de código aberto com base na licença MIT e você pode usá-lo, modificá-lo e distribuí-lo em seus projetos pessoais ou comerciais. - Qual é a formação técnica necessária para implementar esse sistema?

Você precisará de um conhecimento básico da linguagem Python e da estrutura FastAPI, além de conhecimentos sobre a instalação e as operações básicas dos bancos de dados MySQL e Redis. Se optar pela implantação com o Docker, você também precisará estar familiarizado com os comandos comuns do Docker. - Posso acessar meus próprios modelos de IA?

Pode. A arquitetura do sistema suporta o acesso a qualquer modelo compatível com o padrão da API OpenAI. Tudo o que você precisa fazer é adicionar o.envModifique o endereço de API do modelo no arquivo de configuração (OLLAMA_BASE_URL(ou variáveis semelhantes) e uma chave é suficiente. O próprio sistema tem suporte nativo para DeepSeek e Ollama. - A interface de front-end pode ser substituída?

O backend do sistema fornece um conjunto completo de APIs REST. O backend do sistema fornece um conjunto completo de APIs REST. Você pode ignorar completamente o frontend do projeto e seguir a documentação da API (http://localhost:8000/docs) Desenvolva seus próprios aplicativos clientes, como aplicativos de desktop, aplicativos móveis ou miniaplicativos.