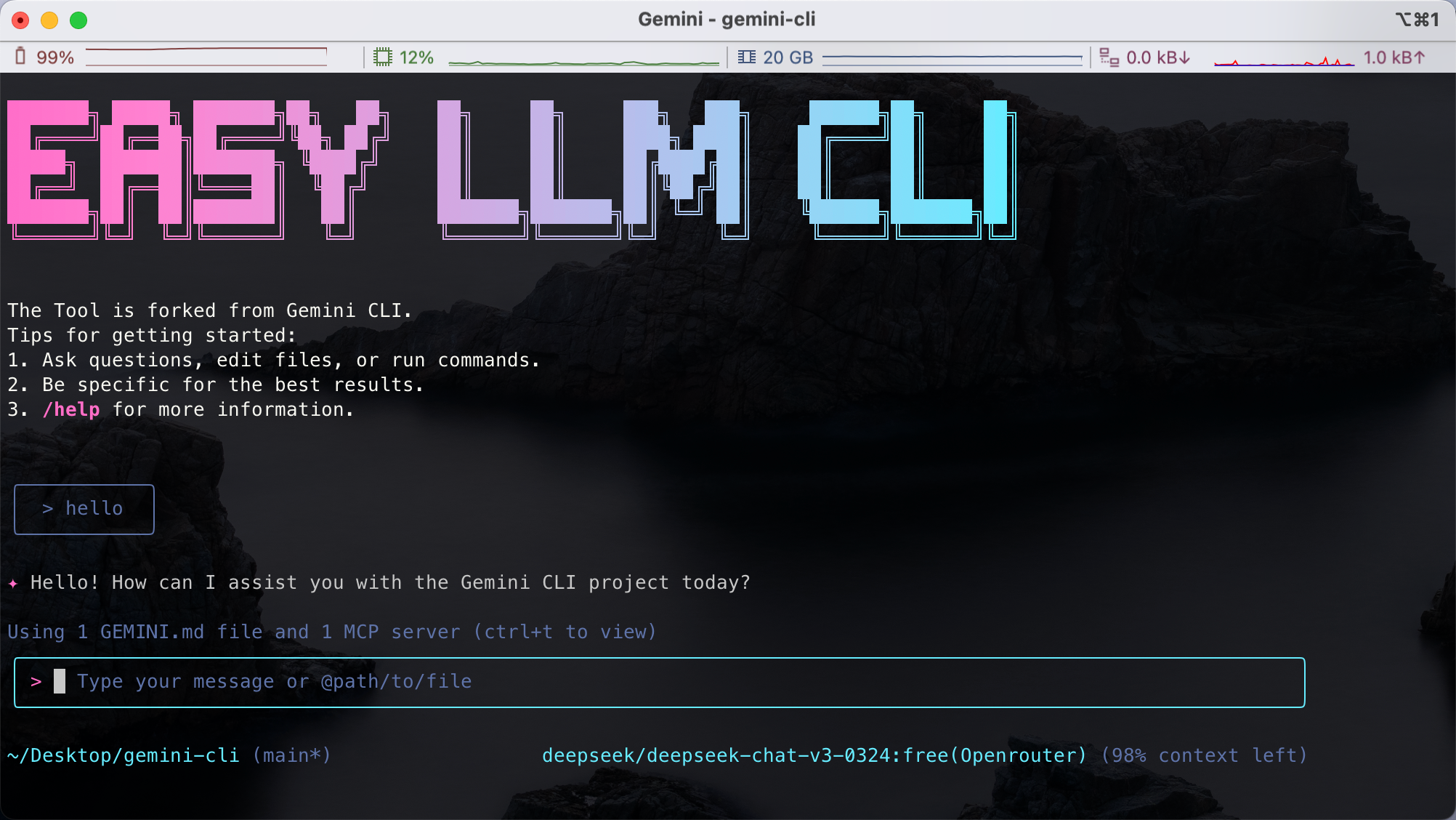

O easy-llm-cli é uma ferramenta de linha de comando de código aberto baseada no Gemini A CLI foi desenvolvida para ajudar os desenvolvedores a invocar vários modelos de linguagem grande (LLMs) com comandos simples. Ela oferece suporte a APIs para OpenAI, Gemini, Claude e muitos outros modelos, e é compatível com qualquer modelo que siga o formato da API do OpenAI. Os usuários podem gerar textos rapidamente, analisar códigos, processar entradas multimodais (como imagens ou PDFs) e até mesmo automatizar tarefas de desenvolvimento complexas por meio do terminal. A ferramenta é leve, modular e suporta configurações personalizadas, o que a torna adequada para os desenvolvedores usarem em ambientes locais ou de produção. O projeto está hospedado no GitHub, com uma comunidade ativa, documentação detalhada e fácil de começar.

Lista de funções

- Oferece suporte a uma ampla variedade de modelos de linguagem grandes, incluindo Gemini, OpenAI, Claude, Qwen e outros.

- Fornece uma interface de linha de comando para gerar texto rapidamente, responder a perguntas ou processar entradas.

- Oferece suporte à entrada multimodal e pode analisar conteúdo não textual, como imagens e PDFs.

- Oferece recursos de análise de código para gerar comentários de código ou resumir alterações na base de código.

- Suporte para fluxos de trabalho automatizados, como processamento de commits do Git, geração de relatórios ou gráficos.

- Permite a configuração de modelos personalizados e a troca flexível de provedores de LLM por meio de variáveis de ambiente.

- apoiar algo MCP servidores, conectando ferramentas externas para ampliar a funcionalidade.

- Projeto de código aberto com suporte para contribuições da comunidade e implementação local.

Usando a Ajuda

Processo de instalação

Para usar o easy-llm-cli localmente, você precisa concluir as seguintes etapas de instalação. Certifique-se de que seu sistema atenda aos requisitos mínimos: Node.js 20 ou superior.

- Instalação do Node.js

entrevistas Site oficial do Node.js Faça download e instale o Node.js (versão recomendada 20.x ou superior). Execute o seguinte comando para verificar a versão:node -v

2. **快速运行 CLI**

无需克隆仓库,可直接通过 npx 运行:

```bash

npx easy-llm-cli

Isso fará o download automático e iniciará a ferramenta para um teste rápido.

3. Instalação global (recomendada)

Se você planeja usá-lo por um longo período de tempo, recomenda-se instalá-lo globalmente:

npm install -g easy-llm-cli

Após a conclusão da instalação, execute o seguinte comando para iniciá-la:

elc

- Instalação a partir da fonte (opcional)

Se precisar personalizar ou contribuir com código, você poderá clonar o repositório:git clone https://github.com/ConardLi/easy-llm-cli.git cd easy-llm-cli npm install npm run start - Configuração de chaves de API

O easy-llm-cli precisa ser configurado com a chave de API do provedor de LLM. Por exemplo, use a API do OpenAI:export CUSTOM_LLM_PROVIDER="openai" export CUSTOM_LLM_API_KEY="sk-xxxxxxxxxxxxxxxxxxxx" export CUSTOM_LLM_ENDPOINT="https://api.openai.com/v1" export CUSTOM_LLM_MODEL_NAME="gpt-4o-mini"将

sk-xxxxxxxxxxxxxxxxxxxxsubstitua-a por sua chave real. Você pode encontrar a chave real na seção.bashrc或.zshrcpara adicionar esses comandos à configuração persistente. - Instalação do Docker (opcional)

Se preferir a implantação em contêineres, você pode usar o Docker:docker build -t easy-llm-cli . docker run -d -p 1717:1717 --name easy-llm-cli easy-llm-cliCertifique-se de que a porta

1717Desocupado.

Funções principais

O núcleo do easy-llm-cli é invocar o modelo de linguagem grande por meio da linha de comando para geração de texto, análise de código e tarefas de automação. A seguir, uma descrição detalhada de como fazer isso:

1. geração de texto

Execute o seguinte comando para gerar o texto:

elc "写一篇 200 字的 Python 简介"

- Instruções de operação:

elcé o comando de inicialização da ferramenta, seguido de um prompt. O modelo configurado (por exemplo, Gemini ou OpenAI) é usado por padrão. Você pode alternar os modelos por meio de variáveis de ambiente. - exportaçõesO modelo retorna um perfil Python de 200 palavras em um formato claro.

2. análise de código

Execute o seguinte comando no diretório do projeto para analisar a base de código:

cd my-project

elc "总结昨天的 Git 提交记录"

- Instruções de operaçãoFerramenta Git: A ferramenta examina o histórico do Git do diretório atual e gera um resumo dos commits.

- exportaçõesInstruções de envio: retorna instruções de envio agrupadas por tempo ou função.

3. entradas multimodais

O easy-llm-cli suporta o processamento de imagens ou PDFs, por exemplo, a extração de texto de PDFs:

elc "提取 PDF 中的文本" -f document.pdf

- Instruções de operação:

-fespecifica o caminho do arquivo. Os formatos compatíveis incluem PDF e imagens (JPEG, PNG, etc.). - exportaçõesTexto extraído: retorna o conteúdo do texto extraído.

4. fluxos de trabalho automatizados

Por meio do servidor MCP, a ferramenta pode se conectar a sistemas externos. Por exemplo, para gerar gráficos de histórico do Git:

elc "生成过去 7 天的 Git 提交柱状图"

- Instruções de operaçãoVocê precisa configurar o servidor MCP (por exemplo

@antv/mcp-server-chart). A ferramenta chama o modelo para gerar os dados do gráfico e os renderiza por meio do MCP. - exportaçõesGráfico de barras: retorna dados do gráfico de barras ou resultados de visualização.

5. configuração personalizada do modelo

Você pode mudar para outros modelos, como o Claude, por meio de variáveis de ambiente:

export CUSTOM_LLM_PROVIDER="openrouter"

export CUSTOM_LLM_API_KEY="your-openrouter-key"

export CUSTOM_LLM_MODEL_NAME="claude-sonnet-4"

elc "分析这段代码的功能" < myfile.py

- Instruções de operaçãoDepois de definir as variáveis de ambiente, execute o comando para trocar de modelo.

- exportações: Retorno Claude Análise do modelo do código.

Operação da função em destaque

1. suporte multimodal

O easy-llm-cli suporta o manuseio de entradas multimodais, como imagens, PDFs e assim por diante. Por exemplo, a geração de aplicativos de rascunho:

elc "根据 sketch.jpg 生成 Web 应用代码" -f sketch.jpg

- Instruções de operaçãoCarregar um esboço de design e o modelo gerará o código HTML/CSS/JavaScript correspondente.

- exportaçõesRetorna a estrutura completa do código do aplicativo da Web.

2. tarefas automatizadas

As ferramentas podem lidar com tarefas de desenvolvimento complexas. Por exemplo, automatizar as operações do Git:

elc "处理 GitHub Issue #123 的代码实现"

- Instruções de operaçãoA ferramenta lê a descrição do problema, gera o código de implementação e envia uma solicitação pull.

- exportaçõesPR: Retorna o código gerado e o link PR.

3. integração programática

Os desenvolvedores podem integrar o easy-llm-cli em seu código. Por exemplo, usando o Node.js:

import { ElcAgent } from 'easy-llm-cli';

const agent = new ElcAgent({

model: 'gpt-4o-mini',

apiKey: 'your-api-key',

endpoint: 'https://api.openai.com/v1'

});

const result = await agent.run('生成销售数据的柱状图');

console.log(result);

- Instruções de operação: através de

ElcAgentModelo de chamada de classe, adequado para ser incorporado em scripts de automação. - exportaçõesRetorna os resultados do processamento, como dados do gráfico.

advertência

- Verifique se a chave de API é válida e se a conexão de rede é estável.

- A funcionalidade multimodal requer suporte ao modelo (consulte o formulário de teste oficial). Por exemplo, o Gemini-2.5-pro e o GPT-4.1 suporta multimodalidade, enquanto alguns modelos, como o DeepSeek-R1 Sem suporte.

- Ao executar tarefas complexas, verifique o

CUSTOM_LLM_MAX_TOKENSé suficiente (padrão 8192). - Se você encontrar problemas, verifique o Documentação para solução de problemas Ou correr:

elc logs

cenário do aplicativo

- Análise da base de código

Os desenvolvedores podem executar o novo projetoelc "描述系统架构"O usuário, que é um dos mais experientes, entende rapidamente a estrutura do código, adequado para assumir projetos desconhecidos. - Gerar protótipos de aplicativos

O designer faz o upload de um esboço ou PDF, executaelc "生成 Web 应用"e obter rapidamente um protótipo de código executável. - Automatização de tarefas de DevOps

Os engenheiros de DevOps podem executarelc "生成最近 7 天的 Git 提交报告"O sistema de gerenciamento de dados da equipe, que é um sistema de gerenciamento de dados, reúne automaticamente o progresso do trabalho da equipe. - processamento de arquivos

Os pesquisadores podem usarelc "提取 PDF 中的关键信息" -f paper.pdfOrganize rapidamente o conteúdo de documentos acadêmicos.

QA

- Quais modelos são compatíveis com o easy-llm-cli?

Compatível com Gemini, OpenAI, Claude, Qwen e muitos outros, bem como com qualquer modelo personalizado que siga o formato da API do OpenAI. Consulte o formulário de teste oficial para obter detalhes. - Como lidar com entradas multimodais?

fazer uso de-fpara carregar uma imagem ou PDF, por exemploelc "提取文本" -f file.pdf. Certifique-se de que o modelo seja compatível com multimodalidade (por exemplo, Gemini-2.5-pro). - Preciso de uma API paga?

Os modelos remotos exigem uma chave de API válida (por exemplo, uma chave paga para OpenAI ou OpenRouter). Os modelos locais, como o Qwen2.5-7B-Instruct, não exigem taxas adicionais. - Como faço para depurar erros?

estar em movimentoelc logsVeja o registro ou visite Documentação para solução de problemas Procure ajuda.