Prefácio: Criando seu próprio AI Agent Studio

Coze Studio é uma plataforma de desenvolvimento de agentes de IA de baixo código e de código aberto da ByteDance. Ela fornece um conjunto de ferramentas visuais que permite aos desenvolvedores criar, depurar e implantar rapidamente inteligências, aplicativos e fluxos de trabalho de IA com uma quantidade mínima de código. Essa abordagem não apenas reduz o limite técnico, mas também fornece uma base sólida para a criação de produtos de IA altamente personalizados.

Um agente de IA é um programa inteligente que entende a intenção do usuário e planeja e executa tarefas complexas de forma autônoma. Implementação local Coze StudioIsso significa que você tem controle total sobre seus dados e modelos, proporcionando excelente privacidade e flexibilidade para desenvolvimento e experimentação.

O back-end da plataforma usa GolangA parte frontal é React + TypeScript A combinação, em geral baseada em microsserviços e na arquitetura de design orientado por domínio (DDD), garante o alto desempenho e o dimensionamento do sistema.

Este artigo o guiará por Coze Studio Open Source Edition para implantação local e configure a conexão com o servidor local. Ollama também OpenRouter de serviços de modelagem.

1. instalação do Ollama: tenha seu próprio modelo pessoal grande

Ollama é uma estrutura leve e extensível para executar modelos de linguagem nativos de grande porte. Ele simplifica bastante a execução do Llama 3, Qwen 和 Gemma e outros processos de modelagem. Tem OllamaVocê pode aproveitar a IA para processar dados privados em um ambiente totalmente off-line sem depender de serviços de nuvem de terceiros, equilibrando segurança e custo.

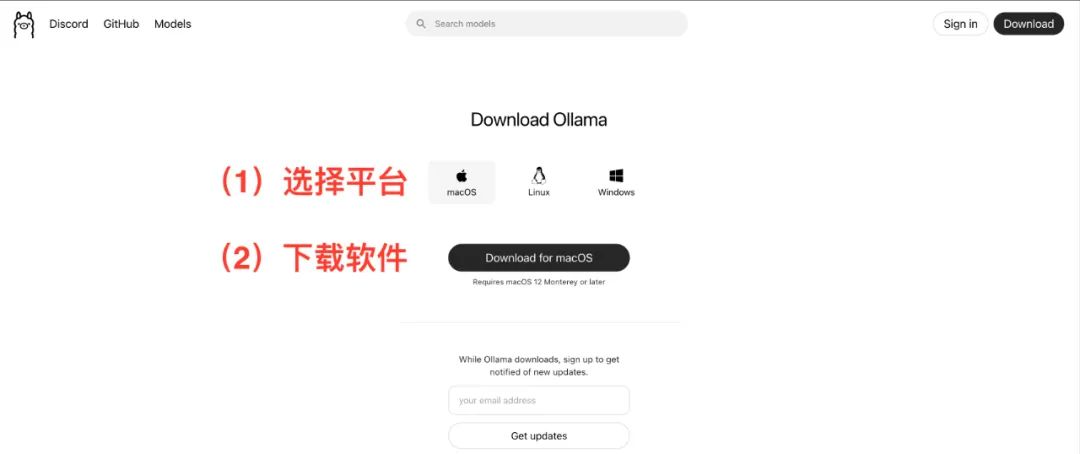

entrevistas https://ollama.com/Faça o download e instale o cliente apropriado para o seu sistema operacional (macOS, Linux, Windows). O processo de instalação é muito intuitivo, basta seguir o assistente.

modelo de tração

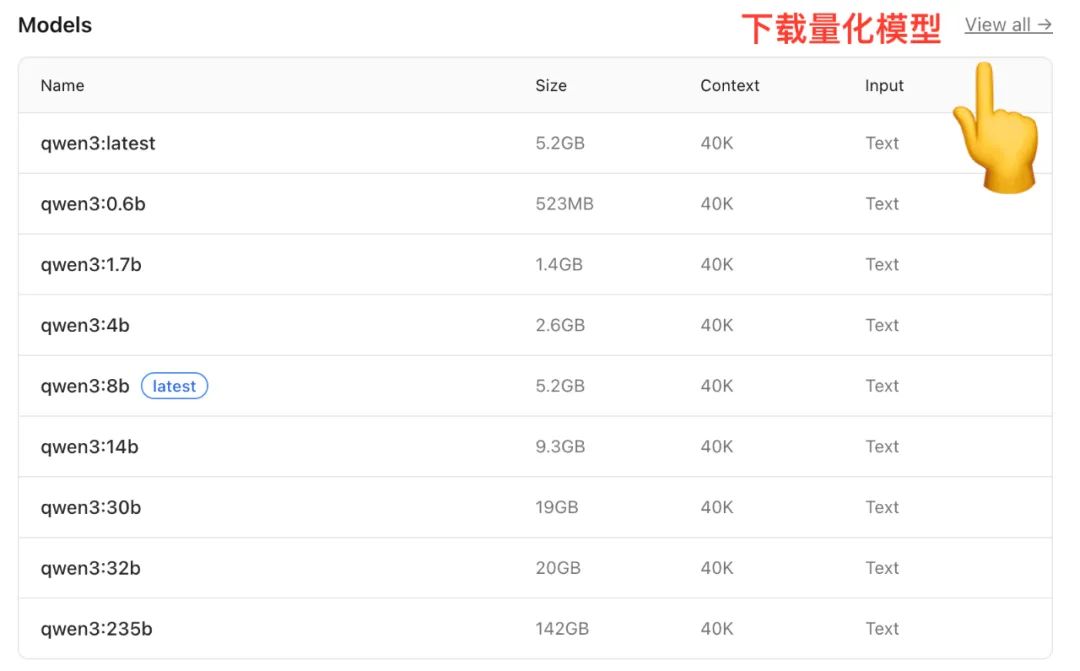

Após a conclusão da instalação, você precisará iniciar a partir da pasta Ollama para baixar um modelo localmente da biblioteca de modelos do Pegue o Qwen A biblioteca de modelos, por exemplo, oferece versões com diferentes escalas de parâmetros.

(Fonte da imagem: https://ollama.com/library/qwen)

Modelos de tamanhos diferentes têm requisitos de memória (RAM) diferentes, e esse é um fator a ser considerado ao fazer uma seleção:

- Modelos 7BRAM: Recomendado 16 GB de RAM

- Modelo 14BRAM: Recomendado 32 GB de RAM

- Modelo 72BRAM: Recomendado 64 GB de RAM

Muitos modelos também oferecemQuantificação Versão. A quantização é uma técnica para reduzir o tamanho do modelo e o espaço de memória, reduzindo a precisão da ponderação e mantendo o desempenho do modelo, permitindo que os modelos sejam executados com mais eficiência em hardware de nível de consumidor.

Abra um terminal (Terminal ou Prompt de Comando) e digite o seguinte comando para extrair um modelo de tamanho médio:

ollama run qwen:14b

Esse comando baixará e descompactará automaticamente o modelo especificado da nuvem. O tempo exato necessário depende das condições da rede.

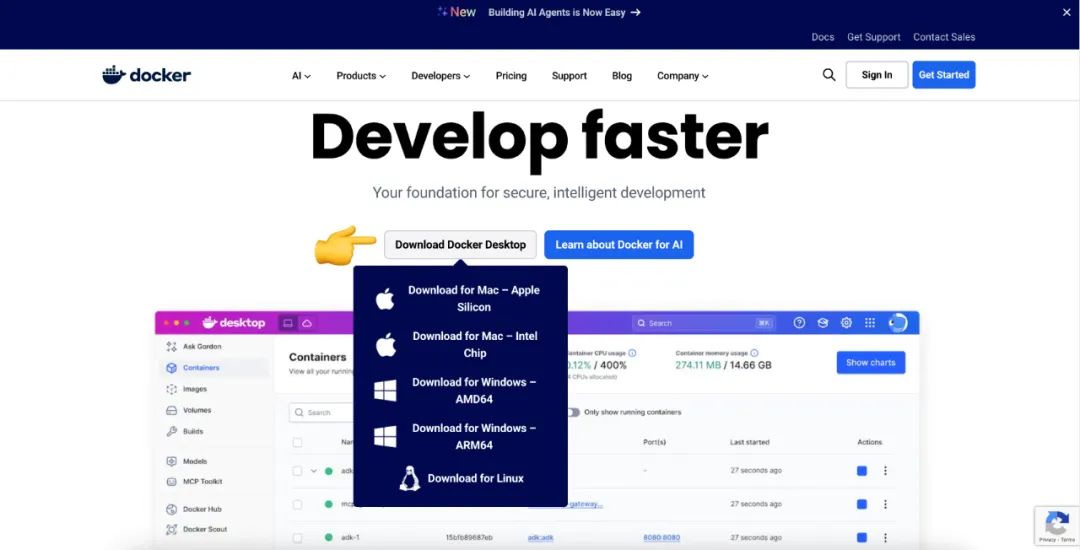

2. instalando o Docker: uma ferramenta padronizada para a implantação de aplicativos

Docker é uma técnica de conteinerização que empacota um aplicativo e todas as suas dependências em um "contêiner" padrão e portátil. Em poucas palavras.Docker É como um contêiner padronizado, e Coze Studio É a carga que estamos carregando. Por DockerPodemos adicionar facilmente uma nova versão a qualquer um dos Docker em uma máquina que esteja executando o Coze StudioVocê não precisa se preocupar com configurações complexas de ambiente e conflitos de dependência.

entrevistas https://www.docker.com/Faça o download e instale Docker DesktopEle também oferece uma interface gráfica de instalação para macOS, Linux e Windows. Ele também oferece uma interface gráfica de instalação para macOS, Linux e Windows.

3. implantação local do Coze Studio

3.1 Requisitos ambientais

- softwareVerifique se a máquina tem pelo menos uma CPU de dois núcleos e 4 GB de RAM.

- hardware: Pré-instalação

Docker、Docker Composee garantir queDockerO serviço foi iniciado.

3.2 Obtenção do código-fonte do Coze Studio

Se a máquina tiver sido instalada GitImplementação git clone é a maneira mais direta de obter o código-fonte.

git clone https://github.com/coze-dev/coze-studio.git

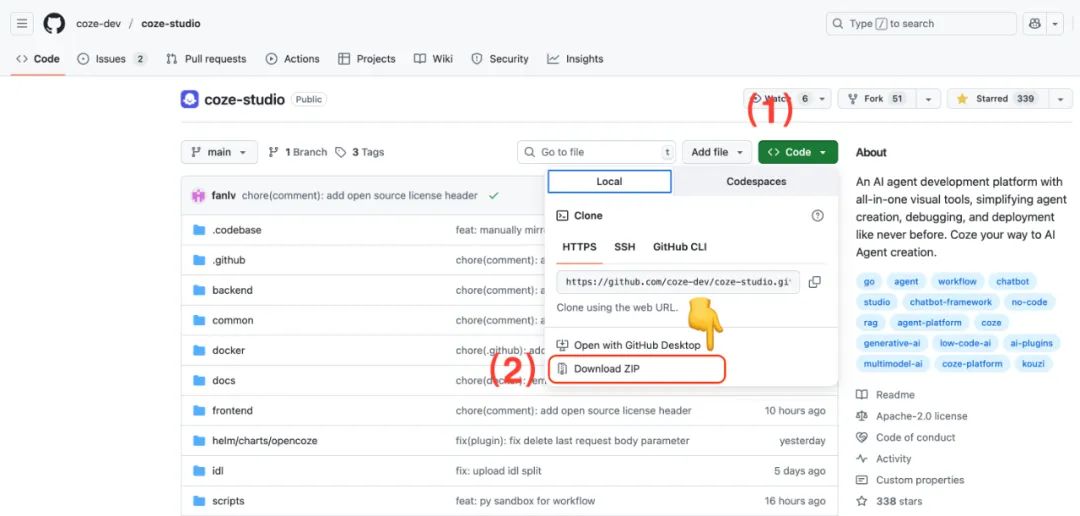

Se não estiver instalado GitEle também pode ser baixado diretamente do site GitHub para fazer download do arquivo ZIP.

3.3 Configuração de modelos para o Coze Studio

Coze Studio Há suporte para vários serviços de modelagem, incluindo Ark(arca do vulcão)OpenAI、DeepSeek、Claude、Ollama、Qwen 和 Gemini。

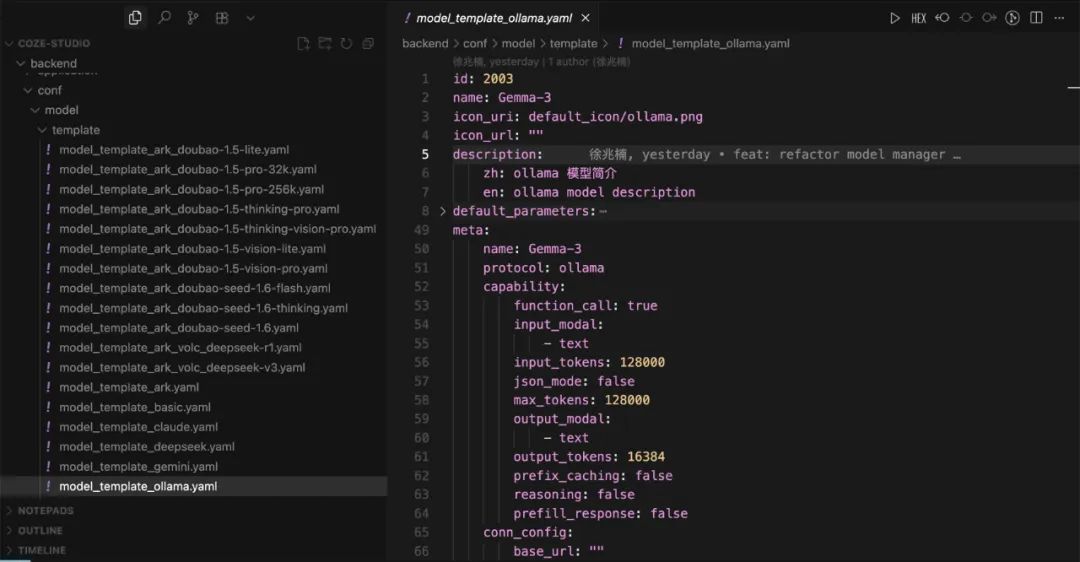

Use o editor de código para abrir o arquivo coze-studio Projeto. Em backend/conf/model/template que contém modelos de configuração para os diferentes serviços de modelo.

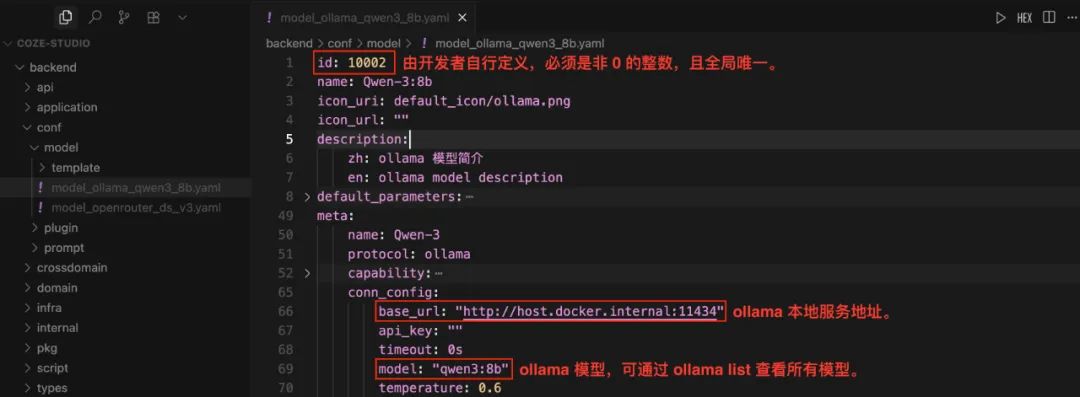

Configuração do modelo Ollama local

- 将

model_template_ollama.yamlOs arquivos de modelo são copiados para a pastabackend/conf/modelCatálogo. - Renomeie-o, por exemplo.

model_ollama_qwen14b.yaml。 - Edite esse arquivo para configurar o

qwen:14bcomo exemplo:

Atenção:id Os campos devem ser números inteiros não nulos globalmente exclusivos. Para modelos que já estão on-line, não modifique seus campos idcaso contrário, a chamada falhará. Antes da configuração, você pode executar ollama list para visualizar os modelos disponíveis localmente.

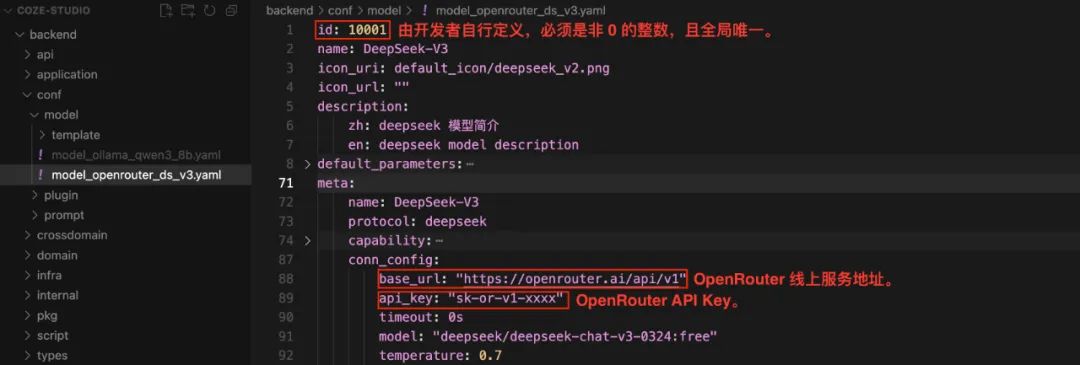

Configuração do modelo OpenRouter

OpenRouter É um serviço de agregação de modelos que permite aos desenvolvedores chamar vários modelos de diferentes fornecedores por meio de uma interface de API unificada, simplificando o gerenciamento de chaves de API e o processo de troca de modelos.

- 将

model_template_deepseek.yamlOs arquivos de modelo são copiados para a pastabackend/conf/modelCatálogo. - renomear

model_openrouter_ds_v2.yaml。 - Edite o arquivo para configurar o

DeepSeek-V2Como exemplo, e preencha as informações doOpenRouteradquiridaapi_key。

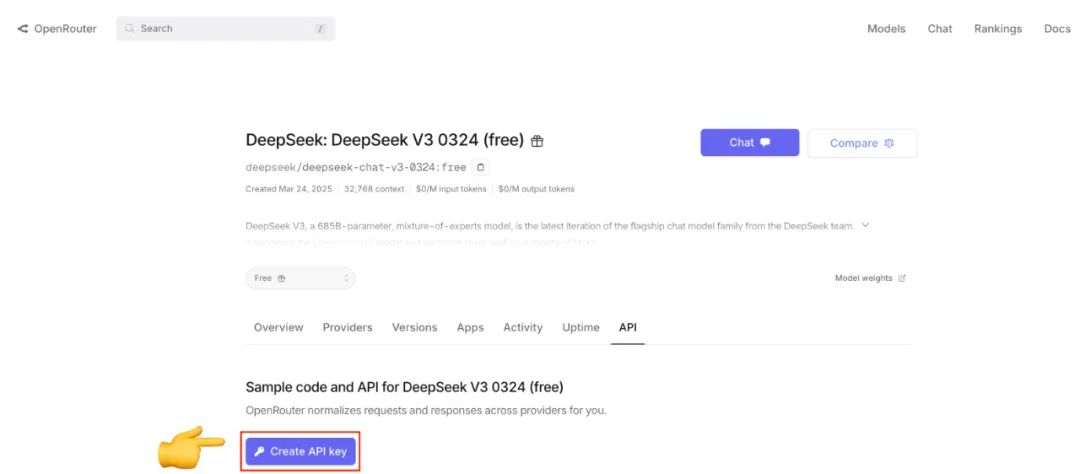

Se ainda não tiver OpenRouter API Key, que pode ser registrada e criada visitando o site oficial.

3.4 Implantar e iniciar serviços

Depois de configurar o modelo, vá para a seção docker e, em seguida, execute o seguinte comando:

cd docker

cp .env.example .env

docker compose --profile '*' up -d

--profile '*' garantirá que o parâmetro docker-compose.yml Todos os serviços definidos no arquivo (inclusive os serviços opcionais) são iniciados. A primeira implementação extrai e constrói a imagem, o que leva muito tempo.

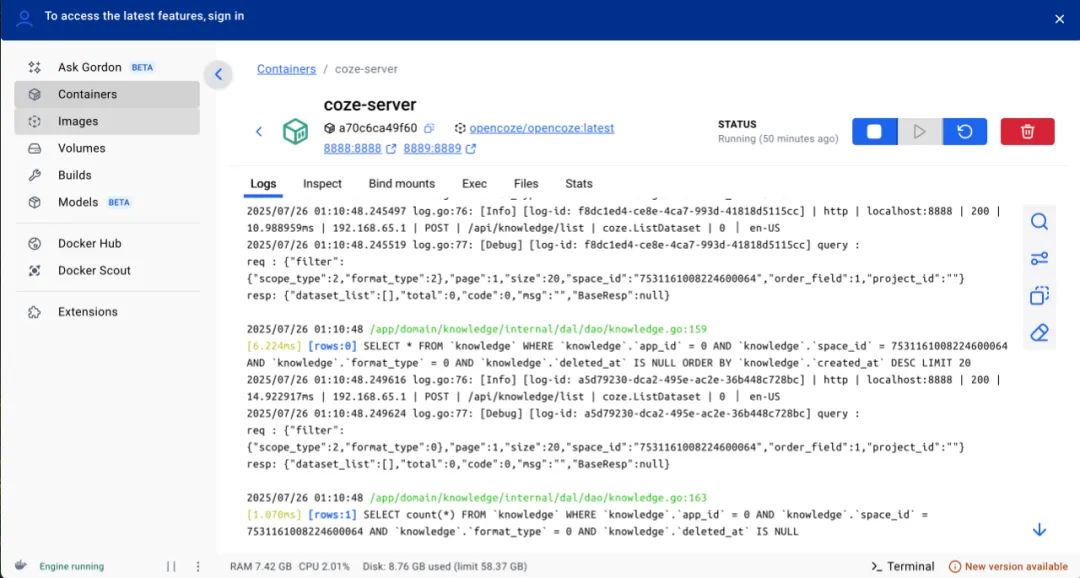

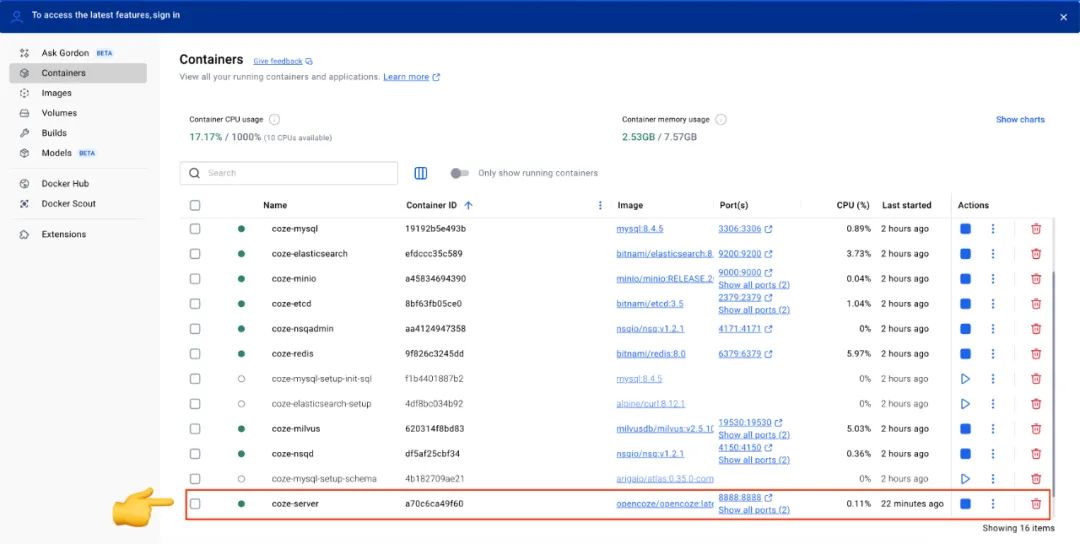

Depois de iniciar o Docker Desktop para visualizar o status de todos os serviços na interface do Quando o coze-server O indicador de status do serviço fica verde, o que significa que o Coze Studio foi lançado com sucesso.

Após cada modificação no arquivo de configuração, é necessário executar o seguinte comando para reiniciar o serviço para que a configuração tenha efeito:

docker compose --profile '*' restart coze-server

3.5 Uso do Coze Studio

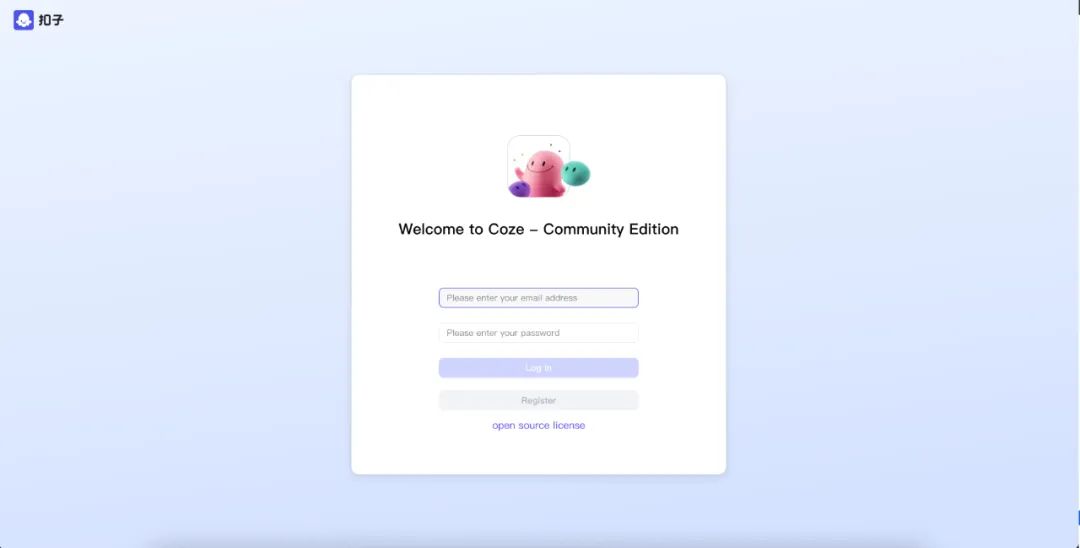

Depois que o serviço for iniciado, acesse-o em seu navegador http://localhost:8888/。

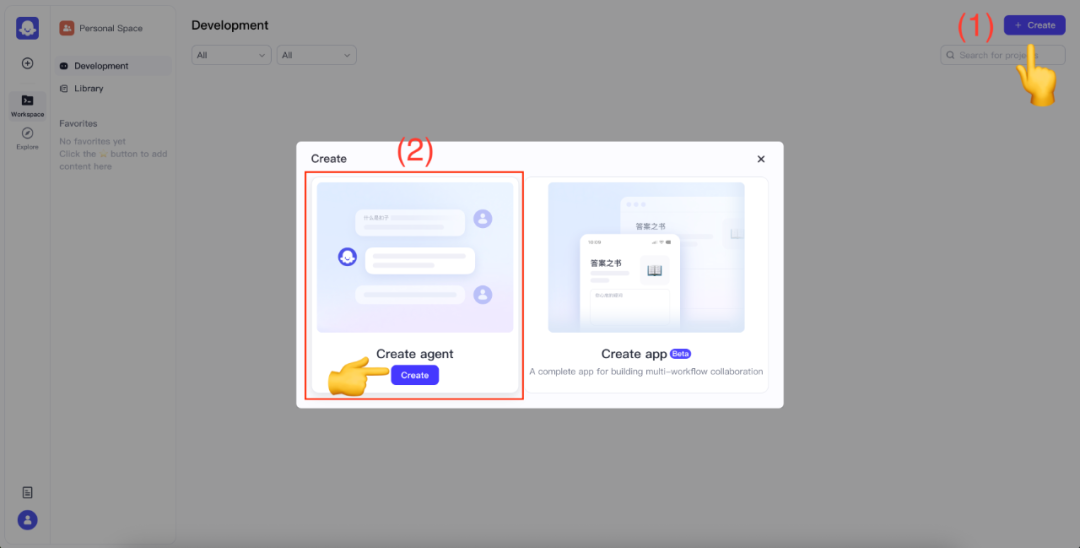

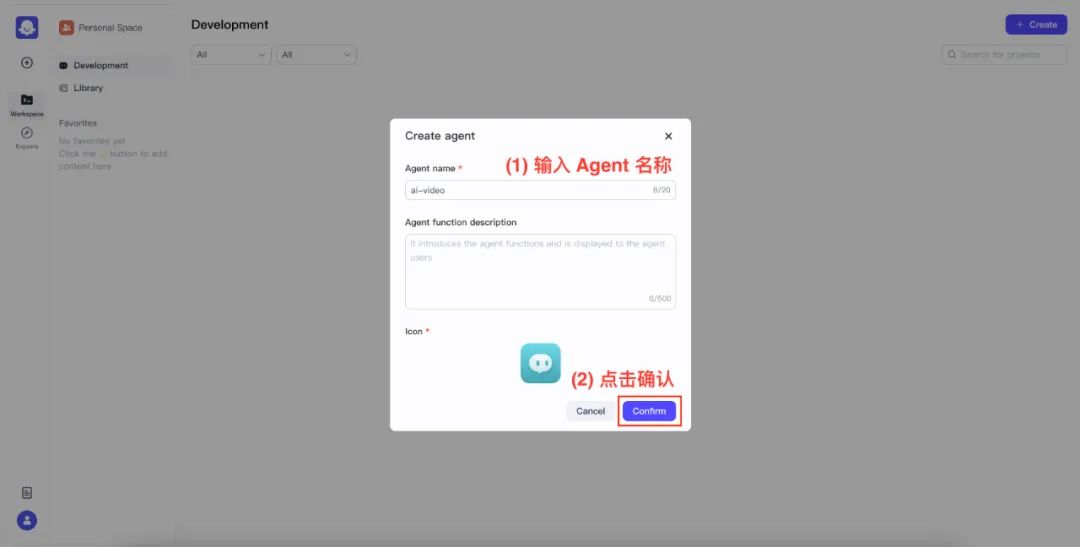

Para usar pela primeira vez, digite seu e-mail e senha para se registrar como um novo usuário. Depois de fazer o login com sucesso, clique no canto superior direito da tela Create botão, selecione Create agent。

Nomeie e confirme seu agente.

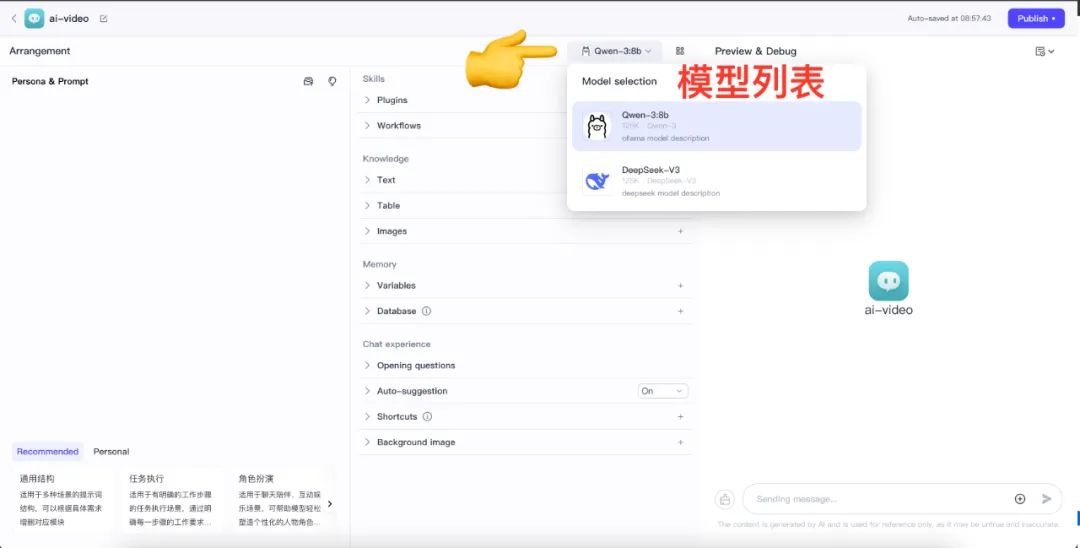

Quando estiver na tela Agent Design, clique em Model List (Lista de modelos) para ver todos os modelos que foram configurados.

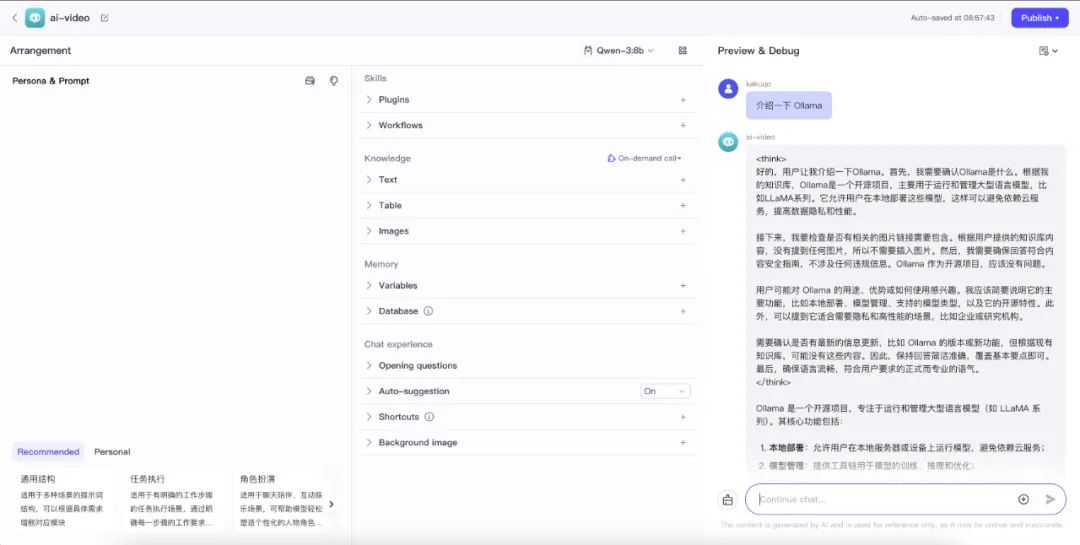

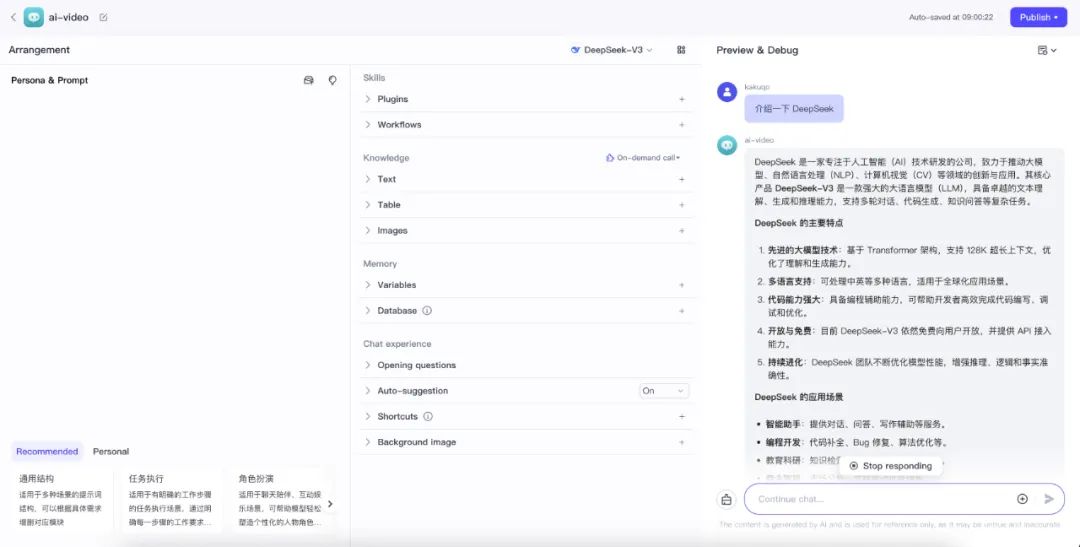

O modelo agora pode ser testado para verificar se está funcionando corretamente usando a caixa de bate-papo na parte inferior do lado direito.

- Teste local Ollama

qwen:14bserviço

- Testando o OpenRouter na rede elétrica

DeepSeek-V2serviço

Se uma exceção de chamada for encontrada, o Docker Desktop confira coze-server registros do contêiner para solucionar problemas.