O Core é uma ferramenta de código aberto desenvolvida pela RedPlanetHQ que tem como objetivo fornecer recursos personalizados de armazenamento de memória para modelos grandes (LLMs). Com o Core, os usuários podem criar e gerenciar seus próprios mapas de memória, salvando texto, diálogo ou outros dados em uma base de conhecimento privada. A ferramenta suporta o armazenamento de registros de interações do usuário com o Big Model para formar nós de memória estruturados que podem ser facilmente consultados posteriormente ou conectados a outras ferramentas. Ele opera por meio de um painel intuitivo e oferece suporte à implantação local e aos serviços de nuvem para atender às necessidades de diferentes usuários. Atualmente, o projeto está em fase de desenvolvimento ativo, com aprimoramentos contínuos, especialmente para a otimização da memória de modelos grandes.

Lista de funções

- armazenamento de memóriaSalvar texto ou diálogo inserido pelo usuário em um gráfico de conhecimento privado.

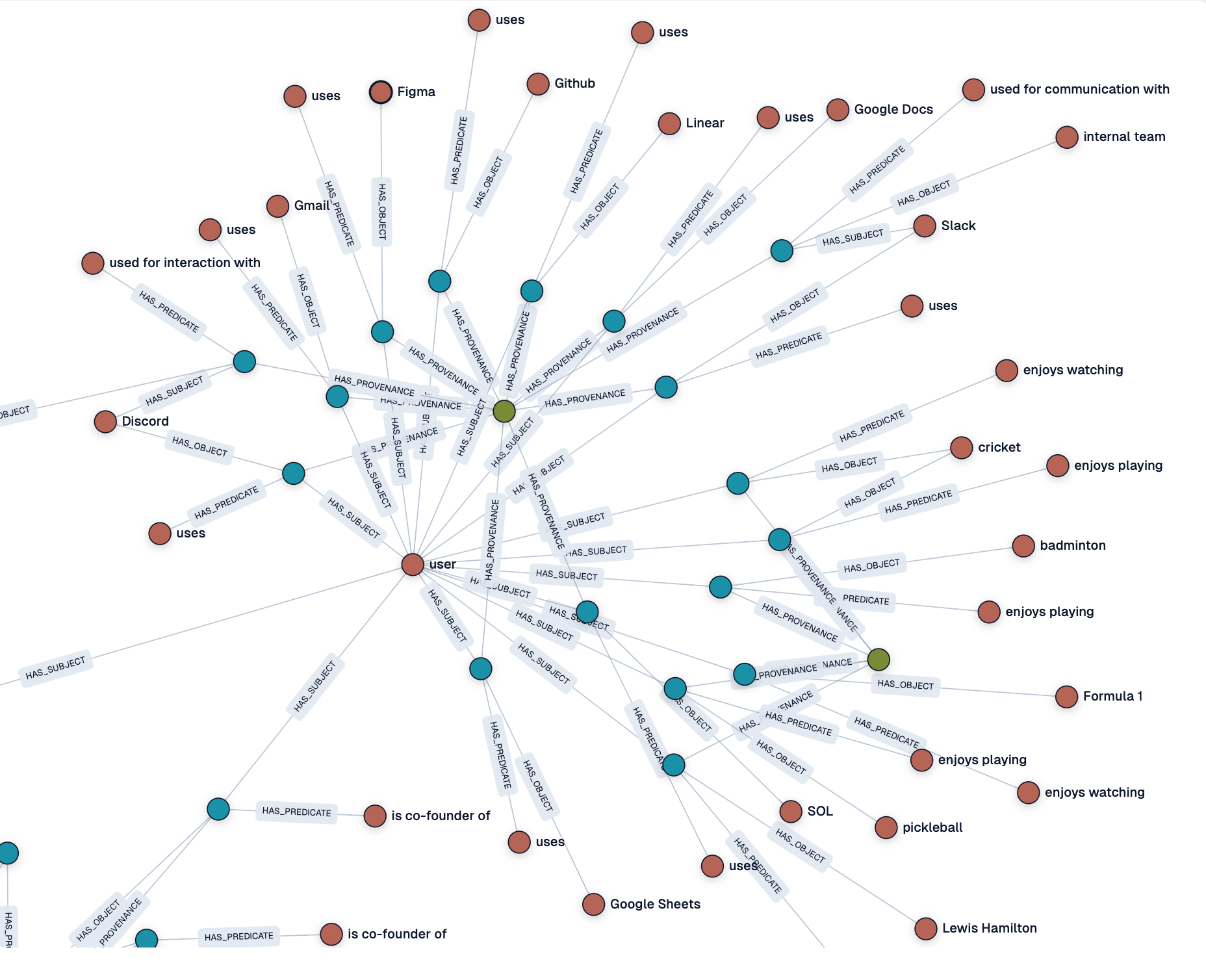

- Geração de gráficos de conhecimentoTransforma automaticamente as entradas em nós de memória estruturados para facilitar a recuperação.

- Gerenciamento do painelInterface visual: fornece uma interface visual para exibir e gerenciar os nós e o estado do mapa de memória.

- Oferece suporte à implementação local e na nuvemOs usuários podem optar por executar localmente ou usar o serviço Core Cloud.

- Integração com modelos grandesSuporte à interface com uma variedade de modelos grandes para armazenar registros de interação.

- Monitoramento de registrosVisualização de registros de processamento de memória em tempo real para entender o status do processamento de dados.

- projeto de código abertoOs usuários são livres para acessar o código e participar do desenvolvimento ou da personalização dos recursos.

Usando a Ajuda

Processo de instalação

Para usar o Core, primeiro você precisa instalar e configurar seu ambiente. Veja a seguir as etapas detalhadas de instalação e uso:

- armazém de clones:

- Abra um terminal e execute o seguinte comando para clonar o repositório Core:

git clone https://github.com/RedPlanetHQ/core.git - Vá para o catálogo de projetos:

cd core

- Abra um terminal e execute o seguinte comando para clonar o repositório Core:

- Instalação de dependências:

- O Core usa um ambiente Node.js, e é recomendável que você instale a versão mais recente do Node.js (recomendado 16.x ou superior).

- Instale os pacotes de dependência:

npm install

- Configuração de variáveis de ambiente:

- No diretório raiz do projeto, crie um arquivo

.envadicione o seguinte:API_TOKEN=YOUR_API_TOKEN_HERE API_BASE_URL=https://core.heysol.ai SOURCE=cursor API_TOKENVocê precisa obtê-lo depois de registrar uma conta no site oficial do Core Cloud (https://core.heysol.ai).

- No diretório raiz do projeto, crie um arquivo

- Execução de serviços locais:

- Inicie o painel de controle de memória (MCP) do Core:

npx -y @redplanethq/core-mcp - Depois que o serviço for iniciado, abra seu navegador e acesse

http://localhost:3000。

- Inicie o painel de controle de memória (MCP) do Core:

- Uso do Core Cloud (opcional):

- Se escolher um serviço de nuvem, acesse https://core.heysol.ai para se registrar e fazer login na sua conta.

- Gerencie memórias diretamente no painel de controle da nuvem sem implementação local.

Funções principais

1. adição de memórias

- procedimento:

- Painel de login (local ou na nuvem).

- Na caixa de entrada no canto superior direito, digite o texto que deseja salvar, por exemplo, "I like to play badminton" (Eu gosto de jogar badminton).

- Clique no botão "+Add" e o texto será enviado para a fila de processamento.

- Verifique o status do processamento na tela "Logs". Quando concluído, o nó de memória será exibido no painel.

- Descrição funcional:

- Um nó de memória é gerado automaticamente para cada texto adicionado, e o nó contém o conteúdo do texto e os metadados (por exemplo, registros de data e hora).

- Esses nós podem ser conectados para formar um gráfico de conhecimento para consultas ou análises subsequentes.

2. visualização e gerenciamento da memória

- procedimento:

- Abra a página "Graph" do painel para ver todos os nós de memória.

- Clique em um nó para visualizar os detalhes ou editá-lo.

- Suporte à função de pesquisa, insira palavras-chave para localizar rapidamente memórias relacionadas.

- Descrição funcional:

- O painel fornece um gráfico de conhecimento visual com as relações entre os nós em um relance.

- Os usuários podem ajustar manualmente as conexões de nós ou excluir memórias indesejadas.

3. integração com modelos maiores

- procedimento:

- Na página Configurações, adicione uma regra para salvar automaticamente a caixa de diálogo do macromodelo:

- Abra "Settings" (Configurações) -> "User rules" (Regras do usuário) -> "New Rule" (Nova regra).

- Adicione regras para garantir que a consulta do usuário e a resposta do modelo sejam armazenadas na memória do Core após cada diálogo.

- configurar

sessionIdé o identificador exclusivo (UUID) do diálogo.

- Exemplo de configuração de regra:

{ "mcpServers": { "memory": { "command": "npx", "args": ["-y", "@redplanethq/core-mcp"], "env": { "API_TOKEN": "YOUR_API_TOKEN_HERE", "API_BASE_URL": "https://core.heysol.ai", "SOURCE": "cursor" } } } }

- Na página Configurações, adicione uma regra para salvar automaticamente a caixa de diálogo do macromodelo:

- Descrição funcional:

- O Core captura automaticamente as interações do usuário com modelos grandes e as armazena como dados estruturados.

- Há suporte para uma ampla gama de modelos grandes, mas o suporte para o modelo Llama está sendo otimizado para melhor compatibilidade no futuro.

4. monitoramento de registros

- procedimento:

- Abra a página "Logs" do painel.

- Visualize os registros de processamento em tempo real, incluindo acréscimos de memória, status de processamento e mensagens de erro.

- Descrição funcional:

- A função de registro ajuda os usuários a monitorar o fluxo de processamento de dados e a garantir a confiabilidade do armazenamento de dados.

- Se o processamento falhar, o registro fornecerá detalhes do erro para facilitar a solução de problemas.

advertência

- implantação localVerifique se a rede está estável e se a porta 3000 não está ocupada.

- serviço de nuvemChaves de API estáveis são necessárias, e a validade da chave é verificada periodicamente.

- Suporte ao modelo Llama: Atualmente, o Core tem compatibilidade limitada com o modelo Llama, portanto, recomenda-se usar outros modelos principais para obter melhores resultados.

- Suporte à comunidadeSe você encontrar problemas, poderá enviar um problema no GitHub ou participar da discussão na comunidade.

cenário do aplicativo

- Gerenciamento de conhecimento pessoal

- Os usuários podem usar o Core para salvar notas de estudo diárias, inspirações ou conversas importantes para formar uma base de conhecimento pessoal. Por exemplo, os alunos podem salvar anotações de aula como nós de memória para facilitar a revisão.

- Desenvolvedor Depuração de modelos grandes

- Os desenvolvedores podem registrar interações com modelos grandes, analisar a saída do modelo e otimizar o design do prompt. Por exemplo, ao depurar um chatbot, o Core pode salvar todas as conversas de teste.

- Trabalho em equipe

- Os membros da equipe podem compartilhar mapas de memória e colaborar na criação de bases de conhecimento de projetos por meio do Core Cloud. Por exemplo, uma equipe de produto pode depositar o feedback do usuário no Core para gerar um mapa de análise de requisitos.

- Assistência à pesquisa

- Os pesquisadores podem salvar resumos de literatura ou dados experimentais no Core para formar uma memória de pesquisa estruturada para análise e citação posteriores.

QA

- Quais modelos grandes são compatíveis com o Core?

- Atualmente, o Core oferece suporte a muitos dos principais modelos grandes, mas a compatibilidade com o modelo Llama ainda está sendo otimizada. Recomenda-se usar outros modelos para obter melhores resultados.

- Qual é a diferença entre a implantação local e os serviços em nuvem?

- A implementação local exige a configuração manual do ambiente, o que é adequado para cenários que exigem privacidade; os serviços em nuvem não exigem instalação e funcionam imediatamente, o que é adequado para começar rapidamente.

- Como posso garantir a segurança dos meus dados de memória?

- Os dados de memória implantados localmente são armazenados no dispositivo do usuário com segurança controlada pelo usuário; os serviços em nuvem usam transmissão criptografada com chaves de API para garantir o acesso seguro aos dados.

- O Core é totalmente gratuito?

- O Core é um projeto de código aberto e é gratuito para implantação local; os serviços em nuvem podem envolver taxas de assinatura, portanto, verifique o site oficial para saber os preços.