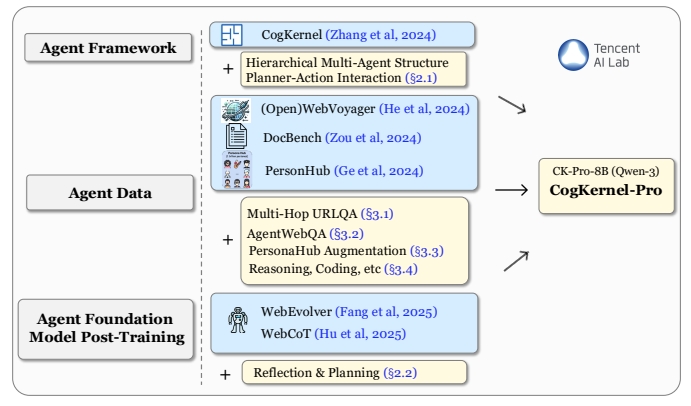

O Cognitive Kernel-Pro é uma estrutura de código aberto desenvolvida pelo Laboratório de IA da Tencent, projetada para ajudar os usuários a criar inteligências de pesquisa profundas e treinar modelos de base inteligentes. Ele integra navegação na Web, manipulação de arquivos e execução de código para dar suporte aos usuários em tarefas de pesquisa complexas. A estrutura enfatiza o uso de ferramentas gratuitas para garantir o código aberto e a acessibilidade. Os usuários podem implementar e executar as inteligências localmente com uma configuração simples para lidar com tarefas como informações em tempo real, gerenciamento de arquivos e geração de códigos. O projeto teve um bom desempenho nos benchmarks GAIA, igualando ou até mesmo superando o desempenho de alguns sistemas de código fechado. O código e o modelo são totalmente de código aberto e estão hospedados no GitHub para incentivar as contribuições da comunidade e pesquisas adicionais.

Lista de funções

- Navegação na Web: os corpos inteligentes podem obter informações da Web em tempo real controlando o navegador para realizar operações como clicar e digitar.

- Processamento de arquivos: suporta a leitura e o processamento de arquivos locais para extrair dados importantes ou gerar relatórios.

- Execução de código: gere e execute automaticamente o código Python para análise de dados ou automação de tarefas.

- Projeto modular: oferece uma arquitetura de vários módulos que permite aos usuários personalizar a combinação de funções das inteligências.

- Suporte a modelos de código aberto: integre o Qwen3-8B-CK-Pro e outros modelos de código aberto para reduzir o custo de uso.

- Planejamento de tarefas: os órgãos inteligentes podem gerar planos de tarefas com base nas instruções do usuário e dividir tarefas complexas.

- Operação segura de sandbox: suporta a execução de código em um ambiente de sandbox para garantir a segurança da operação.

Usando a Ajuda

Processo de instalação

Para usar o Cognitive Kernel-Pro, os usuários precisam concluir as seguintes etapas de instalação e configuração em seu ambiente local. Abaixo está um processo de instalação detalhado para garantir que os usuários possam começar rapidamente.

1. preparação ambiental

Primeiro, certifique-se de que o Python 3.8 ou superior esteja instalado em seu sistema e que você tenha a ferramenta Git. Isso é recomendado para sistemas Linux ou macOS; os usuários do Windows precisarão instalar algumas dependências adicionais. Aqui estão as etapas básicas:

- Instalação de dependênciasExecute o seguinte comando para instalar os pacotes Python necessários:

pip install boto3 botocore openai duckduckgo_search rich numpy openpyxl biopython mammoth markdownify pandas pdfminer-six python-pptx pdf2image puremagic pydub SpeechRecognition bs4 youtube-transcript-api requests transformers protobuf openai langchain_openai langchain selenium helium smolagents - Instalação de dependências do sistema(sistema Linux):

apt-get install -y poppler-utils default-jre libreoffice-common libreoffice-java-common libreoffice ffmpegEssas ferramentas oferecem suporte à conversão de arquivos e ao processamento de multimídia.

- Configuração do caminho do PythonAdicionar o caminho do projeto à variável de ambiente:

export PYTHONPATH=/your/path/to/CogKernel-Pro - projeto de clonagemClone o repositório Cognitive Kernel-Pro do GitHub:

git clone https://github.com/Tencent/CognitiveKernel-Pro.git cd CognitiveKernel-Pro

2. serviços de modelagem de configuração

Suporte do Cognitive Kernel-Pro vLLM ou TGI Model Server para executar modelos de código aberto. A seguir, um exemplo de vLLM:

- Instalação do vLLM:

pip install vllm - Iniciando o serviço de modeloSe você tiver feito o download dos pesos do modelo Qwen3-8B-CK-Pro, execute o seguinte comando para iniciar o serviço:

python -m vllm.entrypoints.openai.api_server --model /path/to/downloaded/model --worker-use-ray --tensor-parallel-size 8 --port 8080 --host 0.0.0.0 --trust-remote-code --max-model-len 8192 --served-model-name ck

3. configuração dos serviços do navegador da Web

O projeto usa o Playwright para fornecer a funcionalidade de navegação na Web. Execute o script a seguir para iniciar o serviço do navegador:

sh ck_pro/ck_web/_web/run_local.sh

Certifique-se de que o serviço esteja sendo executado na porta padrão localhost:3001。

4. executar o programa principal

Depois de preparar o modelo e o serviço do navegador, execute o aplicativo principal para executar a tarefa:

NO_NULL_STDIN=1 python3 -u -m ck_pro.ck_main.main --updates "{'web_agent': {'model': {'call_target': 'http://localhost:8080/v1/chat/completions'}, 'web_env_kwargs': {'web_ip': 'localhost:3001'}}, 'file_agent': {'model': {'call_target': 'http://localhost:8080/v1/chat/completions'}}}" --input /path/to/simple_test.jsonl --output /path/to/simple_test.output.jsonl |& tee _log_simple_test

--inputEspecifica o arquivo de entrada da tarefa no formato JSON Lines, com cada linha contendo uma descrição da tarefa.--outputEspecifica o caminho para um arquivo de saída para salvar os resultados da execução do corpo inteligente.

5 Cuidados

- segurançaRecomenda-se executar em um ambiente sandboxed com privilégios sudo desativados para evitar possíveis riscos:

echo "${USER}" 'ALL=(ALL) NOPASSWD: !ALL' | tee /etc/sudoers.d/${USER}-rule chmod 440 /etc/sudoers.d/${USER}-rule deluser ${USER} sudo - modo de depuração: pode adicionar

-mpdbpara entrar no modo de depuração para solução de problemas.

Funções principais

navegador da web

O recurso de navegação na Web do Cognitive Kernel-Pro permite que as inteligências interajam com páginas da Web como os seres humanos. O usuário fornece uma descrição da tarefa (por exemplo, "Encontre os últimos commits em um repositório no GitHub"), e a inteligência abre automaticamente um navegador e clica, digita etc. para obter as informações desejadas. Veja como funciona:

- Defina tarefas no arquivo de entrada, por exemplo:

{"task": "find the latest commit details of a popular GitHub repository"} - O corpo inteligente gera um plano de tarefa, invoca o navegador Playwright e visita a página da Web de destino.

- Extrai o conteúdo de uma página da Web e retorna o resultado, que é salvo em um arquivo de saída.

Processamento de documentos

A função de processamento de arquivos suporta a leitura e a análise de arquivos em vários formatos (por exemplo, PDF, Excel, Word). Os usuários podem especificar caminhos de arquivos e tarefas, como a extração de dados tabulares de PDFs:

- Prepare o arquivo de entrada, especificando o caminho do arquivo e a tarefa:

{"task": "extract table data from /path/to/document.pdf"} - O corpo inteligente chama o módulo de processamento de arquivos para analisar o arquivo e extrair os dados.

- Os resultados são salvos em um arquivo de saída em um formato estruturado, como JSON ou CSV.

execução de código

O recurso Code Execution permite que as inteligências gerem e executem códigos Python para concluir tarefas de análise de dados ou de automação. Por exemplo, a análise de dados em um arquivo CSV:

- Digite uma descrição da tarefa:

{"task": "analyze sales data in /path/to/sales.csv and generate a summary"} - A Intelligentsia gera código Python para processar os dados usando bibliotecas como a pandas.

- O código é executado em um ambiente sandbox e os resultados são salvos em um arquivo de saída.

Planejamento da missão

A inteligência gerará um plano de execução com base na complexidade da tarefa. Por exemplo, para "Localizar e resumir o conteúdo de um artigo":

- O Intelligentsia divide a tarefa em subetapas: busca de documentos, download de PDFs, extração de informações importantes e geração de resumos.

- Cada subetapa chama o módulo apropriado (navegação na Web, manipulação de arquivos, etc.) para execução.

- O resultado final é emitido em um formato especificado pelo usuário.

Operação da função em destaque

Suporte a modelos de código aberto

O Cognitive Kernel-Pro integra o modelo Qwen3-8B-CK-Pro, que apresenta bom desempenho em benchmarks GAIA. Os usuários podem fazer o download dos pesos do modelo diretamente, eliminando a necessidade de depender de APIs de código fechado e reduzindo o custo de propriedade. O modelo é compatível com tarefas multimodais (por exemplo, processamento de imagens), e os usuários podem configurar o VLM_URL para usar a funcionalidade multimodal.

Operação de sandbox de segurança

Para evitar riscos associados à execução do código, recomenda-se que a estrutura seja executada em um ambiente sandbox. Os usuários podem implementar via Docker para garantir o isolamento do código:

docker run --rm -v /path/to/CogKernel-Pro:/app -w /app python:3.8 bash -c "pip install -r requirements.txt && python -m ck_pro.ck_main.main"

cenário do aplicativo

- pesquisa acadêmica

Com o Cognitive Kernel-Pro, os usuários podem pesquisar artigos acadêmicos, extrair informações importantes e gerar resumos. Por exemplo, se você digitar "find the latest papers in AI and summarise them", a inteligência pesquisará automaticamente o arXiv, baixará o PDF do artigo, extrairá o resumo e as conclusões e gerará um relatório conciso. - análise de dados

Os usuários corporativos podem usar a estrutura para analisar arquivos de dados locais. Por exemplo, o processamento de arquivos CSV de dados de vendas para gerar gráficos estatísticos e relatórios de análise de tendências é adequado para gerar percepções comerciais rápidas. - Tarefas automatizadas

Os desenvolvedores podem usar inteligências para automatizar tarefas repetitivas, como o download em lote de dados da Web, a organização do conteúdo de arquivos ou a execução de testes de código, para aumentar a produtividade. - Desenvolvimento da comunidade de código aberto

Os desenvolvedores da comunidade podem participar do aprimoramento contínuo da estrutura personalizando as inteligências com base na estrutura, ampliando os módulos funcionais, como a adição de novos analisadores de arquivos ou a integração de outros modelos de código aberto.

QA

- O Cognitive Kernel-Pro requer uma API paga?

Não é necessário. A estrutura usa ferramentas e modelos totalmente de código aberto (por exemplo, Qwen3-8B-CK-Pro), sem dependência de APIs pagas. Os usuários podem simplesmente baixar os pesos do modelo e implantá-los localmente. - Como garantir a execução segura do código?

Recomenda-se executar em um ambiente sandboxed (por exemplo, Docker), desativar as permissões sudo e restringir o acesso à rede. A documentação do projeto fornece diretrizes detalhadas de configuração de segurança. - Quais formatos de arquivo são suportados?

Oferece suporte a formatos comuns, como PDF, Excel, Word, Markdown, PPTX etc. Os dados de texto, tabela ou imagem podem ser extraídos por meio do módulo de processamento de arquivos. - Como você lida com tarefas complexas?

O corpo inteligente dividirá tarefas complexas em subtarefas, gerará planos de execução e invocará módulos de navegação na Web, processamento de arquivos ou execução de código para concluí-las passo a passo. - Há suporte para tarefas multimodais?

Sim, há suporte para tarefas multimodais, como processamento de imagens ou análise de vídeo. O usuário precisa configurar o VLM_URL e fornecer suporte a modelos multimodais.