Chutes é uma plataforma de computação de modelo de IA para desenvolvedores. Ela se baseia em uma arquitetura de código aberto descentralizada e os usuários não precisam gerenciar servidores complexos por conta própria. Usando essa plataforma, os desenvolvedores podem implementar e executar rapidamente uma variedade de modelos de IA de código aberto, como grandes modelos de linguagem ou modelos de geração de imagens. Em sua essência, a Chutes.ai oferece um ambiente de computação sem servidor, o que significa que os usuários simplesmente carregam seu código e a plataforma cuida do restante das tarefas de execução e dimensionamento. Ela tem um modelo de pagamento conforme o uso, em que você paga pelo que usa, o que é uma maneira econômica para startups e pesquisadores individuais que precisam de recursos de computação flexíveis. A plataforma oferece suporte computacional estável e eficiente para tarefas de inferência de IA, consolidando recursos de GPU em todo o mundo.

Lista de funções

- Implementação sem servidorOs usuários podem implementar qualquer modelo de IA sem configuração e gerenciamento de servidor.

- Expansão rápida: O sistema pode ajustar automaticamente os recursos de computação com base nas demandas de carga de trabalho.

- Suporte para vários modelosA plataforma não se limita a modelos de linguagem grandes (LLMs), mas também oferece suporte a uma ampla gama de aplicativos de IA, como imagens, vídeo, fala, música e modelagem 3D.

- Ambientes personalizadosOs usuários podem carregar seu próprio código ou usar contêineres do Docker para executar qualquer modelo de código aberto.

- API primeiroAPI: fornece uma interface de API limpa para facilitar a integração de sua funcionalidade em qualquer aplicativo ou sistema.

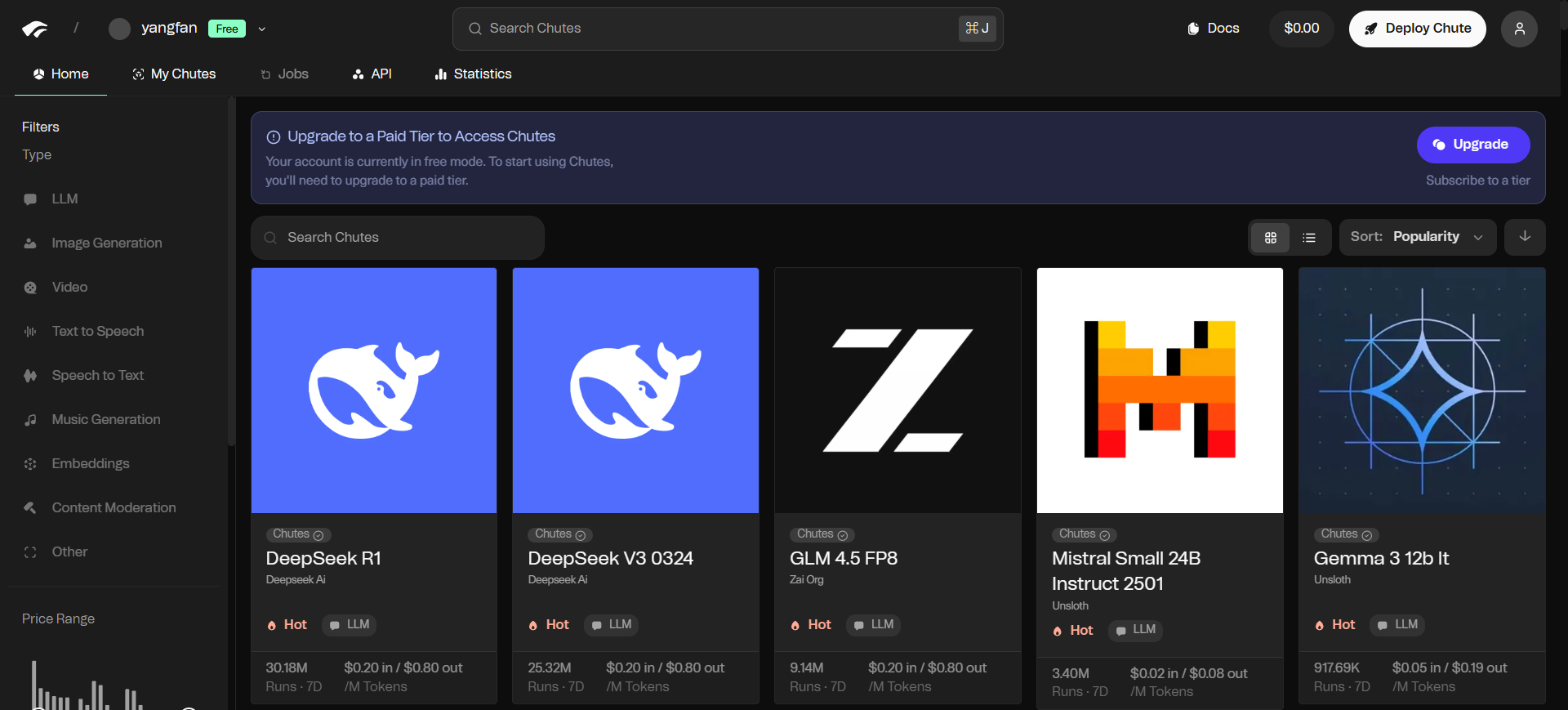

- biblioteca de modelos:: A plataforma fornece os modelos de código aberto mais recentes e geralmente entra em operação logo após o lançamento.

- pagar conforme necessárioO pagamento é baseado no volume real de solicitações de computação e há diferentes níveis de planos de assinatura disponíveis.

- rede descentralizadaCriado com base na rede Bittensor, ele utiliza recursos distribuídos de GPU para fornecer serviços computacionais.

Usando a Ajuda

A plataforma Chutes.ai simplifica o processo de implementação e uso de modelos de IA, permitindo que os desenvolvedores sem conhecimento especializado em gerenciamento de serviços em nuvem comecem a trabalhar rapidamente. Em sua essência, ela fornece um ambiente sem servidor em que os usuários só precisam se concentrar nos modelos e no próprio código.

Registre-se e obtenha a chave da API

- Visite o site oficial do Chutes.ai e crie uma conta.

- Depois de fazer login, localize a seção API Management no painel da sua conta ou na página de configurações.

- Gere uma nova chave de API. Essa chave é a sua credencial para acessar os recursos de computação da plataforma, portanto, mantenha-a segura.

Como usar o modelo por meio da API

O Chutes.ai é compatível com o formato da API da OpenAI, o que facilita muito a troca e a integração. Se você já usou a API da OpenAI antes, precisará fazer poucas alterações no código.

Etapa 1: Definir o endereço de solicitação

Substitua a URL de destino solicitada em seu código pelo endereço de proxy fornecido por Chutes.ai:

https://llm.chutes.ai/v1/chat/completions

Etapa 2: Configurar a chave da API

Autentique sua chave de API como um token de portador nos cabeçalhos da solicitação (Headers).

Authorization: Bearer YOUR_CHUTES_API_KEY

Etapa 3: Especificar o modelo

Nos dados JSON do corpo da solicitação (Body), omodelespecifica o modelo que você deseja usar. Por exemplo, se você quiser usar um dos modelos do DeepSeek, poderá defini-lo como:

"model": "deepseek-ai/DeepSeek-V3"

A seguir, um exemplo de envio de uma solicitação usando cURL:

curl -X POST https://llm.chutes.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_CHUTES_API_KEY" \

-d '{

"model": "deepseek-ai/DeepSeek-V3",

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello! Can you tell me a joke?"

}

]

}'

Você precisará alterar o código no arquivoYOUR_CHUTES_API_KEYSubstitua a chave pela sua própria.

Uso em aplicativos de terceiros

O Chutes.ai também pode ser facilmente integrado a aplicativos de terceiros que suportam interfaces de modelos personalizados, como o Janitor AI ou o KoboldAI.

O processo de configuração geralmente é o seguinte:

- Na opção Settings (Configurações) do aplicativo, localize o portal API ou Model Configuration (Configuração de modelo).

- opção

自定义或兼容OpenAIO tipo de API. - No campo Endereço da API ou URL do proxy, preencha o endereço de solicitação do Chutes:

https://llm.chutes.ai/v1/chat/completions。 - No campo API Key (Chave de API), preencha a chave gerada por sua conta Chutes.ai.

- No campo Nome do modelo, digite o identificador do modelo na plataforma Chutes que você deseja usar, por exemplo

deepseek-ai/DeepSeek-V3。

Depois que as configurações são salvas, o aplicativo executa o modelo de IA por meio da rede computacional do Chutes.ai.

Implante seus próprios modelos

Para usuários avançados que precisam executar modelos personalizados, o Chutes.ai permite carregar seu próprio código ou contêineres do Docker. Você pode encontrar instruções detalhadas sobre como empacotar e implantar um "Chute" (contêiner) personalizado na documentação oficial. Esse processo geralmente exige que você empacote o modelo e as dependências associadas em uma imagem de contêiner padrão, que pode ser carregada e implantada por meio das ferramentas da plataforma.

cenário do aplicativo

- Prototipagem rápida de aplicativos de IA

Para startups ou desenvolvedores que precisam validar rapidamente uma ideia, a Chutes.ai oferece um ambiente em que eles não precisam se preocupar com as instalações subjacentes. Os desenvolvedores podem se concentrar inteiramente na lógica do aplicativo e na experiência do usuário e criar rapidamente um protótipo funcional usando os modelos de código aberto existentes na plataforma. - Ampliação dos recursos de IA nos aplicativos existentes

Se um site ou aplicativo existente precisar integrar a funcionalidade de IA (como atendimento inteligente ao cliente, recomendações de conteúdo ou resumo de texto), os desenvolvedores poderão adicionar facilmente recursos avançados de modelagem aos seus produtos chamando a interface de API do Chutes.ai, sem incorrer em altos custos de hardware e manutenção. - Pesquisa e experimentação acadêmica

Os pesquisadores geralmente precisam testar diferentes modelos ou algoritmos de IA. O modelo de pagamento conforme o uso e o suporte flexível ao modelo do chutes.ai facilitam a pesquisa acadêmica. Os pesquisadores podem recorrer aos mais recentes modelos de código aberto para experimentação a qualquer momento, a um custo gerenciável e sem gastar tempo com a configuração do ambiente. - Lidar com tarefas de dados em grande escala

Para tarefas que exigem incorporação de texto em grande escala, análise de dados ou processamento de imagens, o recurso Long Jobs do Chutes.ai, que será lançado em breve, pode ser usado. Os usuários podem enviar tarefas em lote e usar os recursos de computação distribuída da plataforma para concluir seu trabalho com eficiência.

QA

- Qual é a diferença entre a Chutes.ai e os serviços de IA oferecidos pelos provedores de nuvem tradicionais (por exemplo, AWS, Google Cloud)?

Os provedores de serviços em nuvem tradicionais geralmente exigem que os usuários configurem e gerenciem máquinas virtuais, instâncias de contêineres e redes por conta própria, o que é um processo complicado. chutes.ai fornece serviços de computação sem servidor que encapsulam todos os detalhes técnicos subjacentes. Os usuários podem implantar e invocar o modelo diretamente, e a plataforma lidará automaticamente com a alocação e o dimensionamento de recursos, reduzindo bastante o limite de uso. - O que significa "descentralizado" na plataforma?

"Descentralizado" significa que os recursos de computação da Chutes.ai não vêm de um único data center, mas consistem em uma rede de provedores de GPU espalhados pelo mundo. Essa estrutura melhora a estabilidade e a resiliência do sistema, ao mesmo tempo em que, teoricamente, oferece serviços de computação mais econômicos por meio de mecanismos competitivos. - É seguro executar dados de modelos em Chutes.ai?

O Chutes.ai protege o código dos usuários executando-o em um ambiente isolado. A plataforma também está planejando introduzir recursos de computação confidencial baseados no Trusted Execution Environment (TEE), que fornecerão um nível mais alto de proteção à privacidade dos dados para usuários que trabalham com dados confidenciais. - E se o modelo que eu quiser usar não estiver disponível na plataforma?

O Chutes.ai permite que os usuários adicionem seus próprios modelos. Você pode empacotar qualquer modelo de código aberto em um contêiner do Docker e implantá-lo para ser executado na plataforma.