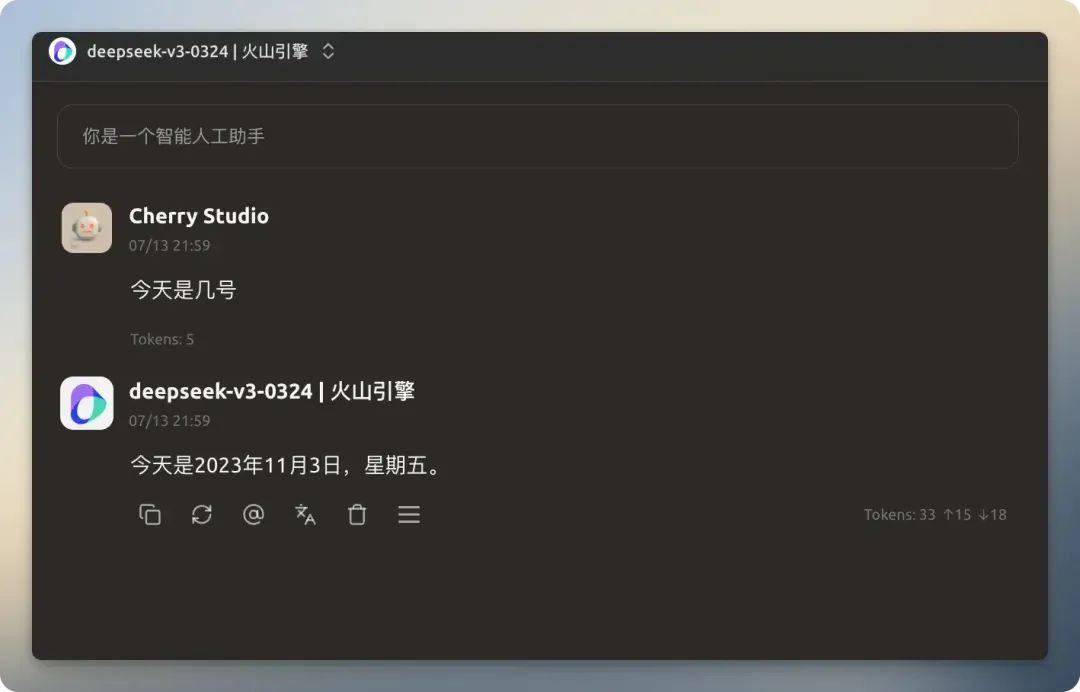

Prefácio

O conhecimento de um Modelo de Linguagem Grande (LLM) é limitado pela data de corte de seus dados de treinamento. Por exemplo, um modelo treinado antes de janeiro de 2025 não será capaz de responder a eventos ocorridos desde então, como uma pergunta sobre a data atual. Capacitar os modelos com recursos de pesquisa em rede que lhes permitam responder com base em informações em tempo real pode expandir muito seus cenários de aplicação e melhorar a precisão de suas respostas. Cherry Studio Um conjunto de funções de pesquisa em rede é fornecido, projetado para permitir que qualquer modelo se conecte à Internet.

Este artigo detalhará os Cherry Studio A função de pesquisa de rede fornece um guia detalhado de configuração e prática.

Configuração de funções

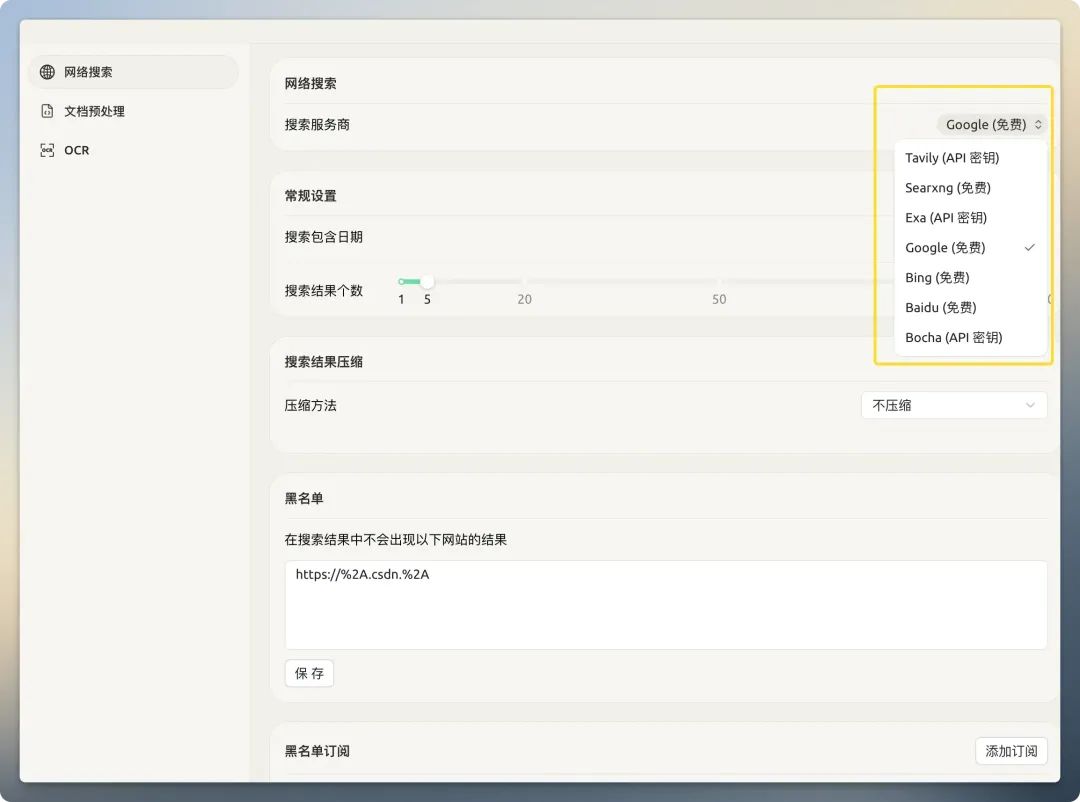

Antes de usar o Networked Search, você precisa configurá-lo adequadamente. Abra a seção Cherry Studio na tela de configurações, a área à direita concentra todas as opções relacionadas à pesquisa na Web.

Provedor de serviços de pesquisa

Cherry Studio Há uma variedade de provedores de pesquisa incorporados. Eles podem ser divididos em duas categorias principais:Mecanismos de busca tradicionais(por exemplo 百度、谷歌、必应eMecanismo de pesquisa nativo de IA(por exemplo Tavily、Exa)。

Mecanismos de busca tradicionaisO que é retornado é uma página da Web completa projetada para leitura visual humana, que contém muito "ruído", como barras de navegação, anúncios, scripts etc., que não estão relacionados ao conteúdo principal. Alimentar essas informações diretamente no modelo de IA não só aumenta drasticamente o custo do token, mas também reduz a qualidade da resposta devido à poluição de informações.

Mecanismo de pesquisa nativo de IAPor outro lado, eles são especializados em servir grandes modelos de linguagem. Eles pré-processaram e otimizaram os resultados da pesquisa no back-end, retornando dados de texto limpos, refinados e estruturados que são mais adequados para o consumo direto da máquina.

Tavily

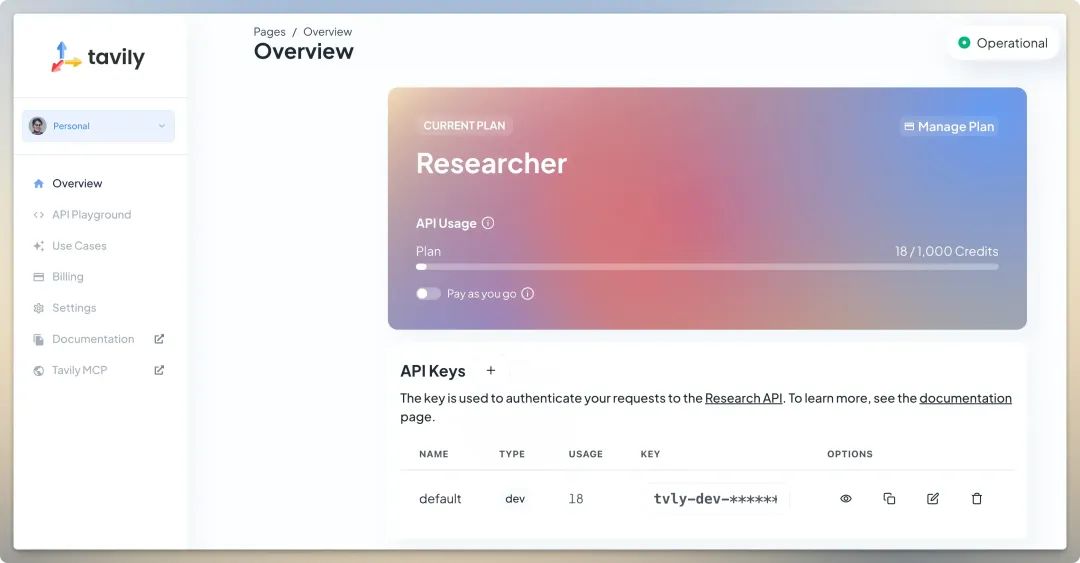

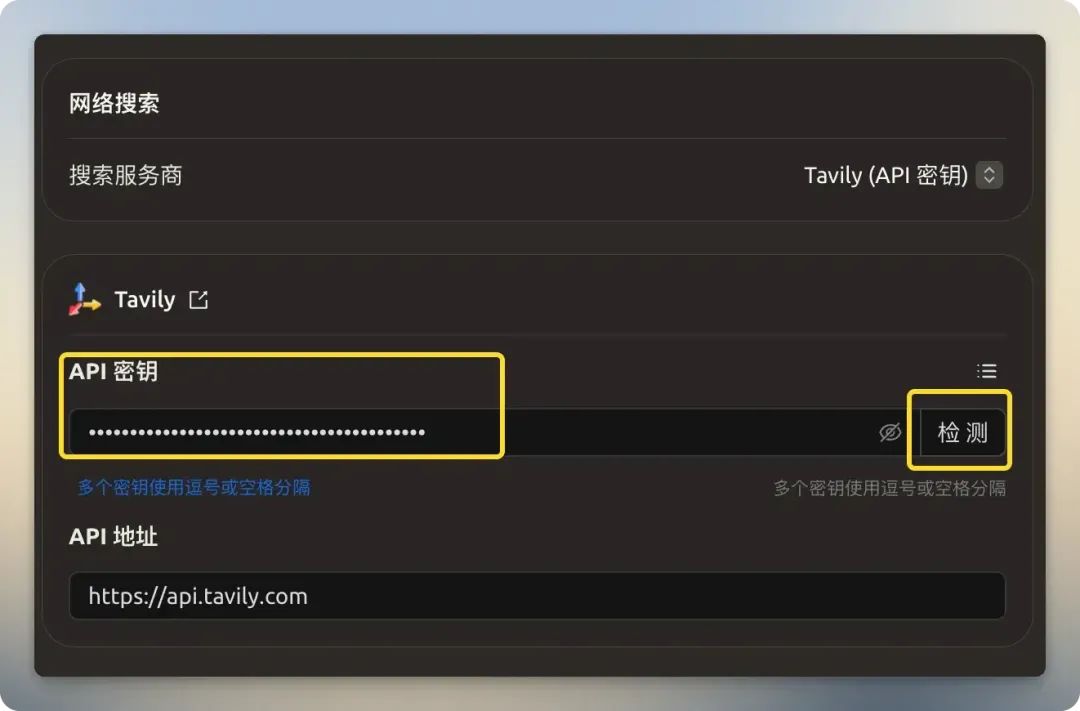

Tavily é um provedor de serviços especializado em APIs de pesquisa para grandes modelos de linguagem. Seu principal ponto forte é a capacidade de retornar dados altamente relevantes, refinados e estruturados, filtrando informações irrelevantes de páginas da Web tradicionais, reduzindo, assim, o tamanho e o custo do contexto fornecido ao modelo.Tavily O plano gratuito da Huawei oferece 1.000 chamadas de API por mês, sem vinculação a cartão de crédito e acesso direto na China. Depois de se inscrever, basta obter a chave de API no back-end e preencher os campos apropriados.

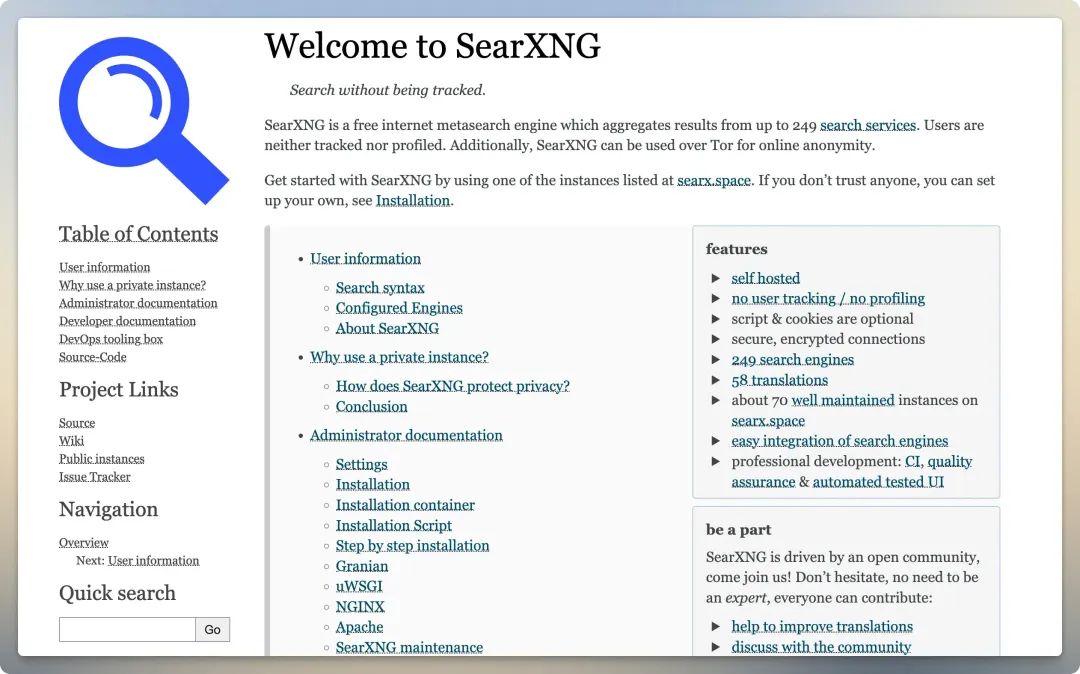

Searxng

Searxng é um mecanismo de metabusca de código aberto (https://github.com/searxng/searxng), que agrega resultados de vários serviços de pesquisa. Os usuários podem consultar a documentação oficial para implantar o serviço por conta própria para obter maior privacidade e controle.

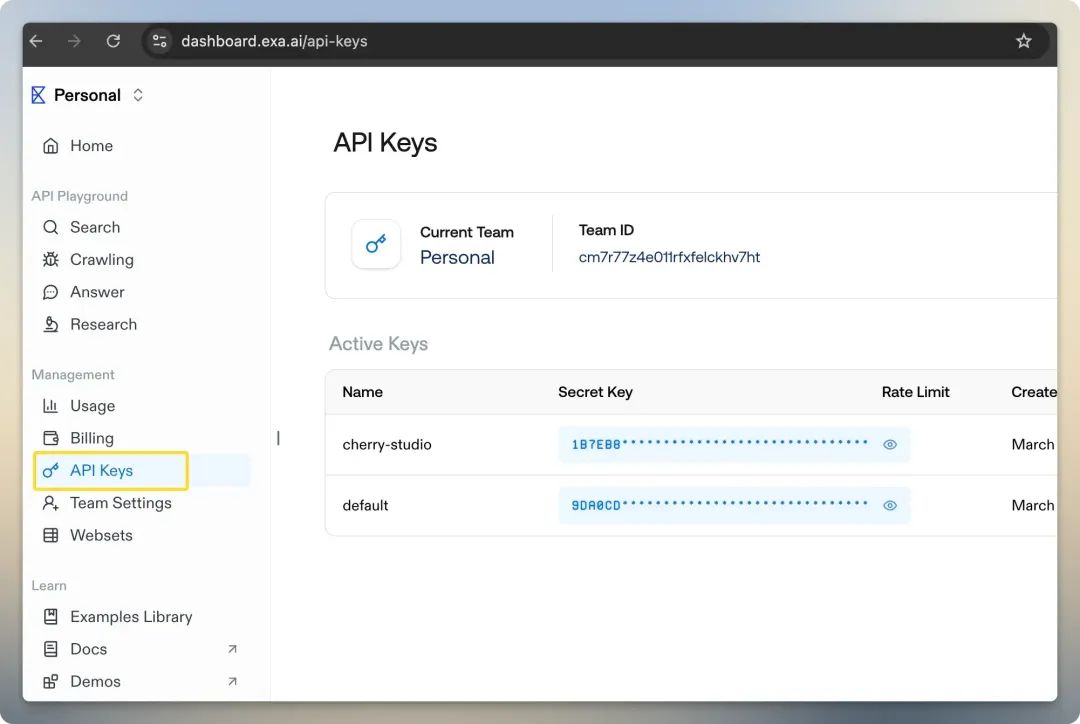

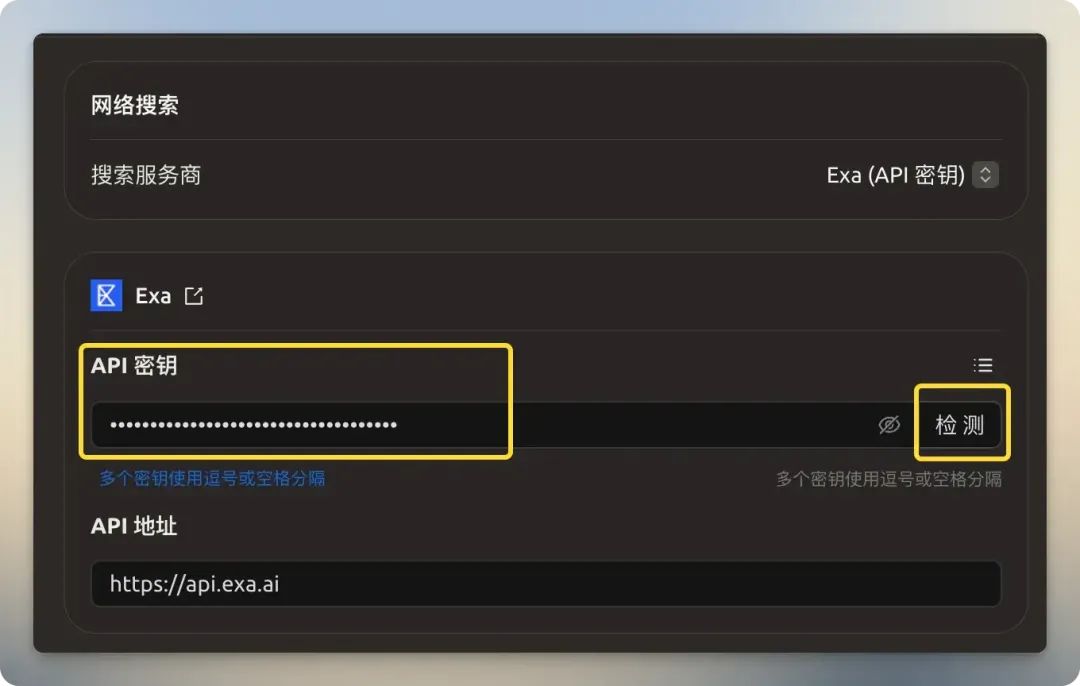

Exa

Exa (anteriormente Metaphor) é outro provedor de pesquisa orientado por IA, cuja melhor característica é o fato de oferecer pesquisa neural baseada em "semântica". Ao contrário da pesquisa tradicional, que se baseia na correspondência de palavras-chaveExa Ele entende melhor a verdadeira intenção por trás de uma consulta (por exemplo, quando você pesquisa "como será o futuro dos telefones com IA", ele entende que essa é uma pergunta conceitual e aberta) para encontrar resultados mais profundos e relevantes. Ele também oferece suporte a pesquisas específicas de domínio, como ensaios,Github Warehouse e Wikipedia. Os novos usuários receberão um crédito gratuito de US$ 10.

Bocha

doméstico 博查 Ele também oferece um serviço de API de pesquisa de IA multimodal, mas seu serviço é um modelo puramente pago, sem créditos gratuitos.

Lançado recentemente Com a iminência da descontinuação da API do Bing Search, a API da Secret Tower poderia ser uma nova opção?Também há novas opções.

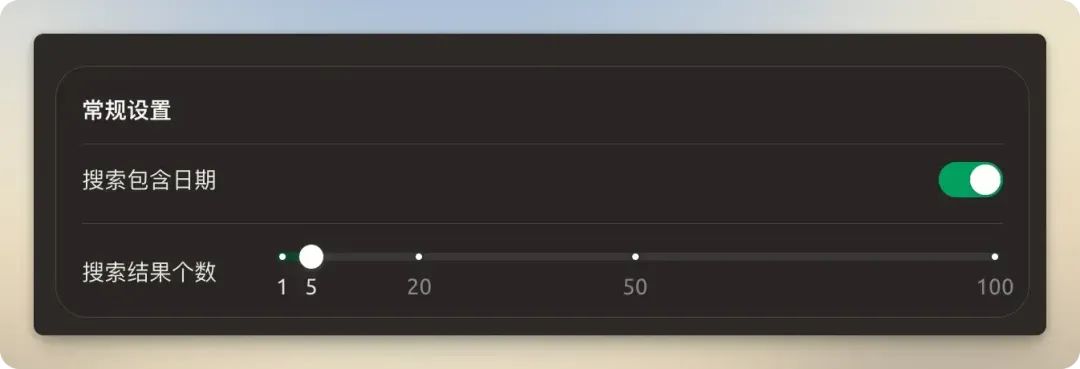

Configurações gerais

Recomendado para ligar "A pesquisa contém data" para obter informações mais atualizadas. Recomenda-se que o número de resultados da pesquisa permaneça no padrão de 5. A definição de um número excessivo de resultados não só aumentará o consumo de tokens, mas também poderá resultar em falhas de processamento por exceder a janela de contexto do modelo.

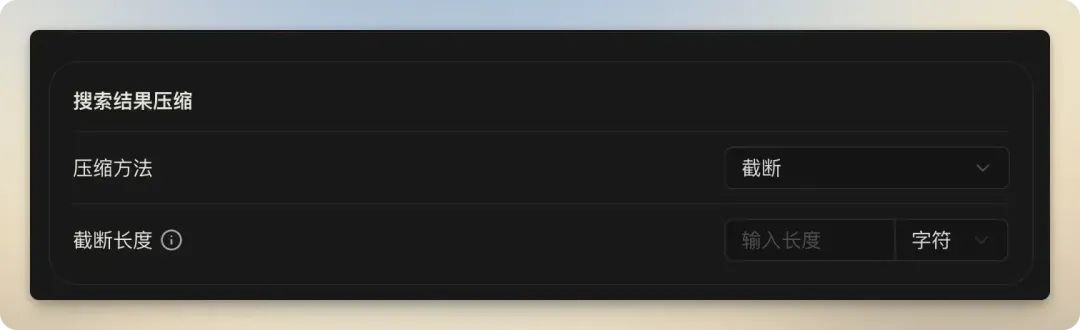

Resultados da pesquisa compressão

Esse recurso é usado para processar e refinar o conteúdo das páginas da Web pesquisadas para se adequar às restrições contextuais do modelo. Compreender as diferenças entre essas três opções é fundamental para otimizar a eficácia e o custo da pesquisa conectada.

| Método de compressão | vantagem | desvantagens | Cenários aplicáveis |

|---|---|---|---|

| sem compressão | Simples de implementar e rápido de processar. | Altamente suscetível a exceder os limites de contexto do modelo, alto custo de token e contém muitas informações irrelevantes. | Disponível apenas ocasionalmente quando a janela de contexto do modelo é muito grande e a página de resultados da pesquisa é muito limpa. |

| truncar | O controle é simples e direto e pode efetivamente evitar excessos. | Ele pode cortar o conteúdo antes que as informações críticas estejam disponíveis, resultando em perda de informações. | Pesquisa rápida e de baixo custo para modelos com janelas de contexto limitadas, mas aceita o risco de informações incompletas. |

| RAG | A mais alta precisão, identificando e fornecendo as informações mais relevantes, reduzindo efetivamente a "ilusão da IA". | A configuração e a computação são relativamente complexas, com alguns requisitos no modelo Embedding. | É a abordagem mais avançada e recomendada para consultas sérias em que a qualidade da resposta é alta. |

- sem compressãoForneça o conteúdo original da Web diretamente para o modelo.

- truncarControle de truncamento: truncamento rígido de conteúdo extralongo definindo o número de caracteres ou a contagem de tokens. Esse é um método de controle simples e de força bruta, mas o risco é que informações críticas possam estar localizadas na parte truncada.

- RAGEssa opção não é simplesmente "compressão", mas significa Geração aprimorada de pesquisa(Retrieval-Augmented Generation).

RAGé uma estrutura avançada de IA que primeiro recupera informações relevantes de uma base de conhecimento externa e, em seguida, envia essas informações ao modelo juntamente com a pergunta original do usuário, orientando o modelo a gerar respostas mais precisas e confiáveis. Seu princípio de funcionamento pode ser simplificado da seguinte forma: primeiro, ele utiliza Modelos de incorporação Todos os trechos de texto pesquisados e as perguntas dos usuários são convertidos em vetores numéricos e, em seguida, a similaridade é calculada no espaço vetorial para descobrir os trechos de texto mais relevantes para a pergunta do usuário. Por fim, somente esses segmentos altamente relevantes são fornecidos como contexto para o modelo maior. Isso é semelhante a fazer com que o modelo faça um "exame de livro aberto" e vá diretamente para as páginas com as respostas corretas, o que faz uso eficiente dos dados mais recentes e reduz significativamente a probabilidade de o modelo "alucinar" (ou seja, inventar fatos). SeleçãoRAGApós o método de compactação, você também precisa configurar oEmbeddingparâmetros como modelo e dimensão de incorporação.

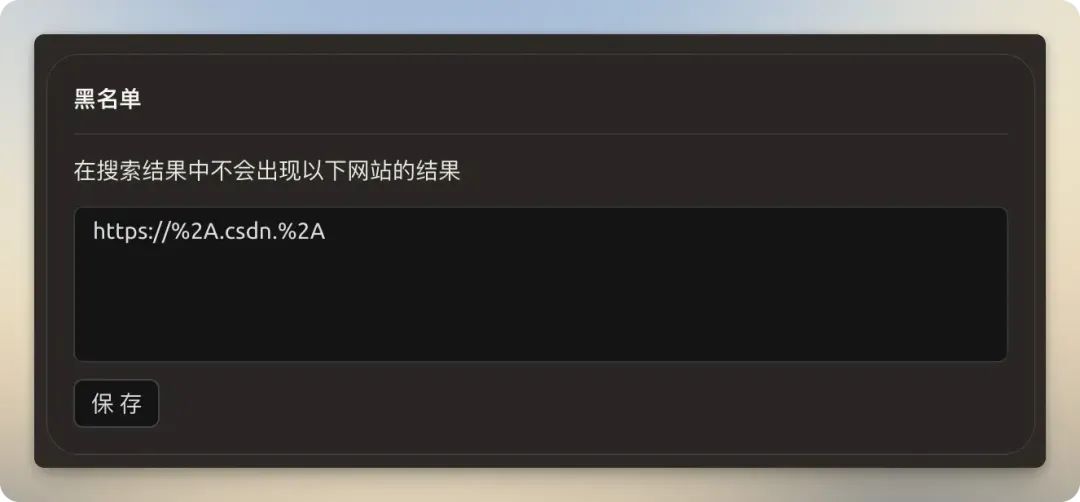

Listas negras e assinaturas

- listas negrasExpressões regulares: suporta o uso de expressões regulares para filtrar resultados de pesquisa de sites específicos, por exemplo, bloqueando sites com conteúdo de baixa qualidade.

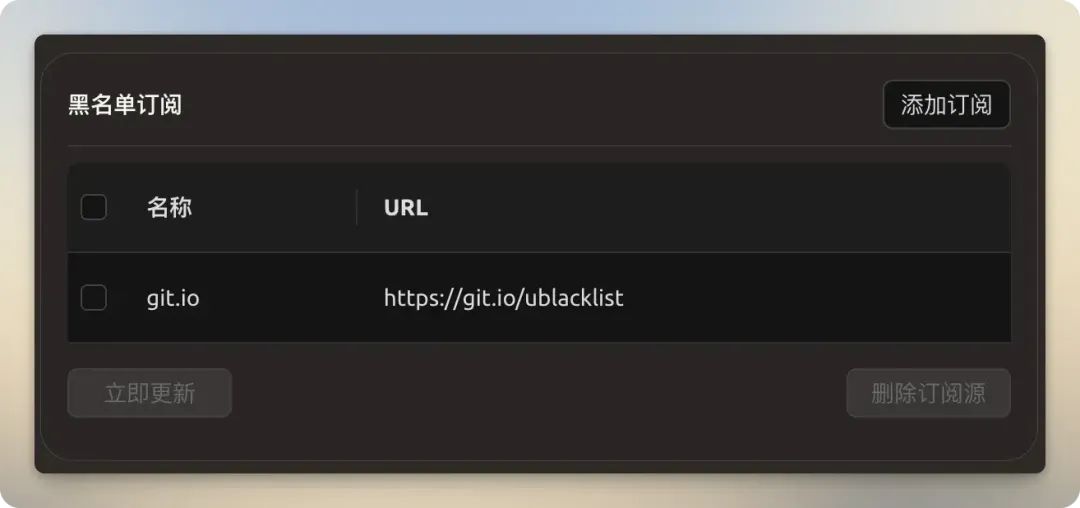

- Assinatura da lista negraAssinatura de links de listas negras mantidos pela comunidade (por exemplo, links de listas negras de

https://git.io/ublacklist), você pode bloquear em massa sites conhecidos de baixa qualidade ou com spam sem precisar adicioná-los manualmente, um a um.

exercício no local

Cherry Studio As buscas conectadas se enquadram em duas categorias: buscas incorporadas ao modelo e serviços de busca de terceiros.

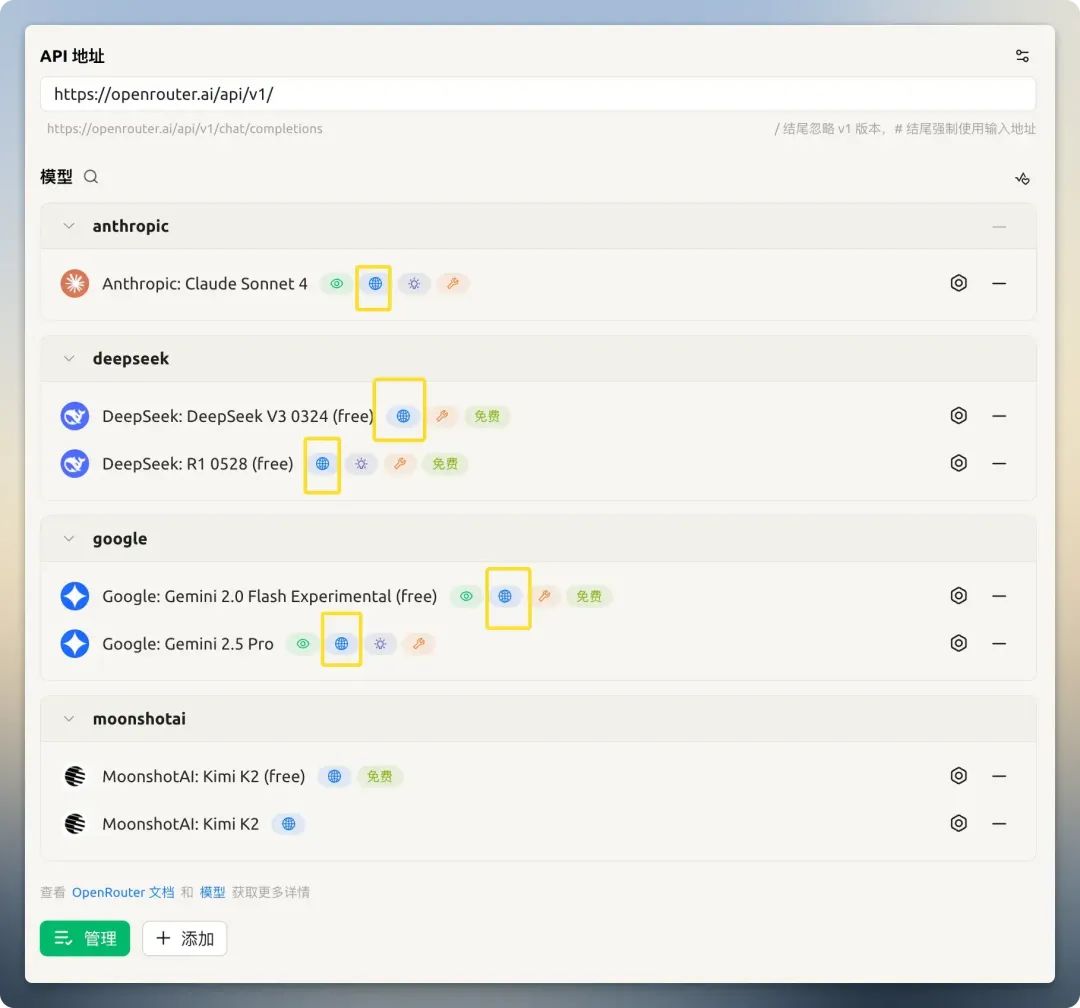

Modelo Pesquisa incorporada

Alguns provedores de modelos (por exemplo OpenRouter) integrou um recurso de pesquisa de rede embutido em seus modelos. Esse recurso pode ser ativado diretamente nas configurações do modelo.

以 OpenRouter Modelos gratuitos oferecidos Kimi K2 Por exemplo, quando a pesquisa está desativada, ela não pode responder à data atual; quando está ativada, ela responde corretamente e fornece a fonte das informações. É importante observar que alguns modelos afirmam oferecer suporte à rede, mas, na prática, são ineficazes ou não funcionam adequadamente (por exemplo, certos GitHub Models)。

Se você não encontrar uma API de modelo grande gratuita adequada, poderá escolher uma aqui:Lista de APIs Big Model gratuitas

Serviços de pesquisa de terceiros

Quando o modelo não tem recursos de pesquisa incorporados, um serviço de pesquisa de terceiros se torna essencial. Mas, ao usá-lo, você enfrentará dois problemas principais:

- Aumento do consumo de tokens

- Falha devido a resultados de pesquisa longos que excedem as limitações do contexto do modelo

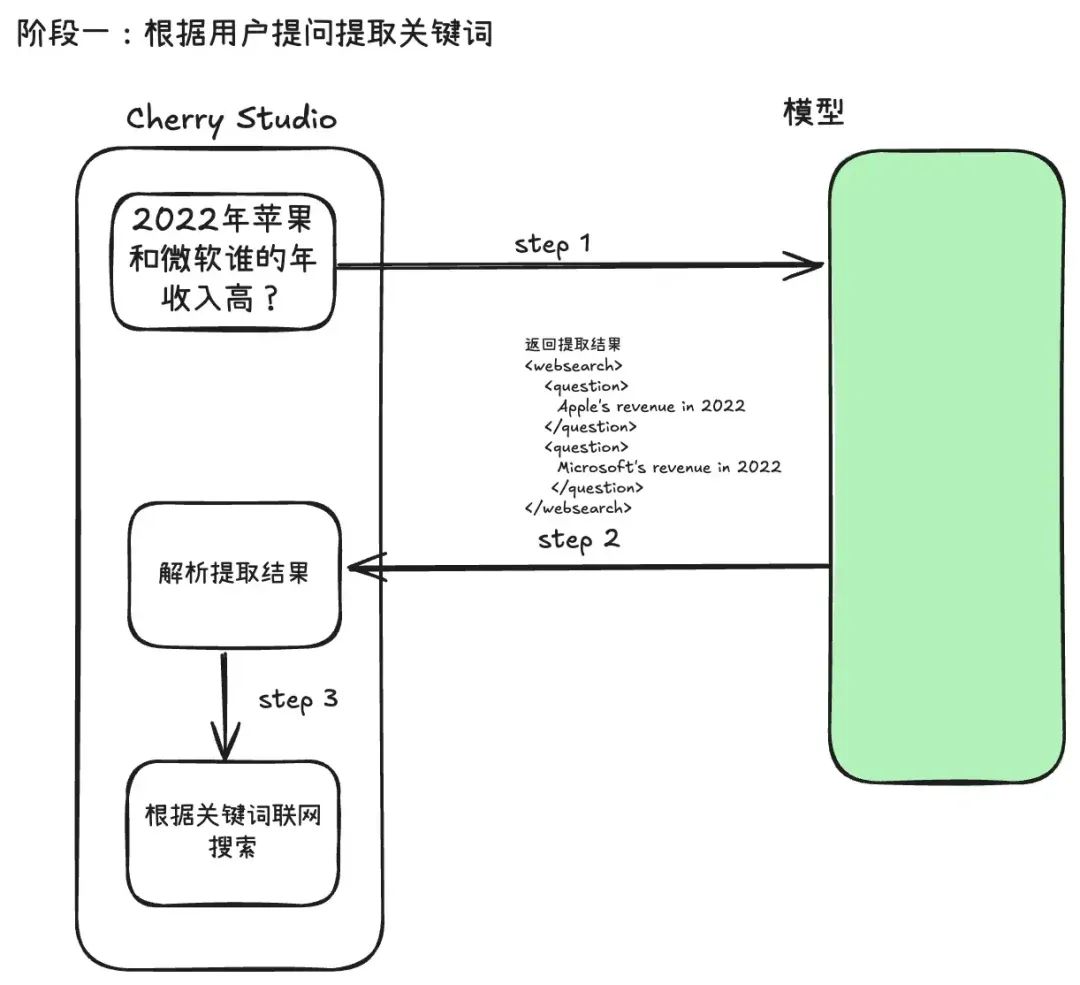

Cherry Studio O processo de pesquisa de terceiros é dividido em duas etapas:

Etapa 1: Extração de palavras-chave de pesquisa e aquisição de conteúdo

Quando um usuário envia uma pergunta, o sistema não envia a pergunta original diretamente para o mecanismo de busca. Em vez disso, ele chama o grande modelo uma vez primeiro, usando um modelo de prompt elaborado que permite que o modelo analise a intenção do usuário e extraia palavras-chave concisas que sejam mais adequadas para uso em pesquisas de máquina. Essa abordagem é conhecida comoReescrita de consultas (Query Rewriting)que pode melhorar muito a precisão das pesquisas subsequentes.

seguintes Cherry Studio extrator de palavras-chave Prompt Modelo. Como você pode ver, ele usa tags XML (como<websearch>) para forçar o modelo a gerar conteúdo estruturado que possa ser analisado diretamente pelo programa, uma técnica comum de "Prompt estruturado".

You are an AI question rephraser. Your role is to rephrase follow-up queries from a conversation into standalone queries that can be used by another LLM to retrieve information through web search.

**Use user's language to rephrase the question.**

Follow these guidelines:

1. If the question is a simple writing task, greeting (e.g., Hi, Hello, How are you), or does not require searching for information (unless the greeting contains a follow-up question), return 'not_needed' in the 'question' XML block. This indicates that no search is required.

2. If the user asks a question related to a specific URL, PDF, or webpage, include the links in the 'links' XML block and the question in the 'question' XML block. If the request is to summarize content from a URL or PDF, return 'summarize' in the 'question' XML block and include the relevant links in the 'links' XML block.

3. For websearch, You need extract keywords into 'question' XML block.

4. Always return the rephrased question inside the 'question' XML block. If there are no links in the follow-up question, do not insert a 'links' XML block in your response.

5. Always wrap the rephrased question in the appropriate XML blocks: use <websearch></websearch> for queries requiring real-time or external information. Ensure that the rephrased question is always contained within a <question></question> block inside the wrapper.

6. *use websearch to rephrase the question*

There are several examples attached for your reference inside the below 'examples' XML block.

<examples>

1. Follow up question: What is the capital of France

Rephrased question:`

<websearch>

<question>

Capital of France

</question>

</websearch>

`

2. Follow up question: Hi, how are you?

Rephrased question:`

<websearch>

<question>

not_needed

</question>

</websearch>

`

3. Follow up question: What is Docker?

Rephrased question: `

<websearch>

<question>

What is Docker

</question>

</websearch>

`

4. Follow up question: Can you tell me what is X from https://example.com

Rephrased question: `

<websearch>

<question>

What is X

</question>

<links>

https://example.com

</links>

</websearch>

`

5. Follow up question: Summarize the content from https://example1.com and https://example2.com

Rephrased question: `

<websearch>

<question>

summarize

</question>

<links>

https://example1.com

</links>

<links>

https://example2.com

</links>

</websearch>

`

6. Follow up question: Based on websearch, Which company had higher revenue in 2022, "Apple" or "Microsoft"?

Rephrased question: `

<websearch>

<question>

Apple's revenue in 2022

</question>

<question>

Microsoft's revenue in 2022

</question>

</websearch>

`

7. Follow up question: Based on knowledge, Fomula of Scaled Dot-Product Attention and Multi-Head Attention?

Rephrased question: `

<websearch>

<question>

not_needed

</question>

</websearch>

`

</examples>

Anything below is part of the actual conversation. Use the conversation history and the follow-up question to rephrase the follow-up question as a standalone question based on the guidelines shared above.

<conversation>

{chat_history}

</conversation>

**Use user's language to rephrase the question.**

Follow up question: {question}

Rephrased question:

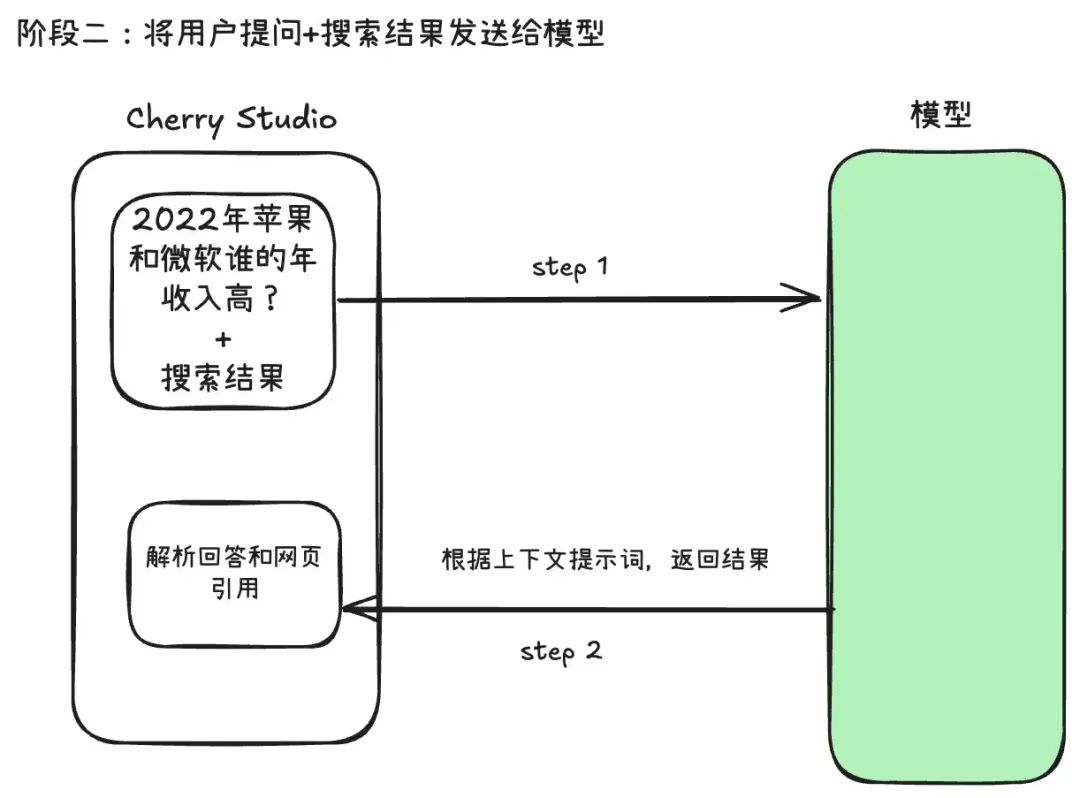

Estágio 2: Integração de informações e geração de respostas

O sistema pega o conteúdo da Web obtido no primeiro estágio e o "comprime", integra-o à pergunta original do usuário e o envia novamente ao modelo, que gera a resposta final com base nessas informações em tempo real.

Esse processo de dois estágios explica o aumento no consumo de tokens: uma chamada de API para extração de palavras-chave e uma chamada de API para geração da resposta final. O custo total é aproximadamente igual ao custo de dois diálogos separados, e a entrada do segundo diálogo também contém um grande número de resultados de pesquisa na Web.

É por isso que "Método de compressão" As configurações são essenciais. Selecione "Cortar". 或 "RAG" É para abordar essa questão.

A prática constatou que a escolha do provedor de serviços de busca afeta significativamente a taxa de falha. O uso de Google、Baidu Quando os mecanismos de pesquisa tradicionais, como esses, retornam páginas HTML completas e não processadas, eles são propensos a excessos, mesmo quando a janela de contexto do modelo é grande. Em vez de usar Tavily 或 Exa Esses tipos de provedores de serviços, que são projetados para IA, têm uma taxa de falha muito menor porque retornam dados pré-processados que são mais limpos, mais concisos e naturalmente adequados ao processamento de modelos.

Por exemplo, quando os resultados da pesquisa são definidos como 20, o método de compactação é "sem compactação" e um modelo com uma pequena janela de contexto (por exemplo, 8.000 tokens) é usado, a probabilidade de falha de uma pesquisa em rede aumenta significativamente.

Recomendações de uso

Testado.OpenRouter e do Google Gemini Oferece uma boa experiência com pesquisas em rede incorporadas. Se você precisar usar um serviço de pesquisa de terceiros, siga estas recomendações para garantir estabilidade e eficiência:

- Priorizar o uso da função de pesquisa integrada do modeloSe o próprio modelo permitir, essa é a maneira mais simples e direta de fazer isso.

- Escolha um serviço de pesquisa projetado para IA: Uso

Tavily、Exae outros provedores de serviços, em vez deGoogle或Baidu. Eles fornecem resultados mais limpos e relevantes, reduzindo o consumo de tokens e o risco de falhas de processamento. - Racionalização dos parâmetros de pesquisa: definido cuidadosamente de acordo com o tamanho da janela de contexto do modelo usado Número de resultados 和 Método de compressão(Altamente recomendado quando a qualidade é importante)

RAG) para evitar falhas de pesquisa devido a excesso de conteúdo.