O ARGO é uma plataforma de agente de IA de código aberto com o conceito de design central de "local primeiro", permitindo que os usuários criem um assistente de IA avançado e dedicado em seus próprios PCs. A plataforma integra várias tecnologias avançadas no campo da IA, como um sistema de inteligência múltipla que permite que as IAs pensem e planejem tarefas de forma autônoma, a tecnologia RAG que facilita o acesso a bases de conhecimento locais e o download e o gerenciamento com um clique de modelos locais de idiomas grandes. Com o ARGO, os usuários podem lidar de forma segura e privada com tarefas complexas, como pesquisa aprofundada, criação de conteúdo ou análise de dados, já que todos os dados são armazenados localmente com suporte total para operação off-line. O ARGO é compatível com os principais sistemas operacionais de desktop, como Windows, macOS e Linux, e também oferece métodos de implementação do Docker, com o objetivo de facilitar a todos a obtenção de uma verdadeira superinteligência de IA própria.

Lista de funções

- Localização e privacidadeO software suporta operação off-line completa e todos os dados do usuário 100% são armazenados no computador local para garantir privacidade e segurança. Estão disponíveis clientes Windows, macOS e Linux prontos para uso.

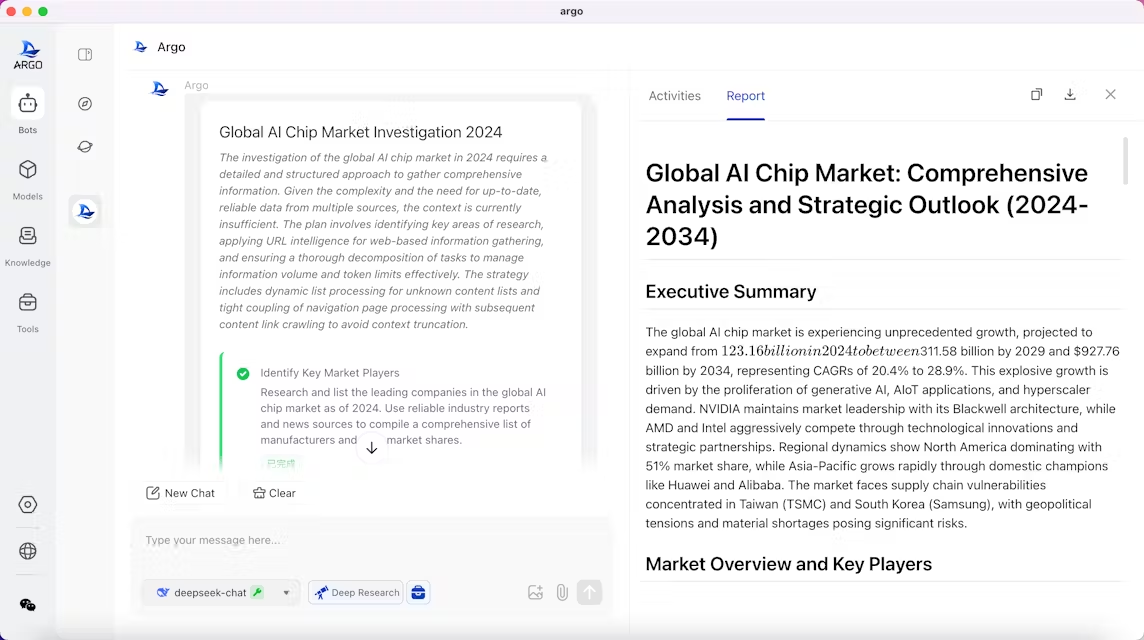

- colaboração de inteligência múltiplaMecanismo de tarefas de inteligência múltipla integrado que pode colaborar como uma equipe. Ele pode entender de forma autônoma a intenção do usuário, planejar etapas de tarefas, executar trabalhos em várias etapas e, por fim, gerar relatórios.

- Intelligentsia personalizadaOs usuários podem criar inteligências exclusivas com base em necessidades específicas, como assistentes de planejamento de viagens, analistas do setor ou consultores jurídicos. Com uma simples descrição, é possível personalizar um assistente de IA para um cenário específico.

- Compatível com muitos modelos grandesOllama: O Ollama integrado permite que você baixe e execute grandes modelos de código aberto com um clique. Ele também oferece suporte ao acesso às APIs do OpenAI, Claude, DeepSeek e muitos outros modelos de código fechado, para que os usuários possam alternar com flexibilidade entre modelos locais e modelos de API na nuvem, conforme necessário.

- Mecanismo de base de conhecimento RAG localBase de conhecimento: suporta a importação de conhecimento de arquivos, pastas, sites e outros canais. Quando associada a uma pasta local, a base de conhecimento pode ser sincronizada e atualizada dinamicamente. É capaz de analisar documentos em vários formatos, como PDF, Word, páginas da Web etc., e rastrear o conteúdo de referência ao responder a perguntas.

- conjunto de ferramentas incorporadasRastreador da Web integrado, controle de navegador, gerenciamento de arquivos locais e outros utilitários, além de suporte para que os usuários ampliem a integração de suas próprias ferramentas.

- Evolução do aprendizado contínuoSoftware: O software tem a capacidade de aprender os hábitos de trabalho e as preferências do usuário e pode ser otimizado no decorrer do uso, evoluindo para um corpo inteligente que entende melhor o usuário (esse recurso está sendo testado).

- Interação rica em bate-papoSuporte à renderização de fórmulas matemáticas, diagramas Mermaid (fluxogramas, diagramas de sequência, etc.) e permite que o diálogo se ramifique livremente, facilitando o gerenciamento e o rastreamento de registros de comunicação pelos usuários.

Usando a Ajuda

O ARGO foi projetado para simplificar o processo de implantação e uso de inteligências de IA locais, para que você possa começar rapidamente, seja você um usuário não técnico ou um desenvolvedor.

Requisitos básicos de hardware

Antes de instalar o ARGO, certifique-se de que seu computador atenda aos seguintes requisitos mínimos de configuração:

- CPUPelo menos 4 núcleos

- Memória (RAM)Pelo menos 8 GB

Se você planeja executar modelos de linguagem em larga escala com requisitos de desempenho mais altos, é recomendável usar hardware com configuração mais alta, especialmente computadores com placas de vídeo NVIDIA, para aproveitar a aceleração da GPU.

Instalação do cliente de desktop (recomendado para iniciantes)

Essa é a maneira mais fácil e direta de usá-lo, sem nenhuma configuração, download e uso adicionais.

- Visite a página oficial de lançamento do ARGO no GitHub (Releases).

- Dependendo do seu sistema operacional, faça o download do pacote de instalação correspondente:

- Windows: downloads com o sufixo

.exearquivos, como oargo-0.3.1-windows-x64-installer.exe。 - macOS (Apple Silicon): downloads com o sufixo

osx-installer.dmgarquivos, como oargo-0.3.1-osx-installer.dmg。 - macOS (Intel): downloads com o sufixo

mac-intel-installer.dmgarquivos, como oargo-0.3.1-mac-intel-installer.dmg。

- Windows: downloads com o sufixo

- Quando o download for concluído, clique duas vezes no arquivo de instalação e siga as instruções na tela para concluir a instalação.

Implantação com o Docker (para desenvolvedores e usuários avançados)

Se você estiver familiarizado com o Docker ou quiser implantar o ARGO em um ambiente de servidor, tudo em um etc., poderá escolher essa abordagem. Essa abordagem é mais flexível e pode ser facilmente integrada a outros serviços.

Requisitos adicionais de software:

Docker >= 24.0.0Docker Compose >= v2.26.1

Dependendo de suas necessidades, escolha uma das seguintes opções de implementação:

1 Opção 1: Instalação somente do ARGO (conexão com o Ollama externo)

Se você já tiver o serviço Ollama em execução localmente ou se tiver outros contêineres executando o Ollama, poderá usar esse comando para que o ARGO se conecte ao serviço existente.

docker compose -f docker/docker-compose.yaml up -d

tomar nota deEste programa não inclui o serviço Ollama, portanto, a capacidade de fazer download de alguns modelos dentro do software (por exemplo, do HuggingFace) pode ser limitada.

2 Opção 2: Instalação do ARGO com Ollama (versão CPU)

Esse cenário implementa o ARGO e o Ollama e usa a CPU para a inferência do modelo. Essa é a maneira recomendada de executar modelos locais em dispositivos sem placas de vídeo NVIDIA.

docker compose -f docker/docker-compose.ollama.yaml up -d

instruçõesOllama será implantado como um serviço com a ARGO no endereço de serviço http://ollama:11434A interface do ARGO suporta o download e o carregamento automáticos de modelos locais dentro da interface do ARGO.

3. opção 3: instalação do ARGO com Ollama (versão GPU)

Use essa solução se você tiver uma máquina com uma placa de vídeo NVIDIA e quiser acelerar a inferência do modelo usando a GPU.

docker compose -f docker/docker-compose.ollama.gpu.yaml up -d

pré-requisitosVerifique se o NVIDIA Container Toolkit está instalado corretamente no host. Essa versão habilitará o suporte a GPU, e o serviço Ollama também é implantado dentro de contêineres e oferece suporte à aceleração de GPU.

Visite a ARGO

Após uma implantação bem-sucedida via Docker, abra em seu navegador o arquivo http://localhost:38888 O acesso à interface de usuário do ARGO está disponível.

Operação da função básica

- gerenciamento de modelosVocê pode baixar modelos populares de código aberto da comunidade com um único clique ou pode configurar chaves de API para se conectar a serviços de modelos remotos, como o OpenAI.

- Criando a IntelligentsiaCom o Intelligence Factory, você pode definir as funções de uma nova inteligência, estabelecer seus objetivos de trabalho, vincular os modelos e as ferramentas que ela pode usar e configurar sua própria base de conhecimento.

- operarO sistema inteligente do ARGO dividirá automaticamente essa tarefa em várias etapas, como "pesquisar as informações mais recentes", "reunir informações importantes", "redigir um relatório" etc., e as executará sucessivamente. O ARGO dividirá automaticamente a tarefa em várias etapas, como "pesquisar as informações mais recentes", "reunir informações importantes", "redigir um relatório" etc., e as executará sequencialmente.

- Uso da base de conhecimentoNo módulo Knowledge Base Management, você pode criar uma base de conhecimento carregando um arquivo, associando-o a uma pasta local ou inserindo um URL. Após a criação, você pode optar por montar a base de conhecimento correspondente durante o diálogo com o organismo inteligente, e o organismo inteligente responderá às perguntas com base nas informações que você fornecer.

cenário do aplicativo

- Assistente pessoal

O ARGO pode ser usado como um assistente pessoal 24 horas por dia, 7 dias por semana, para ajudar os usuários a gerenciar suas agendas, fornecer sugestões de compras e lidar com as tarefas diárias, melhorando assim sua vida pessoal e eficiência no trabalho. - Estudo e pesquisa

Estudantes e pesquisadores podem usar o ARGO para auxiliar seu aprendizado. Ele pode ajudar a entender conceitos acadêmicos complexos, fornecer recursos de aprendizagem ricos, personalizar planos de estudo e dar conselhos de revisão quando necessário. Ao montar artigos e livros didáticos, o ARGO pode se tornar um assistente profissional de questionários acadêmicos. - criação de conteúdo

Para escritores, blogueiros e profissionais de marketing, o ARGO pode gerar automaticamente rascunhos de artigos, otimizar estilos de redação, fornecer inspiração criativa e melhorar significativamente a eficiência e a qualidade da criação de conteúdo. - Assistência ao desenvolvimento de programas

Os desenvolvedores podem usar o ARGO para gerar trechos de código, depurar programas ou buscar soluções para problemas técnicos. Ele pode atuar como um parceiro de programação incansável para ajudar os desenvolvedores a resolver desafios de programação com mais eficiência. - Consultores em áreas especializadas

Por meio da personalização, o ARGO pode ser transformado em um especialista em um setor específico, como um consultor jurídico ou um analista do setor. Os usuários podem criar um corpo inteligente equipado com uma base de conhecimento especializada para atender às necessidades de uma área específica de especialização. - Análise de dados e relatórios

O ARGO analisa rapidamente os dados, gera gráficos e relatórios e fornece suporte de dados para decisões de negócios. Os usuários só precisam importar arquivos de dados e dar instruções para analisá-los.

QA

- O ARGO é gratuito?

Sim, o ARGO é um projeto de código aberto, lançado sob a licença LICENSE, e você pode baixá-lo, usá-lo e modificá-lo gratuitamente. - Meus dados estão seguros?

Um dos principais recursos do ARGO é o "local first", ou seja, todos os dados, inclusive os registros de conversas, o conteúdo da base de conhecimento e os arquivos de modelo, são armazenados em seu próprio computador e não são carregados em nenhum servidor em nuvem, portanto, é totalmente compatível com a execução do LINE. - Quais modelos de IA posso usar?

O ARGO é muito compatível. Ele tem o Ollama integrado, o que facilita o download e a execução de modelos nativos de código aberto no formato GGUF. Ele também suporta a conexão com os principais provedores de modelos de código fechado, como OpenAI, Claude, DeepSeek, etc., por meio de chaves de API. - Pessoas não técnicas podem usar o ARGO?

Sim. O ARGO oferece um pacote de instalação gráfica para usuários do Windows e do macOS, que pode ser instalado com um clique duplo, sem operações complicadas de linha de comando, o que o torna ideal para usuários com formação não técnica. - Esse projeto ainda está em desenvolvimento?

Sim, o projeto ARGO está atualmente nos estágios iniciais de desenvolvimento rápido. A equipe de desenvolvimento está trabalhando ativamente para melhorar os recursos e corrigir problemas, e planeja adicionar mais recursos, como memórias globais personalizadas, tarefas cronometradas e muito mais no futuro.