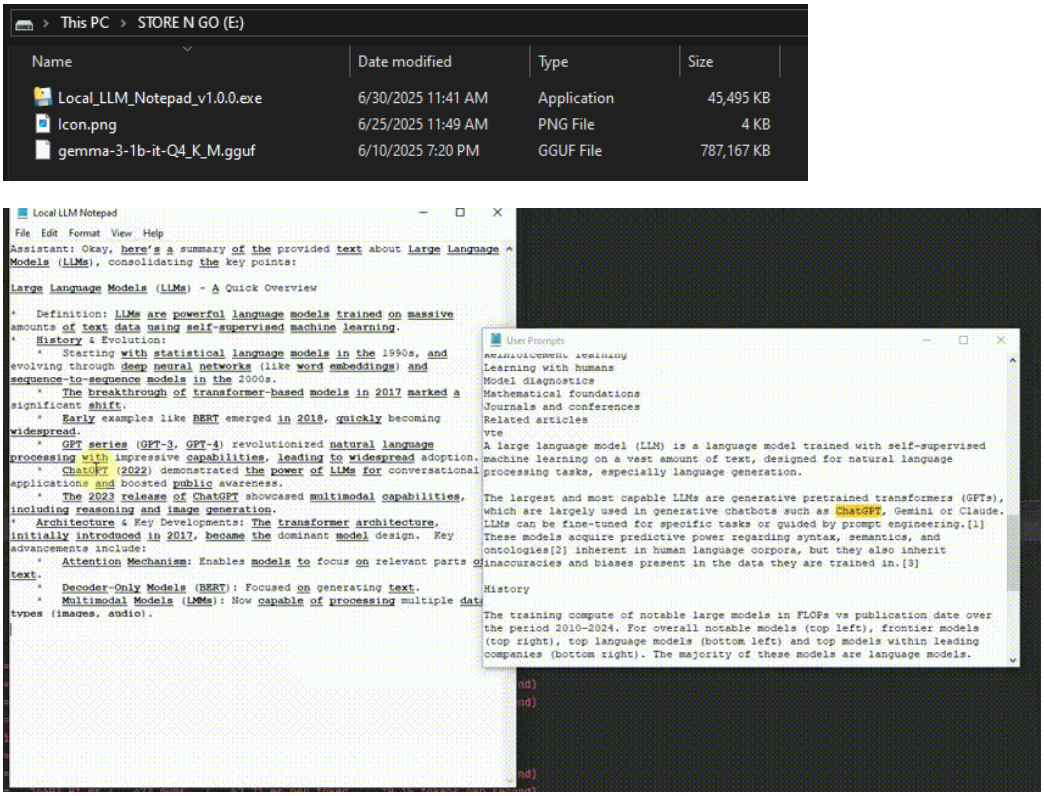

Local LLM Notepad 是一个开源的离线应用程序,允许用户在无需联网、无需安装的情况下,通过USB设备在任何Windows电脑上运行本地大语言模型。用户只需将单个可执行文件(EXE)和模型文件(如GGUF格式)拷贝到U盘,即可随时随地进行聊天、头脑风暴或文档起草。它的设计目标是简单易用,无需管理员权限,适合技术水平不同的用户在各种场景下使用,比如客户端访问或临时工作站。该工具强调便携性和隐私保护,所有数据处理均在本地完成,无需依赖云端或API服务。界面简洁直观,采用双窗口布局,支持提示词高亮和JSON格式导出对话,方便用户管理和追溯内容。

功能列表

- 离线运行大语言模型:无需联网,加载GGUF格式模型,适合隐私敏感场景。

- 便携性设计:单文件EXE,无需安装,直接从U盘运行。

- 双窗口交互界面:下方输入提示词,上方实时显示模型回答,界面简洁无多余装饰。

- 提示词高亮与追溯:用户输入的词语在模型回答中自动加粗下划线,Ctrl+点击可查看相关提示词历史。

- JSON对话导出:支持一键导出对话记录,方便跨设备迁移。

- 模型灵活切换:通过“文件 > 选择模型”加载不同GGUF模型,适配多种需求。

- 高效性能:支持快速CPU模型(如0.8GB模型),在普通硬件上实现约20 tokens/秒的生成速度。

使用帮助

安装与准备

Local LLM Notepad 不需要传统意义上的安装,设计为即插即用。以下是详细准备流程:

- 下载程序:访问 GitHub 仓库(https://github.com/runzhouye/Local_LLM_Notepad)的 Releases 页面,下载最新版本的

Local_LLM_Notepad-portable.exe。 - 获取模型文件:下载兼容的 GGUF 格式模型文件,例如推荐的

gemma-3-1b-it-Q4_K_M.gguf(约0.8GB)。可以在 Hugging Face 或其他模型社区获取。 - 复制到U盘:将下载的 EXE 文件和 GGUF 模型文件复制到U盘或其他移动存储设备。

- 运行程序:在任意Windows电脑上双击

Local_LLM_Notepad-portable.exe启动。首次运行时,程序会将模型加载到内存(RAM),可能需要几秒钟,后续操作会更流畅。

主要功能操作

1. 运行与交互

启动程序后,界面分为上下两部分:

- 下半部分:输入提示词(prompt),支持文本、问题或指令。

- 上半部分:实时显示模型的回答,生成速度约为20 tokens/秒(视硬件性能而定)。

用户可以直接输入问题或任务,例如“帮我写一封邮件”或“解释量子力学”,模型会即时生成答案。界面没有复杂菜单,操作直观,适合快速上手。

2. 提示词高亮与追溯

Local LLM Notepad 的特色功能之一是提示词高亮。用户在提示词中输入的单词或数字会在模型回答中以加粗下划线形式显示。例如,输入“2025年的技术趋势”,模型回答中涉及“2025”或“技术”的部分会高亮。用户可以通过按住 Ctrl 并点击高亮词,打开一个侧边窗口,查看包含该词的所有历史提示词。这一功能非常适合需要验证模型输出或追溯信息的场景,例如数据提取或总结核查。

3. 模型切换

如果需要更换模型,可以点击菜单栏的 文件 > 选择模型,在U盘中选择其他GGUF格式模型文件。程序会自动加载新模型,无需重启。建议初次用户使用推荐的轻量模型(如0.8GB的 gemma-3-1b-it-Q4_K_M.gguf),以保证在普通硬件上的流畅体验。

4. 导出对话

用户可以通过点击界面内的导出按钮,将当前对话以 JSON 格式保存到U盘或其他存储路径。导出的文件包含完整的提示词和模型回答,方便在其他设备上继续使用或存档。操作步骤:

- 点击菜单栏的

导出按钮。 - 选择保存路径并命名文件(默认扩展名为

.json)。 - 保存后,文件可通过文本编辑器查看,或导入其他支持JSON的工具。

5. 性能优化

程序针对普通硬件优化,无需GPU支持。首次加载模型时,程序会将模型缓存到RAM,加快后续响应速度。如果电脑内存较低,建议选择较小的模型文件(小于1GB)。在测试中,程序在 i7-10750H CPU 上可实现约20 tokens/秒的生成速度,适合大多数日常任务。

注意事项

- 硬件要求:最低4GB内存,推荐8GB以上以确保流畅运行。

- 模型兼容性:仅支持 GGUF 格式模型,不兼容其他格式如 PyTorch 或 ONNX。

- 操作系统:目前仅支持Windows系统,暂无Mac或Linux版本。

- 隐私保护:所有处理均在本地完成,无数据上传,确保信息安全。

应用场景

- 临时工作站使用

在没有网络或权限受限的电脑(如客户现场或公共设备)上,通过U盘运行Local LLM Notepad,快速完成文档起草、头脑风暴或问题解答。 - 隐私敏感任务

对于需要高度保密的场景,如法律文件起草或敏感数据分析,离线运行确保数据不外泄,适合律师、记者或研究人员。 - 教育与学习

学生或教师可以在课堂上使用此工具,通过输入问题获取模型解释复杂概念,或生成学习笔记,适合无网络的教学环境。 - 旅行中的创作

作家或创作者在旅途中使用U盘运行程序,随时记录灵感、起草文章或生成创意内容,无需依赖云端服务。

QA

- 需要联网吗?

不需要。Local LLM Notepad 完全离线运行,所有计算在本地完成,无需互联网连接。 - 支持哪些模型?

目前支持 GGUF 格式模型,推荐使用轻量模型如gemma-3-1b-it-Q4_K_M.gguf。用户可从 Hug16. ging Face 等平台下载兼容模型。 - 可以在Mac上运行吗?

目前仅支持Windows系统。Mac或Linux用户需等待后续版本或使用虚拟机运行。 - 如何保证生成速度?

程序针对CPU优化,首次加载模型后会缓存到RAM。建议使用8GB以上内存的设备,并选择小于1GB的模型以获得最佳性能。 - 对话记录如何保存?

通过菜单栏的导出功能,将对话保存为 JSON 文件,存储在U盘或其他设备上,方便迁移和存档。