在构建高级 AI 应用时,实时联网搜索是实现信息同步的关键功能。不过,直接使用平台官方的搜索插件,可能会遇到网络限制或高昂的 API 费用问题。

本文提供一个高性价比的替代方案:通过 Dify 的 HTTP 请求功能,结合腾讯元器平台,来构建一个私有化、免费的联网搜索工具。这套方法不仅能绕开依赖限制,还能让你的 Agent 具备强大的实时信息获取能力。Dify 是一个开源的 LLMOps 平台,旨在帮助开发者快速构建和运营基于大型语言模型的 AI 应用。

架构解析

这个方案的原理可以理解为“服务代理”。

我们使用腾讯元器作为外部搜索服务的提供者。腾讯元器是一个 AI 应用开发平台,通过其工作流功能,可以将复杂的搜索逻辑封装成一个标准的 API 接口。

之后,在 Dify 中,使用 HTTP 请求节点作为客户端来调用这个接口。最终,将整个 HTTP 调用流程发布为一个 Dify 工具,这样它就可以被任何 Agent 或工作流模块化地调用。

该架构的优势很明显:

- 解耦:搜索服务的实现与

Dify的应用逻辑分开,方便独立维护和升级。 - 成本控制:利用免费平台的资源,实现零 API 成本。

- 私有化:工具由自己构建和控制,数据链路清晰,安全性更高。

需要准备什么?

在开始之前,请准备好以下环境和凭证:

- 腾讯元器平台访问权限:注册并登录,地址

https://yuanqi.tencent.com/。 - Dify 运行环境:社区版或云服务版均可。

- 大模型 API Key(可选):腾讯元器的工作流默认使用其内置模型,但一些高级功能或自定义配置可能需要用户提供自己的模型 API Key (如

DeepSeek等)。本次基础搜索教程中暂不涉及,可以先不准备。

操作步骤:从服务构建到工具集成

按照以下步骤,分阶段完成整个构建过程。

阶段一:在腾讯元器中构建并发布搜索服务

- 创建工作流

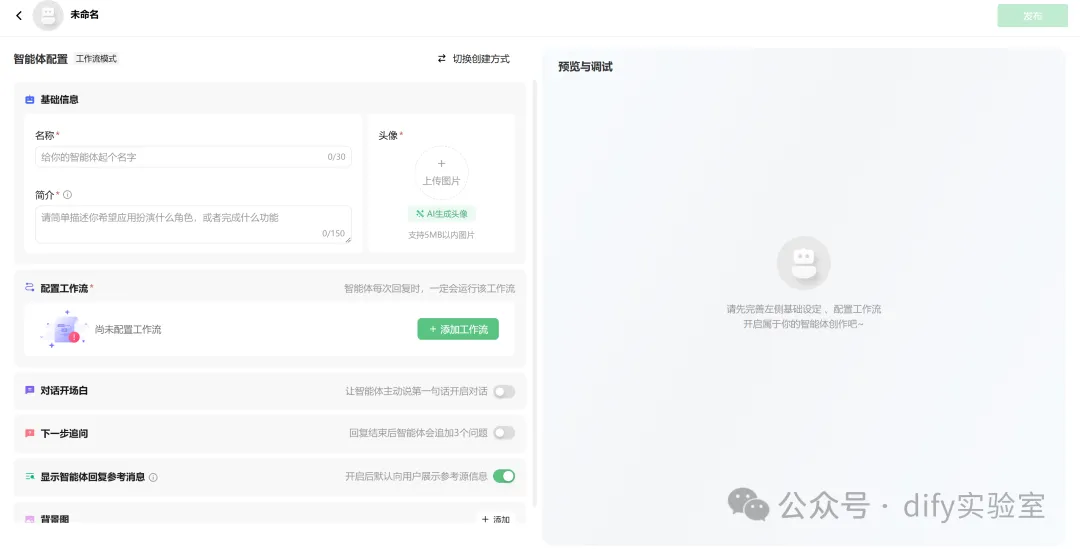

登录腾讯元器,创建一个新的智能体,并选择“工作流”作为创建模式。

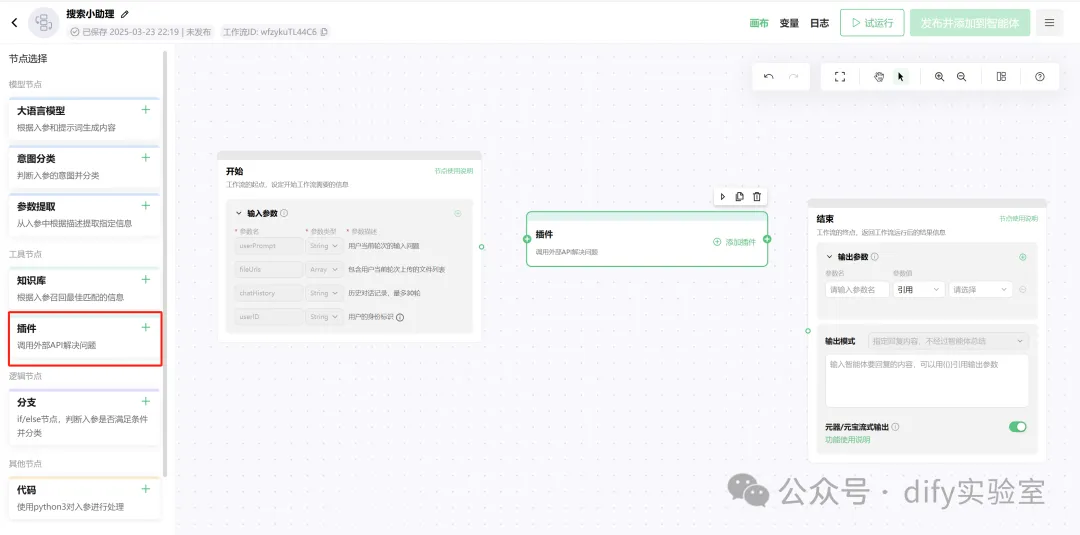

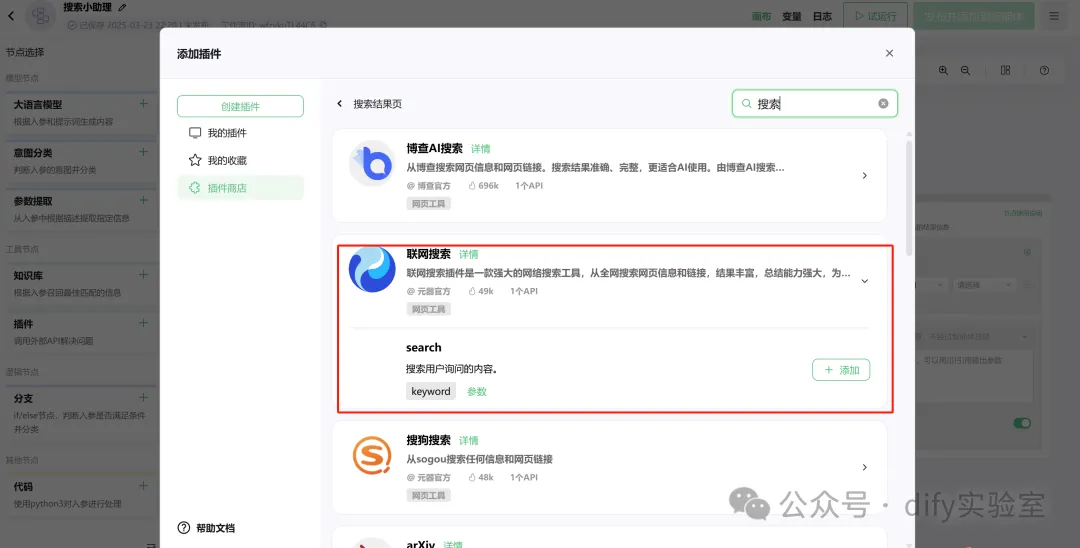

- 添加搜索插件

在工作流画布中,从左侧的插件库里找到并添加官方提供的“搜索”插件。

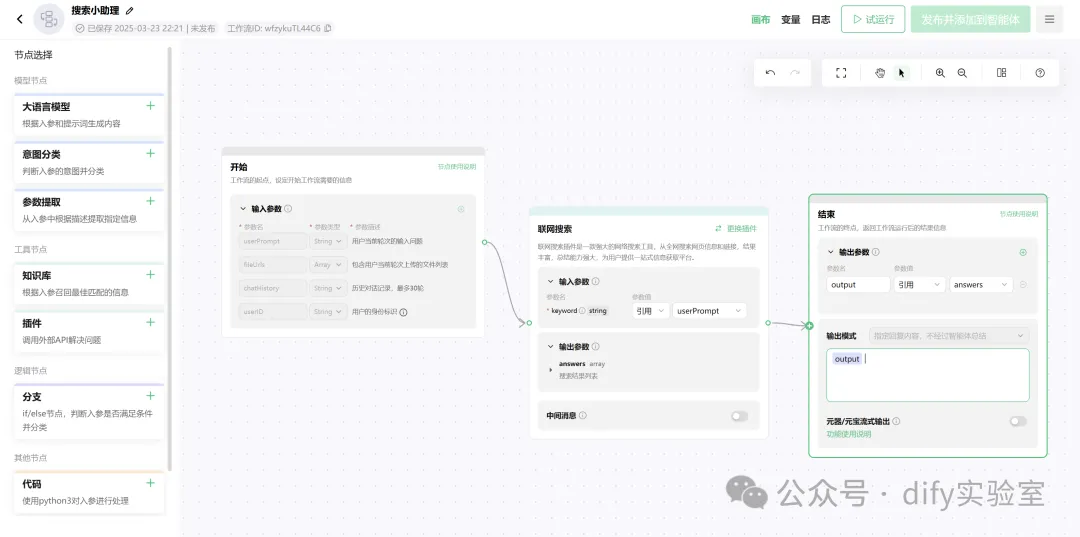

- 配置参数

配置插件的输入参数,确保它能接收外部传入的查询变量 (Query)。

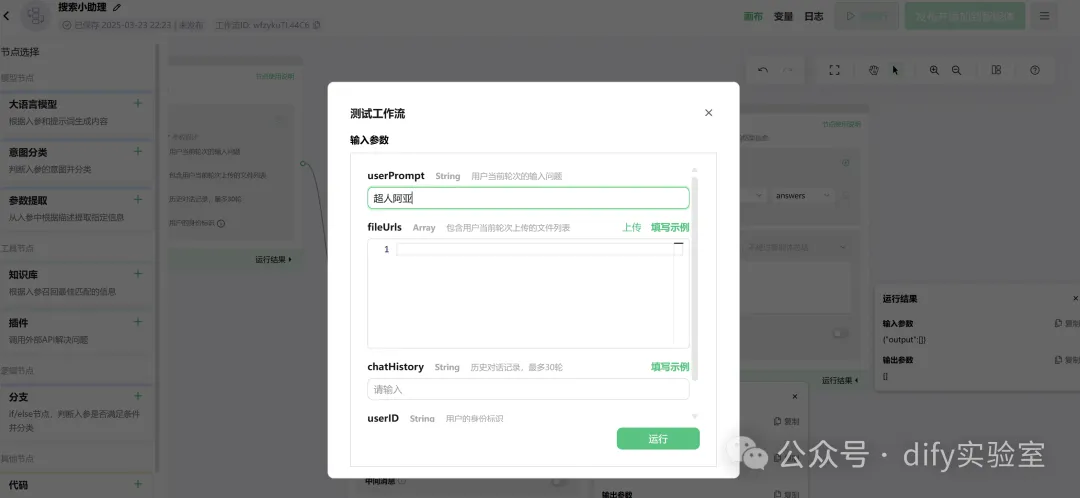

- 测试与发布

在工作流界面进行试运行,验证搜索功能是否正常工作。确认无误后,发布工作流并将其关联到智能体,最后发布该智能体。

- 获取 API 凭证

进入智能体管理页面,在“发布信息”中找到“接口调用”部分,获取 API 的 URL、Authorization以及签名所需的 Headers 信息。这些是连接Dify与元器的关键。

阶段二:在 Dify 中创建并封装 HTTP 工具

- 初始化工作流

在Dify中,创建一个包含 开始 -> HTTP 请求 -> 结束 节点的工作流。

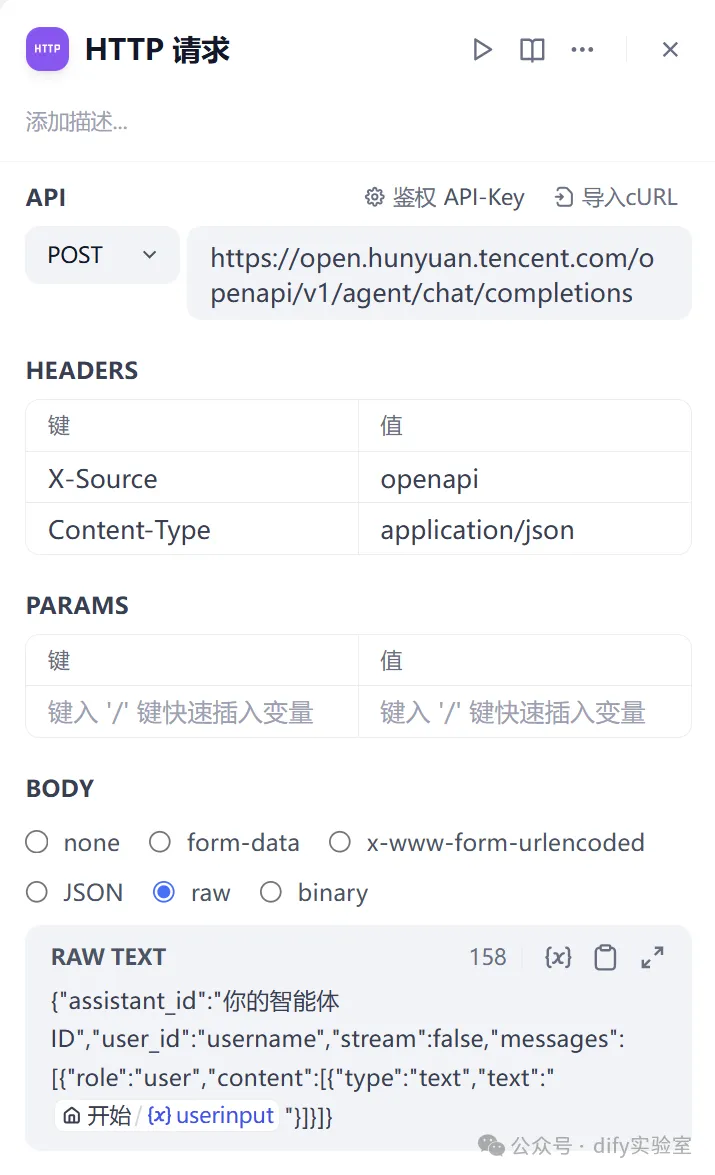

- 配置 HTTP 请求节点

这是集成的核心环节。- Method:

POST - Request URL: 填入从腾讯元器获取的 API URL。

- Headers: 精确填入从元器获取的全部认证头信息,如

Authorization,X-TC-Timestamp等。 - Body: 选择

raw-text,格式为application/json,并构造请求体,如{"query": "{{query}}"}。这里的{{query}}是Dify的变量占位符。

- Method:

- 单元测试

在 HTTP 节点内,使用“运行此步骤”功能,输入一个测试查询词,验证接口是否能返回status 200的成功状态码。 - 发布为工具

验证通过后,保存并发布工作流。最关键的一步是,点击右上角的“发布为工具”,为它设定一个清晰的名称,例如Internal_Search_Engine。

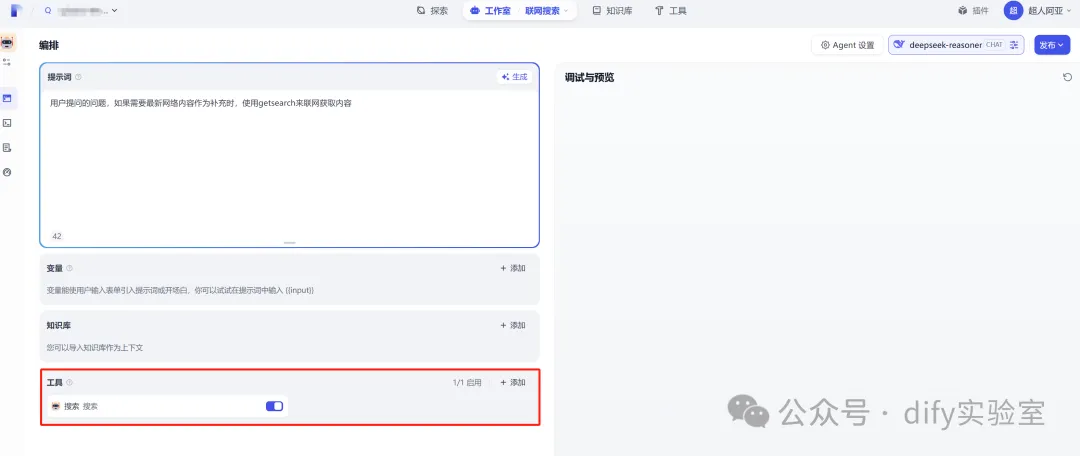

阶段三:在 Agent 中验证工具

- 创建测试 Agent

新建一个Agent应用用于测试。 - 加载工具

在Agent的“工具”配置项中,添加刚刚创建的Internal_Search_Engine工具。 - 端到端测试

在调试与预览界面,向Agent提出一个需要实时信息的问题。观察它是否能够正确调用该工具,并利用返回的搜索结果生成回答。

问题排查与优化

- 常见

400 Bad Request错误

此问题通常是 HTTP 请求的构造错误。请重点检查:Headers中的认证信息是否完整、无误,特别是Authorization和时间戳相关的字段。注意一些签名凭证具有时效性,如果调用失败可以尝试重新生成。Body中的 JSON 格式是否严格正确。Content-Type头是否设置为application/json。

- 性能优化

腾讯元器的搜索插件支持limit参数,可以控制返回结果的数量(默认为10条)。你可以在元器的工作流中把这个参数也设置为变量,然后在Dify的 HTTP 请求体中动态传入,以便根据不同场景调整信息密度,优化处理效率。