DeepInfra 是一个为开发者提供人工智能模型调用服务的云平台。它让使用者可以通过一个简单的API接口,访问并运行包括Meta Llama 3、Mistral AI、Google Gemma在内的多种主流开源AI模型。 这个平台最大的特点是“Serverless”,也就是用户不需要自己部署和维护复杂的服务器硬件,可以直接按使用量付费,大大降低了AI应用的开发和运维门槛。 DeepInfra Chat是该平台提供的一个直观演示页面,用户可以在这个网页上直接与部署在平台上的各种大语言模型进行对话,感受不同模型的性能和特点。同时,它也向开发者展示了其API服务的实际效果,让他们可以快速测试和评估模型,以便将其集成到自己的应用程序中。

功能列表

- 多模型支持: 平台提供了丰富的开源大语言模型供用户选择,例如Llama、Mistral、Gemma等系列模型。

- 在线聊天界面: 提供一个简洁的网页聊天窗口,用户无需注册或配置,可以直接与选定的AI模型进行互动测试。

- API调用服务: 核心功能是为开发者提供稳定、可扩展的API接口,方便地将AI模型的能力集成到自己的软件或服务中。

- 按需付费: 采用按使用量(通常是按token数量)计费的模式,用户只需为实际消耗的计算资源付费,成本效益高。

- 生产环境开箱即用: 提供的是可扩展、低延迟的生产级基础设施,开发者无需处理复杂的机器学习运维(ML Ops)工作。

- 开发者工具集成: 支持与LangChain、LlamaIndex等主流AI开发框架集成,简化了构建复杂AI应用的流程。

使用帮助

DeepInfra Chat主要面向两类用户:一类是希望快速体验和评测不同大语言模型的普通用户;另一类是需要将AI模型能力集成到自己产品中的开发者。以下将分别介绍如何使用。

1. 网页版聊天功能(快速体验)

对于想直接体验AI模型对话能力的用户,使用方法非常简单:

- 访问网站: 在浏览器中打开网址

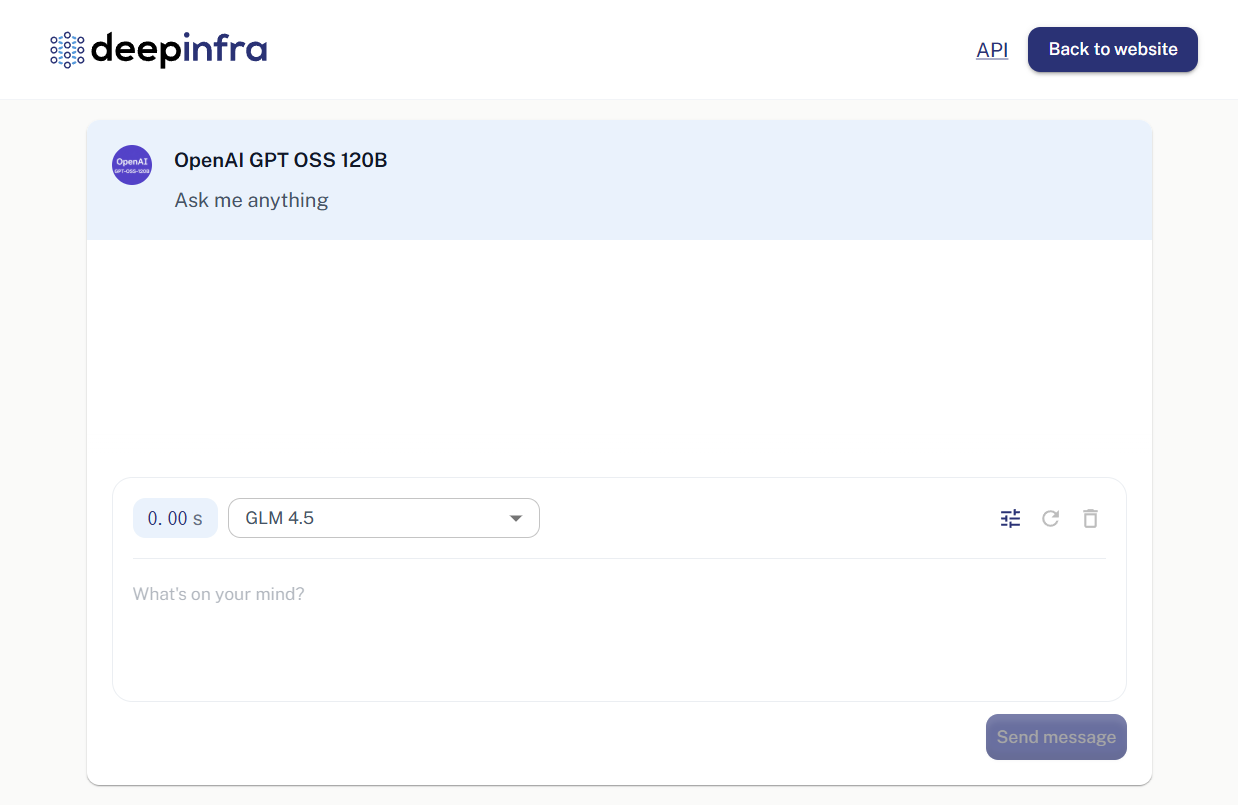

https://deepinfra.com/chat。 - 选择模型: 页面加载后,你会看到一个聊天界面。在界面上方通常会显示当前正在使用的模型名称(例如 “OpenAI GPT OSS 120B”)。你可以点击模型名称,从下拉列表中选择你感兴趣的其他模型进行切换,比如Llama 3或Mistral系列。

- 开始对话: 在页面底部的输入框中,输入任何你想问的问题或想说的话,然后按回车键或点击发送按钮。

- 查看回复: AI模型的回复会直接显示在聊天窗口中。你可以继续提问,进行多轮对话,以测试模型的逻辑、语言和知识能力。

这个过程不需要登录,也不需要任何配置,非常适合快速评测模型。

2. API调用服务(开发者使用)

对于开发者来说,DeepInfra的核心价值在于其强大的API服务。你可以通过API将这些AI模型的能力集成到你的网站、App或后端服务中。

第一步:创建账户并获取API密钥

- 注册/登录: 访问 DeepInfra 官网

https://deepinfra.com/,通常可以使用GitHub账户直接登录。 - 生成API密钥: 登录后,进入你的账户控制台(Dashboard),找到API Keys管理页面(通常路径为

https://deepinfra.com/dash/api_keys)。 - 创建新密钥: 点击“New API Key”按钮,为你的密钥起一个名字(例如 “MyTestApp”),然后点击生成。

- 保存密钥: 系统会生成一串以

di-开头的字符,这就是你的API密钥。请立即复制并妥善保管它,因为出于安全考虑,这个完整的密钥只会出现一次。

第二步:调用API

DeepInfra的API端点兼容OpenAI的格式,这使得迁移和使用变得非常方便。其核心的聊天API端点是:

https://api.deepinfra.com/v1/openai/chat/completions

你可以使用任何支持HTTP请求的工具或编程语言来调用它。

使用 curl 命令的简单示例:

打开你的终端,将下面命令中的 {YOUR_API_KEY} 替换为你刚刚生成的密钥,{MODEL_ID} 替换为你想调用的模型ID(例如 meta-llama/Meta-Llama-3-8B-Instruct)。

curl -X POST https://api.deepinfra.com/v1/openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer {YOUR_API_KEY}" \

-d '{

"model": "{MODEL_ID}",

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

]

}'

使用Python的示例:

你需要先安装 requests 库 ( pip install requests )。

import requests

import json

# 替换成你的API密钥

api_key = "{YOUR_API_KEY}"

# 替换成你想使用的模型ID

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

url = "https://api.deepinfra.com/v1/openai/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": model_id,

"messages": [

{"role": "user", "content": "你好,请用中文介绍一下你自己。"}

],

"stream": False # 如果需要流式输出,可以设置为True

}

response = requests.post(url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

result = response.json()

# 打印出模型返回的内容

print(result['choices'][0]['message']['content'])

else:

print(f"请求失败,状态码: {response.status_code}")

print(response.text)

你可以在DeepInfra的官方文档中找到所有支持的模型ID列表。

应用场景

- AI聊天机器人开发

为网站、App或企业内部系统构建客服机器人、智能助手或特定领域的问答机器人。开发者可以根据成本和性能需求,灵活选择不同的模型。 - 内容创作辅助

利用模型的文本生成能力,辅助撰写营销文案、博客文章、代码、邮件或进行文本润色。 - 教育与研究

研究人员和学生可以利用该平台方便地调用和测试各种前沿的开源AI模型,而无需承担高昂的硬件部署成本。 - 原型快速验证

产品经理和开发者可以在产品开发的早期阶段,利用DeepInfra快速搭建一个包含AI功能的原型,用于功能验证和效果展示。

QA

- DeepInfra Chat是免费的吗?

网页版的聊天体验是免费的,但有一定的使用限制,主要用于功能演示和模型评测。 如果通过API进行调用,则需要根据所选模型和请求的token数量付费,平台会提供一定额度的免费试用计算资源。 - 我可以使用哪些AI模型?

DeepInfra支持多种主流的开源大语言模型,包括但不限于Meta的Llama系列(如Llama 3)、Mistral AI的模型、Google的Gemma、以及CodeLlama等专注于代码生成的模型。 具体支持的模型列表可以在其官网查看。 - 这个平台主要面向哪些用户?

它主要面向AI应用开发者、技术研究人员以及希望将AI功能集成到现有业务中的企业。同时,其网页聊天功能也适合任何对AI技术感兴趣并希望体验不同模型能力的普通用户。 - 使用API需要自己配置服务器吗?

不需要。DeepInfra是一个“Serverless”平台,它负责所有模型的托管、运行和弹性伸缩。开发者只需要通过API密钥发起请求,无需关心底层的硬件和运维。