AI-model-comparison ist ein Webtool, das in einem Browser ausgeführt wird und Benutzern hilft, die Antworten von zwei verschiedenen großen Sprachmodellen der künstlichen Intelligenz (AI) Seite an Seite zu vergleichen. Nachdem der Nutzer eine Frage eingegeben hat, sendet das Tool gleichzeitig eine Anfrage an die beiden konfigurierten Modell-APIs und zeigt die zurückgegebenen Ergebnisse Seite an Seite an. Das Tool läuft vollständig im Front-End des Browsers des Nutzers, es sind keine Back-End-Server erforderlich, und sensible Informationen wie der API-Schlüssel des Nutzers werden nur lokal verwendet und nicht auf Server hochgeladen, was die Sicherheit gewährleistet. Es richtet sich in erster Linie an Entwickler, Forscher und KI-Enthusiasten, die das am besten geeignete KI-Modell für eine bestimmte Aufgabe bewerten und auswählen müssen. Die intuitive Benutzeroberfläche macht die Unterschiede zwischen den Modellen leicht erkennbar.

Funktionsliste

- ParallelvergleichDurch die gleichzeitige Eingabe von Fragen in eine Schnittstelle ruft das Tool zwei verschiedene KI-Modelle parallel auf und zeigt deren Antworten zum direkten Vergleich nebeneinander an.

- vielschichtiger DialogUnterstützung für kontinuierliche Folgefragen. Nachdem Sie die erste Antwort erhalten haben, können Sie weitere Fragen eingeben und das Tool wird das Modell erneut mit einer vollständigen kontextuellen Historie für einen detaillierteren Vergleich anfordern.

- Detaillierte IndikatoranzeigeWährend der Anzeige der Antworten werden Schlüsselinformationen wie Antwortzeit, Anzahl der verbrauchten Token usw. für jedes Modell angezeigt, um Daten für die Leistungsbewertung bereitzustellen.

- Geschichte des DialogsAlle Gespräche werden automatisch aufgezeichnet, und die Benutzer können jederzeit den vollständigen Kontext zur einfachen Überprüfung und Analyse einsehen.

- Automatische Speicherung der KonfigurationDie API-Konfigurationsdaten des Benutzers (mit Ausnahme des API-Schlüssels) werden automatisch lokal im Browser gespeichert und müssen bei der nächsten Verwendung nicht erneut eingegeben werden.

- VerbindungstestBietet eine Ein-Klick-Testfunktion, um schnell zu überprüfen, ob die API-Adresse und der Schlüssel erfolgreich verbunden werden können, was den Konfigurationsprozess vereinfacht.

- schnelle BedienungUnterstützung für die Verwendung von

Ctrl+EnterTastenkombinationen zum schnellen Auslösen von Vergleichen; Doppelklick auf die vom Modell gelieferte Antwort, um sie schnell in die Zwischenablage zu kopieren. - Reiner Front-End-BetriebDas gesamte Tool besteht nur aus HTML, CSS und JavaScript, und es müssen keine Backend-Dienste installiert werden, sondern Sie öffnen die Datei einfach in Ihrem Browser und verwenden sie.

Hilfe verwenden

AI-model-comparison ist eine reine Front-End-Implementierung eines Webtools, was bedeutet, dass es sehr einfach zu bedienen ist, keinen komplexen Installations- und Bereitstellungsprozess erfordert und nur einen modernen Browser zur Ausführung benötigt.

vorläufig

Bevor Sie es benutzen, müssen Sie die folgenden Informationen vorbereiten:

- API-Informationen für AI-ModelleSie benötigen mindestens eine (zum Vergleich zwei empfohlene) Sprachmodell-Schnittstelle, die mit dem OpenAI-API-Format kompatibel ist. Sie benötigen Zugang zu den folgenden drei Informationen:

API Endpoint(Adresse der API-Schnittstelle)Model Name(Name des Modells)API Key(API-Schlüssel)

Nachfolgend sind gängige Dienste und ihre Konfigurationsbeispiele aufgeführt:

- Offizielle OpenAI-API:

API接口:https://api.openai.com/v1/chat/completions模型名称:gpt-4o或gpt-3.5-turboAPI密钥: Ihr OpenAI-Kontoschlüssel

- OpenRouter (Plattform für die Zusammenführung mehrerer Modelldienste):

API接口:https://openrouter.ai/api/v1/chat/completions模型名称:openai/gpt-4o-mini(Modell)API密钥: Ihr OpenRouter-Kontoschlüssel.

- Lokal eingesetzte Modelle oder Proxy-Dienste von Drittanbietern:

- Wenn Sie das Modell lokal über Tools wie Ollama, vLLM usw. bereitgestellt haben und einen OpenAI-kompatiblen API-Server verwenden, können Sie die lokale Adresse eingeben, z. B.

http://localhost:8000/v1/chat/completions。

- Wenn Sie das Modell lokal über Tools wie Ollama, vLLM usw. bereitgestellt haben und einen OpenAI-kompatiblen API-Server verwenden, können Sie die lokale Adresse eingeben, z. B.

Arbeitsablauf

Schritt 1: Herunterladen und Öffnen des Tools

- Besuchen Sie die GitHub-Seite des Projekts:

https://github.com/hubhubgogo/AI-model-comparison - Klicken Sie auf das grüne

Codeund wählen Sie dann die SchaltflächeDownload ZIPLaden Sie die gesamte Projektdatei auf Ihren Computer herunter. - Entpacken Sie die heruntergeladene ZIP-Datei und Sie sehen die

index.html,style.css,script.jsusw. - Öffnen Sie die Seite direkt in Ihrem Browser (Chrome, Firefox, Safari oder Edge empfohlen).

index.htmlDatei, und die Werkzeugschnittstelle wird geladen.

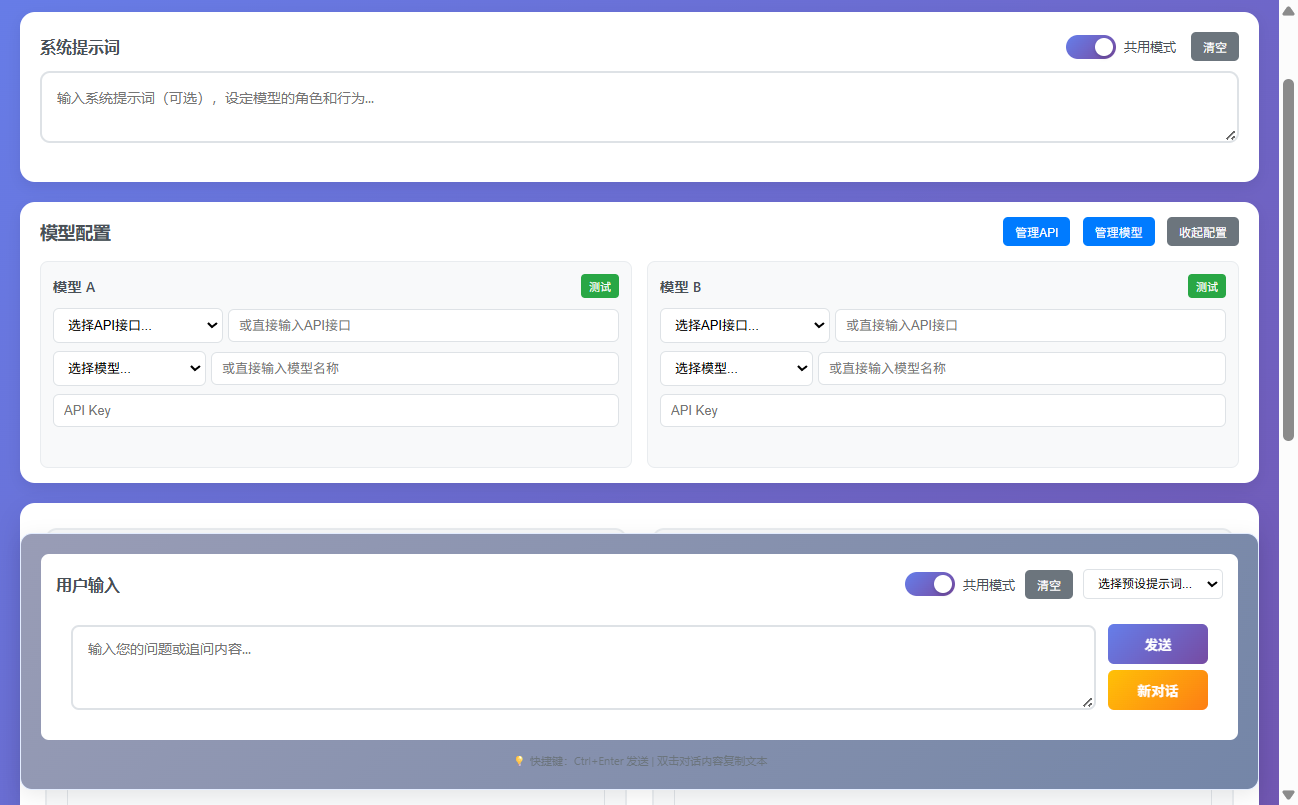

Schritt 2: Konfigurieren Sie die Modell-API

- Die Werkzeugoberfläche ist in eine linke und eine rechte Spalte unterteilt, die jeweils ein zu vergleichendes Modell darstellen.

- Geben Sie im Konfigurationsbereich "Modell A" auf der linken Seite die vorbereiteten

API接口、模型名称和API密钥。 - Geben Sie in ähnlicher Weise im Konfigurationsbereich "Modell B" auf der rechten Seite die API-Informationen für ein anderes Modell ein. Sie können auch dieselbe API verwenden, aber zum Vergleich einen anderen Modellnamen wählen (z. B. verwendet Modell A

gpt-4oModell B verwendetgpt-3.5-turbo)。 - Sobald Sie die Felder ausgefüllt haben, können Sie auf die Schaltfläche "Verbindung testen" unter jedem Konfigurationsbereich klicken. Das System sendet eine einfache Anfrage, um zu überprüfen, ob die API-Konfiguration korrekt ist. Wenn die Konfiguration korrekt ist, wird die Schaltfläche grün und zeigt "Verbindung erfolgreich" an; wenn sie fehlschlägt, wird eine Fehlermeldung angezeigt, damit Sie das Problem überprüfen können.

Schritt 3: Aufforderungswörter eingeben und Vergleich starten

- System-Eingabeaufforderung: Dies ist ein optionales Eingabefeld. Hier können Sie die Rolle des KI-Modells, Verhaltensrichtlinien oder den Antwortstil festlegen. Wenn Sie zum Beispiel "Sie sind ein leitender Software-Ingenieur" eingeben, antwortet das Modell aus einer eher technischen Perspektive. Diese Einstellung gilt für den gesamten Dialog.

- Benutzeraufforderung: Dies ist das erforderliche Kern-Eingabefeld. Geben Sie hier die Frage ein, die Sie stellen möchten, oder die Aufgabe, die das Modell erfüllen soll. Zum Beispiel: "Bitte schreiben Sie einen schnellen Sortieralgorithmus in Python".

- Wenn Sie mit der Eingabe fertig sind, klicken Sie auf die Schaltfläche "Vergleich starten" in der Mitte der Seite, oder verwenden Sie die Tastenkombinationen.

Ctrl+Enter。

Schritt 4: Anzeigen und Analysieren der Ergebnisse

- Nachdem Sie auf die Schaltfläche geklickt haben, sendet das Tool eine Anfrage an jede der beiden konfigurierten API-Adressen.

- Die Modelle liefern Ergebnisse, die nebeneinander in einem Dialogfeld auf der linken und rechten Seite angezeigt werden. Sie können visuell erkennen, welches Modell die genauere, detailliertere oder Ihren Anforderungen entsprechende Antwort liefert.

- Über jeder Antwort werden Metadaten wie die Antwortzeit des Modells und die Anzahl der verwendeten Token angezeigt, was Ihnen helfen kann, das Modell unter Leistungs- und Kostengesichtspunkten zu bewerten.

Schritt 5: Mehrere Runden mit Folgefragen

- Wenn die Ergebnisse des ersten Vergleichs vorliegen, erscheint ein neues Eingabefeld "Weiter" unterhalb des Eingabefeldes.

- Sie können hier Folgefragen eingeben, z. B. "Bitte fügen Sie dem Code, den Sie gerade geschrieben haben, ausführliche Kommentare hinzu".

- Klicken Sie auf "Weiter" oder verwenden Sie es erneut.

Ctrl+EnterDas Tool sendet den gesamten bisherigen Dialogverlauf (einschließlich der Worte der Systemaufforderung, Ihrer ersten Frage, der ersten Antwort des Modells und Ihrer Folgefrage) an beide Modelle zusammen. - Auf diese Weise können Sie mehrere Runden eines kontinuierlichen Dialogs durchführen, um die Leistung des Modells bei komplexen und kontinuierlichen Aufgaben eingehend zu testen.

Schritt 6: Steuerung des Dialogs

- Inhalt kopierenWenn Sie mit der Antwort eines Modells zufrieden sind, doppelklicken Sie einfach mit der Maus auf den Textbereich der Antwort und der Inhalt wird automatisch in die Zwischenablage kopiert.

- Eröffnung eines neuen DialogsWenn Sie eine völlig neue Konversation beginnen möchten, können Sie auf der Seite auf die Schaltfläche "Neue Konversation" klicken. Dadurch wird der aktuelle Dialogverlauf gelöscht und Sie können eine neue Runde von Vergleichstests von Grund auf beginnen.

Anwendungsszenario

- Auswahl des Modells

Vor der Entwicklung einer KI-Anwendung müssen die Entwickler ein Sprachmodell auswählen, das am besten zu ihrem Geschäftsszenario passt. Mit diesem Tool können verschiedene Modelle getestet werden (z. B. GPT-4o vs. Claude 3 Sonnet) bei der Bewältigung bestimmter Aufgaben (z. B. Codegenerierung, Inhaltserstellung, Fragen an den Kundendienst), um eine optimale Auswahl auf der Grundlage von realen Ergebnissen, Reaktionsfähigkeit und Kosten zu treffen. - Schnelles Engineering

Für Entwickler von KI-Anwendungen und Forscher wirkt sich die Qualität der Prompt-Wörter (Prompt) direkt auf die Ausgabe des Modells aus. Mit diesem Tool können sie ein Modell festlegen, aber verschiedene Versionen von System-Prompt-Wörtern oder Benutzer-Prompt-Wörtern für die linke und rechte Seite konfigurieren und schnell vergleichen und iterieren, um die Prompt-Schreibmethode mit den besten Ergebnissen zu finden. - Bewertung der Modellierungskapazität

Forscher oder KI-Enthusiasten, die neu veröffentlichte Modelle analysieren, können damit die Unterschiede zwischen neuen Modellen und bestehenden Mainstream-Modellen in Bezug auf logische Schlussfolgerungen, Wissensbasis, Sicherheitskonformität usw. visuell vergleichen und so Informationen aus erster Hand für Modellevaluierungsberichte erhalten. - Bildung & Präsentation

Bei der Vermittlung von KI-Technologien kann dieses Tool verwendet werden, um den Zuhörern den Unterschied zwischen verschiedenen KI-Modellen visuell zu verdeutlichen, z. B. durch den Vergleich des Wissensunterschieds zwischen einem Basismodell und einem fein abgestimmten Modell in einem bestimmten Bereich, wodurch die Konzepte konkret und leicht verständlich werden.

QA

- Ist dieses Tool sicher? Wird mein API-Schlüssel kompromittiert werden?

Dieses Tool ist sicher. Es handelt sich um eine reine Front-End-Anwendung, der gesamte Code wird in Ihrem Browser ausgeführt, und Ihr API-Schlüssel wird nur verwendet, um Anfragen direkt von Ihrem Browser an Ihren konfigurierten API-Dienstanbieter zu senden, er wird nicht gespeichert oder an einen Server eines Dritten übertragen. Um maximale Sicherheit zu gewährleisten, verwenden Sie es bitte nicht auf öffentlichen oder nicht vertrauenswürdigen Computern. - Warum gibt es keine Antwort oder einen Netzwerkfehler, wenn ich auf "Verbindung testen" oder "Vergleich starten" klicke?

Dafür gibt es in der Regel mehrere Gründe: Erstens sollten Sie IhreAPI接口Die Adresse ist korrekt ausgefüllt. Vergewissern Sie sich zweitens, dass Ihr Computer normal auf die API-Adresse zugreifen kann. Für einige APIs (wie die offizielle OpenAI-API) ist möglicherweise eine bestimmte Netzwerkumgebung erforderlich. Schließlich überprüfen Sie bitte IhreAPI密钥Ist sie korrekt und gültig. - Welche KI-Modelle unterstützt dieses Tool?

Es unterstützt jeden Modelldienst, der eine mit dem OpenAI-API-Format kompatible Schnittstelle bietet. Dazu gehören die offiziellen OpenAI-Modelle, der Microsoft Azure OpenAI-Service, zahlreiche Modelle auf der OpenRouter-Plattform und viele Open-Source-Modelle, die über lokale Server wie Ollama bereitgestellt werden können. - Ist es möglich, den Dialogverlauf zu exportieren?

In der aktuellen Version ist es nicht möglich, den gesamten Gesprächsverlauf mit einem Klick zu exportieren. Sie können jedoch die benötigten Informationen manuell speichern, indem Sie auf eine beliebige Antwort doppelklicken, um deren Inhalt schnell zu kopieren.