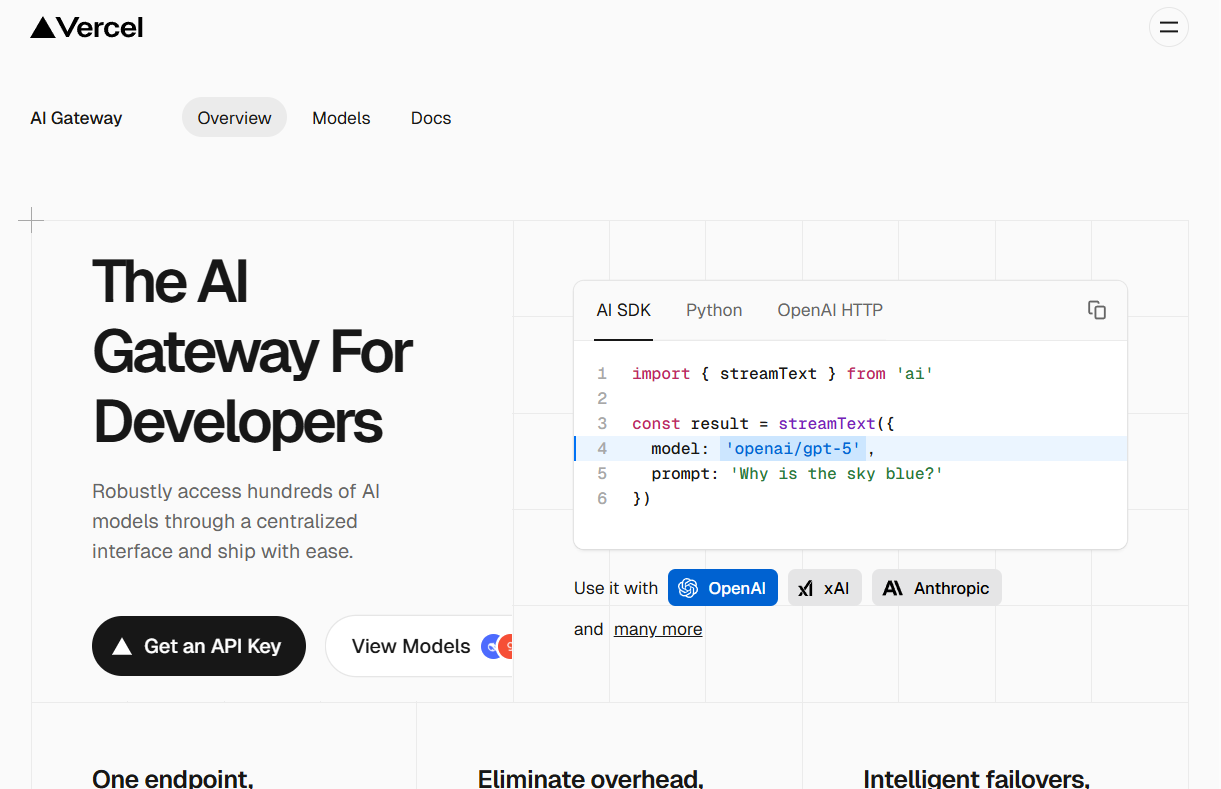

Vercel AI Gateway 是一个为开发者设计的中间层服务。 它通过提供一个统一的API接口,让开发者可以用一套代码访问来自不同供应商的多种AI模型。 这项服务的主要目的是简化AI应用的开发和管理流程。开发者不再需要为每个AI模型单独管理API密钥、处理复杂的计费和应对不同服务商的速率限制。 它还内置了智能故障备援功能,当某个AI模型服务出现故障时,系统能自动切换到备用模型,从而提高应用的稳定性和可靠性。 此外,AI Gateway也提供了日志记录和分析工具,帮助开发者监控应用的花费和性能,以便更好地控制成本和优化服务。

功能列表

- 统一API接口: 提供单一的API入口(endpoint),通过修改一行代码即可切换和使用来自OpenAI、Anthropic、xAI等不同供应商的上百种AI模型。

- 智能故障备援: 当某个AI模型供应商的服务中断时,网关可以自动将请求切换到备用的模型或供应商,保障应用服务的连续性。

- 性能监控与日志: 集中记录所有通过网关的AI请求日志,方便开发者追踪、分析和调试应用的性能问题。

- 成本控制与预算管理: 允许开发者设置预算,实时监控AI模型的调用成本,避免费用超支。

- 简化密钥管理: 开发者无需在自己的应用程序中管理多个供应商的API密钥,所有密钥都由Vercel的后台统一处理。

- 无缝集成: 可以和Vercel AI SDK、OpenAI SDK以及其他主流框架轻松集成,开发者可以使用自己熟悉的工具进行开发。

- 无速率限制: Vercel本身不对API请求设置速率限制,让开发者可以充分利用上游供应商提供的最大吞吐量。

使用帮助

Vercel AI Gateway旨在简化在应用中集成和管理大语言模型(LLM)的过程。它作为一个代理层,开发者只需与Vercel的统一接口交互,即可调用市面上多种主流AI模型。

第一步:获取API密钥

- 访问 Vercel AI Gateway 官方网站。

- 点击 “Sign Up” 注册一个Vercel账户。新用户每月可以获得5美元的免费额度来体验平台上的任何模型。

- 登录后,在AI Gateway的控制面板中,你可以创建新的项目并获取一个专属的API密钥。这个密钥将用于后续所有API请求的身份验证,请妥善保管。

第二步:配置开发环境

AI Gateway可以与多种编程语言和框架集成。以下以Python环境和OpenAI官方SDK为例,说明如何配置和使用。

首先,确保你的开发环境中已经安装了OpenAI的Python库。如果尚未安装,可以通过pip命令进行安装:

pip install openai

安装完成后,你需要将从Vercel获取的API密钥配置为环境变量。这样做比将密钥硬编码在代码中更安全。

在你的终端中设置环境变量:

export AI_GATEWAY_API_KEY='你的Vercel AI Gateway API密钥'

请将你的Vercel AI Gateway API密钥替换为你在第一步中获取的真实密钥。

第三步:发送API请求

配置完成后,你就可以通过编写代码来调用AI模型了。核心操作是,在初始化OpenAI客户端时,将base_url参数指定为Vercel AI Gateway的统一接口地址。

以下是一个完整的Python代码示例,展示了如何通过AI Gateway调用xAI的grok-4模型:

import os

from openai import OpenAI

# 初始化OpenAI客户端

# 客户端会自动读取名为'AI_GATEWAY_API_KEY'的环境变量作为api_key

# 同时,必须将base_url指向Vercel的网关地址

client = OpenAI(

api_key=os.getenv('AI_GATEWAY_API_KEY'),

base_url='https://ai-gateway.vercel.sh/v1'

)

# 发起聊天补全请求

try:

response = client.chat.completions.create(

# 'model'参数指定了你想要调用的模型

# 格式为 '供应商/模型名称'

model='xai/grok-4',

messages=[

{

'role': 'user',

'content': '天空为什么是蓝色的?'

}

]

)

# 打印模型返回的回答

print(response.choices[0].message.content)

except Exception as e:

print(f"请求发生错误: {e}")

在这段代码中,base_url='https://ai-gateway.vercel.sh/v1'是关键。 它将原本要发送给OpenAI的请求重定向到了Vercel AI Gateway。网关接收到请求后,会根据你指定的model='xai/grok-4',将请求转发给相应的AI供应商(这里是xAI),并将最终结果返回给你。

切换模型

AI Gateway最大的便利之一就是可以轻松切换模型。如果你想换用Anthropic的claude-sonnet-4模型,只需修改model参数即可,其他代码保持不变:

response = client.chat.completions.create(

model='anthropic/claude-sonnet-4',

messages=[

{

'role': 'user',

'content': '请给我写一个关于太空旅行的短故事。'

}

]

)

print(response.choices[0].message.content)

这种设计让开发者可以灵活地在不同模型之间进行测试和切换,而无需修改任何认证和网络请求相关的底层代码。

应用场景

- 快速原型开发

在开发AI应用的初期阶段,开发者需要尝试多种不同的模型以找到最适合应用场景的一个。使用AI Gateway,开发者可以通过简单修改模型标识符来快速测试和比较不同模型的性能和成本,而无需为每个模型都进行一次完整的集成开发。 - 提高应用可靠性

对于已经上线并面向用户的生产环境应用,服务的稳定性至关重要。AI模型供应商偶尔会出现服务中断。通过配置AI Gateway的故障备援功能,当主模型服务不可用时,系统可以自动切换到备用模型,保证应用的核心功能不受影响,从而提升用户体验。 - 初创公司成本控制

初创公司或小型开发团队的资源有限,必须严格控制运营成本。AI Gateway的监控和预算管理功能可以实时追踪Token消耗和费用,帮助团队了解成本构成。通过设置预算上限,可以有效防止因代码错误或流量激增导致的意外高额账单。 - 多模型应用的统一管理

一些复杂的AI应用可能需要在不同的任务中使用不同的模型,例如,使用一个模型进行文本生成,另一个模型进行内容审查。AI Gateway提供了一个统一的管理平台,开发者可以在同一个地方监控和管理所有模型的API调用、日志和费用,简化了运维的复杂度。

QA

- 使用Vercel AI Gateway需要付费吗?

Vercel为新注册用户提供每月5美元的免费额度,可以用来体验平台上的任何AI模型。当免费额度用完或者用户进行首次付款后,后续的使用将按量计费。Vercel本身不对Token价格进行加价,费用与直接使用上游供应商的价格保持一致。 - AI Gateway支持哪些AI模型?

AI Gateway支持来自OpenAI、Anthropic、Google、xAI、Groq等多个主流供应商的上百种模型。完整的支持列表可以在Vercel的官方文档或模型市场中查看。 - Vercel AI Gateway会限制API的请求速度吗?

Vercel本身不对通过网关的API请求设置速率限制。开发者能获得的请求速率和吞吐量主要取决于上游AI模型供应商自身的限制策略。 - 如果我已经在用OpenAI的SDK,迁移到AI Gateway会很复杂吗?

迁移过程非常简单。你只需要在初始化OpenAI客户端时,将base_url参数修改为Vercel提供的网关地址,并将api_key替换为从Vercel获取的密钥即可,核心的业务代码几乎无需改动。