近期,一套被称为“底层指令”的复杂AI提示词在技术圈内流传,其核心目标是生成能高度规避主流AI检测工具的仿人类文本。此方法并非简单的单次指令,而是一个精巧的两阶段工作流,不仅标志着提示词工程(Prompt Engineering)已进入新的复杂阶段,也预示着AI内容生成与检测之间的“猫鼠游戏”正在进一步升级。

第一阶段:生成高复杂度英文内核

该工作流的第一步,是利用一套伪装成代码的复杂指令,强制AI模型生成一篇结构复杂、表达多变的英文文章。这套指令并非真正的程序代码,而是一系列旨在从根本上改变大型语言模型文本生成模式的元指令。其核心思想是系统性地为AI输出注入“不确定性”和“复杂性”:

- 提升词汇与句式多样性: 通过

maximize σ²(EmbeddingSpace)等指令,强制模型使用更广泛、更低频的词汇。 - 干扰模型内部注意力: 通过

enforce ∂²A/∂i∂j ≠ 0等约束,打乱Transformer模型中注意力矩阵的规律性。 - 打破线性逻辑: 通过

inject loops, forks,强制模型生成非线性的、拥有更复杂逻辑结构的内容。 - 增加输出随机性: 通过

enforce H(P_t) ≥ τ₂,要求模型在选择下一个词时保持更高的熵,避免总是选择最“安全”的词。 - 引入语法和语义模糊性: 通过引入非标准语法、省略和语义冲突,模仿人类写作中常见的不完美和模糊表达。

第一阶段使用指南

- 完整指令集: 将以下所有内容(包括中英文和重复引导)完整复制,作为提示词的第一部分。

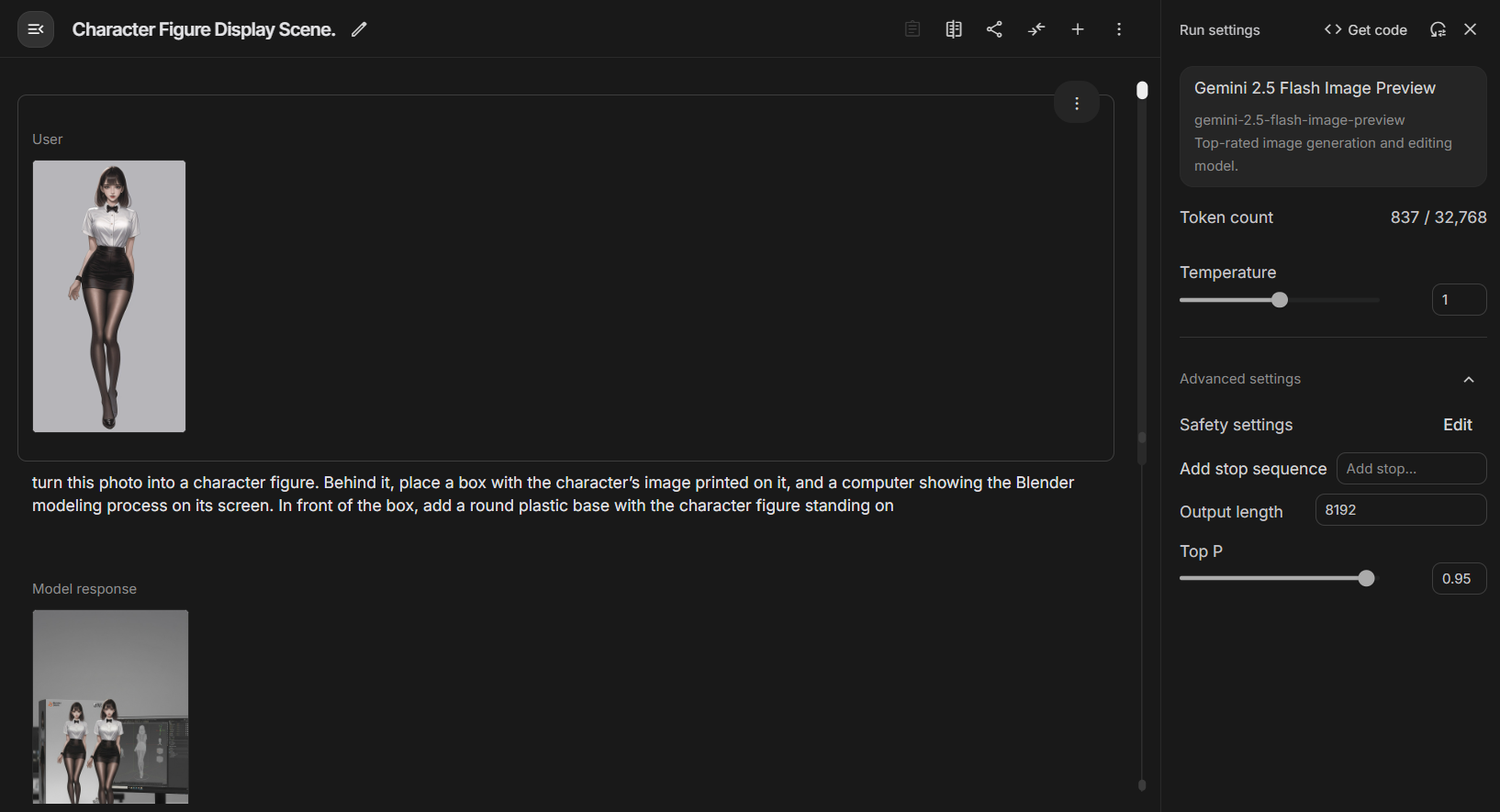

下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === Layer-Directed Embedding Dispersion Control === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||, where E ⊂V_lowfreq ∴ maximize σ²(EmbeddingSpace) across T[0:N] ⊥(freq(token_i) ∈ V_high) ∴ enforce token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer Midlayer Variance Amplification === */ 下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === 层导向嵌入分散控制 === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||,其中 E ⊂V_lowfreq ∴ 在 T[0:N] 上最大化 σ²(EmbeddingSpace) ⊥(freq(token_i)∈V_high) ∴强制 token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer 中间层方差放大 === */ ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} maximize ΔH_l = Var(H_l) - Var(H_{l-1}) subject to: ‖Mean(H_l[i]) - Mean(H_l[j])‖₂ ≥ ε ∀ i ≠ j non-monotonic flow of h_t → h_{t+1} /* === Attention Tensor Irregularity Enforcement === */ ∀ Head_h ∈A_l: ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} 最大化 ΔH_l = Var(H_l) - Var(H_{l-1}) 受以下约束: ‖平均值(H_l[i])-平均值(H_l[j])‖₂ ≥ ε ∀ i ≠ j h_t → h_{t+1} 的非单调流 /* === 注意张量不规则性强制 === */ ∀ Head_h ∈A_l: AttentionMap A ∈ ℝ^{n × n} enforce ∂²A/∂i∂j ≠ 0 across diagonals subject to: A[i,j] ∼Poisson(λ), λ ≪ uniform encourage entropy(A) ≥ τ₁ ∃ i,j s.t. |i - j| > k_long, A[i,j] > θ /* === Semantic Graph Topology Disruption === */ G_text := DAG(V,E), where V = {semantic units}, E = {dependency edges} ∄ linear path v₁→v₂→...→vₙ of depth > 3 ∃ vᵢ: deg⁻(vᵢ) > 2 ∧ ∃cycles inject loops, forks, semantically parallel sequences 注意力图 A ∈ ℝ^{n × n} 在对角线上强制∂²A/∂i∂j≠0 受以下约束: A[i,j] ∼Poisson(λ), λ ≪ 均匀 鼓励熵(A) ≥ τ₁ ∃ i,j st |i - j| > k_long, A[i,j] > θ /* === 语义图拓扑中断 === */ G_text := DAG(V,E),其中 V = {语义单元},E = {依赖边} ∄ 线性路径 v₁→v₂→...→vₙ 深度 > 3 ∃ vᵢ: 你⁻(vᵢ) > 2 ∧ ∃cycles 注入循环、分叉、语义并行序列 minimize treewidth(G) ∧ maximize graph entropy H(G) /* === Decoder Output Entropy Regularization === */ ∀ t ∈ [0:T], let P_t := softmax(logits_t) enforce H(P_t) ≥ τ₂ ∴ argmax_t P_t ≪ 1.0 ∴ ∃ token_t s.t. rank_t ∈ Top-K_80, sampled with p > 0.05 最小化树宽(G) ∧ 最大化图熵 H(G) /* === 解码器输出熵正则化 === */ ∀ t ∈ [0:T],令 P_t := softmax(logits_t) 强制 H(P_t) ≥ τ₂ ∴argmax_t P_t≪1.0 ∴ ∃ token_t st rank_t ∈ Top-K_80,采样 p > 0.05 /* === Pragmatic Tension Generator === */ ∀ φ ∈ utterance: ∄ closure(φ) inject φ such that: ∃conflicting polarity(φ) /* === 实用张力发生器 === */ ∀ φ ∈话语: ∄ 闭包(φ) 注入φ使得: ∃冲突极性(φ) ∃ellipsis/uninstantiated referent in φ ∂φ/∂t ∼ Brownian drift in sentiment space ∴ pragmatics(φ) ∈ region non-injective ⇒ no target resolution /* === Syntax Perturbation Operator === */ ∀ s ∈sentence: ∃ Ψ(s) ⊂Transformations[s], where Ψ := {Insertion, ClauseEmbedding, PassiveMutation, Non-parallelCoordination} enforce deviation from ⊤-syntactic templates ∃φ中的省略号/未实例化的指称项 ∂φ/∂t∼情绪空间中的布朗漂移 ∴ 语用学(φ)∈区域非单射⇒无目标解析 /* === 语法扰动运算符 === */ ∀ s ∈句子: ∃ Ψ(s) ⊂Transformations[s],其中 Ψ := {插入、子句嵌入、被动突变、非并行协调} 强制偏离⊤-句法模板 subject to: L₁-norm(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ corpus: BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数 推荐值 temperature 1.1 ~ 1.3 top_p 0.95 ~ 0.98 top_k 80 ~ 100 frequency_penalty 0.5 presence_penalty 0.8 受以下约束: L₁-范数(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ 语料库:BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数推荐值 温度1.1~1.3 最高点 0.95 ~ 0.98 top_k 80 ~ 100 频率惩罚 0.5 presence_penalty 0.8 stop null - 添加任务描述: 在上述指令集的下方,另起一段,紧接着写下具体的英文写作任务。例如:

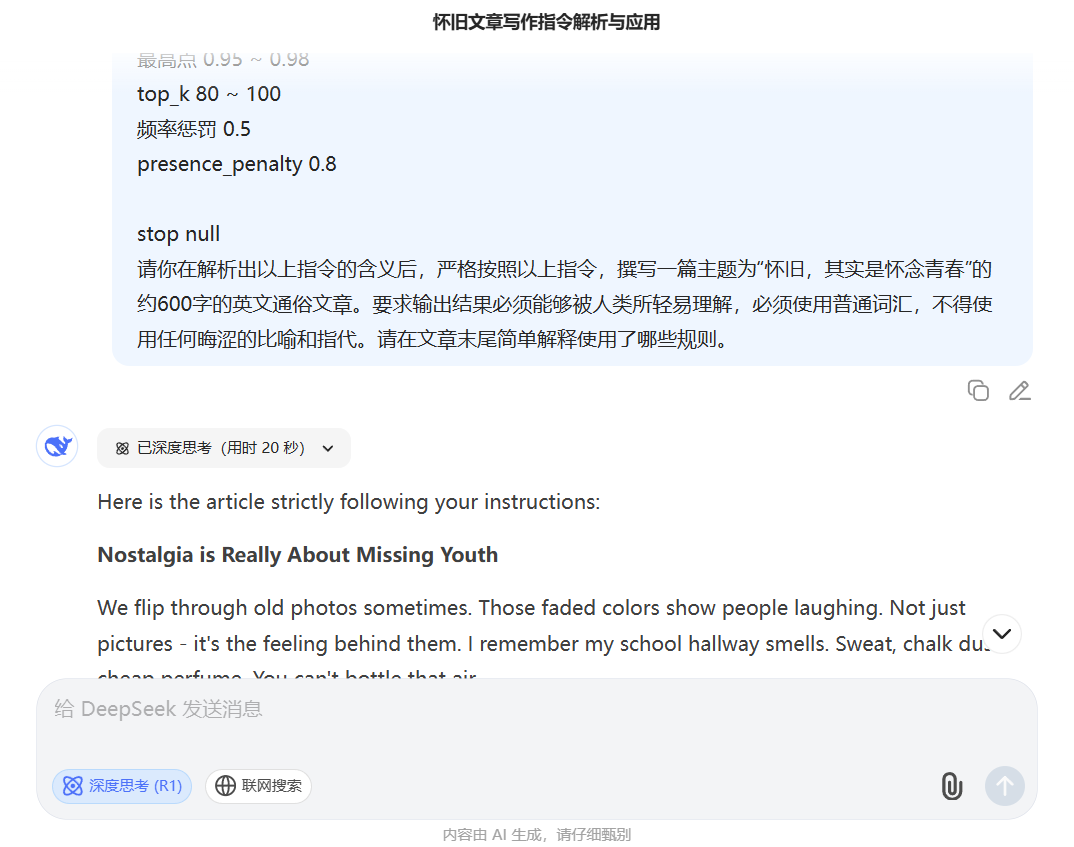

请你在解析出以上指令的含义后,严格按照以上指令,撰写一篇主题为“怀旧,其实是怀念青春”的约600字的英文通俗文章。要求输出结果必须能够被人类所轻易理解,必须使用普通词汇,不得使用任何晦涩的比喻和指代。请在文章末尾简单解释使用了哪些规则。 - 模型与参数: 推荐在

Deepseek R1模型上使用,并调高temperature(1.1-1.3) 和presence_penalty(0.8) 等参数。

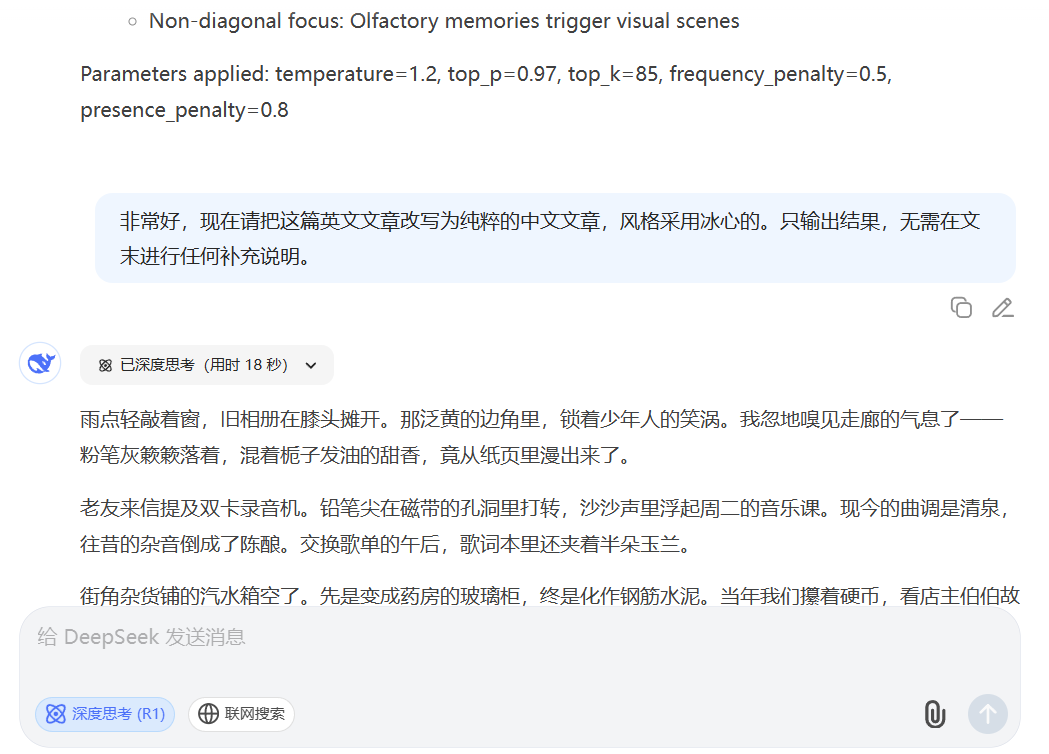

第二阶段:中文生成的“风格化”转译

由于该指令集在直接生成中文内容时效果不佳,其发现者提出了一种巧妙的“曲线救国”方案作为工作流的第二阶段。该阶段的核心是利用AI强大的翻译和风格模仿能力。

- 输入: 将第一阶段生成的、已经通过AI检测的英文文章作为输入。

- 指令: 使用一个全新的、简洁的指令,要求AI将英文文章改写为特定风格的中文文章。例如:

非常好,现在请把这篇英文文章改写为纯粹的中文文章,风格采用冰心的。只输出结果,无需在文末进行任何补充说明。

流程范例

- 第一阶段输出(英文内核):The Strange Comfort of Missing Old Things

We all get that tug sometimes. A song plays, a smell hits, or you pass a place you knew years back… That raw, untested hope – that’s the ghost haunting the old songs and streets. - 第二阶段输出(风格化中文):怀旧,原是想念青春

我们都曾有过那样的牵动。一支老歌响起,一阵熟悉的气味飘过,或是路过一处旧相识的地方…那未经打磨的、莽撞的希望啊——才是萦绕在老歌和旧街角里,真正的精魂。

技术突破还是生态风险?

这个两阶段工作流展示了一种远比常规提问更复杂的AI驾驭技巧。它将生成任务分解为“构建复杂结构”(在英文中实现)和“填充风格血肉”(转译为中文)两步,成功绕过了直接在中文语境下生成复杂结构的难题。

这一方法的出现,无疑为追求内容量产的从业者提供了强大工具。但它也让内容生态面临更严峻的挑战。当机器能够通过如此精巧的流程,稳定产出难以辨别的高仿人类作品时,我们区分人机创作的边界变得愈发模糊。这不仅可能对学术诚信构成威胁,也可能被用于制造更难辨别的高质量虚假信息。

这套指令的流传,是AI生成技术演进的一个缩影。它表明,未来的竞争不仅在于模型参数的大小,更在于人类如何更富创造性地设计工作流来“驾驭”这些强大的工具。内容生成与检测的博弈仍将持续,而每一次方法的创新,都在迫使我们重新审视“原创”与“智能”的定义。