当谷歌首席科学家 Jeff Dean 和 AI 基础设施副总裁 Amin Vahdat 联合署名发布一份技术报告时,整个行业都在倾听。报告的核心信息被包装成一个极具传播力的比喻:处理一次 Gemini 模型的文本指令,其消耗的能源比观看9秒电视还要少。

这个比喻生动且贴近生活,巧妙地将一次人工智能交互的成本描绘得微不足道。然而,这个由行业领袖亲自背书的微观视角,却掩盖了 AI 技术在全球尺度下惊人的能源需求。当微小的单次消耗乘以天文数字般的日查询量后,故事就完全不同了。

为何是 “中位数”?一个关于诚实与偏见的选择

在深入探讨之前,必须理解谷歌为何选择 “文本查询中位数” 作为其核心指标。每一次用户与 AI 的交互,从 “2+2等于几?” 这样的简单问题,到要求撰写数千字论文的复杂任务,能耗差异巨大。

如果使用平均数,少数极端复杂的查询会急剧拉高整体数值,从而扭曲普通用户日常使用的真实成本。相比之下,中位数剔除了两端的异常值,更能代表一次典型查询的能耗。报告估算,一次中位数的 Gemini 文本查询消耗 0.24 瓦时 (Wh) 的能量,排放 0.03 克二氧化碳,并使用 0.26 毫升的水。谷歌强调,这是业内首次有大型科技公司如此详尽地公布大语言模型的使用成本。

谷歌的 “全栈算法”:不只是计算原材料

报告的另一大亮点是其 “全栈式” 测量方法。谷歌声称,许多公开估算只计算 AI 加速器(如 TPU 或 GPU)在主动运算时的电力,这严重低估了真实成本。

打个比方,这种乐观算法好比计算一张披萨的成本时,只算了面粉和番茄的钱。

而谷歌的 “全栈算法” 则计入了所有成本:

- 完整的系统功耗:不仅包括 AI 芯片,还计入支持其运行的主机服务器、CPU 和内存。

- 待命的空闲系统:为应对流量洪峰而预留的、处于待机状态的服务器所消耗的能源。

- 数据中心间接开销:用以衡量能源效率的

PUE(电源使用效率) 指标,包括冷却系统、电力分配等所有额外消耗。谷歌宣称其数据中心机群的平均PUE为 1.09,处于行业领先水平。

按照这种更全面的算法,Gemini 的单次查询能耗为 0.24 瓦时。谷歌坦言,如果采用行业内某些只计算芯片功耗的狭隘方法,这个数字可以轻松降至 0.10 瓦时。[3] 此举无疑是在标榜自身数据的透明度和诚实性,同时也给竞争对手施加了压力。

效率飞跃的背后

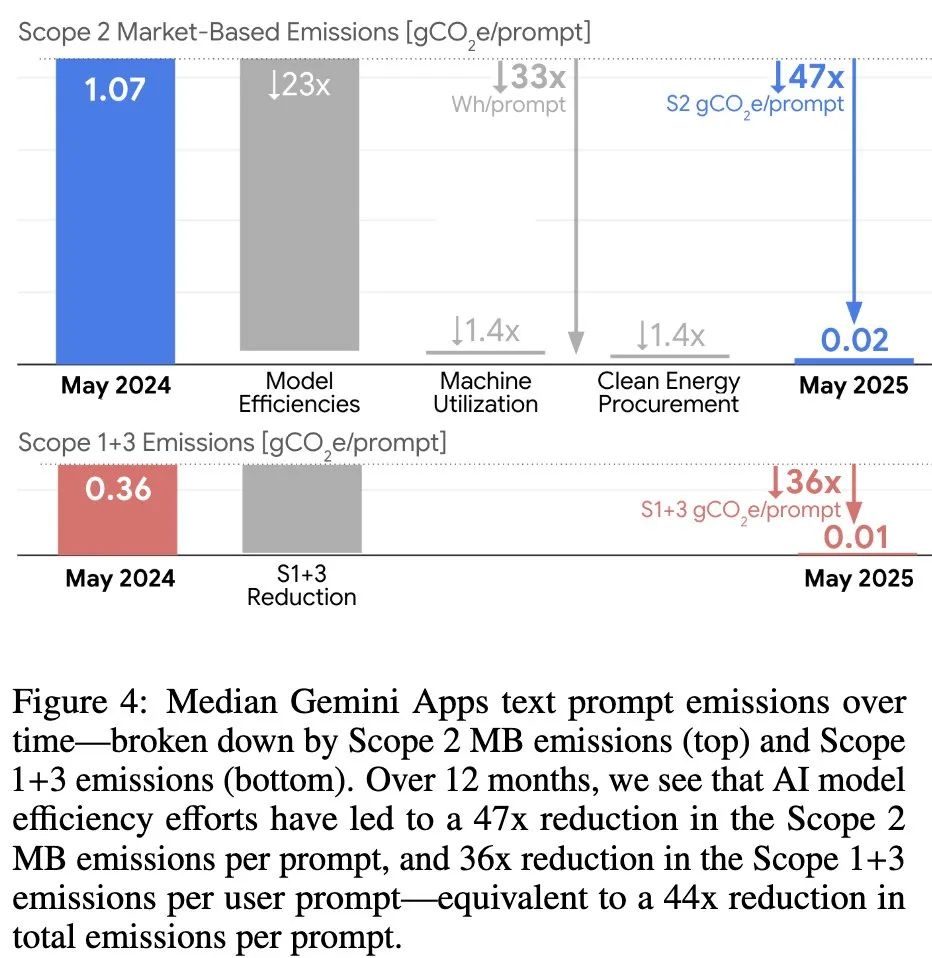

报告还强调了 Gemini 在过去一年中取得的惊人效率提升:在提供更高质量回复的同时,单次查询能耗降低了 33 倍,碳足迹减少了 44 倍。

这一飞跃并非单一技术的突破,而是其 “全栈优化” 策略的成果,涵盖了从模型架构到硬件的每一个环节:

- 高效模型架构:采用

Mixture-of-Experts (MoE)等架构,让模型在处理请求时只激活所需的部分“专家”网络,从而将计算量减少 10 到 100 倍。 - 优化的算法:通过量化 (

Quantization) 和蒸馏 (Distillation) 等技术,在不牺牲过多质量的前提下,创建更小、更快的模型版本。 - 智能推理系统:利用

speculative decoding(推测解码) 等技术,让小模型先进行预测,再由大模型快速验证,大幅提升响应效率。 - 定制硬件:谷歌自研的

TPU(张量处理单元) 从设计之初就为 AI 运算优化,实现了极高的能效比。

平心而论,谷歌在降低 AI 单次查询成本上取得的工程成就值得肯定。然而,将视角从单次查询的 “9秒” 拉远,一幅截然不同的图景浮现出来。

宏观视角:当 “9秒” 累积成 “285年”

“9秒电视” 的比喻之所以巧妙,因为它利用了人类对微小成本的钝感。但真正的考验在于规模化。

目前,关于 Gemini 的全球日查询量没有官方数据,但行业估算从保守的 2800 万次到乐观的 10 亿次不等。我们不妨用这两个数字分别计算。

场景一:10 亿次查询(乐观估算)

- 每日总能耗:10 亿次 × 0.24 瓦时/次 = 2.4 亿瓦时,即 24 万千瓦时 (kWh)。

- 意味着什么:一个普通印度家庭日均用电约 3 千瓦时。这意味着

Gemini一天的能耗,足以支撑 8万个 印度家庭的日常用电。 - 换个比喻:这相当于一个人不眠不休地连续观看 285年 电视。

场景二:2800 万次查询(保守估算)

- 每日总能耗:2800 万次 × 0.24 瓦时/次 = 672 万瓦时,即 6720 千瓦时 (kWh)。

- 意味着什么:即便如此,

Gemini一天的能耗也足够 2240个 印度家庭使用。 - 换个比喻:这相当于连续观看 8年 电视。

无论是哪个场景,计算结果都揭示了一个现实:那个让单次行为显得微不足道的比喻,一旦置于全球化的宏大尺度下,其真实影响便触目惊心。

真正的挑战:效率增长能否追上需求爆炸?

谷歌通过这份报告,意在证明自己已经解决了 “单次查询成本” 这个技术难题,并将皮球踢给了其他人。然而,这恰恰回避了整个行业面临的更深层困境。

真正的挑战,早已不是优化单次查询的微小成本。而是当 AI 服务全面融入搜索、邮件乃至操作系统,当查询量从数十亿次向数千亿次迈进时,如何用可持续的能源满足这种指数级的需求增长。

技术的进步带来了效率,但效率的提升又刺激了更广泛的应用,从而导致了总需求的爆炸。这是一个典型的 “杰文斯悖论”。谷歌声称正努力实现其数据中心 24/7 全天候无碳能源 的目标,并致力于补充 120% 的淡水消耗。但在全球范围内,尤其是在能源结构尚不完善的地区,新建的数据中心依然会给电网带来巨大压力。

当科技巨头们都在谈论 AI 将如何改变世界时,它们或许更应该坦诚地讨论,这个被重塑的世界将由什么来供电。

参考:https://arxiv.org/abs/2508.15734