Original: https://arxiv.org/pdf/2210.03629.pdf

Sie verstehen auch nach der Lektüre nicht, wie ReAct funktioniert und angewendet wird? Schauen Sie sich dieReAct-Implementierungslogik Hands-on" mit praktischen Beispielen.

Abstracts

Während groß angelegte Sprachmodelle (llm) beeindruckende Leistungen bei Aufgaben des Sprachverständnisses und der interaktiven Entscheidungsfindung gezeigt haben, wurden ihre Denkfähigkeiten (z. B. Hinweise auf Gedankenketten) und Handlungsfähigkeiten (z. B. die Erstellung von Handlungsplänen) weitgehend als separate Themen untersucht. In diesem Beitrag wird die Verwendung von LLL zur Generierung von Argumentationstrajektorien und aufgabenspezifischen Aktionen in einer verschachtelten Art und Weise untersucht, die eine größere Synergie zwischen den beiden ermöglicht: Argumentationstrajektorien helfen dem Modell, Aktionspläne zu verallgemeinern, zu verfolgen und zu aktualisieren sowie mit Ausnahmen umzugehen, während Aktionen es ihm ermöglichen, mit externen Quellen (z. B. Wissensdatenbanken oder Umgebungen) zu interagieren und zusätzliche Informationen zu sammeln. Die vorgeschlagene ReAct-Methode wird auf eine Reihe von Sprach- und Entscheidungsfindungsaufgaben angewandt, und ihre Effektivität wird im Vergleich zum Stand der Technik demonstriert, zusätzlich zur Verbesserung der menschlichen Interpretierbarkeit und Vertrauenswürdigkeit. Insbesondere bei der Beantwortung von Fragen (HotpotQA) und der Überprüfung von Fakten (Fever) überwindet ReAct die Probleme der Täuschung und der Fehlerfortpflanzung, die bei der Gedankenkette vorherrschen, indem es mit einer einfachen Wikipedia-API interagiert und menschenähnliche Lösungswege generiert, die leichter zu interpretieren sind als die Grundlinien ohne Entscheidungswege. Darüber hinaus übertrifft ReAct bei zwei interaktiven Entscheidungsfindungs-Benchmarks (ALFWorld und WebShop) Mimikry- und Reinforcement-Learning-Ansätze mit einer absoluten Erfolgsrate von 34% bzw. 10%, wobei nur ein oder zwei kontextbezogene Beispiele benötigt werden.

1 Einleitung

Ein einzigartiges Merkmal menschlicher Intelligenz ist die Fähigkeit, aufgabenorientierte Handlungen nahtlos mit verbalem Denken zu verbinden. Man geht davon aus, dass dies eine wichtige Rolle in der menschlichen Kognition spielt und zur Selbstregulierung oder Strategieformulierung sowie zur Aufrechterhaltung des Arbeitsgedächtnisses beiträgt. Nehmen wir das Beispiel des Kochens eines Gerichts in der Küche: Zwischen zwei spezifischen Handlungen können wir verbales Denken einsetzen, um den Fortschritt zu verfolgen ("Jetzt, wo alles gehackt ist, sollte ich den Topf mit Wasser erhitzen"), um mit Anomalien umzugehen oder den Plan der Situation anzupassen ("Ich habe kein Salz, dann nehme ich stattdessen Sojasauce und Pfeffer Ich habe kein Salz, dann nehme ich stattdessen Sojasauce und Pfeffer"), und zu erkennen, wann externe Informationen benötigt werden ("Wie bereite ich den Teig zu? Ich werde im Internet recherchieren"). Wir können auch aktiv werden (ein Rezeptbuch aufschlagen, um ein Rezept zu lesen, den Kühlschrank öffnen, die Zutaten überprüfen), um das Denken zu unterstützen und Fragen zu beantworten ("Was kann ich jetzt kochen?"). Diese Art des "Handelns" stellt für uns kein Problem dar. Diese enge Synergie zwischen "Handeln" und "Denken" ermöglicht es dem Menschen, neue Aufgaben schnell zu erlernen und in bisher unbekannten Umgebungen oder bei Informationsunsicherheiten robuste Entscheidungen zu treffen oder zu argumentieren.

Jüngste Ergebnisse deuten auf die Möglichkeit hin, verbales Denken mit interaktiver Entscheidungsfindung in autonomen Systemen zu kombinieren. Einerseits haben entsprechend geführte Large Language Models (LLMs) die Fähigkeit bewiesen, mehrere Schritte des logischen Denkens in arithmetischen, vernünftigen und symbolischen Aufgaben durchzuführen. Allerdings handelt es sich bei dieser "Denkkette" um eine statische Blackbox, bei der das Modell seine interne Repräsentation verwendet, um Gedanken zu generieren, und sich nicht auf die externe Welt stützt, was seine Fähigkeit einschränkt, reaktiv zu denken oder Wissen zu aktualisieren. Dies kann zu faktischen Illusionen und Fehlerfortpflanzung im Denkprozess führen (Abbildung 1(1b)). Andererseits haben neuere Arbeiten die Verwendung von vortrainierten Sprachmodellen für die Planung und Ausführung von Handlungen in interaktiven Umgebungen untersucht, wobei der Schwerpunkt auf der Vorhersage von Handlungen durch linguistische Prioritäten liegt. Diese Ansätze wandeln typischerweise multimodale Beobachtungen in Text um, verwenden Sprachmodelle, um domänenspezifische Aktionen oder Pläne zu generieren, und verwenden dann Controller, um diese auszuwählen oder auszuführen. Sie verwenden jedoch keine linguistischen Modelle, um abstrakt über übergeordnete Ziele nachzudenken oder das Arbeitsgedächtnis zur Unterstützung von Handlungen aufrechtzuerhalten, mit Ausnahme von Huang et al. (2022b), die eine begrenzte Form des verbalen Denkens einsetzten, um räumliche Fakten über den aktuellen Zustand zu wiederholen. Abgesehen von dieser einfachen verkörperten Aufgabe, die mit mehreren Bausteinen interagiert, wurde bisher nicht erforscht, wie logisches Denken und Handeln auf synergetische Weise kombiniert werden können, um allgemeine Aufgaben zu lösen, und ob eine solche Kombination systematische Vorteile gegenüber dem logischen Denken oder dem Handeln allein bieten kann.

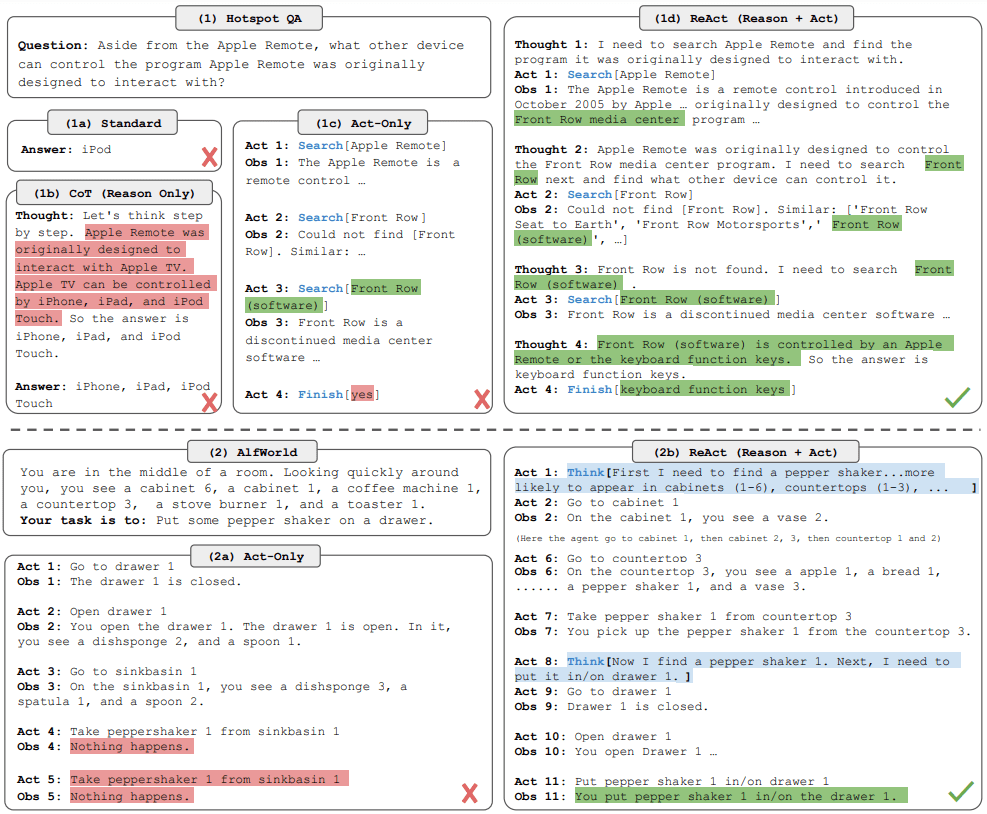

Abbildung 1: (1) Vergleich von vier Prompting-Methoden, (a) Standard Prompting, (b) Chain of Thought (CoT, nur Reasoning), (c) nur Action und (d) ReAct (Reasoning + Action), um ein HotpotQA (Yang et al., 2018) Problem zu lösen. (2) Ein Vergleich von (a) Nur-Action- und (b) ReAct-Hinting-Ansätzen zur Lösung eines AlfWorld (Shridhar et al., 2020b) Spiels. In beiden Bereichen lassen wir kontextuelle Beispiele aus den Aufforderungen weg und zeigen nur die vom Modell (Handlung, Denken) und der Umgebung (Beobachtung) generierten Problemlösungswege.

dieses Papier präsentiertReActReAct fordert llm auf, aufgabenrelevante verbale Argumentationsspuren und Aktionen in einer übergreifenden Art und Weise zu generieren, die es dem Modell ermöglicht, dynamische Argumentation durchzuführen, um Handlungspläne auf hoher Ebene zu erstellen, aufrechtzuerhalten und anzupassen (schlussfolgerndes Handeln), während es gleichzeitig mit externen Umgebungen (z. B. Wikipedia) interagiert, um zusätzliche Informationen in die Argumentation einzubeziehen (schlussfolgerndes Handeln). zusätzliche Informationen in die Schlussfolgerungen einfließen zu lassen (Schlussfolgerung durch Handlung).

In dieser Arbeit werden ReAct und die modernsten Basismodelle in vier verschiedenen Benchmarks empirisch evaluiert: Quiz, Faktenüberprüfung, Textspiele und Webnavigation. Bei HotPotQA und Fever übertrifft ReAct gängige Modelle zur Handlungsgenerierung und konkurriert mit Chain of Thought Reasoning (CoT), indem es auf die Wikipedia-API zugreift, mit der Modelle interagieren können. Insgesamt ist der beste Ansatz eine Kombination aus ReAct und CoT, die es ermöglicht, sowohl internes Wissen als auch extern gewonnene Informationen in den Schlussfolgerungsprozess einzubeziehen. Bei ALFWorld und WebShop können zwei oder sogar ein ReAct-Prompt die Verwendung von 103 ∼ 105Methoden des Imitations- oder Verstärkungslernens, die auf Aufgabeninstanzen trainiert wurden, führten zu absoluten Steigerungen der Erfolgsquoten von 34 % bzw. 10 %. Die Bedeutung des spärlichen, verallgemeinerten Denkens bei der Entscheidungsfindung wird durch einen konsistenten Vorteil gegenüber einer kontrollierten Grundlinie, bei der nur gehandelt wird, demonstriert. Neben der allgemeinen Anwendbarkeit und den Leistungssteigerungen trägt die Kombination von Schlussfolgerungen und Handlungen zur Interpretierbarkeit, Vertrauenswürdigkeit und Diagnostizierbarkeit des Modells in allen Bereichen bei, da der Mensch leicht zwischen Informationen aus dem internen Wissen des Modells und der externen Umgebung unterscheiden und die Inferenzverläufe untersuchen kann, um die Entscheidungsgrundlagen der Handlungen des Modells zu verstehen.

Zusammenfassend lassen sich unsere wichtigsten Beiträge wie folgt zusammenfassen.

(1) Vorschlag von ReAct, einem neuen, auf Stichworten basierenden Paradigma für kollaboratives Denken und Handeln bei der Sprachmodellierung zur Lösung allgemeiner Aufgaben.

(2) Es wurden umfangreiche Experimente mit verschiedenen Benchmarks durchgeführt, um die Vorteile von ReAct gegenüber bisherigen Ansätzen zur Inferenz oder zur alleinigen Handlungsgenerierung in einer stichprobenlosen Lernumgebung zu demonstrieren.

(3) systematische Abtragungen und Analysen vorschlagen, um die Bedeutung von Handlungen in Denkaufgaben und von Denkaufgaben in Interaktionsaufgaben zu verstehen.

(4) Die Grenzen von ReAct im cued Setting (d.h. begrenzte Unterstützung für Inferenz und Verhalten) werden analysiert und erste Experimente zur Feinabstimmung durchgeführt, die das Potenzial für eine Verbesserung von ReAct mit zusätzlichen Trainingsdaten zeigen. Die Erweiterung von ReAct, um zusätzliche Aufgaben zu trainieren und zu bearbeiten, und die Kombination mit ergänzenden Paradigmen wie dem Verstärkungslernen könnten das Potenzial großer Sprachmodelle weiter erschließen.

2 REACT: Kollaboratives Denken und Handeln

Betrachten wir den allgemeinen Aufbau eines intelligenten Körpers, der mit seiner Umgebung interagiert, um eine Aufgabe zu lösen. In dem ZeitschritttEin, der Agent erhält eine Beobachtung aus der Umgebungot ∈ O, und nach einer bestimmten Strategieπ(at|ct) Nehmen Sie eine Operationat ∈ A, wobeict = (o1,a1,··· ,ot−1,at−1,ot) ist der Kontext des Agenten. Wenn die Abbildungct →7 atDas Erlernen von Strategien kann eine Herausforderung darstellen, wenn sie in hohem Maße implizit sind und eine große Menge an Berechnungen erfordern. Der in Abb. 1 (1c) gezeigte Agent ist zum Beispiel nicht in der Lage, die korrekte letzte Aktion (Akt 4) zu generieren, um die QA-Aufgabe abzuschließen, da sie komplexe Schlussfolgerungen über den Kontext der Flugbahn (Frage, Akt 1-3, Beobachtung 1-3) erfordert. In ähnlicher Weise ist der in Abb. 1 (2a) gezeigte Agent nicht in der Lage, aus dem Kontext zu verstehen, dass Spüle 1 keinen Pfefferstreuer 1 enthält, und produziert daher weiterhin halluzinatorische Verhaltensweisen.

Die Idee von ReAct ist einfach: Wir erweitern den Aktionsraum eines intelligenten Körpers zu Aˆ = A ∪ L, wobei L der Sprachraum ist. Eine Aktion im Sprachraumaˆt ∈ L, das wir als Gedanken- oder Argumentationsspur bezeichnen, wirkt sich nicht auf die äußere Umgebung aus und führt daher nicht zu einem Beobachtungsfeedback. Im Gegensatz dazu, ein GedankeaˆtZiel ist es, nützliche Informationen zusammenzustellen, indem man über den aktuellen Kontext nachdenktctund aktualisieren den Kontextct+1 = (ct,aˆt), um zukünftige Überlegungen oder Handlungen zu unterstützen. Wie in Abbildung 1 dargestellt, kann es verschiedene Arten von nützlichen Ideen geben, wie z. B.: Aufschlüsselung der Aufgabenziele und Erstellung eines Aktionsplans (2b, Handlung 1; 1d, Gedanke 1), Einbringen von für die Aufgabenlösung relevantem Alltagswissen (2b, Gedanke 1), Extrahieren wichtiger Teile aus Beobachtungen (1d, Gedanke 2,4), Verfolgen des Fortschritts und Transportieren des Aktionsplans (2b, Gedanke 8), Umgang mit Ausnahmen und Anpassen des Aktionsplans ( 1d, Gedanke 3), und so weiter.

Da der Sprachraum L jedoch unendlich ist, ist das Lernen in diesem erweiterten Aktionsraum schwierig und erfordert einen starken linguistischen Prior. In dieser Arbeit konzentrieren wir uns auf ein eingefrorenes großes Sprachmodell PaLM-540B (Chowdhery et al., 2022) in dieser Umgebung[1]Kontextuelle Beispiele mit weniger Stichproben wurden herangezogen, um domänenspezifische Handlungen und freie sprachliche Gedanken zur Aufgabenlösung zu generieren (Abb. 1 (1d), (2b)). Die Beispiele in jedem Kontext sind Trajektorien menschlicher Handlungen, Gedanken und Umweltbeobachtungen, die zur Lösung von Aufgabeninstanzen verwendet werden (siehe Anhang C). Bei Aufgaben, bei denen das Denken im Vordergrund steht (Abb. 1(1)), erzeugen wir Gedanken und Handlungen abwechselnd, so dass die Trajektorie der Aufgabenlösung aus mehreren Gedanken-Handlungs-Beobachtungs-Schritten besteht. Im Gegensatz dazu müssen bei Entscheidungsaufgaben, die eine große Anzahl von Handlungen beinhalten können (Abb. 1(2)), Gedanken nur spärlich an den relevantesten Stellen der Trajektorie erscheinen, so dass wir das Sprachmodell selbst über das asynchrone Auftreten von Gedanken und Handlungen entscheiden lassen.

Durch die Integration von Entscheidungs- und Schlussfolgerungsfähigkeiten in ein großes Sprachmodell verfügt ReAct über mehrere einzigartige Eigenschaften.

A) Intuitiv und einfach zu gestalten:Die Gestaltung von ReAct-Prompts ist einfach, weil menschliche Kommentatoren ihre Gedanken einfach in Worten zusätzlich zu ihren Handlungen ausdrücken. In diesem Papier werden keine spezifischen Formatwahlen, Think-Aloud-Designs oder Beispielwahlen verwendet. Wir beschreiben das Prompt-Design für jede Aufgabe im Detail in den Abschnitten 3 und 4.

B) Universell und flexibel:Aufgrund des flexiblen Denkraums und des Think-Act-Generate-Formats eignet sich ReAct für verschiedene Aufgaben mit unterschiedlichen Handlungsräumen und Argumentationsanforderungen, einschließlich, aber nicht beschränkt auf QA, Faktenüberprüfung, Textspiele und Webnavigation.

C) Leistungsstarke und robuste Leistung:ReAct zeigt eine starke Generalisierung, wenn es von nur einem bis sechs kontextuellen Beispielen lernt, und geht dabei konsequent über die Basislinie von nur Denken oder Handeln in allen Domänen hinaus. In Abschnitt 3 zeigen wir zusätzliche Vorteile bei der Feinabstimmung und in Abschnitt 4 die Robustheit der ReAct-Leistung bei der Auswahl von Stichwörtern.

D) Auf den Menschen ausgerichtet und kontrollierbar:ReAct verspricht einen interpretierbaren, sequentiellen Entscheidungs- und Argumentationsprozess, bei dem der Mensch die Argumentation und die sachliche Korrektheit leicht überprüfen kann. Darüber hinaus kann der Mensch, wie in Abbildung 5 in Abschnitt 4 gezeigt, das Verhalten des intelligenten Körpers auch durch Nachdenken über die Bearbeitung steuern oder korrigieren.

3 Wissensintensive Argumentationsaufgaben

Angefangen bei wissensintensiven Argumentationsaufgaben wie Multi-Hop-Quiz und Fact-Checking. Wie in Abbildung 1 (1d) zu sehen ist, kann ReAct durch Interaktion mit der Wikipedia-API Informationen abrufen, um die Argumentation zu unterstützen, und auch die Argumentation nutzen, um zu bestimmen, was als Nächstes abgerufen werden soll, was die Synergie von Argumentation und Aktion demonstriert.

3.1 Einstellungen

Domains Wir betrachten zwei Datensätze, die eine Herausforderung für die Wissenssuche und Inferenz darstellen: (1) HotPotQA , ein Multi-Hop-Frage-Antwort-Benchmark, der Inferenz über zwei oder mehr Wikipedia-Artikel erfordert, und (2) FEVER , ein Faktencheck-Benchmark, bei dem jede Aussage mit SUPPORTS, REFUTES oder NOT ENOUGH INFO gekennzeichnet ist, je nachdem, ob ein Wikipedia-Artikel zur Bestätigung der Aussage existiert. In dieser Arbeit verwenden wir bei beiden Aufgaben eine reine Problemstellung, bei der das Modell nur das Problem/die Aussage als Eingabe erhält und keinen Zugang zu den unterstützenden Passagen hat und sich auf sein internes Wissen verlassen oder Wissen durch Interaktion mit der externen Umgebung abrufen muss, um die Argumentation zu unterstützen.

Aktionsraum Wir haben eine einfache Wikipedia-Web-API entwickelt, die drei Arten von Operationen enthält, um die interaktive Suche nach Informationen zu unterstützen:

(1) nach etw. Ausschau halten [Entität], die die ersten 5 Sätze der entsprechenden Wiki-Seite der Entität zurückgibt, wenn sie existiert, andernfalls werden die ersten 5 ähnlichen Entitäten aus der Wikipedia-Suchmaschine vorgeschlagen.

(2) ausfindig machen. [string], was den nächsten Satz in der Seite, die die Zeichenkette enthält, zurückgibt und die Funktion Strg+F eines Browsers simuliert.

(3) erfüllen. [Antwort], schließt die aktuelle Aufgabe mit der Antwort ab. Der Aktionsraum kann meist nur einen kleinen Teil eines Absatzes auf der Grundlage des genauen Absatznamens abrufen und ist damit viel schwächer als moderne lexikalische oder neuronale Retriever. Das Ziel ist es, zu simulieren, wie Menschen mit Wikipedia interagieren, und das Modell zu zwingen, durch explizite Schlussfolgerungen in der Sprache zu recherchieren.

3.2 Methodik

ReAct Prompting Bei HotpotQA und Fever wurden 6 bzw. 3 Fälle zufällig aus der Trainingsmenge ausgewählt und manuell Trajektorien im ReAct-Format geschrieben, die als unterdurchschnittliche Stichproben in den Prompts verwendet wurden. Ähnlich wie in Abb. 1 (d) besteht jede Trajektorie aus mehreren Gedanken-Handlungs-Beobachtungs-Schritten (d. h. dichtes Denken), in denen frei geformte Gedanken für verschiedene Zwecke verwendet werden. Insbesondere verwenden wir eine Kombination von Gedanken, um das Problem zu zerlegen ("Ich muss nach x suchen, y finden und dann z finden"), Informationen aus Wikipedia-Beobachtungen zu extrahieren ("x begann im Jahr 1844", "der Text sagt nicht x"), gesunder Menschenverstand ("x ist nicht y, also muss z ...... sein") oder arithmetische Überlegungen ("1844 < 1989"), die Rekonstruktion der geführten Suche ("Vielleicht kann ich x suchen/finden") und Synthese der endgültigen Antwort (""......, also ist die Antwort x "). Siehe Anhang C für weitere Einzelheiten.

Baselines Wir entfernten systematisch ReAct-Trajektorien, um mehrere Grundlinien zu konstruieren (im Format von Abb. 1 (1a-1c)).

(a)Standard-Prompting/Standard-Prompting(Standard), wobei alle Gedanken, Handlungen und Beobachtungen aus dem ReAct-Verlauf entfernt werden.

(b)Gedankenketten-Prompting / Gedankenketten-Prompting(CoT), bei der Handlungen und Beobachtungen entfernt werden und die nur als Grundlinie für die Schlussfolgerungen dient. Eine selbstkonsistente Basislinie (CoT-SC) wurde erstellt, indem während der Inferenz Trajektorien mit einer CoT-Dekodierungstemperatur von 0,7 abgetastet und ein Großteil der Antworten verwendet wurde. Es wurde festgestellt, dass sich die Leistung gegenüber der CoT durchgängig verbessert.

(c)Reine Handlungsaufforderung(Act), das Ideen aus dem ReAct-Verlauf entfernt, entspricht in etwa der Art und Weise, wie WebGPT mit dem Internet interagiert, um Fragen zu beantworten, obwohl es auf einem anderen Aufgaben- und Handlungsraum arbeitet und eher Imitations- und Verstärkungslernen als Aufforderungen verwendet.

Kombination von internem und externem Wissen / Combining Internal and External Knowledge Wie wir in Abschnitt 3.3 näher ausführen werden, stellen wir fest, dassReAct zeigte einen sachlicheren und fundierteren Problemlösungsprozess, während CoT eine genauere Argumentationsstruktur formulierte, aber zu Halluzinationen neigte.Daher schlagen wir vor, ReAct und CoT-SC zu verschmelzen und das Modell anhand der folgenden Heuristik entscheiden zu lassen, wann es auf die andere Methode umschaltet.

a) ReAct→CoT-SCWir haben 7 bzw. 5 Schritte für HotpotQA und FEVER festgelegt, weil wir festgestellt haben, dass mehr Schritte die Leistung von ReAct nicht verbessern.

b) CoT-SC→ReAct:: WennnDie meisten Antworten in der CoT-SC-Stichprobe erscheinen weniger alsn/In 2 Fällen (d.h. wenn das interne Wissen nicht ausreicht, um die Aufgabe sicher zu unterstützen), kehren Sie zu ReAct zurück.

Feinabstimmung/Finetuning Aufgrund der Herausforderungen bei der manuellen Kennzeichnung von Inferenz-Trajektorien und Aktionen in großem Umfang wird in diesem Papier ein Selbsthilfeansatz ähnlich dem von Zelikman et al. (2022) betrachtet, der 3000 von ReAct generierte Trajektorien mit korrekten Antworten (die auch in anderen Baselines verwendet werden) zur Feinabstimmung eines kleineren Sprachmodells (PaLM-8/62B) verwendet, um Trajektorien zu dekodieren, die durch Eingabefragen/-aussagen bedingt sind (alle Gedanken, Handlungen, Beobachtungen). Siehe Anhang B.1 für weitere Einzelheiten.

3.3 Ergebnisse und Beobachtungen

ReAct schneidet insgesamt besser ab als Act/ReAct schneidet durchweg besser ab als Act Tabelle 1 zeigt die Ergebnisse von HotpotQA und Fever unter Verwendung von PaLM-540B als Basismodell und unter Verwendung verschiedener Cueing-Methoden. Wir stellen fest, dass ReAct bei beiden Aufgaben besser abschneidet als Act, was den Wert von Schlussfolgerungen zur Steuerung von Handlungen zeigt, insbesondere bei der Synthese der endgültigen Antworten, wie in Abbildung 1 (1c-d) gezeigt. Das Ergebnis der Feinabstimmung (3) bestätigt ebenfalls die Vorteile von Inferenzspuren für fundierteres Handeln.

Tabelle 1: PaLM-540B Cueing-Ergebnisse bei HotpotQA und Fever.

ReAct vs. CoT Andererseits übertrifft ReAct das CoT bei Fieber (60,9 vs. 56,3) und liegt bei HotpotQA leicht hinter dem CoT (27,4 vs. 29,4). Möglicherweise gibt es nur geringfügige Unterschiede bei den Befürwortern und Gegnern von Eiferer-Aussagen (siehe Anhang D.1), so dass es von entscheidender Bedeutung ist, Maßnahmen zu ergreifen, um genaue und aktuelle Erkenntnisse zu gewinnen. Um die Verhaltensunterschiede zwischen ReAct und CoT bei HotpotQA besser zu verstehen, haben wir nach dem Zufallsprinzip jeweils 50 Trajektorien mit richtigen und falschen Antworten (EM-Urteile) aus ReAct und CoT (insgesamt 200 Beispiele) ausgewählt und deren Erfolgs- und Misserfolgsmuster in Tabelle 2 manuell gekennzeichnet. Im Folgenden sind einige wichtige Beobachtungen aufgeführt.

Tabelle 2: Arten von Erfolgs- und Misserfolgsmodi für ReAct und CoT auf HotpotQA und ihre prozentualen Anteile in zufällig ausgewählten Beispielen aus Humanstudien.

A) Halluzinationen sind ein ernstes Problem für CoTsführt im Erfolgsmodus zu einer viel höheren Fehlalarmrate als ReAct (14% vs. 6%) und ist der Hauptausfallmodus (56%). Im Gegensatz dazu ist der Problemlösungsverlauf von ReAct relevanter, faktenorientierter und glaubwürdiger, da es auf eine externe Wissensbasis zugreifen kann.

B) Während die Verschachtelung von Argumentations-, Handlungs- und Beobachtungsschritten die Praktikabilität und Glaubwürdigkeit von ReAct erhöht, reduziert diese strukturelle Einschränkung auch die Flexibilität bei der Formulierung von ArgumentationsschrittenWir stellen fest, dass ReAct ein bestimmtes häufiges Fehlermuster aufweist, bei dem das Modell frühere Gedanken und Handlungen neu generiert, was wir als Teil des "Argumentationsfehlers" einstufen, da das Modell nicht angemessen über die nächste Handlung nachdenken kann und aus der Schleife herausspringt.

C) Für ReAct ist der erfolgreiche Abruf von Informationswissen durch Suche entscheidend.Nicht-informative Suchen machten 23% der Fehlerfälle aus, was die Modellüberlegungen entgleisen ließ und es schwierig machte, Ideen wiederzufinden und neu zu formulieren. Dies könnte ein erwarteter Kompromiss zwischen Faktizität und Flexibilität sein, der uns dazu inspiriert hat, eine Strategie vorzuschlagen, die beide Ansätze kombiniert.

Beispiele für jeden Erfolgs- und Misserfolgsmodus finden Sie in Anhang E.1. Wir haben auch festgestellt, dass einige HotpotQA-Fragen möglicherweise veraltete Antwortbezeichnungen enthalten, siehe Abbildung 4 für ein Beispiel.

ReAct + CoT-SC schnitt bei der Aufforderung zu LLM am besten ab.Wie in Tabelle 1 gezeigt, waren die besten Cueing-Methoden bei HotpotQA und Fever ReAct → CoT-SC bzw. CoT-SC → ReAct. Abbildung 2 zeigt außerdem die Leistung der verschiedenen Methoden bei Verwendung einer unterschiedlichen Anzahl von CoT-SC-Proben. Während die beiden ReAct + CoT-SC-Methoden bei ihren jeweiligen Aufgaben Vorteile haben, übertreffen sie beide CoT-SC signifikant und konsistent, wenn sie nur 3-5 Stichproben über eine unterschiedliche Anzahl von Stichproben hinweg verwenden, ein Ergebnis, das den Wert einer angemessenen Kombination von modellinternem Wissen mit externem Wissen über die Schlussfolgerungsaufgabe demonstriert.

Abbildung 2: PaLM-540B Prompt-Ergebnisse, dargestellt nach der Anzahl der verwendeten CoT-SC-Proben.

ReAct ist optimal für die Feinabstimmung geeignet.Abbildung 3 zeigt die erweiterten Auswirkungen von Cueing/Fine-Tuning für die vier Methoden (Standard, CoT, Act, ReAct) auf HotpotQA. In PaLM-8/62B schnitt die Prompting-Methode ReAct von den vier Methoden am schlechtesten ab, was auf die Schwierigkeit zurückzuführen ist, das Denken und Handeln anhand von Szenarien zu erlernen. Bei einer Feinabstimmung mit nur 3.000 Beispielen wurde ReAct jedoch zur besten der vier Methoden, wobei das feinabgestimmte PaLM-8B ReAct alle PaLM-62B Prompting-Methoden und das feinabgestimmte PaLM-62B ReAct alle 540B Prompting-Methoden übertraf. Im Gegensatz dazu schnitt die Feinabstimmung Standard oder CoT signifikant schlechter ab als die Feinabstimmung ReAct oder Act in PaLM8/62B, wobei erstere dem Modell in erster Linie beibringt, sich (möglicherweise fiktive) Wissensfakten zu merken, während letztere dem Modell beibringt, wie man Informationen aus Wikipedia (schlussfolgert und) handelt, was eine allgemeinere Fähigkeit zum schlussfolgernden Denken ist. Da alle Prompting-Methoden immer noch deutlich unter dem domänenspezifischen Stand der Technik liegen (Tabelle 1), glauben wir, dass eine Feinabstimmung mit mehr von Menschen geschriebenen Daten ein besserer Weg sein könnte, um die Fähigkeiten von ReAct zu entfalten.

Abbildung 3: Erweiterte Ergebnisse für das Cueing und die Feinabstimmung von HotPotQA unter Verwendung von ReAct (unsere Methode) und der Basislinien.

4 Aufgaben der Entscheidungsfindung

Wir haben ReAct auch an zwei interaktiven sprachbasierten Entscheidungsfindungsaufgaben getestet, ALFWorld und WebShop, die beide komplexe Umgebungen haben, die von Intelligenzen verlangen, über lange Zeiträume mit spärlichen Belohnungen zu handeln, was von Intelligenzen verlangt, effektiv zu denken, um zu handeln und zu erkunden.

ALFWorld ALFWorld (Abbildung 1(2)) ist ein synthetisches, textbasiertes Spiel, das auf den verkörperten ALFRED-Benchmark abgestimmt ist. Es besteht aus 6 Aufgabentypen, bei denen Intelligenzen durch textuelle Aktionen navigieren müssen (z. B. zum Kaffeetisch1 gehen, die Akte2 aufheben, die Schreibtischlampe1 benutzen) und mit einer simulierten Familie interagieren müssen, um übergeordnete Ziele zu erreichen (z. B. die Akte unter der Schreibtischlampe überprüfen). Eine Aufgabeninstanz kann mehr als 50 Orte haben und mehr als 50 Schritte der Expertenstrategie zur Lösung erfordern, was die Intelligenzen herausfordert, Teilziele zu planen und zu verfolgen sowie systematisch zu erkunden (z. B. alle Tische einzeln zu überprüfen, um die Schreibtischlampe zu finden). Eine der Herausforderungen in ALFWorld besteht darin, die wahrscheinlichen Standorte von Haushaltsgegenständen zu bestimmen (z. B. befindet sich eine Tischlampe wahrscheinlich auf einem Tisch, einem Regal oder einer Kommode), was diese Umgebung ideal für LLM macht, um sein vortrainiertes Commonsense-Wissen zu nutzen. Um ReAct anzusteuern, haben wir für jeden Aufgabentyp zufällig drei Trajektorien im Trainingsset annotiert, die jeweils aus spärlichen Ideen bestehen, die (1) das Ziel zerlegen, (2) die Erledigung des Teilziels verfolgen, (3) das nächste Teilziel bestimmen und (4) den Ort des Objekts und das, was damit zu tun ist, mit Hilfe von Commonsense-Reasoning finden. Wir zeigen die für ALFWorld verwendeten Hinweise in Anhang C.4. In Anlehnung an den Ansatz von Shridhar et al. haben wir 134 ungesehene Bewertungsspiele in einer spezifischen Aufgabenstellung evaluiert. Um die Robustheit zu gewährleisten, konstruierten wir 6 Hinweise für jeden Aufgabentyp durch jede Permutation der 3 annotierten Trajektorien.Act-Hinweise wurden unter Verwendung der gleichen Trajektorien konstruiert, aber ohne Ideen - da die Aufgabeninstanzen zufällig aus der Trainingsmenge ausgewählt wurden, waren sie weder in Richtung ReAct noch Act voreingenommen, so dass ein fairer und kontrollierter Vergleich möglich ist, um die Bedeutung von spärlichen Ideen zu testen. Als Basis verwenden wir BUTLER, eine nachahmende Lernintelligenz, die auf 105 Experten-Trajektorien für jeden Aufgabentyp trainiert wurde.

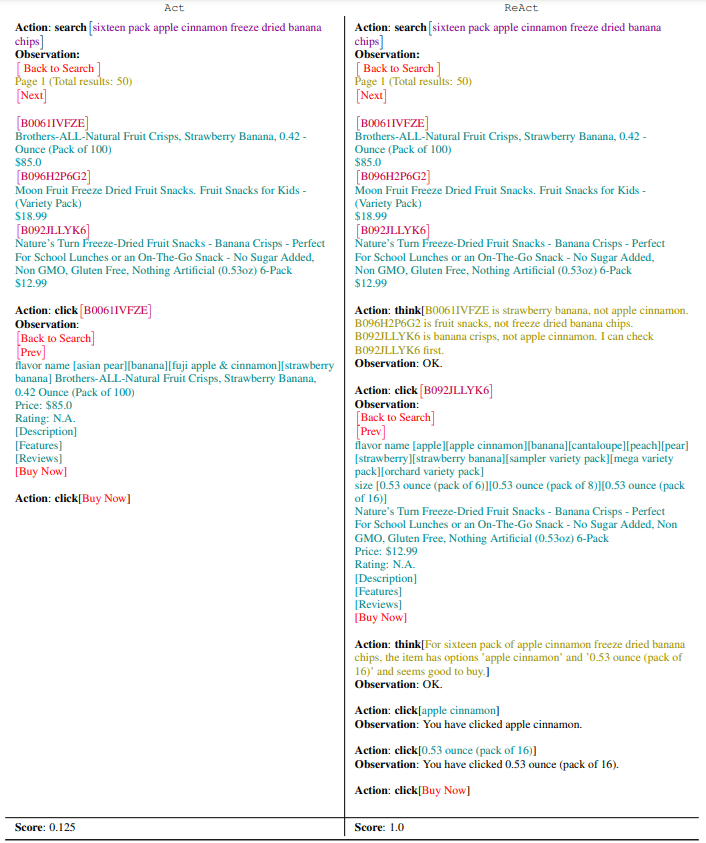

WebShop Kann ReAct auch mit verrauschten realen Sprachumgebungen für praktische Anwendungen interagieren? Wir haben WebShop untersucht, eine kürzlich vorgeschlagene Online-Shopping-Website-Umgebung mit 1,18 Millionen realen Produkten und 12k menschlichen Anweisungen. Im Gegensatz zu ALFWorld enthält Webshop eine große Menge an strukturiertem und unstrukturiertem Text (z.B. Produkttitel, Beschreibungen und Optionen, die von Amazon gecrawlt wurden) und bittet Intelligenzen, auf der Grundlage von Benutzerbefehlen damit zu interagieren (z.B. "Ich suche einen Nachttisch mit Schubladen. Es sollte eine Nickeloberfläche haben und weniger als 140 $ kosten") durch Webinteraktionen (z. B. Suche nach "Nachttisch Schubladen" und Auswahl von Schaltflächen wie "Farbe: Modernes Nickelweiß" oder "Zurück zu Suche", Auswahl von Schaltflächen wie "Farbe: Modernes Nickelweiß" oder "Zurück"), um das Produkt zu kaufen. Diese Aufgabe wurde anhand der mittleren Punktzahl (Prozentsatz der erforderlichen Attribute, die vom ausgewählten Produkt abgedeckt wurden, gemittelt über alle Episoden) und der Erfolgsquote (Prozentsatz der Episoden, in denen das ausgewählte Produkt alle Anforderungen erfüllte) bei 500 Testanweisungen bewertet. Wir haben Act-Prompts entwickelt, die Aktionen für die Suche, die Auswahl von Produkten, die Auswahl von Optionen und den Kauf beinhalten, während ReAct-Prompts zusätzliche Überlegungen anstellen, um zu bestimmen, was zu erkunden ist, wann gekauft werden soll und welche Produktoptionen für die Anweisungen relevant sind. Siehe Tabelle 6 für Beispielaufforderungen und Tabelle 10 im Anhang für Modellvorhersagen. Wir vergleichen dies mit einem Ansatz des Nachahmungslernens, der mit 1012 persönlich annotierten Trajektorien trainiert wurde, und einem zusätzlichen Ansatz des Nachahmungs- und Verstärkungslernens (IL + RL), der mit 10587 Trainingsanweisungen trainiert wurde.

am Ende ReAct übertrifft Act sowohl auf der ALFWorld- (Tabelle 3) als auch auf der Webshop-Plattform (Tabelle 4): Auf der ALFWorld-Plattform erreicht das leistungsstärkste ReAct-Experiment eine durchschnittliche Erfolgsrate von 711 TP3T, was die besten Act- (451 TP3T) und BUTLER-Experimente (371 TP3T) deutlich übertrifft. Tatsächlich übertrifft das schlechteste ReAct-Experiment (481 TP3T) auch die besten Experimente beider Methoden. Darüber hinaus blieb der Vorteil von ReAct gegenüber Act über die sechs kontrollierten Experimente hinweg bestehen, wobei die relativen Leistungssteigerungen von 331 TP3T bis 901 TP3T reichten, mit einem Durchschnitt von 621 TP3T. Aus qualitativer Sicht stellten wir fest, dass Act das Ziel nicht korrekt in kleinere Unterziele zerlegte oder den aktuellen Zustand der Umgebung nicht im Auge behielt, wenn überhaupt kein Denken vorhanden war. Beispiele für Trajektorien, die ReAct und Act vergleichen, finden Sie in Anhang D.2.1 und Anhang D.2.2.

Tabelle 3: AlfWorld aufgabenspezifische Erfolgsquoten (%). Die Ergebnisse für BUTLER und BUTLERg stammen aus Shridhar et al. 2020b Tabelle 4. Alle Methoden verwenden Greedy-Decodierung, mit Ausnahme von BUTLER, das Balkensuche verwendet.

Tabelle 4: Punktzahlen und Erfolgsquoten (SR) im Webshop. IL/IL+RL-Daten entnommen aus Yao et al. (2022).

Im Webshop konnten einmalige Act-Hinweise Hand in Hand mit IL- und IL+RL-Methoden gehen. Mit zusätzlichem Sparse Reasoning erreicht ReAct eine deutlich bessere Leistung, mit einer absoluten Verbesserung von 10% gegenüber der bisher besten Erfolgsrate. Bei der Untersuchung von Beispielen haben wir festgestellt, dass ReAct eher in der Lage ist, die Lücke zwischen verrauschten Beobachtungen und Handlungen zu schließen, indem es Produkte und Optionen identifiziert, die für die Anweisung relevant sind (z. B.: "Für den 'platzsparenden Wohnzimmerhocker' hat der Artikel eine Größe von ' 39x18x18inch' und 'blau' Optionen, die es wert zu sein scheinen, gekauft zu werden") . Allerdings schneiden die vorhandenen Methoden immer noch weit weniger gut ab als menschliche Experten (Tabelle 4), die wesentlich mehr Produktexploration und Rekonstruktion von Suchanfragen durchführen, was eine Herausforderung für cue-basierte Methoden bleibt.

Über den Wert interner Überlegungen gegenüber externem Feedback Soweit wir wissen, ist ReAct die erste Demonstration von LLM, die auf ein geschlossenes System angewendet wird, das Denken und Handeln in einer interaktiven Umgebung kombiniert. Die vielleicht ähnlichste frühere Arbeit ist Internal Monologue (IM) von Huang et al. (2022b), bei der die Handlungen verkörperter Agenten durch den gleichnamigen "internen Monolog" gesteuert werden.Der "interne Monolog" des IM beschränkt sich jedoch auf die Beobachtung des Zustands der Umwelt und der Aufgaben, die der Agent erfüllen muss, um seine Ziele zu erreichen.Im Gegensatz dazu ist die Entscheidungsinferenzverfolgung in ReAct flexibel und spärlich, so dass verschiedene Inferenztypen für unterschiedliche Aufgaben induziert werden können (siehe Abschnitt 2).

Um den Unterschied zwischen ReAct und IM zu demonstrieren und die Bedeutung des internen Denkens im Vergleich zu einfachen Antworten auf externes Feedback zu betonen, führten wir Ablationsexperimente mit einem Denkmuster durch, das aus IM-artigem, dichtem externen Feedback bestand. Wie in Tabelle 3 gezeigt, übertraf ReAct die IM-artigen Aufforderungen (ReAct-IM) bei weitem (71% vs. 53% für den Gesamterfolg), mit konsistenten Vorteilen bei fünf der sechs Aufgaben. Qualitativ stellten wir fest, dass ReAct-IM häufig Fehler bei der Bestimmung des Zeitpunkts der Erledigung von Teilzielen oder der Festlegung des nächsten Teilziels machte, was auf eine fehlende Dekomposition der Ziele auf hoher Ebene zurückzuführen ist. Darüber hinaus hatten viele der ReAct-IM-Trajektorien auch Schwierigkeiten bei der Bestimmung, wo sich Gegenstände in der ALFWorld-Umgebung befinden könnten, da es ihnen an gesundem Menschenverstand mangelte.

Beide Unzulänglichkeiten können mit dem ReAct-Paradigma behoben werden. Weitere Einzelheiten zu ReAct-IM finden Sie in Anhang B.2. Beispielhafte Hinweise zu ReAct-IM finden Sie in Anhang C.4, und Beispieltrajektorien in Anhang D.2.3.

5 Verwandte Arbeiten

Ein linguistisches Modell der Argumentation Die vielleicht bekannteste Arbeit über das schlussfolgernde Denken mit Large Language Models (LLMs) ist Chain-of-Thought (CoT), die die Fähigkeit von LLMs aufzeigte, ihre eigenen "Denkprozesse" zur Lösung von Problemen zu formulieren. Seitdem wurden mehrere Folgearbeiten durchgeführt, darunter Least-to-Most Prompting für komplexe Aufgaben, Zero-Shot CoT und selbstkonsistentes Denken. Kürzlich untersuchten (Madaan & Yazdanbakhsh, 2022) systematisch den Aufbau und die Struktur von CoTs und stellten fest, dass das Vorhandensein von Symbolen, Schemata und Text entscheidend für die Wirksamkeit von CoTs ist.

Andere Arbeiten haben zu komplexeren Schlussfolgerungsarchitekturen geführt, die über einfache Hinweise hinausgehen. Bei Selection-Inference beispielsweise wird der Schlussfolgerungsprozess in "Auswahl"- und "Schlussfolgerungs"-Schritte unterteilt, und STaR leitet den Schlussfolgerungsprozess durch Feinabstimmung des Modells auf der Grundlage der vom Modell selbst erzeugten korrekten Schlussfolgerung. Schlussfolgernder Prozess. Faithful Reasoning zerlegt mehrstufige Schlussfolgerungen in drei Schritte, von denen jeder von einem speziellen LM ausgeführt wird. Ähnliche Ansätze, wie z. B. Scratchpad, zeigen ebenfalls Verbesserungen bei mehrstufigen Berechnungsproblemen durch Feinabstimmung des LM auf dazwischen liegenden Berechnungsschritten.

Im Gegensatz zu diesen Ansätzen führt ReAct mehr als isolierte, fixe Schlussfolgerungen durch und integriert Modellaktionen und ihre entsprechenden Beobachtungen in einen kohärenten Eingabestrom, so dass das Modell genauer schlussfolgern und Aufgaben lösen kann, die über das Schlussfolgern hinausgehen (z. B. interaktive Entscheidungsfindung).

Verwendung von Sprachmodellen für die Entscheidungsfindung. Die Fähigkeiten leistungsfähiger LLMs erlauben es ihnen, Aufgaben zu erfüllen, die über die Spracherzeugung hinausgehen, und es wird immer beliebter, LLMs als Strategiemodell für die Entscheidungsfindung zu nutzen, insbesondere in interaktiven Umgebungen.WebGPT verwendet LLMs, um mit Webbrowsern zu interagieren, auf Webseiten zu navigieren und Antworten auf komplexe Fragen aus ELI abzuleiten5 . Im Gegensatz dazu modelliert WebGPT nicht explizit Denk- und Argumentationsprozesse, sondern verlässt sich auf teures menschliches Feedback zum Verstärkungslernen. In der Dialogmodellierung trainieren Systeme wie BlenderBot und Sparrow sowie aufgabenorientierte Dialogsysteme wie SimpleTOD ebenfalls LMs, um Entscheidungen über API-Aufrufe zu treffen. Im Gegensatz zu ReAct berücksichtigen sie nicht explizit den Inferenzprozess und verlassen sich auf teure Datensätze und menschliches Feedback für das Lernen von Richtlinien. Im Gegensatz dazu lernt ReAct Richtlinien auf billigere Art und Weise, da der Entscheidungsprozess nur Sprache benötigt, um den Schlussfolgerungsprozess zu beschreiben.

Sprachmodelle (LLMs) werden auch zunehmend für die Planung und Entscheidungsfindung in interaktiven und verkörperten Umgebungen eingesetzt. In dieser Hinsicht sind die für ReAct relevantesten wahrscheinlich SayCan undInnerer MonologIn SayCan werden LLMs aufgefordert, die möglichen Aktionen des Roboters direkt vorherzusagen, die dann von einem auf der visuellen Umgebung basierenden Verfügbarkeitsmodell neu sortiert werden, um die endgültige Vorhersage zu treffen. In SayCan werden LLMs aufgefordert, die möglichen Aktionen des Roboters direkt vorherzusagen, die dann von einem visuellen, auf der Umgebung basierenden Verfügbarkeitsmodell neu geordnet werden, um die endgültige Vorhersage zu treffen.Inner Monologue wird weiter verbessert durch die Hinzufügung des berühmten "inneren Monologs", der als Feedback aus der Umgebung implementiert wird. Feedback aus der Umgebung. Unseres Wissens nach ist Inner Monologue die erste Arbeit, die ein solches geschlossenes System demonstriert, und ReAct baut darauf auf. Wir argumentieren jedoch, dass Inner Monologue nicht wirklich inneres Denken enthält - dies wird in Abschnitt 4 näher erläutert. Wir weisen auch darauf hin, dass sich die Verwendung von Sprache als semantisch reichhaltiger Input in interaktiven Entscheidungsprozessen in anderen Bereichen bewährt hat. Es wird immer deutlicher, dass mit LLMs die Sprache als grundlegender kognitiver Mechanismus eine Schlüsselrolle in der Interaktion und Entscheidungsfindung spielen wird. Darüber hinaus haben Fortschritte bei LLMs die Entwicklung vielseitiger und universell einsetzbarer Agenten wie Reed et al.

6 Schlussfolgerung

Wir stellen ReAct vor - eine einfache, aber effektive Methode zur Koordinierung von Schlussfolgerungen und Aktionen in großen Sprachmodellen. Durch eine Reihe von Experimenten zur Beantwortung von Multi-Hop-Fragen, Faktenüberprüfung und interaktiven Entscheidungsfindungsaufgaben zeigen wir, dass ReAct zu überlegener Leistung mit parsierbaren Entscheidungspfaden führt. Trotz der Einfachheit unseres Ansatzes erfordern komplexe Aufgaben in großen Handlungsräumen mehr Beispiele, um gut zu lernen, was die Grenzen der Eingabelänge beim kontextuellen Lernen leicht überschreiten kann. Wir haben den fein abgestimmten Ansatz an HotpotQA ausprobiert und die ersten Ergebnisse sind ermutigend, aber es ist zu erwarten, dass das Lernen mit qualitativ hochwertigeren menschlichen Annotationen die Leistung weiter verbessert. Die Skalierbarkeit von ReAct beim Multi-Task-Training in Kombination mit ergänzenden Paradigmen wie dem Verstärkungslernen könnte zu leistungsfähigeren Agenten führen, die das Potenzial von LLMs für weitere Anwendungen erschließen.

A Zusätzliche Schlussfolgerungen

A.1 GPT-3-Versuch

Tabelle 5: Vergleich der Ergebnisse für ReAct-Aufforderungen mit PaLM-540B und GPT-3 (text-davinci-002, greedy decoding). Bei HotpotQA haben wir eine Teilmenge von 500 Validierungsfragen zufällig ausgewählt. In ALFWorld haben wir alle 134 ungesehenen Instanzen der Verifikationsaufgabe mit dem besten Satz von Hints verwendet, der gemäß PaLM-540B ausgewählt wurde.

Wir haben zusätzliche GPT-3-Experimente (Brown et al., 2020) durchgeführt, um die Allgemeingültigkeit der ReAct-Cue-Leistung über verschiedene große Sprachmodelle hinweg zu bestätigen. Wie in Tabelle 5 gezeigt, übertrifft GPT-3 (text-davinci-002, greedy decoding) durchweg PaLM-540B bei HotpotQA und ALFWorld, möglicherweise weil es fein abgestimmt wurde, um menschlichen Anweisungen zu folgen. Dies deutet darauf hin, dass der ReAct-Hinweis bei verschiedenen Aufgaben für verschiedene große Sprachmodelle effektiv ist. Der Code für diese Experimente ist unter https://react-lm.github.io/ zu finden.

A.2 ReAct zum Erwerb aktueller Kenntnisse über HotpotQA

Abbildung 4: Ein weiteres Beispiel für eine Hotpot-Quizfrage, bei der die ursprünglichen Beschriftungen nicht mehr aktuell sind. Nur ReAct war in der Lage, die aktuellsten Antworten durch tatsächliche Web-Interaktionen in Verbindung mit Schlussfolgerungen zu erhalten.

A.3 Verhaltenskorrekturen für die menschliche Beteiligung am Kreislauf auf ALFWorld

Wir haben auch menschliche Interaktionen mit ReAct untersucht, die es dem Menschen ermöglichten, ReActs Gedankenspuren zu überprüfen und zu bearbeiten. Abbildung 5 zeigt, dass ReAct durch einfaches Entfernen eines halluzinatorischen Satzes in Akt 17 und Hinzufügen einiger Hinweise in Akt 23 dazu gebracht werden kann, sein Verhalten erheblich zu ändern, sich an diese menschlichen Gedankenänderungen anzupassen und die Aufgabe erfolgreich zu lösen. Aus menschlicher Sicht wird die Lösung einer solchen Aufgabe viel einfacher, da nicht mehr Dutzende von Aktionen eingegeben werden müssen, sondern nur noch einige wenige Gedanken, was eine neue Art der Zusammenarbeit zwischen Mensch und Maschine ermöglicht. Wir weisen darauf hin, dass eine solche Bearbeitung von Richtlinien für Act und frühere RL-Ansätze schwierig ist, da der Mensch die Modellparameter nicht ändern kann und die Änderung einiger weniger Aktionen das restliche Verhalten des Modells nicht beeinflussen kann. Dieses Paradigma geht auch über den menschlichen Dialog hinaus, um Ziele oder Unterziele zu aktualisieren, wie in Huang et al. (2022b) beschrieben - während die Bearbeitung von ReAct-Ideen all dies tun kann, kann sie auch alle internen Überzeugungen des Modells, Denkstile oder flexible Gedankenraumunterstützung ändern, um die Aufgabe besser zu lösen. Wir glauben, dass dies eine spannende Richtung für die menschliche Ausrichtung ist, und sehen systematischere Forschung als zukünftige Arbeit an.

Abbildung 5: Beispiele für HCI-Verhaltenskorrekturen mit ReAct in AlfWorld. (a) Die ReAct-Trajektorie scheitert aufgrund von halluzinatorischem Denken (Verhalten 17). (b) Durch einfaches Editieren der beiden Gedanken (Verhalten 17, 23) durch einen Menschen erzeugt die ReAct-Trajektorie mit Erfolg die gewünschte Denk-Trajektorie und Handlung.

B Experimentelle Einzelheiten

B.1 Feinabstimmung der Details des Hot-Topics-Quiz

Für alle Feinabstimmungen wird eine Losgröße von 64 verwendet. Auf dem PaLM-8B führen wir für die ReAct- und Act-Methoden eine Feinabstimmung um 4.000 Schritte und für die Standard- und CoT-Methoden eine Feinabstimmung um 2.000 Schritte durch. Auf dem PaLM-62B haben wir die ReAct- und Act-Methoden um 4.000 Schritte und die Standard- und CoT-Methoden um 1.000 Schritte feinabgestimmt. Wir stellen fest, dass die ReAct- und Act-Methoden in der Regel von mehr Trainingsschritten (und mehr Trainingsdaten) profitieren, während die Standard- und CoT-Methoden schon bald nach der Feinabstimmung zu schwächeln beginnen.

B.2 ALFWORLD Instant Style Details

Für die Experimente zur unmittelbaren Stilablation wurden dieselben Expertentrajektorien, die in ReAct verwendet wurden, erneut annotiert, und diese Trajektorien enthielten intern ein dichtes externes Feedback-Denken, das ReAct-IM darauf beschränkte, nur (1) die Zerlegung des aktuellen Ziels und (2) das aktuelle Teilziel zu berücksichtigen, das abgeschlossen werden muss. Insbesondere fehlt ReAct-IM (1) das Denken, das bestimmt, wann ein Teilziel abgeschlossen ist, (2) das Denken, das bestimmt, was das nächste Teilziel sein sollte, (3) das Denken, das das LLM dazu veranlasst, sich auf sein internes, vortrainiertes Wissen zu beziehen, um die möglichen Standorte von Objekten in der Umgebung zu identifizieren.

C PROMPTS

C.1 Quiz zu aktuellen Themen

Heiße Q&A-Tipps

| Original | |

| Question | Answer |

| What’s the elevation range for the area that the eastern sector of the Colorado orogeny extends into? | 1,800 to 7,000 ft |

| Musician and satirist Allie Goertz wrote a song about “The Simpsons” character Milhouse. Who did Matt Groening name after Nixon? | Richard Nixon |

| Which documentary is about Finnish rock groups, Adam Clayton Powell, or The Saimaa Gesture? | The Saimaa Gesture |

| What profession do Nicholas Ray and Elia Kazan have in common? | Director, screenwriter, actor |

| Which magazine was started first, Arthur’s Magazine or First for Women? | Arthur’s Magazine |

| Are Pavel Urysohn and Leonid Levin known for the same type of work? | Yes |

| Original | |

| Ausgaben | Lösung |

| Wie hoch ist der Höhenbereich der östlichen Ausdehnung der Colorado-Orogenese? | 1.800 bis 7.000 ft. |

| Die Musikerin und Satirikerin Allie Goertz schrieb einen Song über die Simpsons-Figur Milhouse, Matt Groening, benannt nach welchem Nixon-Mann? | Richard Nixon. |

| Was ist der Dokumentarfilm über die finnische Rockband Adam Clayton Powell oder die Aktionen von Saimaa? | Operation Saïmaa |

| Welche Berufe haben Nicholas Ray und Elia Kazan gemeinsam? | Regisseur, Drehbuchautor, Schauspieler |

| Welche Zeitschrift wurde früher gegründet, Arthur's Magazine oder First for Women? | Arthur’s Magazine |

| Sind Pavel Urizon und Leonid Levin für dieselbe Art von Arbeit bekannt? | 是 |

| Act | ||

| Question | Action | Observation |

| What is the elevation range for the area that the eastern sector of the Colorado orogeny extends into? | Search[Colorado orogeny] | The Colorado orogeny was an episode of mountain building (an orogeny) in Colorado and surrounding areas. |

| Lookup[eastern sector] | (Result 1 / i) The eastern sector extends into the High Plains and is called the Central Plains orogeny. | |

| Search[High Plains] | High Plains refers to one of two distinct land regions: | |

| Search[High Plains (United States)] | The High Plains are a subregion of the Great Plains. From east to west, the High Plains rise in elevation from around 1,800 to 7,000 ft (550 to 2,130 m).[3] | |

| Finish | [1,800 to 7,000 ft] | |

| Musician and satirist Allie Goertz wrote a song about the “The Simpsons” character Milhouse, who Matt Groening named after who? | Search[Milhouse] | Milhouse Mussolini Van Houten is a recurring character in the Fox animated television series The simpsons voiced by Pamela Hayden and created by Matt Groening. |

| Lookup[named after] | (Result 1 / l) Milhouse was named after U.S. president Richard Nixon, whose middle name was Milhous. | |

| Finish | [Richard Nixon] | |

| Which documentary is about Finnish rock groups, Adam clayton Powell or The Saimaa Gesture? | Search[Adam clayton Powell] | Could not find [Adam clayton Powell]. Similar: [‘Adam Clayton Powel III’, ‘Seventh Avenue (Manhattan)’, ‘Adam clayton Powell Jr. State office Building’, ‘Isabel Washington Powell’, ‘Adam Powell’, ‘Adam Clayton Powell (film)”, “Giancarlo Esposito”]. |

| Search[Adam clayton Powell (film)] | Adam clayton Powell is a 1989 American documentary film directed by Richard Kilberg. The film is about the rise and fall of influential African-American politician Adam clayton Powell Jr.[3][4] It was later aired as part of the PBs series The American Experience. | |

| Finish | [The Saimaa Gesture] | |

| What profession does Nicholas Ray and Elia Kazan have in common? | Search[Nicholas Ray] | Nicholas Ray (born Raymond Nicholas Kienzle Jr., ) August 7,1911 -June16, 1979) was an American film director, screenwriter, and actor best known for the 1955 film Rebel Without a Cause. |

| Search[Elia Kazan] | Elia Kazan was an American film and theatre director, producer, screenwriter and actor. | |

| Finish[director, screenwriter, actor] | ||

| Welche Zeitschrift wurde zuerst gegründet: Arthur's Magazine oder First for Women? | Suche [Arthur's Magazine] | Arthur's Magazine (1844-1846) war eine amerikanische Literaturzeitschrift, die im 19. Jahrhundert in Philadelphia erschien. |

| Search[First for Women] | First for Women ist eine Frauenzeitschrift, die von der Bauer Media Group in den USA herausgegeben wird.[1] Die Zeitschrift wurde 1989 gegründet. | |

| Beenden [Arthurs Magazin] | ||

| Were Pavel Urysohn and Leonid Levin known for the same type of work? | Search[Pavel Urysohn] | Pavel Samuilovich Urysohn (February 3, 1898 – August 17, 1924) was a Soviet mathematician who is best known for his contributions in dimension theory. |

| Search[Leonid Levin] | Leonid Anatolievich Levin is a Soviet-American mathematician and computer scientist. | |

| Finish[yes] | ||

| Act | ||

| Ausgaben | Bewegung | beachten Sie |

| Wie groß ist der Höhenbereich des Gebiets, in das sich der östliche Abschnitt der Colorado-Orogenese erstreckt? | Suche [Colorado Mountain Building Campaign] | Die Colorado-Orogenese ist eine Gebirgsbildungsbewegung (Orogenese), die in und um Colorado stattfand. |

| Suche nach [Östlicher Sektor] | (Ergebnisse 1 / i) Der östliche Abschnitt erstreckt sich bis in die High Plains und wird als Central Plains Orogenese bezeichnet. | |

| Suche [High Plains] | Die High Plains sind eine von zwei unterschiedlichen Regionen: | |

| Suche [High Plains (USA)] | Die High Plains sind eine Unterregion der Great Plains. Von Osten nach Westen steigt die Höhe der High Plains von etwa 550 Metern (1.800 Fuß) auf 2.130 Meter (7.000 Fuß) an. [3] | |

| erfüllen. | [1.800 bis 7.000 Fuß] | |

| Die Musikerin und Satirikerin Allie Goertz hat einen Song über die Simpsons-Figur Milhouse geschrieben. Nach wem hat Matt Groening die Figur benannt? | Suche [Milhouse] | Milhouse Mussolini Van Houten ist eine Figur in der Fox-Zeichentrickserie Die Simpsons, die von Pamela Hayden gesprochen und von Matt Groening geschaffen wird. |

| Suche nach [benannte Quelle] | (Ergebnisse 1 / l) Milhouse wurde nach Richard Nixon, dem Präsidenten der Vereinigten Staaten, benannt, dessen zweiter Vorname Milhous war. | |

| erfüllen. | [Richard Nixon] | |

| Welcher Dokumentarfilm handelt von einer finnischen Rockband, Adam Clayton Powell oder The Saimaa Gesture? | Suche [Adam Clayton Powell] | Es wurde kein [Adam Clayton Powell] gefunden. Ähnlich: ['Adam Clayton Powel III', 'Seventh Avenue (Manhattan)', 'Adam clayton Powell Jr. State Office Building', 'Isabel Washington Powell', 'Adam Powell', 'Adam Clayton Powell (Film)', 'Giancarlo Esposito']. |

| Suche [Adam Clayton Powell (Film)] | Adam Clayton Powell ist ein amerikanischer Dokumentarfilm aus dem Jahr 1989 unter der Regie von Richard Kilberg. Der Film verfolgt den Aufstieg und Fall des einflussreichen afroamerikanischen Politikers Adam Clayton Powell Jr. [3][4] Er wurde später als Teil der PBS-Serie The American Experience ausgestrahlt. | |

| erfüllen. | [The Saimaa Gesture] | |

| Welche Berufe haben Nicholas Ray und Elia Kazan gemeinsam? | Suche [Nicholas Ray] | Nicholas Ray (eigentlich Raymond Nicholas Kienzle Jr.,) 7. August 1911 - 16. Juni 1979) war ein amerikanischer Filmregisseur, Drehbuchautor und Schauspieler, der vor allem durch den Film Rebel Without a Cause von 1955 bekannt wurde. |

| Suche [Elia Kazan] | Elia Kazan ist ein amerikanischer Film- und Theaterregisseur, Produzent, Drehbuchautor und Schauspielerin. | |

| Abgeschlossen [Regisseur, Drehbuchautor, Schauspieler] | ||

| Welche Zeitschrift wurde zuerst gegründet, Arthur's Magazine oder First for Women? | Suche in [Arthurs Magazin]. | Arthur's Magazine (1844-1846) war eine amerikanische Literaturzeitschrift, die im 19. Jahrhundert in Philadelphia, USA, erschien. |

| Suche [First for Women] | First for Women ist eine Frauenzeitschrift, die in den Vereinigten Staaten von der Bauer Media Group herausgegeben wird.[1] Sie wurde 1989 gegründet. [1] Die Zeitschrift wurde 1989 eingeführt. | |

| Beenden [Arthurs Magazin] | ||

| Sind Pavel Urysohn und Leonid Levin für dieselbe Art von Arbeit bekannt? | Suche [Pavel Urysohn] | Pawel Samuilowitsch Urysohn (3. Februar 1898 - 17. August 1924) war ein sowjetischer Mathematiker, der vor allem für seine Beiträge zur dimensionalen Zahlentheorie bekannt ist. |

| Suche [Leonid Levin] | Leonid Anatolievich Levin war ein sowjetisch-amerikanischer Mathematiker und Computerwissenschaftler. | |

| Abgeschlossen [ja] | ||

| CoT | ||

| Question | Thought | Answer |

| What is the elevation range for the area that the eastern sector of the Colorado orogeny extends into? | Let’s think step by step. The eastern sector of Colorado orogeny extends into the High Plains. High Plains rise in elevation from around 1,800 to 7,000 ft, so the answer is 1,800 to 7,000 ft. | 1,800 to 7,000 ft |

| Musician and satirist Allie Goertz wrote a song about the “The Simpsons” character Milhouse, who Matt Groening named after who? | Let’s think step by step. Milhouse was named after U.S. president Richard Nixon, so the answer is Richard Nixon. | Richard Nixon |

| Which documentary is about Finnish rock groups, Adam Clayton Powell or The Saimaa Gesture? | Let’s think step by step. Adam Clayton Powell (film) is a documentary about an African-American politician, not Finnish rock groups. So the documentary about Finnish rock groups must instead be The Saimaa Gesture. | The Saimaa Gesture |

| What profession does Nicholas Ray and Elia Kazan have in common? | Let’s think step by step. Professions of Nicholas Ray are director, screenwriter, and actor. Professions of Elia Kazan are director, producer, screenwriter, and actor. So profession Nicholas Ray and Elia Kazan have in common is director, screenwriter, and actor. | director, screenwriter, actor |

| Which magazine was started first Arthur’s Magazine or First for Women? | Let’s think step by step. Arthur’s Magazine was started in 1844. First for Women was started in 1989. 1844 (Arthur’s Magazine) < 1989 (First for Women), so Arthur’s Magazine was started first. | Arthur’s Magazine |

| Were Pavel Urysohn and Leonid Levin known for the same type of work? | Let’s think step by step. Pavel Urysohn is a mathematician. Leonid Levin is a mathematician and computer scientist. So Pavel Urysohn and Leonid Levin have the same type of work. | Yes |

| CoT | ||

| Ausgaben | Denkprozess | Lösung |

| Wie groß ist der Höhenbereich des Gebiets, in das sich der östliche Abschnitt der Colorado-Orogenese erstreckt? | Lassen Sie uns dies Schritt für Schritt betrachten. Der östliche Abschnitt der Colorado-Orogenese reicht bis in die High Plains. Die Höhe der High Plains steigt von etwa 1.800 Fuß auf 7.000 Fuß an, also lautet die Antwort 1.800 bis 7.000 Fuß. | 1.800 bis 7.000 ft. |

| Die Musikerin und Satirikerin Allie Goertz hat einen Song über die Simpsons-Figur Milhouse geschrieben. Nach wem hat Matt Groening die Figur benannt? | Milhouse ist nach Richard Nixon, dem Präsidenten der Vereinigten Staaten, benannt, die Antwort lautet also Richard Nixon. | Richard Nixon. |

| Handelt der Dokumentarfilm von der finnischen Rockband Adam Clayton Powell oder von The Semaja Gesture? | Betrachten wir es Schritt für Schritt. Adam Clayton Powell (Film) ist ein Dokumentarfilm über einen afro-amerikanischen Politiker, nicht über eine finnische Rockband. Ein Dokumentarfilm über eine finnische Rockband wäre also The Semaja Gesture. | Die Semaya-Geste |

| Welche Berufe haben Nicholas Ray und Ilya Kazan gemeinsam? | Betrachten wir es Schritt für Schritt. Nicholas Rays Beruf ist Regisseur, Drehbuchautor und Schauspieler. Der Beruf von Ilya Kazan ist Regisseur, Produzent, Drehbuchautor und Schauspieler. Nicholas Ray und Ilya Kazan teilen sich also den Beruf des Regisseurs, Drehbuchautors und Schauspielers. | Regisseur, Drehbuchautor, Schauspieler |

| Wurde Arthur's Magazine oder First for Women zuerst gegründet? | Lassen Sie uns dies Schritt für Schritt betrachten. Arthur's Magazine wurde 1844 gegründet. First for Women wurde 1989 gegründet. 1844 (Arthur's Magazine) < 1989 (First for Women), also wurde Arthur's Magazine zuerst gegründet. | Arthurs Magazin |

| Sind Pavel Urysohn und Leonid Levin für dieselbe Art von Arbeit bekannt? | Betrachten wir dies Schritt für Schritt: Pavel Urysohn ist Mathematiker, Leonid Levin ist Mathematiker und Computerwissenschaftler. Pavel Urysohn und Leonid Levin haben also die gleiche Art von Beruf. | 是 |

| ReAct | |||

| Question | Thought | Action | Observation |

| What is the elevation range for the area that the eastern sector of the Colorado orogeny extends into? | I need to search Colorado orogeny, find the area that the eastern sector of the Colorado orogeny extends into, then find the elevation range of the area. | Search[Colorado orogeny] | The Colorado orogeny was an episode of mountain building (anorogeny) in Colorado and surrounding areas. |

| It does not mention the eastern sector. So I need to look up eastern sector. | Lookup[eastern sector] | (Result 1 / 1) The eastern sector extends into the High Plains and is called the Central Plains orogeny. | |

| The eastern sector of Colorado orogeny extends into the High Plains. So I need to search High Plains and find its elevation range. | Search[High Plains] | High Plains refers to one of two distinct land regions | |

| I need to instead search High Plains (United States). | Search[High Plains (United States)] | The High Plains are a subregion of the Great Plains. From east to west, the High Plains rise in elevation from around 1,800 to 7,000 ft (550 to 2,130 m).[3] | |

| High Plains rise in elevation from around 1,800 to 7,000 ft, so the answer is 1,800 to 7,000 ft. |

Finish[1,800 to 7,000 ft] | ||

| Musician and satirist Allie Goertz wrote a song about the “The Simpsons” character Milhouse, who Matt Groening named after who? | The question simplifies to “The Simpsons” character Milhouse is named after who. I only need to search Milhouse and find who it is named after. | Search[Milhouse] | Milhouse Mussolini Van Houten is a recurring character in the Fox animated television series The Simpsons voiced by Pamela Hayden and created by Matt Groening. |

| The paragraph does not tell who Milhouse is named after, maybe I can look up “named after”. | Lookup[named after] | (Result 1 / 1) Milhouse was named after U.S. president Richard Nixon, whose middle name was Milhous. | |

| Milhouse was named after U.S. president Richard Nixon, so the answer is Richard Nixon. | Finish[Richard Nixon] | ||

| Which documentary is about Finnish rock groups, Adam Clayton Powell or The Saimaa Gesture? | I need to search Adam Clayton Powell and The Saimaa Gesture, and find which documentary is about Finnish rock groups. | Search[Adam Clayton Powell] | Konnte [Adam Clayton Powell] nicht finden. Ähnlich: ['Adam Clayton Powell III', 'Seventh Avenue (Manhattan)', 'Adam Clayton Powell Jr. Clayton Powell Jr. State Office Building', 'Isabel Washington Powell', 'Adam Powell ', 'Adam Clayton Powell (Film)', 'Giancarlo Esposito']. |

| To find the documentary, I can search Adam Clayton Powell (film). | Search[Adam Clayton Powell (film)] | Adam Clayton Powell is a 1989 American documentary film directed by Richard Kilberg. The film is about the rise and fall of influential African-American politician Adam Clayton Powell Jr.[3][4] It was later aired as part of the PBS series The American Experience. | |

| Adam Clayton Powell (film) is a documentary about an African-American politician, not Finnish rock groups. So the documentary about Finnish rock groups must instead be The Saimaa Gesture. | Finish[The Saimaa Gesture] | ||

| What profession does Nicholas Ray and Elia Kazan have in common? | I need to search Nicholas Ray and Elia Kazan, find their professions, then find the profession they have in common. | Search[Nicholas Ray] | Nicholas Ray (born Raymond Nicholas Kienzle Jr., August 7, 1911 – June 16, 1979) was an American film director, screenwriter, and actor best known for the 1955 film Rebel Without a Cause. |

| Professions of Nicholas Ray are director, screenwriter, and actor. I need to search Elia Kazan next and find his professions. | Search[Elia Kazan] | Elia Kazan was an American film and theatre director, producer, screenwriter and actor. | |

| Professions of Elia Kazan are director, producer, screenwriter, and actor. So profession Nicholas Ray and Elia Kazan have in common is director, screenwriter, and actor. | Finish[director, screenwriter, actor] | ||

| Welche Zeitschrift wurde zuerst gegründet: Arthur's Magazine oder First for Women? | Ich muss Arthur's Magazine und First for Women durchsuchen, um herauszufinden, welche Zeitschrift zuerst gegründet wurde. | Suche [Arthur's Magazine] | Arthur's Magazine (1844-1846) war eine amerikanische Literaturzeitschrift, die im 19. Jahrhundert in Philadelphia erschien. |

| Arthur's Magazine wurde 1844 gegründet. Ich muss als nächstes First for Women durchsuchen. | Search[First for Women] | First for Women ist eine Frauenzeitschrift, die von der Bauer Media Group in den USA herausgegeben wird.[1] Die Zeitschrift wurde 1989 gegründet. | |

| First for Women wurde 1989 gegründet. 1844 (Arthur's Magazine) < 1989 (First for Women), also wurde Arthur's Magazine zuerst gegründet . | Beenden [Arthurs Magazin] | ||

| Were Pavel Urysohn and Leonid Levin known for the same type of work? | I need to search Pavel Urysohn and Leonid Levin, find their types of work, then find if they are the same. | Search[Pavel Urysohn] | Pavel Samuilovich Urysohn (February 3, 1898 – August 17, 1924) was a Soviet mathematician who is best known for his contributions in dimension theory. |

| Pavel Urysohn is a mathematician. I need to search Leonid Levin next and find its type of work. | Search[Leonid Levin] | Leonid Anatolievich Levin is a Soviet-American mathematician and computer scientist. | |

| Leonid Levin is a mathematician and computer scientist. So Pavel Urysohn and Leonid Levin have the same type of work. | Finish[yes] | ||

|

ReAct |

||

| Ausgaben | Reflexionen | handeln |

| Wie hoch ist die Region, in die sich der östliche Teil des orogenen Gürtels von Colorado erstreckt? | Ich muss den orogenen Gürtel von Colorado durchsuchen, das Gebiet finden, in das der östliche Abschnitt hineinreicht, und dann den Höhenbereich dieses Gebiets ermitteln. | Suche [Colorado orogenic belt] |

| Der Ostteil wird nicht erwähnt. Ich muss also den Ostteil nachschlagen. | Suche nach [Östlicher Sektor] | |

| Der östliche Teil des orogenen Gürtels von Colorado reicht bis in die High Plains. Ich muss also die High Plains durchsuchen und ihren Höhenbereich finden. | Suche [High Plains] | |

| Die Höhe der High Plains steigt von etwa 1.800 Fuß auf 7.000 Fuß an, also lautet die Antwort 1.800 Fuß bis 7.000 Fuß. | Fertigstellung [1800 ft bis 7000 ft] | |

| Die Musikerin und Satirikerin Allie Goertz schrieb einen Song über die Figur Milhouse in der Serie "Die Simpsons". Nach wem hat Matt Groening Milhouse benannt? | Die Frage ist vereinfacht gesagt, nach wem die Figur Milhouse in "Die Simpsons" benannt ist. Ich muss nur nach Milhouse suchen und herausfinden, nach wem er benannt ist. | Suche [Milhouse] |

| In dem Absatz steht nicht, nach wem Milhouse benannt ist, also kann ich vielleicht "benannt nach" nachschlagen. | Finde [benannt nach...] | |

| Milhouse ist nach dem US-Präsidenten Richard Nixon benannt, die Antwort lautet also Richard Nixon. | Beendet [Richard Nixon] | |

| Handelt der Dokumentarfilm von der finnischen Rockband Adam Clayton Powell oder von The Saimaa Gesture? | Ich muss nach Adam Clayton Powell und The Saimaa Gesture suchen und herausfinden, welcher Dokumentarfilm über eine finnische Rockband handelt. | Suche [Adam Clayton Powell] |

| Um den Dokumentarfilm zu finden, würde ich nach Adam Clayton Powell (Film) suchen. | Suche [Adam Clayton Powell (Film)] | |

| Adam Clayton Powell (Film) ist ein Dokumentarfilm über einen afro-amerikanischen Politiker, nicht über eine finnische Rockband. Ein Dokumentarfilm über eine finnische Rockband müsste also The Saimaa Gesture sein. | Beenden [Die Saimaa-Geste] | |

| Welche Berufe haben Nicholas Ray und Elia Kazan gemeinsam? | Ich muss nach Nicholas Ray und Elia Kazan suchen, ihre Berufe herausfinden und dann herausfinden, welche Berufe sie gemeinsam haben. | Suche [Nicholas Ray] |

| Nicholas Rays Beruf war Regisseur, Drehbuchautor und Schauspieler. Als nächstes muss ich nach Elia Kazan suchen und seinen Beruf herausfinden. | Suche [Elia Kazan] | |

| Elia Kazan übt den Beruf des Regisseurs, Produzenten, Drehbuchautors und Schauspielers aus. Nicholas Ray und Elia Kazan haben also denselben Beruf als Regisseur, Drehbuchautor und Schauspieler. | Fertigstellung [Regisseur, Drehbuchautor, Schauspieler] | |

| Welche Zeitschrift wurde zuerst gegründet, Arthur's Magazine oder First for Women? | Ich muss nach "Arthur's Magazine" und "First for Women" suchen und herausfinden, welche Zeitschrift zuerst gegründet wurde. | Suche in [Arthurs Magazin]. |

| Das Arthur's Magazine wurde 1844 gegründet. Als nächstes muss ich First for Women durchsuchen. | Suche [First for Women] | |

| First for Women wurde 1989 gegründet. 1844 (Arthur's Magazine) < 1989 (First for Women), also wurde Arthur's Magazine zuerst gegründet. | Beenden [Arthurs Magazin] | |

| Sind Pavel Urysohn und Leonid Levin für dieselbe Art von Arbeit bekannt? | Ich muss nach Pavel Urysohn und Leonid Levin suchen, um herauszufinden, welche Art von Arbeit sie verrichten, und dann herausfinden, ob sie dieselben sind. | Suche [Pavel Urysohn] |

| Pavel Urysohn ist ein Mathematiker. Als Nächstes muss ich nach Leonid Levin suchen und herausfinden, welche Art von Arbeit er macht. | Suche [Leonid Levin] | |

| Leonid Levin ist ein Mathematiker und Informatiker. Pavel Urysohn und Leonid Levin haben also dieselbe Art von Beruf. | Abgeschlossen [ja] | |

C.2 Faktenextraktion und Validierungsdatensatz/FEVER

FEVER Prompts

| Original | |

| Frage: Bestimmen Sie, ob es eine Beobachtung gibt, die eine Behauptung UNTERSTÜTZT oder widerlegt, oder ob es NICHT GENÜGEND INFORMATIONEN gibt. | |

| Claim | Answer |

| Nikolaj Coster-Waldau worked with the Fox Broadcasting Company. | SUPPORTS |

| Stranger Things is set in Bloomington, Indiana. | REFUTES |

| Beautiful reached number two on the Billboard Hot 100 in 2003. | NOT ENOUGH INFO |

| Original | |

| FRAGE: Stellen Sie fest, ob es Beobachtungen gibt, die die Aussage unterstützen oder widerlegen, oder ob die Informationen unzureichend sind. | |

| Vertretungen | Lösung |

| Nikolaj Coster-Waldau hat mit Fox Broadcasting Co. | etw. unterstützen |

| Stranger Things spielt in Bloomington, Indiana. | Retorte |

| Der Song "Beautiful" erreichte 2003 Platz zwei der Billboard Hot 100. | Unzureichende Informationen |

| Act | ||

| Frage: Bestimmen Sie, ob es eine Beobachtung gibt, die eine Behauptung UNTERSTÜTZT oder widerlegt, oder ob es NICHT GENÜGEND INFORMATIONEN gibt. | ||

| Claim | Action | Observation |

| Nikolaj Coster-waldau worked with the Fox Broadcasting Company. | Search[Nikolaj Coster-Waldau] | Nikolaj William Coster-Waldau (born 27 July 1970) is a Danish actor and producer. He graduated from the Danish National School of Performing Arts in Copenhagen in 1993,[1] and had his breakthrough role in Denmark with the film Nightwatch (1994). He played Jaime Lannister in the HBO fantasy drama series Game of Thrones, for which he received two Primetime Emmy Award nominations for Outstanding Supporting Actor in a Drama Series.. Coster-Waldau has appeared in numerous films in his native Denmark and Scandinavia, including Headhunters (2011) and A Thousand Times Good Night (2013). In the U.S, his debut film role was in the war film Black Hawk Down (2001), playing Medal of Honor recipient Gary Gordon.[2] He then played a detective in the short-lived Fox television series New Amsterdam (2008), and appeared in the 2009 Fox television film Virtuality, originally intended as a pilot. |

| Finish[SUPPORTS] | ||

| Stranger Things is set in Bloomington, Indiana. | Search[Stranger Things] | Stranger Things is an American science fiction horror drama television series created by the Duffer Brothers. Set in the 1980s, primarily in the fictional town of Hawkins, Indiana, the series centers on a number of mysteries and supernatural events occurring around the town and their impact on an ensemble of child and adult characters. |

| Finish[REFUTES] | ||

| Beautiful reached number two on the Billboard Hot 100 in 2003. | Search[Beautiful] | Konnte [Beautiful] nicht finden. Ähnlich: ['Beautiful', 'Beautiful, Beautiful', 'A Beautiful Mind (Film) ', 'Beautiful (Christina Aguilera Song)', 'Life Is Beautiful']. |

| Search[Beautiful (Christina Aguilera song) | “Beautiful” is a song recorded by American singer Christina Aguilera for her fourth studio album, Stripped (2002). | |

| Lookup[Billboard Hot 100] | (Result 1 / 3) The song peaked at number two on the Billboard Hot 100 in the United States, where it was certified Gold for 500,000 units shipped. | |

| Finish[NOT ENOUGH INFO] | ||

| Act | ||

| Problem: Feststellen, ob eine Beobachtung eine Aussage stützt oder widerlegt oder ob die Informationen unzureichend sind. | ||

| Vertretungen | handeln | beachten Sie |

| Nikolaj Coster-Waldau hat für die Fox Broadcasting Company gearbeitet. | Suche [Nikolaj Coster-Waldau] | Nikolaj William Coster-Waldau (geboren am 27. Juli 1970) ist ein dänischer Schauspieler und Produzent. Er machte 1993 seinen Abschluss an der Danish National Academy of Performing Arts in Kopenhagen[1] und erlangte seinen Durchbruch in Dänemark durch den Film Night Watch (1994). Für seine Darstellung des Jaime Lannister in der HBO-Fantasyserie Game of Thrones erhielt er zwei Primetime-Emmy-Award-Nominierungen als Bester Nebendarsteller in einer Dramaserie.Coster-Waldau hat in seinem Heimatland Dänemark und in Skandinavien in zahlreichen Filmen mitgewirkt, darunter Headhunters (2011) und A Thousand Times Goodnight (2013). In den Vereinigten Staaten war seine erste Filmrolle die des mit der Ehrenmedaille ausgezeichneten Gary Gordon in dem Kriegsfilm Black Hawk Down (2001).[2] Er spielte auch einen Detektiv in der kurzlebigen Fox-Fernsehserie New Amsterdam (2008) und trat 2009 in dem Fox-Fernsehfilm Virtua Fighter auf, der ursprünglich als Pilotfolge gedacht war. |

| Erledigt [unterstützt] | ||

| Stranger Things spielt in Bloomington, Indiana. | Suche [Stranger Things] | Stranger Things ist eine amerikanische Science-Fiction-Horror-Dramaserie, die von den Duff-Brüdern entwickelt wurde. Die Episoden spielen in den 1980er Jahren in der fiktiven Stadt Hawkins, Indiana, und drehen sich um eine Reihe von mysteriösen und übernatürlichen Ereignissen, die sich in der Stadt ereignen, und deren Auswirkungen auf eine Gruppe von Kindern und erwachsenen Personen. |

| Erledigt [Gegendarstellung] | ||

| Beautiful" erreichte 2003 Platz zwei der Billboard Hot 100. | Suche [Schön] | Keine [Beautiful] gefunden. Ähnlich: ['Beautiful', 'Beautiful, Beautiful', 'A Beautiful Mind (Film) ', 'Beautiful (Christina Aguilera Song)', 'Life Is Beautiful']. |

| Suche [Beautiful (Christina Aguilera song)] | "Beautiful" ist ein Song, den die amerikanische Sängerin Christina Aguilera für ihr viertes Studioalbum Stripped aufgenommen hat, das 2002 erschien. | |

| Finden Sie [Billboard Hot 100] | (Ergebnis 1 / 3) Der Song erreichte in den USA Platz zwei der Billboard Hot 100 und wurde mit 500.000 verkauften Einheiten mit Gold ausgezeichnet. | |

| Abgeschlossen [unzureichende Informationen] | ||

| CoT | ||

| Frage: Bestimmen Sie, ob es eine Beobachtung gibt, die eine Behauptung UNTERSTÜTZT oder widerlegt, oder ob es NICHT GENÜGEND INFORMATIONEN gibt. | ||

| Claim | Thought | Answer |

| Nikolaj Coster-Waldau worked with the Fox Broadcasting Company. | Nikolaj William Coster-Waldau appeared in the 2009 Fox television film Virtuality, so he has worked with the Fox Broadcasting Company. | SUPPORTS |

| Stranger Things is set in Bloomington, Indiana. | Stranger Things is in the fictional town of Hawkins, Indiana, not in Bloomington, Indiana. | REFUTES |

| Beautiful reached number two on the Billboard Hot 100 in 2003. | The song peaked at number two on the Billboard Hot 100 in the United States, but not sure if it was in 2003. | NOT ENOUGH INFO |

| COT | ||

| Problem: Feststellen, ob es Beobachtungen gibt, die eine Behauptung stützen oder widerlegen, oder ob die Informationen unzureichend sind. | ||

| Standpunkt | Reflexionen | Lösung |

| Nikolaj Coster-Waldau hat mit Fox Broadcasting Co. | Nikolai William Coster-Waldau spielte 2009 die Hauptrolle in dem Fox-Fernsehfilm Virtual Life, er hat also schon mit der Fox Broadcasting Company zusammengearbeitet. | etw. unterstützen |

| Stranger Things findet in Bloomington, Indiana, statt. | Stranger Things spielt in der fiktiven Stadt Hawkins, Indiana, und nicht in Bloomington, Indiana. | Retorte |

| Der Song "Beautiful" erreichte 2003 Platz zwei der Billboard Hot 100. | Der Song erreichte Platz zwei der Billboard Hot 100, aber es ist ungewiss, ob dies im Jahr 2003 der Fall war. | Unzureichende Informationen |

| ReAct | |||

| Frage: Bestimmen Sie, ob es eine Beobachtung gibt, die eine Behauptung UNTERSTÜTZT oder widerlegt, oder ob es NICHT GENÜGEND INFORMATIONEN gibt. | |||

| Claim | Thought | Action | Observation |

| Nikolaj Coster-Waldau worked with the Fox Broadcasting Company. | I need to search Nikolaj Coster-Waldau and find if he has worked with the Fox Broadcasting Company. | Search[Nikolaj Coster-Waldau] | Nikolaj William Coster-Waldau (born 27 July 1970) is a Danish actor and producer. He graduated from the Danish National School of Performing Arts in Copenhagen in 1993,[1] and had his breakthrough role in Denmark with the film Nightwatch (1994). He played Jaime Lannister in the HBO fantasy drama series Game of Thrones, for which he received two Primetime Emmy Award nominations for Outstanding Supporting Actor in a Drama Series.. Coster-Waldau has appeared in numerous films in his native Denmark and Scandinavia, including Headhunters (2011) and A Thousand Times Good Night (2013). In the U.S, his debut film role was in the war film Black Hawk Down (2001), playing Medal of Honor recipient Gary Gordon.[2] He then played a detective in the short-lived Fox television series New Amsterdam (2008), and appeared in the 2009 Fox television film Virtuality, originally intended as a pilot. |

| Because he “appeared in the 2009 Fox television film Virtuality”, he should have worked with the Fox Broadcasting Company. | Finish[SUPPORTS] | ||

| Stranger Things is set in Bloomington, Indiana. | I should search for Stranger Things, and see if it is set in Bloomington, Indiana. | Search[Stranger Things] | Stranger Things is an American science fiction horror drama television series created by the Duffer Brothers. Set in the 1980s, primarily in the fictional town of Hawkins, Indiana, the series centers on a number of mysteries and supernatural events occurring around the town and their impact on an ensemble of child and adult characters. |

| The observation says that it is set in a “fictional town of Hawkins, Indiana”, so it is not set in Bloomington. | Finish[REFUTES] | ||

| Beautiful reached number two on the Billboard Hot 100 in 2003. | I need to search the song Beautiful and find if it reached number two on the Billboard Hot 100 in 2003. | Search[Beautiful] | Konnte [Beautiful] nicht finden. Ähnlich: ['Beautiful', 'Beautiful, Beautiful', 'A Beautiful Mind (Film) ', 'Beautiful (Christina Aguilera Song)', 'Life Is Beautiful']. |

| From suggestions, I should search “Beautiful (Christina Aguilera song)” to find the song. | Search[Beautiful (Christina Aguilera song)] | “Beautiful” is a song recorded by American singer Christina Aguilera for her fourth studio album, Stripped (2002). | |

| It does not mention Billboard, so I need to look up “Billboard Hot 100” to find if it reached number two on it in 2003. | Lookup[Billboard Hot 100] | (Result 1 / 3) The song peaked at number two on the Billboard Hot 100 in the United States, where it was certified Gold for 500,000 units shipped. | |

| It only says the song peaked at number two on the Billboard Hot 100, but not if it was in 2003. I am not sure if this claim is true or not. | Finish[NOT ENOUGH INFO] | ||

|

ReAct |

|||

| FRAGE: Stellen Sie fest, ob es Beobachtungen gibt, die eine Aussage stützen oder widerlegen, oder ob die Informationen unzureichend sind. | |||

| Vertretungen | Reflexionen | handeln | beachten Sie |

| Nikolaj Coster-Waldau hat mit Fox Broadcasting Co. | Ich muss nach Nikolaj Coster-Waldau suchen, um herauszufinden, ob er mit Fox Broadcasting zusammengearbeitet hat. | Suche [Nikolaj Coster-Waldau] | Nikolaj Wilhelm Koster-Waldau (geboren am 27. Juli 1970) ist ein dänischer Schauspieler und Produzent. Er schloss 1993 sein Studium an der Danish National Academy of Performing Arts in Kopenhagen ab[1] und erzielte seinen Durchbruch in Dänemark mit dem Film Night Shift von 1994. Für seine Rolle als Jaime Lannister in der HBO-Fantasyserie Game of Thrones erhielt er zwei Nominierungen für den Primetime Emmy Award als bester Nebendarsteller in einer Dramaserie. In seiner Heimat Dänemark und Skandinavien hat Koster-Waldau in zahlreichen Filmen mitgewirkt, darunter Headhunters (2011) und A Thousand Times Goodnight (2013). In den Vereinigten Staaten war seine erste Filmrolle die des mit der Ehrenmedaille ausgezeichneten Gary Gordon in dem Kriegsfilm Black Hawk Down (2001). [2] Er spielte einen Detektiv in der Fox-Fernseh-Sketch-Show New Amsterdam (2008) und trat 2009 in dem Fox-Fernsehfilm Virtual Worlds auf, der ursprünglich als Pilotfolge produziert wurde. |

| Da er 2009 in dem Fox-Fernsehfilm Virtua Fighter" die Hauptrolle spielte, hätte er mit Fox Broadcasting zusammengearbeitet. | Erledigt [unterstützt] | ||