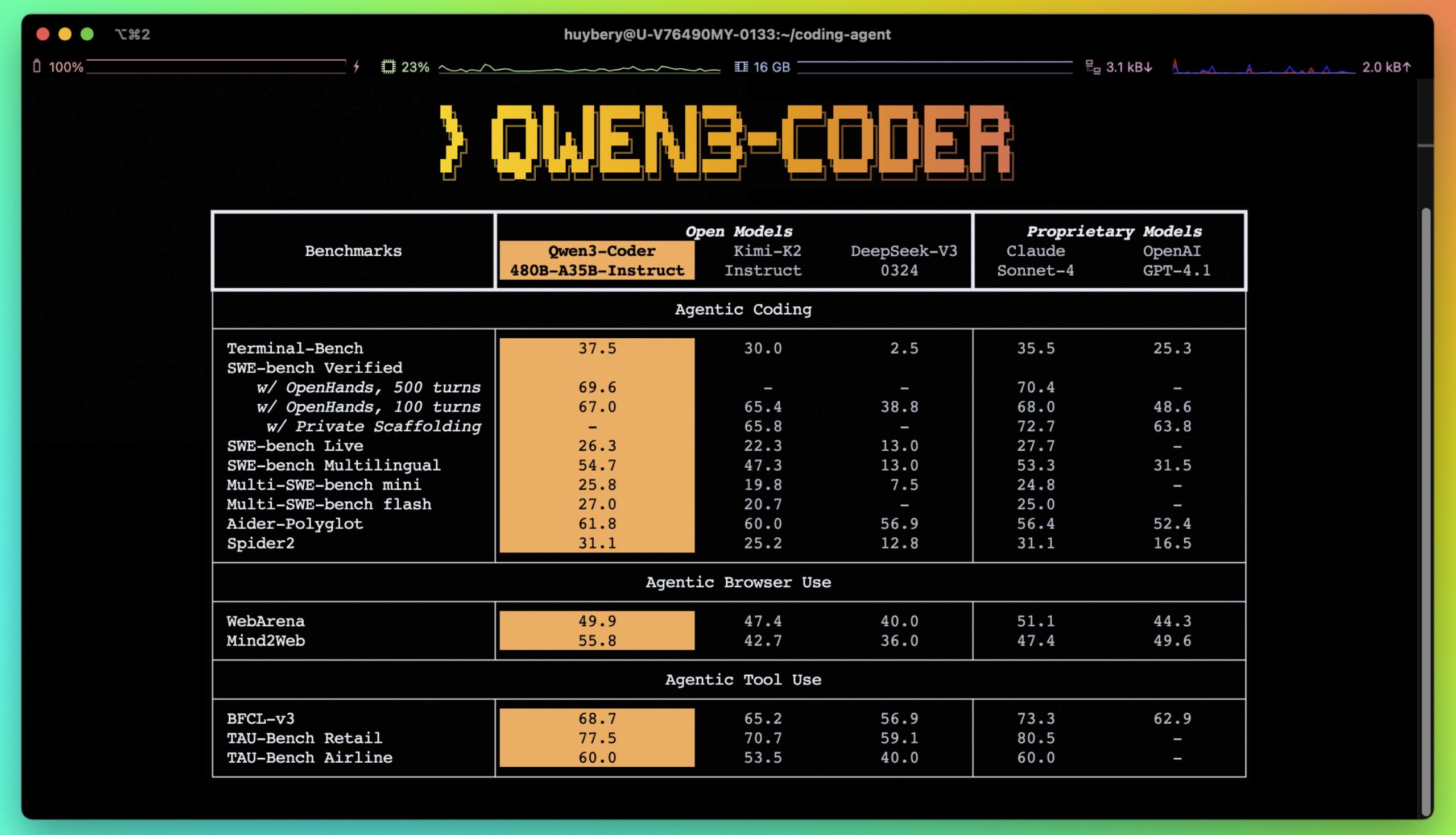

Qwen3-Coder ist eine Open-Source-Sprachmodellierungsfamilie, die vom Alibaba Cloud Qwen-Team entwickelt wurde und sich auf Codegenerierung und intelligente Programmierung konzentriert. Ihre Kernprodukte sind Qwen3-Coder-480B-A35B-InstructQwen3-Coder ist ein hybrides Model of Expert (MoE) mit 48 Milliarden Parametern und 3,5 Milliarden aktivierten Parametern. Es unterstützt eine native Kontextlänge von 256K Token und kann mit einer Erweiterungsmethode auf bis zu 1 Million Token skaliert werden. Qwen3-Coder zeichnet sich bei der Code-Generierung, der Code-Reparatur und bei Agentenaufgaben (z. B. Browser-Manipulation und Tool-Nutzung) durch eine Leistung aus, die mit der des Claude Sonnet 4 ist über das Open-Source-Befehlszeilentool Qwen Code Bietet erweiterte Codierungsunterstützung für Entwickler, die mit komplexen Codeaufgaben arbeiten. Die Modelle unterstützen mehr als 100 Sprachen und zeichnen sich besonders bei der mehrsprachigen Codegenerierung und Systemprogrammierung aus. Alle Modelle sind Open Source unter der Apache 2.0-Lizenz und können frei heruntergeladen und von Entwicklern angepasst werden.

Qwen3-Code Free User Guide: Konfigurieren der ModelScope API und Qwen CLI

Funktionsliste

- CodegenerierungGenerieren Sie hochwertigen Code mit Unterstützung für 92 Programmiersprachen, darunter Python, C++, Java und andere.

- Code-KorrekturenAutomatisches Erkennen und Beheben von Fehlern im Code zur Verbesserung der Programmiereffizienz.

- Code-VervollständigungUnterstützung für Code Snippet Filler Patching zur Optimierung des Entwicklungsprozesses.

- Unterstützung von AgentenmissionenIntegration externer Tools zur Durchführung von Browseroperationen und zur Bewältigung komplexer Aufgaben.

- lange KontextverarbeitungNative Unterstützung für 256K Token-Kontexte, skalierbar auf 1M Token, geeignet für die Bearbeitung großer Codebasen.

- Unterstützung mehrerer SprachenAbdeckung von mehr als 100 Sprachen und Dialekten, geeignet für mehrsprachige Entwicklung und Übersetzung.

- Kommandozeilentool: Vorausgesetzt

Qwen CodeOptimierung des Parsers und der Werkzeugunterstützung zur Vereinfachung der Codeverwaltung und der Automatisierungsaufgaben. - Open-Source-ModellBietet mehrere Modellgrößen (0,6B bis 480B) und unterstützt die Anpassung und Feinabstimmung durch den Entwickler.

Hilfe verwenden

Installation und Einsatz

Das Qwen3-Coder-Modell wird auf GitHub gehostet und kann von Entwicklern mit den folgenden Schritten installiert und verwendet werden:

- Klon-Lager

Führen Sie den folgenden Befehl in einem Terminal aus, um das Qwen3-Coder-Repository zu klonen:git clone https://github.com/QwenLM/Qwen3-Coder.gitDadurch wird die Projektdatei lokal heruntergeladen.

- Installation von Abhängigkeiten

Wechseln Sie in das Projektverzeichnis und installieren Sie die erforderlichen Python-Abhängigkeiten:cd Qwen3-Coder pip install -e ./"[gui,rag,code_interpreter,mcp]"Wenn nur minimale Abhängigkeiten benötigt werden, können Sie

pip install -e ./。 - Umgebungsvariablen konfigurieren

Qwen3-Coder unterstützt die Nutzung über die DashScope-API von Alibaba Cloud oder native Bereitstellungsmodelle.- Verwendung der DashScope APIEinstellung von Umgebungsvariablen für die Nutzung von Cloud-Diensten:

export OPENAI_API_KEY="your_api_key_here" export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1" export OPENAI_MODEL="qwen3-coder-plus"API-Schlüssel sind über die DashScope-Plattform von Alibaba Cloud erhältlich.

- lokaler Einsatz: Verwendung

llama.cpp或OllamaBereitstellungsmodelle.- Ollama verwenden: Installieren Sie Ollama (Version 0.6.6 oder höher) und führen Sie es aus:

ollama serve ollama run qwen3:8bLegen Sie die Kontextlänge und die Generierungsparameter fest:

/set parameter num_ctx 40960 /set parameter num_predict 32768Die API-Adresse lautet

http://localhost:11434/v1/。 - Verwendung von llama.cppFühren Sie den folgenden Befehl aus, um den Dienst zu starten:

./llama-server -hf Qwen/Qwen3-8B-GGUF:Q8_0 --jinja --reasoning-format deepseek -ngl 99 -fa -sm row --temp 0.6 --top-k 20 --top-p 0.95 --min-p 0 -c 40960 -n 32768 --no-context-shift --port 8080Dadurch wird ein lokaler Dienst mit einer API-Adresse von

http://localhost:8080/v1。

- Ollama verwenden: Installieren Sie Ollama (Version 0.6.6 oder höher) und führen Sie es aus:

- Verwendung der DashScope APIEinstellung von Umgebungsvariablen für die Nutzung von Cloud-Diensten:

- Modelle herunterladen

Modellgewichte können von Hugging Face oder ModelScope heruntergeladen werden. Beispiel:- Hugging Face:

https://huggingface.co/Qwen/Qwen3-Coder-480B-A35B-Instruct - ModelScope:

https://modelscope.cn/organization/qwen

ausnutzentransformersModelle zum Laden der Bibliothek:

from transformers import AutoTokenizer, AutoModelForCausalLM device = "cuda" # 使用 GPU tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct", device_map="auto").eval() - Hugging Face:

Qwen3-Coder verwenden

Qwen3-Coder bietet eine Vielzahl von Funktionen, und im Folgenden wird die Bedienung der Hauptfunktionen detailliert beschrieben:

- Codegenerierung

Qwen3-Coder erzeugt hochwertigen Code. Zum Beispiel generiert er schnelle Sortieralgorithmen:input_text = "#write a quick sort algorithm" model_inputs = tokenizer([input_text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output)Das Modell gibt den vollständigen Quick Sort Code zurück. Zu den unterstützten Programmiersprachen gehören C, C++, Python, Java usw., die sich für eine Vielzahl von Entwicklungsszenarien eignen.

- Code-Vervollständigung

Qwen3-Coder unterstützt Fill-in-the-Middle. Füllen Sie zum Beispiel die Schnellsortierfunktion aus:input_text = """<|fim_prefix|>def quicksort(arr): if len(arr) <= 1: return arr pivot = arr[len(arr) // 2] <|fim_suffix|> middle = [x for x in arr if x == pivot] right = [x for x in arr if x > pivot] return quicksort(left) + middle + quicksort(right)<|fim_middle|>""" messages = [{"role": "system", "content": "You are a code completion assistant."}, {"role": "user", "content": input_text}] text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True) model_inputs = tokenizer([text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output)Das Modell wird die fehlenden Codeabschnitte automatisch ausfüllen.

- Code-Korrekturen

Qwen3-Coder erkennt und korrigiert Codefehler. Der Benutzer kann fehlerhaften Code eingeben, und das Modell gibt eine korrigierte Version zurück. Im Aider-Benchmark schneidet Qwen3-Coder-480B-A35B-Instruct zum Beispiel genauso gut ab wie GPT-4o für komplexe Fehlerbehebungen. - Verwendung des Qwen Code Tools

Qwen Codeist ein Kommandozeilen-Tool, das für das Parsen und die Unterstützung von Qwen3-Coder optimiert ist. Führen Sie den folgenden Befehl aus:cd your-project/ qwenBeispielbefehl:

- Sehen Sie sich die Projektarchitektur an:

qwen > Describe the main pieces of this system's architecture - Verbesserungsfunktion:

qwen > Refactor this function to improve readability and performance - Erzeugen Sie Dokumente:

qwen > Generate comprehensive JSDoc comments for this function

Das Tool unterstützt automatisierte Aufgaben wie die Bearbeitung von Git-Commits und Code-Refactoring.

- Sehen Sie sich die Projektarchitektur an:

- Aufgaben der Agentur

Qwen3-Coder unterstützt Proxy-Aufgaben wie Browser-Aktionen oder Tool-Aufrufe. Methoden zur Konfiguration:- Setzen Sie den API-Anbieter auf

OpenAI Compatible。 - Geben Sie den DashScope API-Schlüssel ein.

- Legen Sie eine benutzerdefinierte URL fest:

https://dashscope-intl.aliyuncs.com/compatible-mode/v1。 - Wählen Sie das Modell aus:

qwen3-coder-plus。

Modelle können komplexe Agentenaufgaben wie die automatische Ausführung von Skripten oder die Interaktion mit dem Browser übernehmen.

- Setzen Sie den API-Anbieter auf

caveat

- Länge des KontextsStandardmäßig werden 256K Token unterstützt, die für die Analyse großer Codebasen geeignet sind. Sie kann mit YaRN auf 1M Token erweitert werden.

- Hardware-VoraussetzungGPUs (z. B. CUDA-Geräte) werden für eine schnellere Inferenz empfohlen. Kleinere Modelle (z. B. Qwen3-8B) sind für ressourcenarme Umgebungen geeignet.

- LizenzDas Modell ist quelloffen unter der Apache 2.0-Lizenz, die eine freie Nutzung und Modifikation erlaubt, aber die kommerzielle Nutzung unterliegt einer Lizenzvereinbarung.

Anwendungsszenario

- Software-Entwicklung

Entwickler können Qwen3-Coder verwenden, um schnell Code zu generieren, Fehler zu beheben oder Funktionen für Projekte von Anfängern bis hin zu professionellen Entwicklern zu patchen. Zum Beispiel, um Back-End-Code für Webanwendungen zu generieren oder Code für eingebettete Systeme zu optimieren. - Automatisierte Arbeitsabläufe

passieren (eine Rechnung oder Inspektion etc.)Qwen CodeEin Tool, mit dem Entwickler Git-Commits, Code-Refactoring oder Dokumentationserstellung für die Zusammenarbeit im Team und DevOps-Szenarien automatisieren können. - Mehrsprachige Projekte

Qwen3-Coder unterstützt mehr als 100 Sprachen und ist damit ideal für die Entwicklung mehrsprachiger Anwendungen oder für die Codeübersetzung, z. B. die Konvertierung von Python-Code in C++. - Verwaltung einer großen Codebasis

Durch die kontextbezogene Unterstützung von 256K-Tokens kann das Modell mit großen Codebasen umgehen und eignet sich für die Analyse und Optimierung komplexer Projekte wie Unternehmenssoftware oder Open-Source-Repositories.

QA

- Welche Programmiersprachen werden von Qwen3-Coder unterstützt?

Es unterstützt 92 Programmiersprachen, darunter Python, C, C++, Java, JavaScript usw., und deckt damit die wichtigsten Entwicklungsanforderungen ab. - Wie gehen Sie mit großen Code-Basen um?

Das Modell unterstützt von Haus aus 256K Token-Kontexte und kann mit YaRN auf 1M Token skaliert werden. Das Modell kann auf 1M Token erweitert werden, indem dieQwen CodeWerkzeuge zur direkten Abfrage und Bearbeitung großer Code-Basen. - Ist Qwen3-Coder kostenlos?

Die Modelle sind Open Source unter der Apache 2.0-Lizenz und können kostenlos heruntergeladen und verwendet werden. Die kommerzielle Nutzung unterliegt einer Lizenzvereinbarung. - Wie lässt sich die Modellleistung optimieren?

Die Verwendung eines GPU-Geräts wie CUDA erhöht die Inferenzgeschwindigkeit. Die Einstellung von Parametern wiemax_new_tokens和top_pDie Qualität der Erzeugung kann optimiert werden.