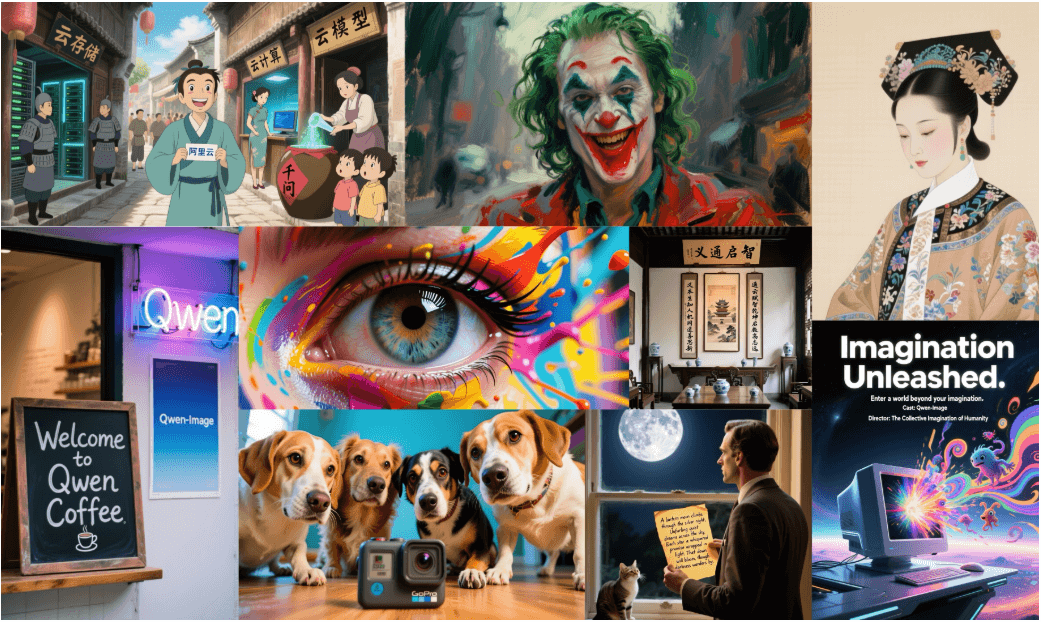

Qwen-Image ist ein 20B parametrisches multimodales Diffusionsmodell (MMDiT), das vom Qwen-Team entwickelt wurde und sich auf die originalgetreue Bilderzeugung und die genaue Textwiedergabe konzentriert. Es zeichnet sich durch komplexe Textverarbeitung (insbesondere Chinesisch und Englisch) und Bildbearbeitung aus. Das Modell unterstützt eine breite Palette von Kunststilen, wie z. B. realistische, Anime- und HD-Plakate, und kann mehrsprachige Typografie und layoutabhängige Szenarien verarbeiten. Das Modell kann angepasst werden, indem man es kombiniert mit ComfyUI Mit der nativen Integration von Qwen-Image können Benutzer Qwen-Image einfach in ihrem lokalen Workflow verwenden, um Inhalte wie Werbeplakate, Zeitschriftencover oder Pixelkunst zu erstellen. Das Modell steht unter der Apache 2.0 Lizenz und ist offen für Künstler, Designer und Entwickler.

Funktionsliste

- Realitätsnahe Bilderzeugung: Unterstützung von Realismus, Anime, Pixel Art und anderen Stilen zur Erzeugung hochauflösender Bilder.

- Komplexes Text-Rendering: Präzises Rendern von mehrsprachigem Text in Englisch und Chinesisch unter Wahrung typografischer Konsistenz und visueller Harmonie.

- Bildbearbeitungsfunktionen: Unterstützung für Stilkonvertierung, Hinzufügen und Löschen von Objekten, Textänderung und Detailverbesserung.

- Bildverstehensfunktionen: einschließlich Zielerkennung, semantische Segmentierung, Tiefenschätzung und Superauflösung.

- Unterstützung mehrerer Auflösungen: 1:1, 16:9, 9:16, 4:3, 3:4 Seitenverhältnisse.

- ComfyUI Integration: Läuft in nativen Workflows und unterstützt modulare Operationen und benutzerdefinierte Workflows.

- Prompt-Optimierung: Erweiterung der mehrsprachigen Prompts mit Qwen-Plus zur Verbesserung der Qualität der Generierung.

- Multiplattform-Unterstützung: Kompatibel mit Hugging Face, ModelScope, WaveSpeedAI und LiblibAI.

Hilfe verwenden

Einbauverfahren

Um Qwen-Image in ComfyUI zu verwenden, führen Sie die folgenden Installationsschritte durch:

- ComfyUI herunterladen oder aktualisieren:

Besuchen Sie die ComfyUI-Website (https://www.comfy.org/download), um die neueste Version herunterzuladen oder eine bestehende Installation zu aktualisieren. Stellen Sie sicher, dass Python 3.8 oder höher auf Ihrem System installiert ist. - Installation von Abhängigkeiten:

Installieren Sie die erforderlichen Python-Bibliotheken, einschließlichdiffusersund PyTorch:pip install git+https://github.com/huggingface/diffusers pip install torch torchvision

Wenn Sie eine GPU verwenden, wird empfohlen, PyTorch mit CUDA-Unterstützung zu installieren, um die Leistung zu verbessern.

- Das Qwen-Image-Modell erhalten:

Nach der Auswahl des Qwen-Image Workflows in ComfyUI werden Sie automatisch aufgefordert, die Modellgewichte herunterzuladen (Qwen/Qwen-Image). Es kann auch manuell von Hugging Face oder ModelScope heruntergeladen werden. - Konfiguration der Umgebung:

Um die Hardware-Unterstützung zu gewährleisten, empfehlen wir die Verwendung einer leistungsstarken GPU wie der RTX 4090D (24 GB RAM). CPU-Läufe sind möglich, aber langsamer.

Qwen-Image in ComfyUI verwenden

ComfyUI bietet einen modularen Arbeitsablauf, der für den lokalen Betrieb von Qwen-Image geeignet ist:

- ComfyUI starten:

Führen Sie die ComfyUI-Anwendung aus, um den Hauptbildschirm aufzurufen. - Laden des Qwen-Image Workflows:

- Einstellung von Stichwörtern:

Geben Sie ein ausführliches Textaufforderungswort ein, zum Beispiel:A realistic vintage TV news broadcast scene from the 1980s, displayed on an old CRT television with rounded screen edges, static noise, and scanlines. The screen shows a breaking news segment with a lower-third banner that reads: "Breaking: ComfyUI just supported Qwen-Image".Es wird empfohlen, positive Hinweise hinzuzufügen, um die Ergebnisse zu optimieren:

Ultra HD, 4K, cinematic composition - Anpassung der Erzeugungsparameter:

- Auflösung (eines Fotos)Wählen Sie 16:9 (1664 x 928) oder ein anderes unterstütztes Seitenverhältnis.

- InferenzschrittEs werden 50 Schritte empfohlen, um ein Gleichgewicht zwischen Qualität und Geschwindigkeit zu erreichen.

- CFG-Skala4.0, um sicherzustellen, dass das Bild eine hohe Relevanz für das Stichwort hat.

- ZufallsauswahlFixationskeim (z.B. 42) einstellen, um reproduzierbare Ergebnisse zu gewährleisten.

- Bilder generieren:

Streik (auf der Tastatur)RunTaste, ruft ComfyUI Qwen-Image auf, um ein Bild zu erzeugen. Das Ergebnis kann als PNG-Datei gespeichert werden.

Stichwort Wortoptimierung

Um die Qualität der Generierung zu verbessern, kann das Qwen-Plus-Tool zur Verbesserung der Eingabeaufforderung verwendet werden:

- Code-Integration:

from tools.prompt_utils import rewrite prompt = rewrite(prompt) # 优化提示词 - Befehlszeilenbetrieb:

aufstellenDASHSCOPE_API_KEYNach dem Lauf:cd src DASHSCOPE_API_KEY=sk-xxxxxxxxxxxxxxxxxxxx python examples/generate_w_prompt_enhance.py

Erweiterte Funktion Betrieb

- Textwiedergabe:

Qwen-Image zeichnet sich durch mehrsprachiges Text-Rendering aus und eignet sich für die Erstellung von Postern, Magazin-Covern und mehr. Zum Beispiel für die Erstellung eines Covers für ein Modemagazin:A high-fashion magazine cover inspired by Vogue. Stylish model in avant-garde outfit, dramatic pose, soft studio lighting. Elegant layout with English headlines: "THE BOLD ISSUE — Confidence is the New Couture", "100 LOOKS THAT DEFINE TOMORROW".Das Modell sorgt dafür, dass Schriftarten und Typografie natürlich mit dem Hintergrund verschmelzen.

- Bildbearbeitung:

Zukünftige Bearbeitungsfunktionen unterstützen die Konvertierung von Stilen, das Hinzufügen und Löschen von Objekten und die Änderung von Text. So kann beispielsweise ein Fotohintergrund durch einen Pixel-Art-Stil ersetzt werden oder es können neue Objekte zu einem Bild hinzugefügt werden. - grafisches Verständnis:

Qwen-Image unterstützt Aufgaben wie die Zielerkennung und die semantische Segmentierung. So kann es beispielsweise zur Analyse der Position eines Objekts in einem Bild oder zur Segmentierung einer Region verwendet werden, wobei die genaue Funktionsweise erst in der offiziellen Dokumentation erläutert werden muss.

Einsatz und Optimierung

Wenn Sie Multi-GPU-Dienste einsetzen müssen, um eine hohe Gleichzeitigkeit zu unterstützen:

- Konfigurieren Sie die Umgebungsvariablen:

export NUM_GPUS_TO_USE=4 export TASK_QUEUE_SIZE=100 export TASK_TIMEOUT=300 - Starten Sie den Gradio-Server:

cd src DASHSCOPE_API_KEY=sk-xxxxxxxxxxxxxxxxx python examples/demo.pyDer Zugriff auf die Gradio-Weboberfläche ist über Ihren Browser möglich.

Unterstützung der Gemeinschaft

- Hugging Face: Unterstützung

diffusersWorkflow-, LoRA- und Feinabstimmungsfunktionen sind in Kürze verfügbar. - ModelScopeUnterstützt Inferenz mit geringem Speicherbedarf (4 GB VRAM), FP8-Quantisierung und LoRA-Training.

- WaveSpeedAI und LiblibAIBieten Sie Online-Erfahrungen an, besuchen Sie ihre Website für weitere Informationen.

- ComfyUI DokumentationWeitere Anleitungen finden Sie unter https://docs.comfy.org/tutorials/image/qwen/qwen-image.

Anwendungsszenario

- Werbeentwurf

Erstellen Sie Poster oder Plakate mit Markentext, wobei Text und Bilder nahtlos ineinander übergehen.

Erstellen Sie zum Beispiel ein Plakat auf dem Dach einer Stadt mit der Aufschrift "ComfyUI ist mit Liebe gebaut". - Kunst

Künstler können Bilder in verschiedenen Stilen wie Pixelkunst oder High-Fashion-Cover für Illustrationen oder digitale Kunst erstellen.

Erstellen Sie zum Beispiel eine Spieloberfläche im 16-Bit-Pixel-Stil. - Bildung und Forschung

Zielerkennung oder semantische Segmentierung mit Hilfe von Bildverstehensfunktionen zur Unterstützung der akademischen Forschung.

Zum Beispiel die Analyse der Anordnung der Waren in einem Einzelhandelsszenario. - Marketing-Inhalt

Erstellen Sie professionelle Marketing-Diashows oder Video-Werbematerial mit Unterstützung für mehrsprachigen Text und elegante Typografie.

Erstellen Sie zum Beispiel eine Diashow mit Schlagzeilen und visuellen Elementen zum Thema Milch.

QA

- Wie funktioniert Qwen-Image in ComfyUI?

Das Qwen-Image-Modell wird durch den modularen Arbeitsablauf von ComfyUI geladen, Eingabeaufforderungen und Parameter werden festgelegt und das Bild wird erzeugt. - Welche Textsprachen werden unterstützt?

Unterstützung für Chinesisch und Englisch und andere Sprachen, Chinesisch-Rendering ist besonders genau, geeignet für komplexe Schriftsatz. - Welche Hardware-Anforderungen gibt es?

RTX 4090D (24GB RAM) wird empfohlen, CPUs können es ausführen, aber es ist langsamer, ModelScope unterstützt die Optimierung für geringen RAM. - Wie kann ich an der Modellüberprüfung teilnehmen?

Besuchen Sie die offizielle AI Arena-Website, um an dem Vergleich der Bilderzeugung teilzunehmen, oder wenden Sie sich an weiyue.wy@alibaba-inc.com, um das Modell einzusetzen.