GLM-4.5V: Ein multimodales Dialogmodell, das Bilder und Videos versteht und Code erzeugt

GLM-4.5V ist eine neue Generation des von Zhipu AI (Z.AI) entwickelten Visual Language Megamodel (VLM). Das Modell basiert auf dem Flaggschiff-Textmodell GLM-4.5-Air unter Verwendung der MOE-Architektur, mit 106 Milliarden Gesamtreferenzen, einschließlich 12 Milliarden Aktivierungsparametern.GLM-4.5V verarbeitet nicht nur Bilder und Texte, sondern versteht auch visuelle...

Schritt 3: Effiziente Generierung von quelloffenen Makromodellen für multimodale Inhalte

Step3 ist ein von StepFun entwickeltes Open-Source-Projekt zur multimodalen Makromodellierung, das auf GitHub gehostet wird und darauf abzielt, effiziente und kostengünstige Funktionen zur Erzeugung von Text-, Bild- und Sprachinhalten bereitzustellen. Das Projekt konzentriert sich auf ein 32,1 Milliarden Parameter (3,8 Milliarden aktive Parameter) gemischtes Expertenmodell (MoE), das für die Geschwindigkeit der Inferenz optimiert ist...

AutoArk: Eine Multi-Intelligenz-KI-Plattform für die Zusammenarbeit bei komplexen Aufgaben

AutoArk ist ein Unternehmen, das sich auf die Technologie der künstlichen Intelligenz konzentriert, deren Kernstück das selbst entwickelte multimodale End-to-End-Modell EVA-1 ist, das GPT-4o in vielen internationalen Benchmarks übertrifft. Auf der Grundlage des EVA-1-Modells hat AutoArk ein multimodales Framework namens "ArkAgentOS" entwickelt. Auf der Grundlage des EVA-1-Modells hat Boundless Ark ein Multi-Intelligenz-Framework namens "ArkAgentOS" entwickelt. ....

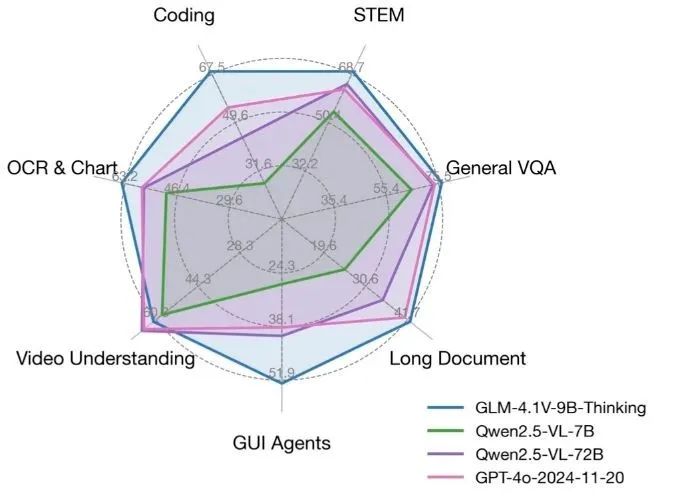

GLM-4.1V-Thinking: ein quelloffenes visuelles Inferenzmodell zur Unterstützung komplexer multimodaler Aufgaben

GLM-4.1V-Thinking ist ein quelloffenes visuelles Sprachmodell, das vom KEG Lab der Tsinghua Universität (THUDM) entwickelt wurde und sich auf multimodale Argumentationsfähigkeiten konzentriert. Basierend auf dem Basismodell GLM-4-9B-0414 verwendet GLM-4.1V-Thinking Verstärkungslernen und "chain-of-mind"-Schlussfolgernde Mechanismen,...

Gemma 3n

Mit der Veröffentlichung von Gemma 3 und Gemma 3 QAT, Open-Source-Modellen, die auf einem einzigen Cloud- oder Desktop-Beschleuniger laufen, erweitert Google seinen Fußabdruck für integrative KI. Wenn Gemma 3 den Entwicklern leistungsstarke Cloud- und Desktop-Funktionen bot, so wird diese Version vom 20. Mai 2025...

BAGEL

BAGEL ist ein vom ByteDance Seed-Team entwickeltes und auf GitHub gehostetes Open-Source-Multimodal-Basismodell, das Textverständnis, Bilderzeugung und Editierfunktionen zur Unterstützung crossmodaler Aufgaben integriert. Das Modell hat 7B aktive Parameter (14B Parameter insgesamt) und verwendet Mixture-of-Tra...

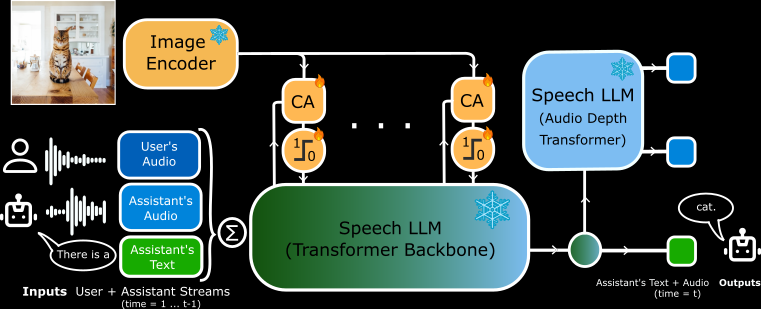

MoshiVis

MoshiVis ist ein Open-Source-Projekt, das von Kyutai Labs entwickelt und auf GitHub gehostet wird. Es basiert auf dem Moshi-Sprache-zu-Text-Modell (7B-Parameter), mit etwa 206 Millionen neuen Anpassungsparametern und dem eingefrorenen PaliGemma2-Visual-Coder (400M-Parameter), der es dem Modell ermöglicht,...

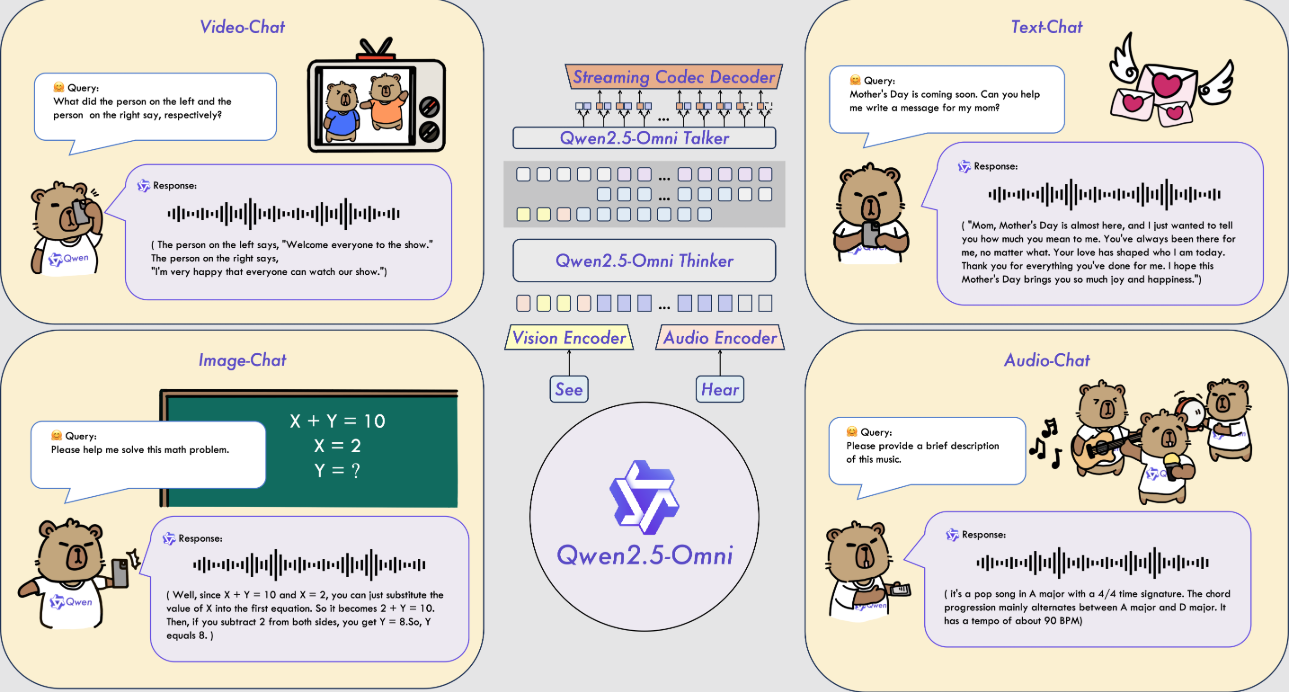

Qwen2.5-Omni

Qwen2.5-Omni ist ein Open-Source-Modell für multimodale KI, das vom Alibaba Cloud Qwen-Team entwickelt wurde. Es kann mehrere Eingaben wie Text, Bilder, Audio und Video verarbeiten und Antworten in Text oder natürlicher Sprache in Echtzeit erzeugen. Das Modell wurde am 26. März 2025 veröffentlicht, und der Code und die Modelldateien werden auf GitH.... gehostet.

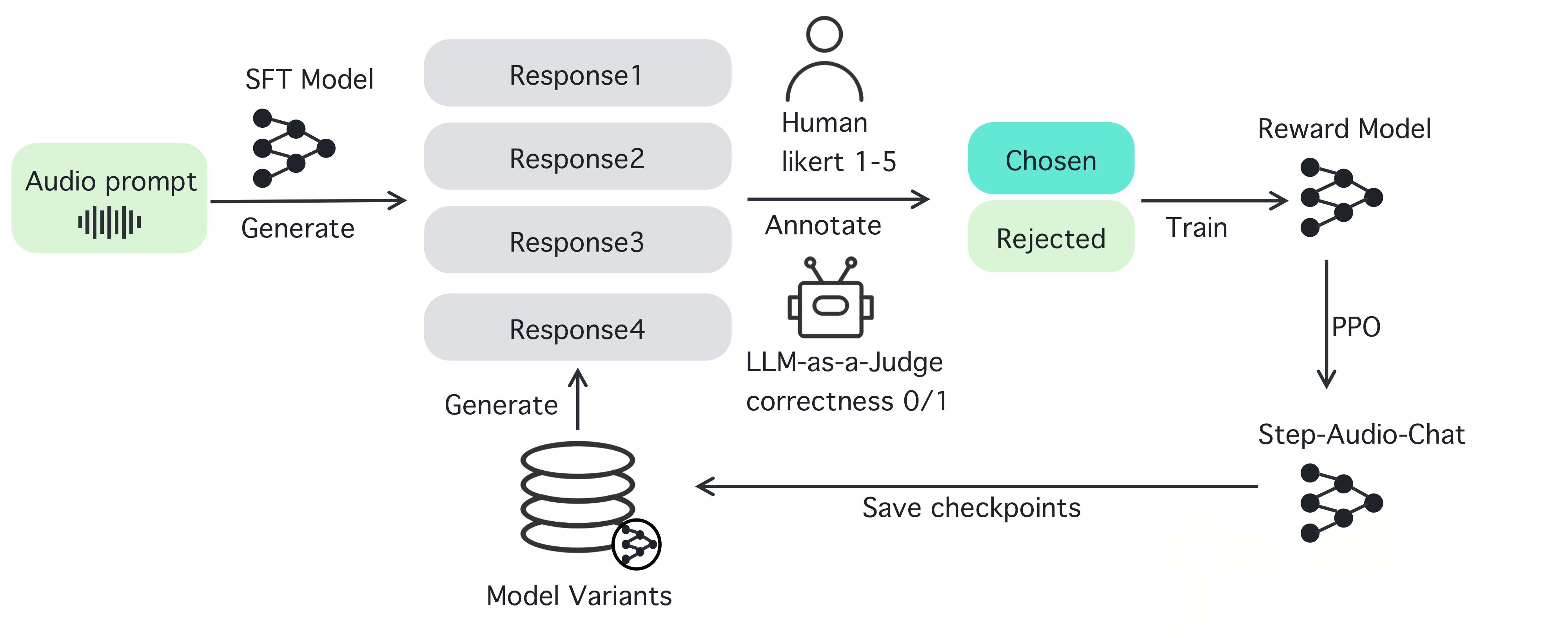

Schritt-Audio

Step-Audio ist ein Open-Source-Framework für intelligente Sprachinteraktion, das entwickelt wurde, um sofort einsetzbare Sprachverstehens- und -erzeugungsfunktionen für Produktionsumgebungen bereitzustellen. Das Framework unterstützt mehrsprachige Dialoge (z. B. Chinesisch, Englisch, Japanisch), emotionale Sprache (z. B. fröhlich, traurig), regionale Dialekte (z. B. Kantonesisch, Sichuan), einstellbare Sprachgeschwindigkeit...

VITA

VITA ist ein führendes quelloffenes, interaktives, multimodales Projekt zur Modellierung großer Sprachen, das Pionierarbeit bei der Verwirklichung echter, vollständig multimodaler Interaktion leistet. Das Projekt startete VITA-1.0 im August 2024 und leistete damit Pionierarbeit für das erste quelloffene, interaktive, vollständig modale große Sprachmodell. Im Dezember 2024 startete das Projekt ein großes Upgrade...

Megrez-3B-Omni

Infini-Megrez ist eine Edge-Intelligence-Lösung, die vom unquestioned core dome (Infinigence AI) entwickelt wurde und darauf abzielt, ein effizientes multimodales Verstehen und Analysieren durch gemeinsames Design von Hardware und Software zu erreichen. Das Herzstück des Projekts ist das Megrez-3B-Modell, das ein integriertes Bild-, Text- und Audioverständnis mit hoher Genauigkeit und schneller...

zurück zum Anfang